微服务架构

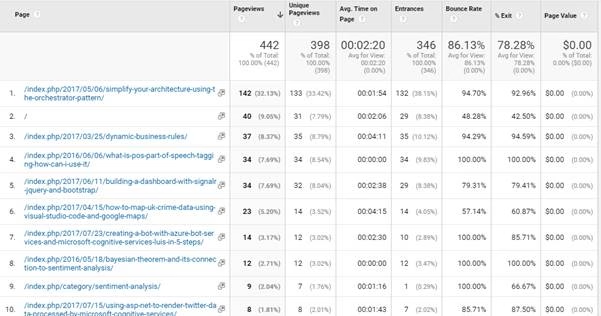

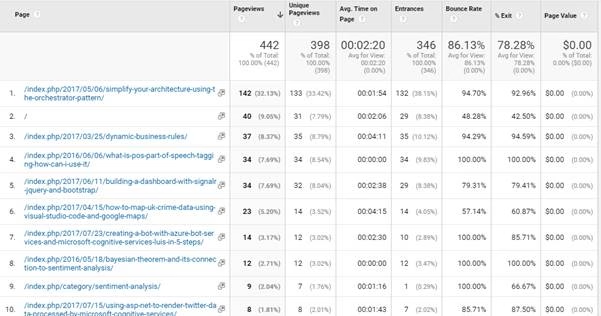

微服务架构 intelligentx- 501 次浏览

「分布式架构」分布式架构中可扩展性的事务一致性

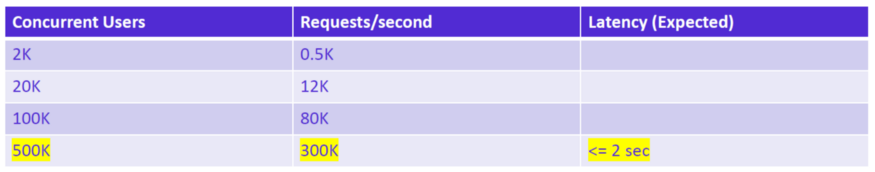

系统架构师角色的一个关键方面是权衡冲突的需求并决定解决方案,通常是通过将一个方面与另一个方面进行权衡。 随着系统变得越来越大,越来越复杂,越来越多关于如何构建应用程序的传统智慧正在受到挑战。 例如,去年3月在伦敦召开的QCon会议上,Dan Pritchard就eBay的架构发表了演讲。 从他的演讲中获得大量后续报道的主要内容之一是eBay不使用事务,事务丢失简单的数据一致性,以显着改善其系统的整体可扩展性和性能。

在他的演讲之后,InfoQ与Dan Pritchard进行了交谈,以获取更多信息:

为什么eBay不使用交易,或者如何决定应用程序级交易?

并不是我们不使用事务。我们只是不使用跨物理资源的事务,因为它跨多个组件创建了依赖关系。组件可以是应用程序服务器和数据库(例如客户端管理的事务),因为客户端故障可能会占用数据库资源的时间超过我们可以容忍的时间。我们也不使用分布式事务,因为使应用程序依赖于多个数据库会降低客户端的有效可用性。相反,我们选择设计缺少事务并构建故障模式,即使在数据库可用性问题的情况下,客户端也能成功。

应用程序级别的事务总是有些问题。无论何时您要求开发人员管理资源生命周期,您都将面临管理出错时出现的错误。事务与内存没什么不同,我们看到语言的一般趋势是由于生命周期问题而从开发人员那里消除内存管理的责任。声明性事务(例如EJB中的事务)是[a]简化事务管理的大锤方法,假设bean背后的每个数据库操作都同等重要。

决定是否使用事务实际上取决于您的可伸缩性和可用性目标。如果您的应用程序需要每秒达到数百个事务,那么您将发现分布式事务不会削减它。如果要在可用性的第3个9之后添加另一个数字,您将无法假设所有数据库提交都必须在网页的上下文中完成,或者在某些情况下完成。不幸的是,没有简单的公式可以何时退出应用程序级别的事务。相反,作为架构师,您必须决定系统上的一个约束何时需要您放松另一个约束。

你是如何为“放置出价”(Place bid)之类的东西建立自己的原子性的?

单独出价是一个有趣的问题,因为它不是关于原子性的,而是更多关于在拍卖的关键后几秒没有阻止任何竞标者。事实证明,如果您决定在展示时间而不是出价时间计算高出价者和出价,这很简单。将出价插入到单独的子表中,这是一种低争用操作。每次显示该项目时,都会检索所有出价并应用用于确定高出价者的业务规则。

你问题背后的真正问题是我们如何实现一致性?要在大规模系统中实现一致性,您必须放弃ACID而是使用BASE:

基本可用

软状态

最终一致

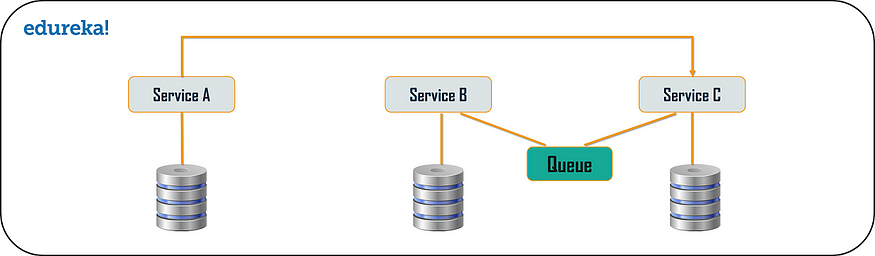

在每个客户端请求结束时,您需要放松数据的一致性,现在您已打开窗口以消除分布式事务并使用其他机制来达到一致状态。例如,在上述投标案例中,我们还更新由投标人组织的查看表,以便在“我的易趣”页面中快速显示。这是使用一对异步事件完成的。一个人依赖于内存队列,因为我们希望在出价和出现在“我的易趣”之间的延迟非常低。但是,在内存中队列不可靠,因此我们还使用具有出价操作的服务器端事务来捕获出价事件。如果内存队列操作失败,则作为恢复机制处理bid事件。因此,投标人视图表是分离的,并不总是与投标表的状态一致。但这是我们能够承受的宽容,并允许我们避免出价和出价视图表之间的ACID合规性。

您对大型系统的其他架构师有什么建议?

他最简单的建议是,大规模扩展不会为设计为小规模扩展的架构增加资源。 您必须摆脱传统模式,例如ACID和分布式事务。 愿意寻找机会放松传统智慧状态无法放松的约束。

对于一些简单的公理,设计所有要拆分的东西,并考虑BASE,而不是ACID。

亚马逊首席技术官Werner Vogels也在QCon上发表讲话,并以Eric Brewer的CAP定理为例,提供了一些权衡的背景。该定理在2000年PODC会议(.pdf文档)的介绍中描述,其中也涵盖了ACID与BASE,它表明,对于共享数据系统的三个属性 - 数据一致性,系统可用性和网络分区容忍度 - 只有两个可以同时发生。换句话说,不能容忍网络分区的系统可以使用诸如事务之类的常用技术来实现一致性和可用性。但是,对于亚马逊和eBay等大型分布式系统,网络分区是给定的。这样做的结果是,处理非常大的分布式系统的架构师必须决定是否放宽对一致性或可用性的要求。这两个选项都给开发人员带来了一些责任,他们需要了解他们正在使用的架构的特征。例如,如果您选择放松一致性,那么开发人员需要决定如何处理对系统的写入不会立即反映在相应读取中的情况。正如Windows Live程序经理Dare Obasanjo所说的那样.

我们在Windows Live平台的某些方面遵循类似的做法,我听说开发人员抱怨这样一个事实,即您通过事务免费获得的错误恢复由应用程序开发人员掌握。 最大的抱怨总是围绕复杂的批量操作。

有趣的是,许多大型网站似乎都独立地得出了相同的结论。 虽然只有少数节点的小型系统不必担心这些类型的权衡,但eBay和亚马逊正在解决的各种问题可能会开始出现在企业系统中,因为它们也会扩展到更大的范围。 更多的观众。

- 68 次浏览

「微服务架构」Google和eBay在构建微服务生态系统方面的深刻教训

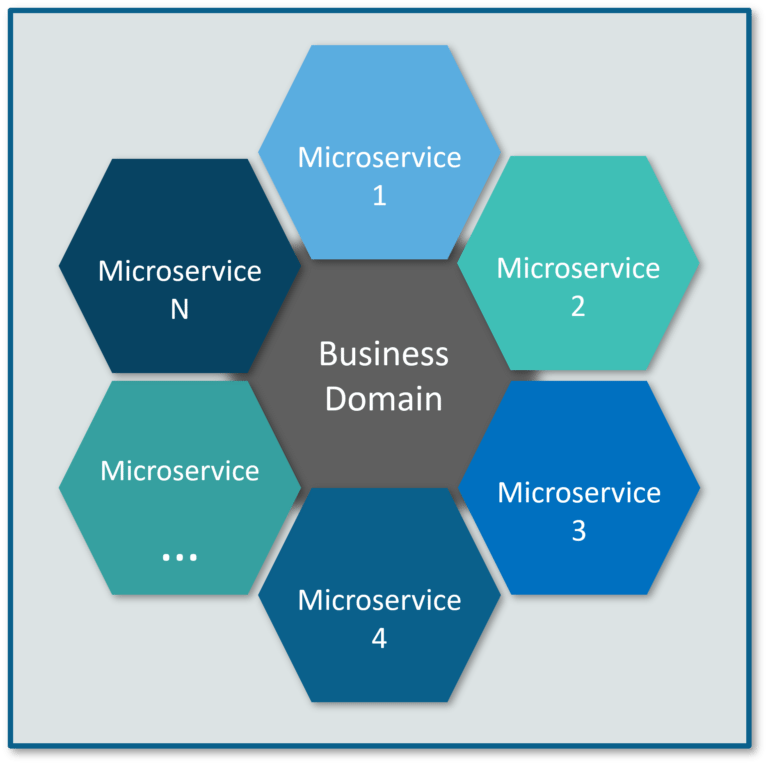

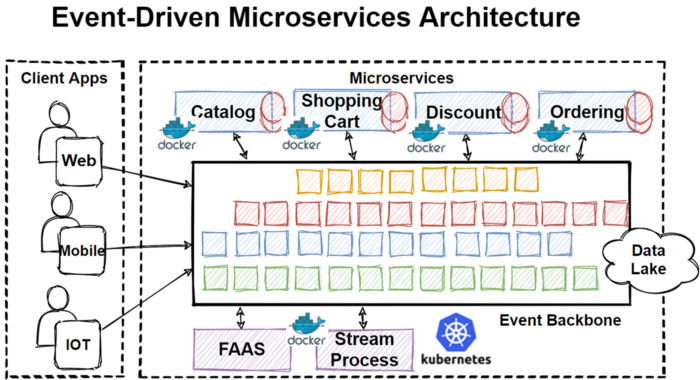

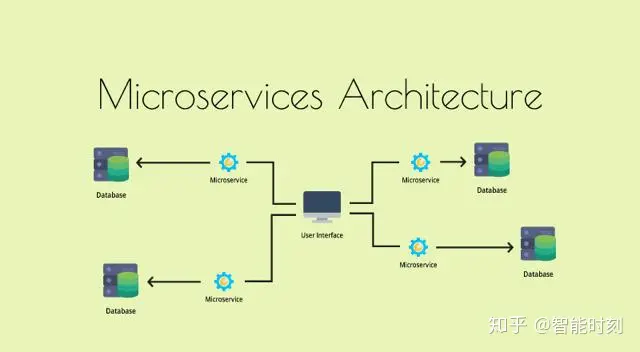

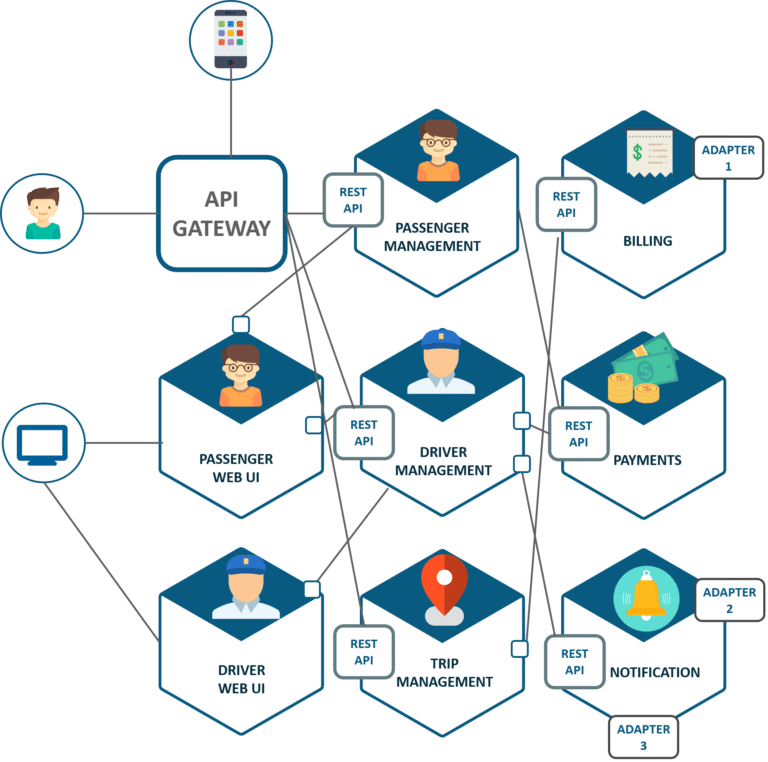

当你看到来自谷歌,Twitter,eBay和亚马逊的大规模系统时,他们的架构已演变成类似的东西:一组多语言微服务。

当您处于多语言微服务结束状态时,它看起来像什么? Randy Shoup曾在谷歌和eBay担任过高级职位,他有一个非常有趣的话题就是探索这个想法:规模的服务架构:谷歌和eBay的经验教训。

我真正喜欢Randy的演讲是他如何自觉地试图让你沉浸在你可能没有经验的经历中:创造,使用,延续和保护大规模的架构。

在谈话的服务生态系统部分兰迪问道:拥有大规模多语言微服务生态系统是什么样的?在“规模运营服务”部分,他问:作为服务提供商,运营此类服务的感觉如何?在“建立服务”部分,他问:当您是服务所有者时,它看起来像什么?在服务反模式部分,他问:什么可能出错?

一种非常强大的方法。

对我来说,演讲的亮点是调整激励机制的想法,这是一个贯穿整个努力的一贯主题。虽然从未明确地将其作为一个单独的策略,但这是为什么您希望小团队开发小型清洁服务,为什么内部服务的退款模型如此强大,架构如何在没有架构师的情况下发展,如何清洁设计可以发展的动机自下而上的过程,以及标准如何在没有中央委员会的情况下发展。

我的想法是,有意识地调整激励机制是如何扩展大型动态组织和大型动态代码库。在没有明确控制的情况下,采用正确的激励措施可以促使事情发生,几乎同样的方式是,当您移除锁定,不共享状态,与消息通信以及并行化所有内容时,分布式系统中的更多工作都会完成。

让我们看看现代时代如何建立大规模系统......

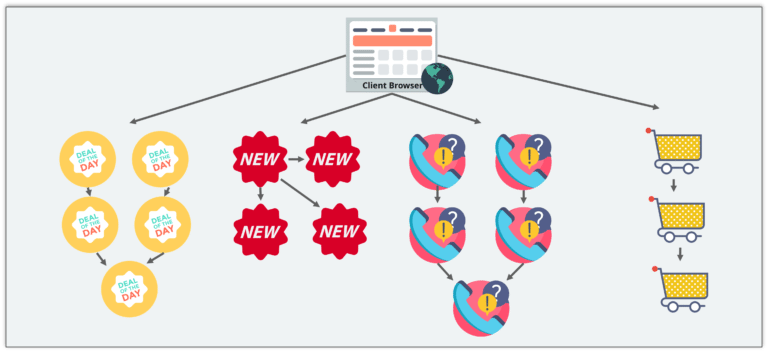

多语言微服务是最终的游戏

大规模系统最终演变成看起来非常相似的东西:一组多语言微服务。多语言意味着微服务可以用多种语言编写。

eBay始于1995年。根据您的计算方式,他们是第5代的架构。

- 始于1995年劳动节周末创始人写的单片Perl应用程序。

- 然后它转移到一个单片C ++应用程序,最终在一个DLL中有340万行代码。

- 之前的经验促使人们转向更加分散的Java分区系统。

- 今天的eBay有相当多的Java,但是一套多语言的微服务。

Twitter的演变看起来非常相似。根据您的计算方式,他们是第三代架构。

- 作为单片Ruby on Rails应用程序启动。

- 移动到前端的Javascript和Rails组合,后端有很多Scala。

- 最终,他们已经转向我们今天称之为一组多语言微服务。

亚马逊遵循类似的道路。

- 从单片C ++应用程序开始。

- 然后用Java和Scala编写的服务。

- 结束一组多语言微服务。

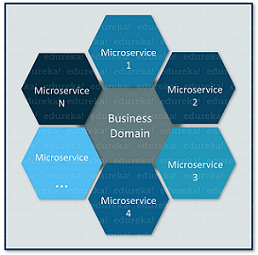

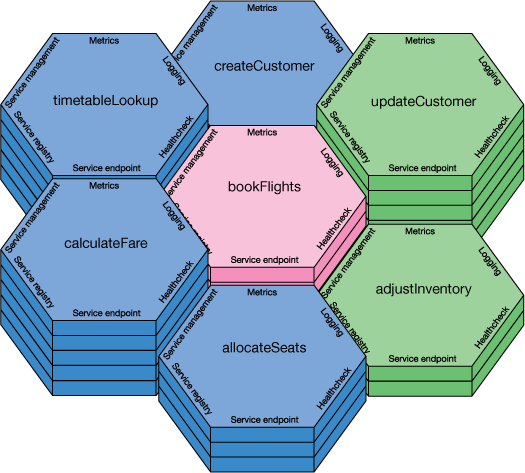

服务生态系统

拥有多语种微服务的大规模生态系统是什么样的?

在eBay和Google上,数百到数千个独立服务都在一起工作。

- 现代大规模系统在关系图中组成服务,而不是层次结构或层级组。

- 服务依赖于许多其他服务,同时被许多服务依赖。

- 较旧的大型系统通常以严格的层级组织。

如何建立服务生态系统?

这些性能最佳的系统更多是进化的产物,而不是智能设计。例如,在Google,从未有过系统的自上而下的设计。它以一种非常有机的方式随着时间的推移而发展和成长。

变化和自然选择。当需要解决问题时,会创建新服务,或者更经常从现有服务或产品中提取新服务。只要服务使用,服务就会存在,只要它们提供价值,否则它们会被弃用。

这些大规模系统自下而上发展。清洁设计( Clean design)可以是一种新兴产品,而不是自顶向下设计的产品。

例如,考虑Google App Engine的一些服务分层。

- Cloud Datastore(NoSQL服务)构建在Megastore(一个地理规模的结构化数据库)上,该数据库构建在Bigtable(一种集群级结构化服务)上,该服务基于Colossus(下一代集群文件系统)构建,建立在Borg(集群管理基础架构)之上。

- 分层很干净。每个图层都添加了一些不属于下面图层的内容。它不是自上而下设计的产物。

- 它是自下而上建造的。 Colossus,谷歌文件系统是首先建立的。几年后,Bigtable建成了。几年后,Megastore建成了。几年后,Cloud Database迁移到了Megastore。

- 没有自上而下的架构,您可以将这种关注点分离出来。

这是没有架构师的架构。 Google没有人拥有建筑师的头衔。技术决策没有中央批准。大多数技术决策都是由各个团队在当地为自己的目的做出的,而不是全球性的。

与2004年的eBay相比。有一个架构审查委员会,必须批准所有大型项目。

- 通常他们只是参与项目,因为改变它们已经太晚了。

- 集中审批机构成为瓶颈。它唯一的影响往往是在最后一分钟说不。

eBay处理这种情况的一个更好的方法是在审查委员会中对智能经验丰富的人员的知识进行编码,并将其放入可由各个团队重复使用的内容中。将这种体验编码到库或服务中,甚至是一组人们可以自己使用的指南,而不是在最后一刻进入流程。

标准如何在没有建筑师的情况下发展?

没有中央控制可能最终导致标准化。

- 标准化往往发生在服务和公共基础设施之间的通信中。

- 标准成为标准,因为它们比替代品更健康。

通常标准化的通信部分:

- 网络协议。 Google使用名为Stubby的专有协议。易趣使用REST。

- 数据格式。 Google使用Protocol Buffers。易趣倾向于使用JSON。

- 接口模式标准。 Google使用Protocol Buffers。对于JSON,有JSON模式。

通常标准化的通用基础设施:

- 源代码控制。

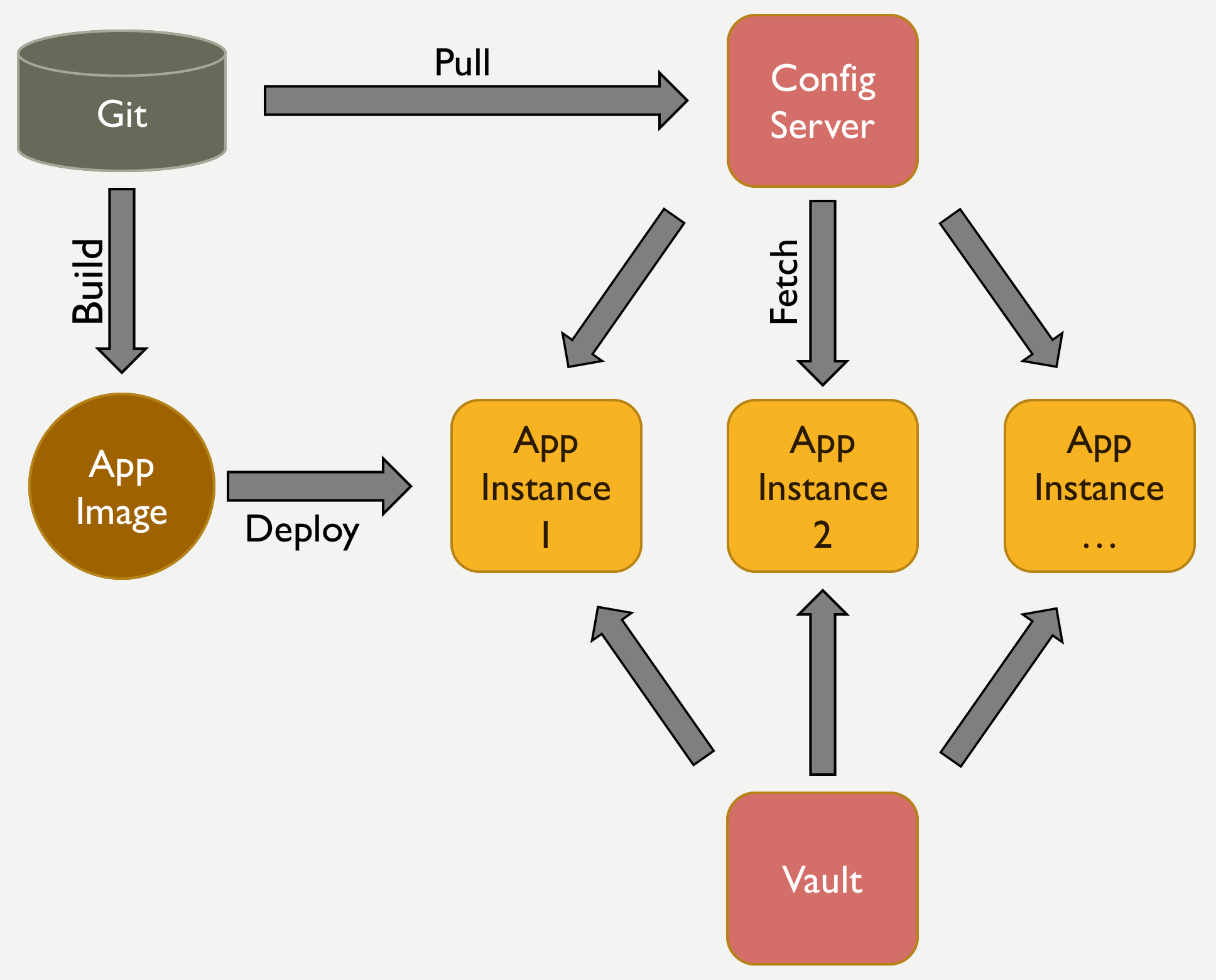

- 配置管理。

- 集群管理器。

- 监控系统。

- 警报系统。

- 诊断工具。

- 所有这些组件都可以根据惯例发展。

在进化环境中,标准通过以下方式实施:代码,鼓励,代码审查和代码搜索。

- 鼓励最佳实践的最简单方法是通过实际代码。这不是关于自上而下的审查,也不是前期设计,而是关于生成代码的人,这使得完成工作变得容易。

- 鼓励是通过提供库的团队。

- 鼓励也是通过您希望依赖于支持X协议或Y协议的服务。

- Google以至少一位其他程序员审阅源代码控制的每行代码而闻名。这是沟通常见做法的好方法。

- 除了少数例外,Google的每位工程师都可以搜索整个代码库。当程序员试图弄清楚如何做某事时,这是一个巨大的增值。对于10K工程师来说,如果你正在尝试做一些人已经做过类似事情的话。这允许从一个区域开始的最佳实践通过代码库传播。它还允许错误传播。

为了鼓励共同的实践和标准化的惯例,使得做正确的事情变得非常容易,并且做错事情要困难得多。

个人服务彼此独立。

- 在谷歌,没有标准化的服务内部。服务是外面的黑匣子。

- 有常规和通用库,但没有编程语言要求。通常使用四种语言:C ++,Go,Java,Python。许多不同的服务都是用各种语言编写的。

- 框架或持久性机制没有标准化。

在成熟的服务生态系统中,我们标准化 图的弧,而不是节点本身。定义一个共同的形状,而不是常见的实现。

创建新服务

- 新服务在使用已经过验证后即可创建。

- 通常,为一个特定用例构建了一个功能。然后发现该功能是通用且有用的。

- 一个团队成立,服务分离到自己的独立单位。

- 只有当功能成功并适合许多不同的用例时才会发生这种情况。

- 这些架构通过实用主义而成长。没有人坐在高处并且说应该添加服务。

- Google文件系统支持搜索引擎。毫无疑问,分布式文件系统通常更常用。

- Bigtable最初支持搜索引擎,但更广泛有用。

- Megastore是作为Google应用程序的存储机制构建的,但更广泛有用。

- Google App Engine本身是由一小群工程师发起的,他们认识到需要帮助构建网站。

- Gmail来自一个内部非常有用的副项目,然后被外部化为其他人。

弃用旧服务

如果不再使用某项服务会怎样?

- 可以重新利用的技术可以重复使用。

- 人们可以被解雇或重新部署到其他团队。

- Google Wave并非市场成功,但其中一些技术最终出现在Google Apps中。 例如,多人编辑文档的能力来自Wave。

更常见的情况是核心服务经历多代并且旧代被弃用。 这种情况在Google发生了很多。 通常情况下,谷歌内部的每项服务都被弃用或尚未准备就绪。

建立服务

当您是服务所有者时,在大规模多语言微服务系统中构建服务时,它会是什么样子?

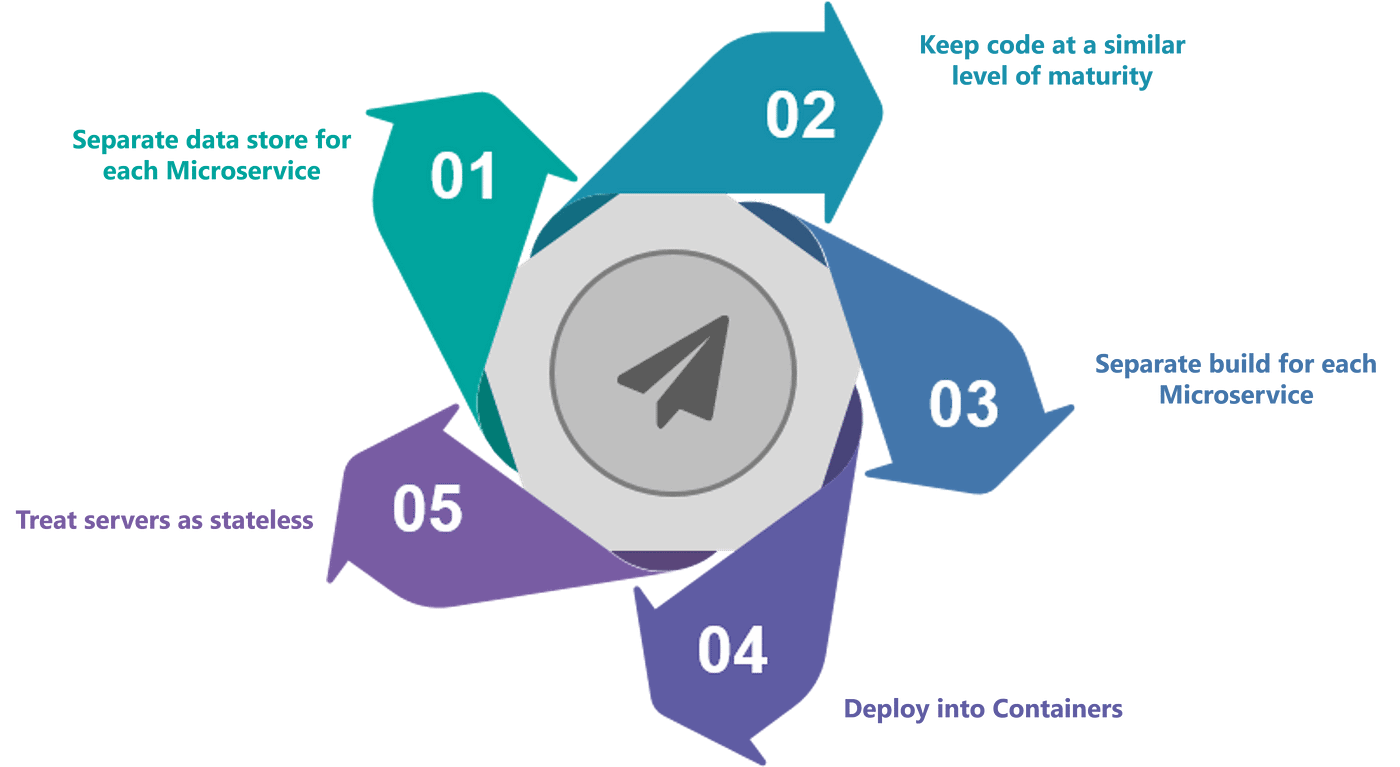

在大型架构中表现良好的服务是:

- 单用途。 它将有一个简单明确的界面。

- 模块化和独立。 我们可以称之为微服务。

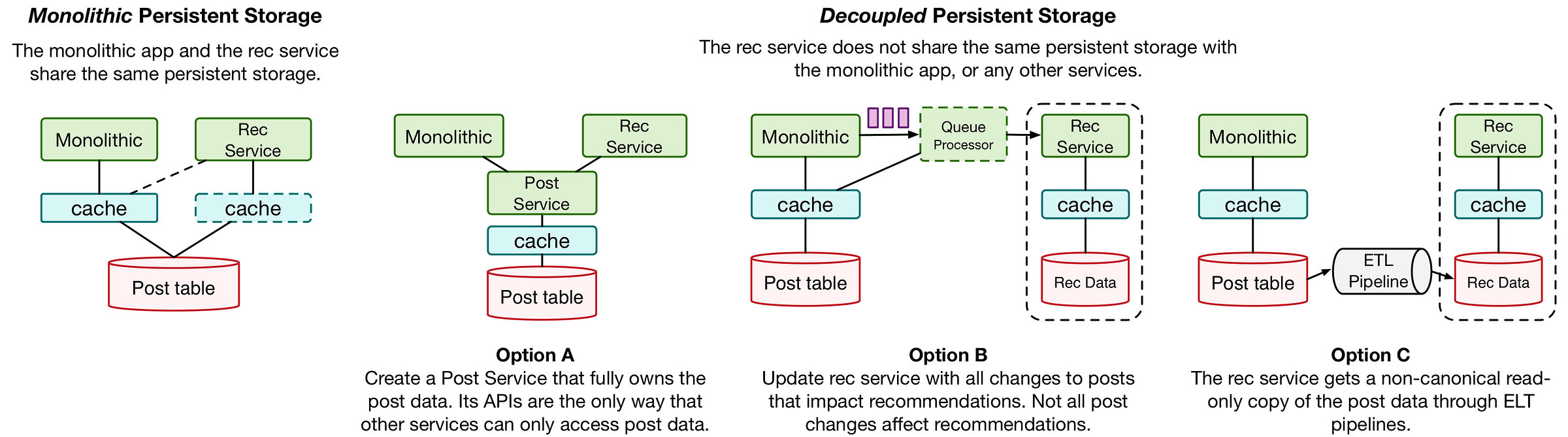

- 不共享持久层。 稍后会详细介绍。

服务所有者的目标是什么?

- 满足客户的需求。 以适当的质量水平提供必要的功能,同时满足协商的性能水平,同时保持稳定性和可靠性,同时不断改进服务。

- 以最低的成本和精力满足需求。

- 这一目标以鼓励使用共同基础设施的方式调整激励措施。

- 每个团队都拥有有限的资源,因此利用常见的战斗测试工具,流程,组件和服务符合他们的利益。

- 它还可以激发良好的操作行为。 自动构建和部署您的服务。

- 它还可以优化资源的有效利用。

服务所有者的责任是什么?

- 你构建它运行它。

- 该团队通常是一个小团队,拥有从设计,开发和部署到退役的服务。

- 没有单独的维护或维护工程团队。

- 团队可以自由地制定自己的技术选择,方法和工作环境。

- 团队对他们的选择负责。

- 服务作为有限的边界。

- 团队的认知负荷是有限的。

- 没有必要了解生态系统中的所有其他服务。

- 团队需要深入了解他们的服务以及他们所依赖的服务。

- 这意味着团队可以非常小巧灵活。一个典型的团队是3-5人。 (另外一个美国海军陆战队的火队有四个人。)

- 团队规模小意味着团队内部的沟通具有非常高的带宽和质量。

- 康威定律对你有利。通过组织小团队,你最终会得到一些小的个人组件。

什么是服务之间的关系?

- 考虑服务之间的关系作为供应商 - 客户关系,即使您在同一家公司。

- 非常友好和合作,但在关系中要非常有条理。

- 对所有权非常清楚。

- 要清楚谁应该对什么负责。在很大程度上,这是关于定义一个清晰的界面并维护它。

- 奖励是一致的,因为客户可以选择是否使用服务。这鼓励客户做正确的服务。这是新服务最终建立的方式之一。

- 定义SLA。服务提供商承诺为其客户提供一定程度的服务,以便客户可以依赖该服务。

- 客户团队为服务付费。

- 为服务收费可以协调经济激励措施。它激励双方在资源利用方面极为高效。

- 当事物是自由的时,我们倾向于不重视它们,并且往往不优化它们。

- 例如,内部客户免费使用Google App Engine,他们使用了大量资源。乞求他们更有效地利用资源,结果证明这不是一个好策略。退款开始一周后,通过一两个简单的更改,他们能够将GAE资源的消耗减少90%。

- 并不是使用GAE的团队是邪恶的,他们只是有其他优先事项,因此没有动力让他们优化他们对GAE的使用。事实证明,他们实际上通过更高效的架构获得了更好的响应时间。

- 充电还可以使服务提供商保持高质量,否则内部客户可能会去其他地方。这直接激励了良好的开发和管理实践。代码审查就是一个例子。谷歌的超大规模构建和测试系统是另一个。 Google每天都会运行数百万次自动化测试。每次将代码接受到存储库时,都会运行所有相关代码的验收测试,这有助于所有小型团队保持其服务质量。

- 退回退模式鼓励小额增量变更。小变化更容易理解。此外,代码更改的影响是非线性的。千分线变化的风险不是100线变化的10倍,它更像风险的100倍。

- 保持接口的完全向后/向前兼容性。

- 切勿破坏客户端代码。

- 这意味着维护多个接口版本。在一些令人讨厌的情况下,这意味着维护多个部署,一个用于新版本,另一个用于旧版本。

- 通常由于小的增量变化模型接口没有改变。

- 有明确的弃用政策。然后,服务提供商非常激动地将所有客户从版本N移到版本N + 1。

规模运营服务

作为服务提供商,在大规模多语言微服务系统中运行服务是什么感觉?

可预测的性能是一项要求。

- 大规模服务很容易受到性能差异的影响。

- 性能的可预测性比平均性能重要得多。

- 具有不一致性能的低延迟实际上根本不是低延迟。

- 当客户端提供一致的性能时,它可以更轻松地针对服务进行编程。

- 由于服务使用许多其他服务来执行其工作,因此尾部延迟主导性能。

- 想象一下这样一种服务,在中位数上有1ms的延迟,在99.999%的ile(1 / 10,000)中,延迟是一秒。

- 拨打一个电话意味着你很慢.01%的时间。

- 如果你使用的是5000台机器,就像Google那样的大型服务,那么50%的时间你都会很慢。

- 例如,memcached中百万分之一的问题被追踪到低级数据结构重新分配事件。这个罕见的问题表现为更高级别的延迟峰值。像这样的低级细节在大规模系统中变得非常重要。

深度弹力。

- 服务中断更可能是由于某人的错误而不是硬件或软件故障而发生的。

- 适应机器,集群和数据中心故障。

- 负载平衡并在调用其他服务时提供流量控制。

- 能够快速回滚变化。

增量部署。

- 使用金丝雀系统。不要一次部署到所有计算机。选择一个系统,将该软件的新版本放在该系统上,并查看它在新世界中的表现。

- 如果它工作开始分阶段推出。开始使用10%的机器,移动到20%,依此类推,通过其余的机队。

- 如果在部署中的50%点发生问题,那么您应该能够回滚。

- eBay利用功能标志将代码部署与功能部署分离。通常在关闭功能的情况下部署代码,然后可以打开或关闭代码。这可确保在打开新功能之前正确部署代码。这也意味着如果新功能存在错误,性能问题或业务故障,则可以关闭该功能,而无需部署新代码。

你可以有太多警报,你永远不会有太多的监控。

服务反模式

大型服务

- 服务太多了。 你想要的是一个非常小的清洁服务生态系统。

- 做太多的服务只是另一个巨石。 它很难推理,它很难扩展,很难改变,而且它还创建了比你想要的更多的上游和下游依赖。

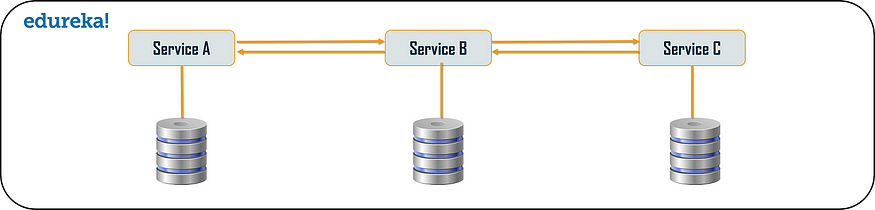

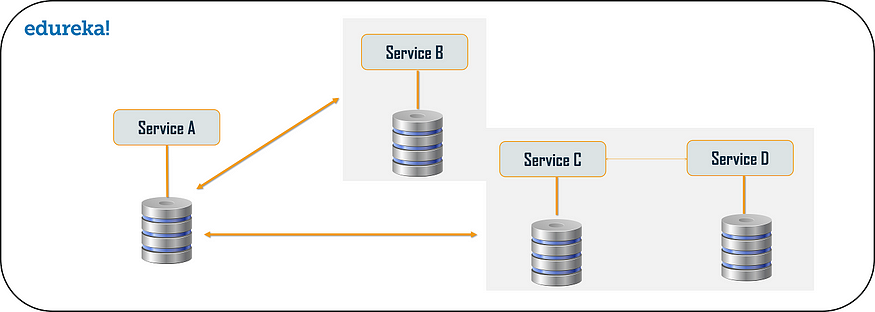

共享持久性

- 在分层模型中,服务放在应用程序层中,持久层作为应用程序的公共服务提供。

- 他们在eBay做到了这一点并没有奏效。 它打破了服务的封装。 应用程序可以通过更新数据库来支持您的服务。 它最终重新引入服务耦合。 共享数据库不允许松散耦合的服务。

- 微服务通过小型,隔离和独立来防止这个问题,这是您保持生态系统健康和发展的方式。

- 114 次浏览

「微服务架构」Saga 模式 如何使用微服务实现业务事务-第二部分

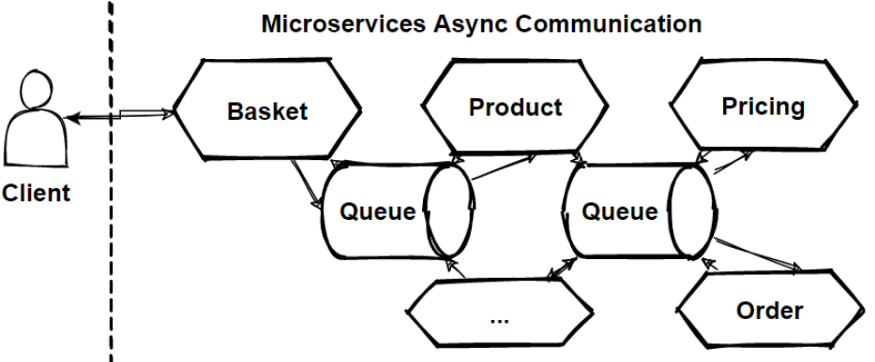

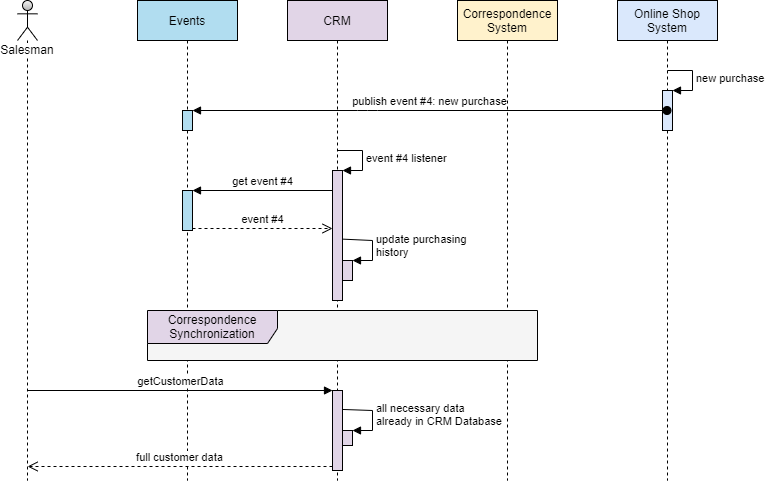

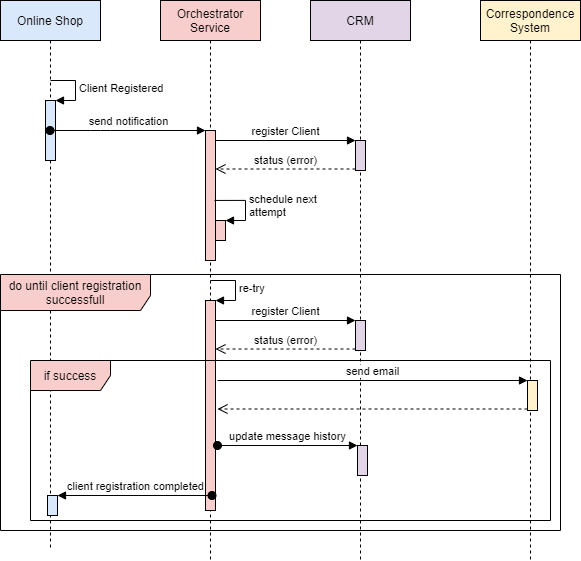

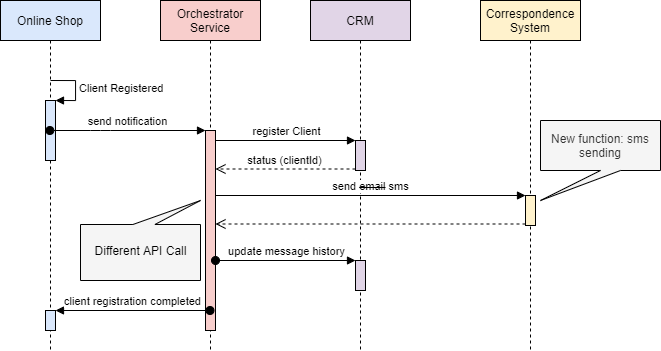

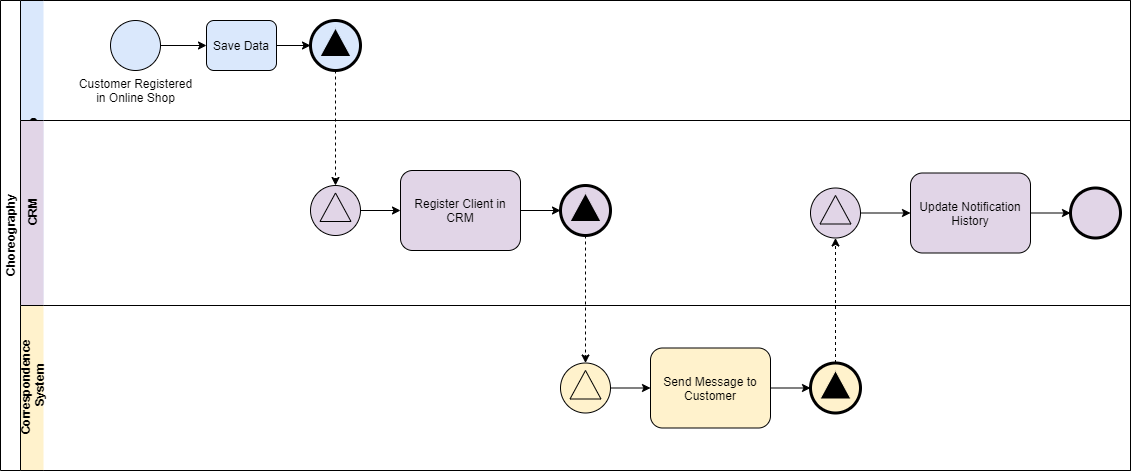

在上一篇文章中,我们看到了实现分布式事务的一些挑战,以及如何使用Event / Choreography方法实现Saga的模式。在本文中,我们将讨论如何通过使用另一种类型的Saga实现(称为Command或Orchestration)来解决一些问题,如复杂事务或事件的循环依赖性。

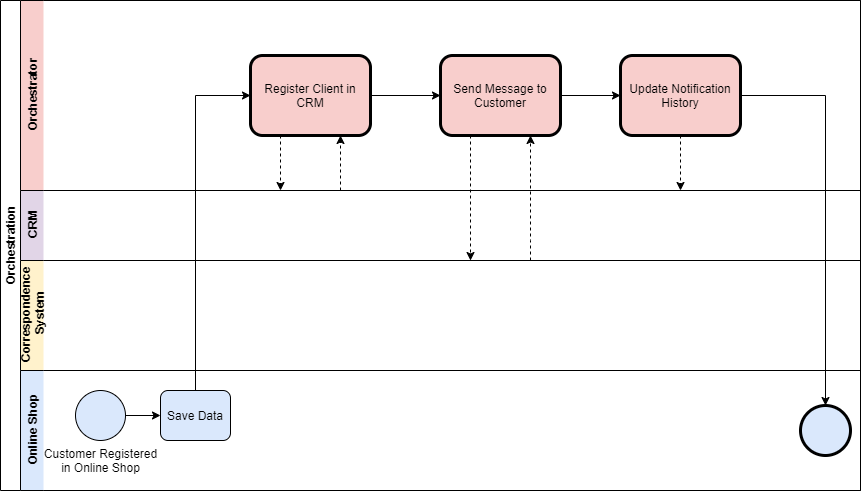

Saga的命令/编曲序列逻辑

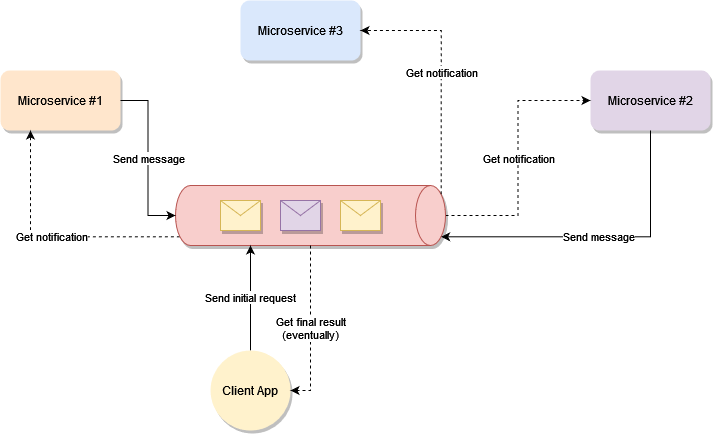

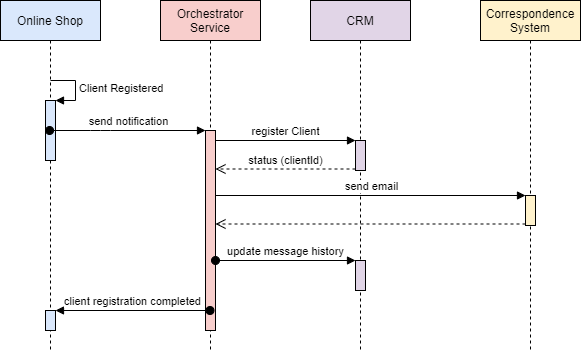

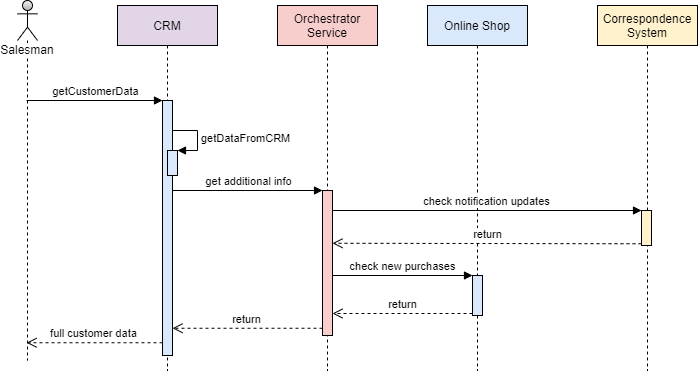

在编曲方法中,我们定义了一项新服务,其唯一责任是告诉每个参与者该做什么以及何时做什么。 saga orchestrator以命令/回复方式与每个服务进行通信,告诉他们应该执行哪些操作。

让我们看一下使用我们之前的电子商务示例的样子:

- 订单服务保存挂起的定单并要求Order Saga Orchestrator(OSO)启动创建订单交易。

- OSO向付款服务发送执行付款命令,并回复付款已执行消息

- OSO向库存服务发送准备订单命令,并回复订单准备消息

- OSO向Delivery Service发送Deliver Order命令,并以Order Delivered消息回复

在上面的例子中,Order Saga Orchestrator知道执行“创建订单”事务所需的流程是什么。如果有任何失败,它还负责通过向每个参与者发送命令以撤消先前的操作来协调回滚。

为saga协调器建模的标准方法是状态机,其中每个转换对应于命令或消息。状态机是构建定义明确的行为的极好模式,因为它们易于实现,特别适合测试。

在Saga的命令/编曲中回滚

当你有一个协调器来协调所有事情时,回滚会容易得多:

使用Saga命令/编曲设计的好处和缺点

基于编排的传奇有各种好处:

避免服务之间的循环依赖,因为saga orchestrator调用saga参与者但参与者不调用orchestrator

- 集中分布式事务的编排

- 降低参与者的复杂性,因为他们只需要执行/回复命令。

- 更容易实施和测试

- 添加新步骤时,事务复杂性保持线性

- 回滚更容易管理

- 如果您有第二个愿意更改同一目标对象的事务,您可以轻松地将其保留在协调器上,直到第一个事务结束。

然而,这种方法仍然存在一些缺点,其中之一是在协调器中集中过多逻辑的风险,最终导致智能协调器告诉哑巴服务该做什么的架构。

Saga的Orchestration模式的另一个缺点是它会略微增加您的基础架构复杂性,因为您需要管理额外的服务。

Saga(传奇)模式提示

- 为每个事务创建唯一ID

为每个事务提供唯一标识符是可追溯性的常用技术,但它也有助于参与者以标准方式相互请求数据。例如,通过使用交易ID,交付服务可以询问库存服务在哪里提取产品,如果订单已付款,则可以使用支付服务仔细检查。

- 在命令中添加回复地址

不要将参与者设计为回复固定地址,而是考虑在消息中发送回复地址,这样您就可以让参与者回复多个协调者。

- 幂等运算

如果您使用队列进行服务之间的通信(如SQS,Kafka,RabbitMQ等),我个人建议您使您的操作具有幂等性。大多数队列可能会两次传递相同的消息。

它还可能会增加您的服务的容错能力。通常,客户端中的错误可能会触发/重放不需要的消息并弄乱您的数据库。

- 避免同步通信

随着事务的进行,不要忘记将每个要执行的操作所需的所有数据添加到消息中。整个目标是避免服务之间的同步调用只是为了请求更多的数据。即使其他服务处于脱机状态,它也可以使您的服务执行本地事务。

缺点是您的协调器会稍微复杂一些,因为您需要操纵每个步骤的请求/响应,因此请注意权衡。

- 103 次浏览

「微服务架构」Saga 模式|如何使用微服务实现业务事务 第一部分

最强大的事务类型之一称为两阶段提交,当第一个事务的提交取决于第二个事务的完成时,它是摘要。特别是当您必须同时更新多个实体时,例如确认订单和立即更新库存时,它非常有用。

但是,例如,当您使用微服务时,事情变得更加复杂。每个服务都是一个独立的系统,拥有自己的数据库,您不再可以利用本地两阶段提交的简单性来维护整个系统的一致性。

当你失去这种能力时,RDBMS成为一个非常糟糕的存储选择,因为你可以完成相同的“单实体原子事务”,但只需使用像Couchbase这样的NoSQL数据库就可以快几十倍。这就是为什么大多数使用微服务的公司也在使用NoSQL。

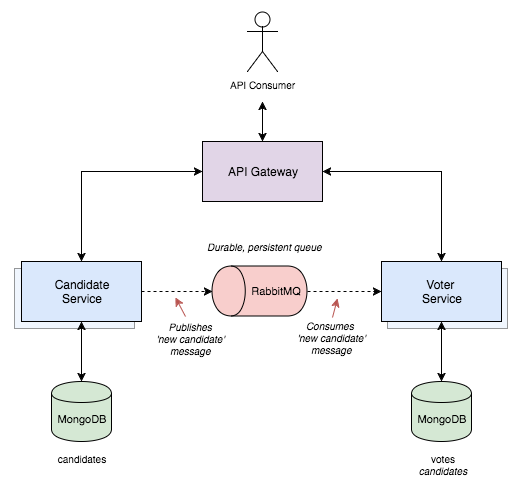

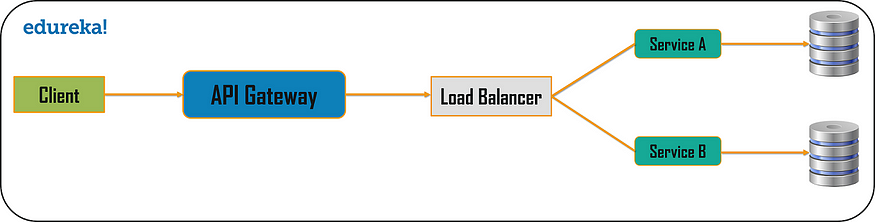

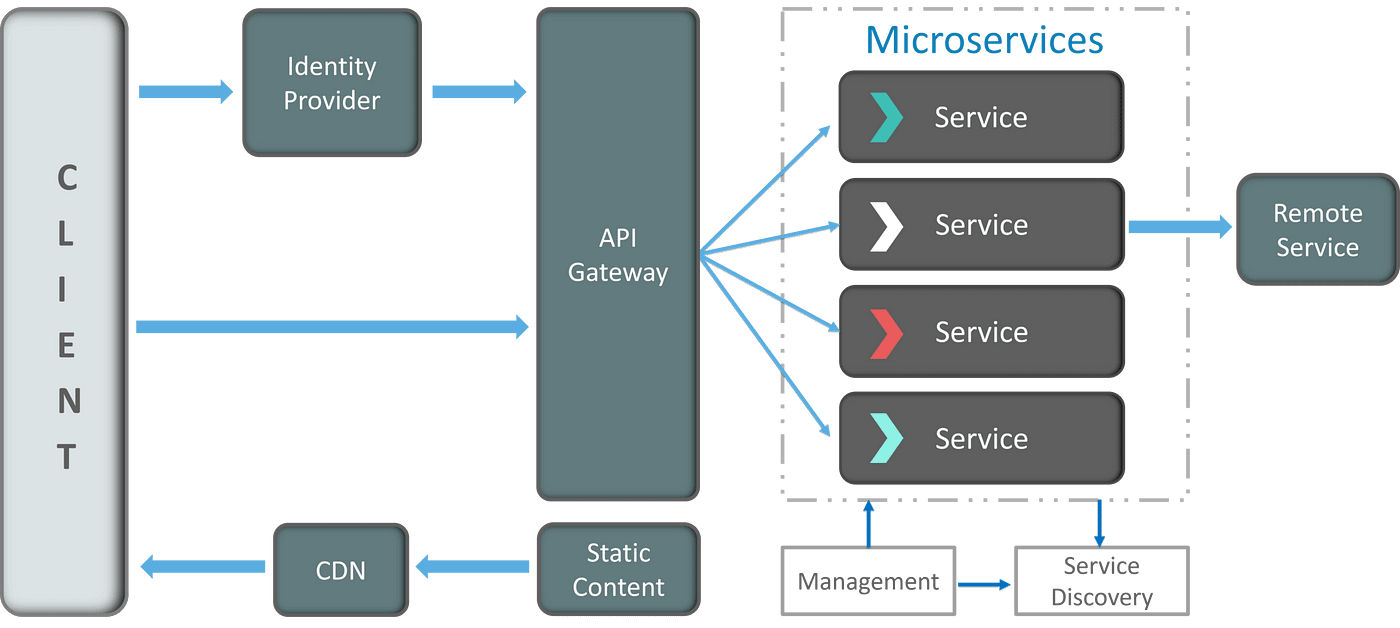

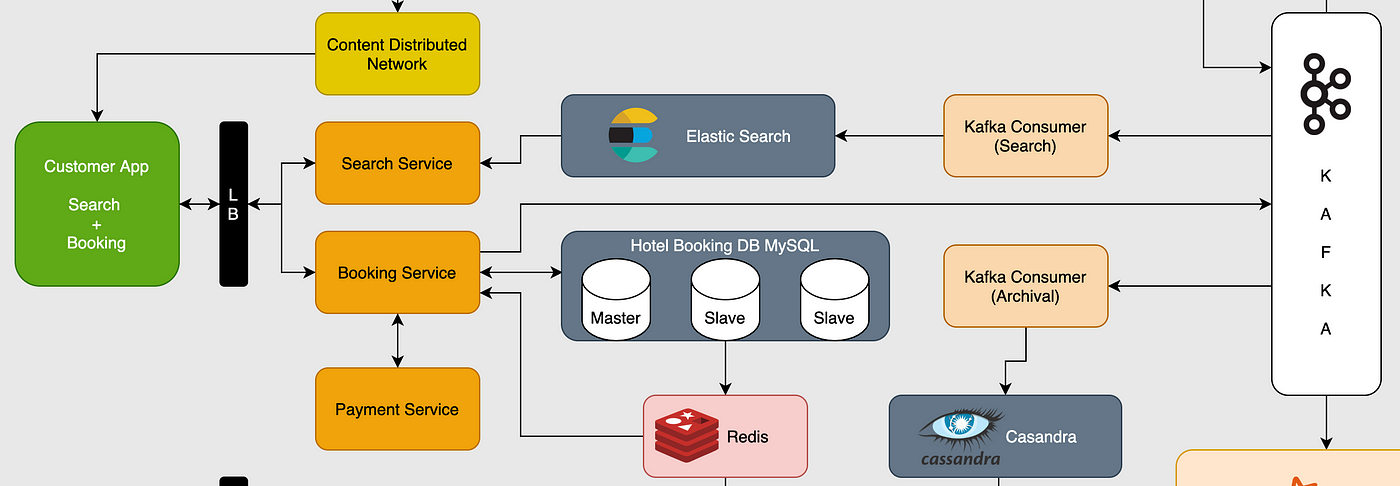

要举例说明此问题,请考虑以下电子商务系统的高级微服务架构:

在上面的示例中,人们不能只在一个ACID交易中下订单,向客户收费,更新库存,并将其发送到交货。要始终如一地执行此整个流程,您将需要创建分布式事务。

我们都知道实现分布式任务是多么困难,不幸的是,交易也不例外。处理瞬态状态,服务,隔离和回滚之间的最终一致性是在设计阶段应该考虑的场景。

幸运的是,我们已经为它提出了一些好的模式,因为我们已经实施分布式事务已有二十多年了。我今天要谈的那个叫做Saga模式。

传奇(Saga)模式

分布式事务最着名的模式之一称为Saga。关于它的第一篇论文发表于1987年,从那时起它就成了一种流行的解决方案。

Saga是一系列本地事务,其中每个事务在单个服务中更新数据。第一个事务由对应于系统操作的外部请求启动,然后每个后续步骤由前一个完成触发。

使用我们之前的电子商务示例,在一个非常高级的设计中,Saga实现如下所示:

有几种不同的方法来实现传奇交易,但最受欢迎的两种方式是:

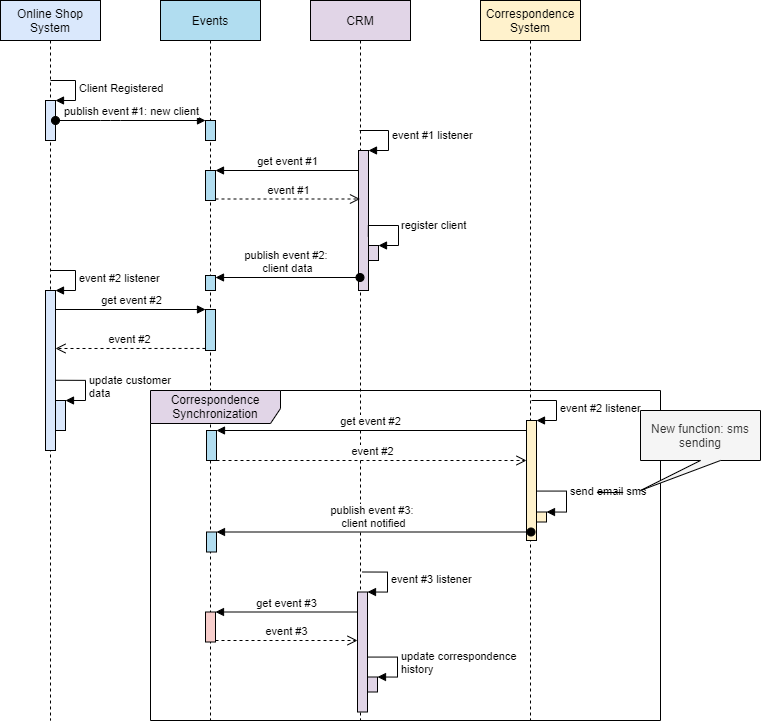

- 事件/Choreography(编舞):当没有中央协调时,每个服务产生并监听其他服务的事件,并决定是否应该采取行动。

- 命令 / Orchestration(编曲):协调器服务负责集中saga的决策和排序业务逻辑。

让我们更深入地了解每个实现,以了解它们的工作原理。

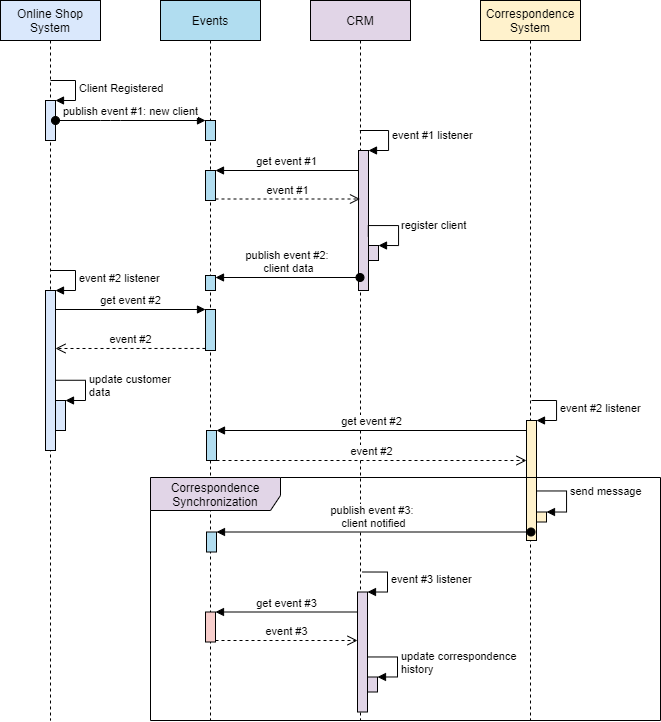

事件/编舞

在事件/Choreography(编舞)方法中,第一个服务执行事务然后发布事件。该事件由一个或多个服务监听,这些服务执行本地事务并发布(或不发布)新事件。

当最后一个服务执行其本地事务并且不发布任何事件时,分布式事务结束,或者任何传奇(Saga)参与者都不会听到发布的事件。

让我们看看它在我们的电子商务示例中的样子:

- 订单服务保存新订单,将状态设置为挂起并发布名为ORDER_CREATED_EVENT的事件。

- 付款服务侦听ORDER_CREATED_EVENT,向客户收费并发布事件BILLED_ORDER_EVENT。

- Stock Service监听BILLED_ORDER_EVENT,更新库存,准备订单中购买的产品并发布ORDER_PREPARED_EVENT。

- Delivery Service侦听ORDER_PREPARED_EVENT,然后选择并交付产品。最后,它发布了ORDER_DELIVERED_EVENT

- 最后,Order Service侦听ORDER_DELIVERED_EVENT并将订单状态设置为已结束。

在上面的情况中,如果需要跟踪订单的状态,订单服务可以简单地监听所有事件并更新其状态。

分布式事务中的回滚

回滚分布式事务并非免费。通常,您必须实施另一个操作/事务来补偿之前已完成的操作。

假设Stock Service在交易期间失败了。让我们看看回滚会是什么样子:

- 库存服务生产PRODUCT_OUT_OF_STOCK_EVENT;

- 订单服务和付款服务都会收听上一条消息:

- 付款服务退还客户。

- 订单服务将订单状态设置为失败。

请注意,为每个事务定义一个公共共享ID至关重要,因此每当您抛出一个事件时,所有侦听器都可以立即知道它所引用的事务。

Saga 事件/Choreography(编舞)设计的好处和缺点

事件/编排是实现Saga模式的自然方式;它简单,易于理解,不需要太多的努力来构建,并且所有参与者都是松散耦合的,因为他们没有彼此的直接知识。如果您的交易涉及2到4个步骤,那么它可能非常合适。

但是,如果您不断在事务中添加额外的步骤,这种方法很快就会变得混乱,因为很难跟踪哪些服务监听哪些事件。此外,它还可能在服务之间添加循环依赖,因为它们必须订阅彼此的事件。

最后,使用这种设计实现测试会很棘手。为了模拟事务行为,您应该运行所有服务。

在下一篇文章中,我将解释如何使用另一个名为Command / Orchestration的Saga实现解决Saga事件/编舞方法的大部分问题。

- 50 次浏览

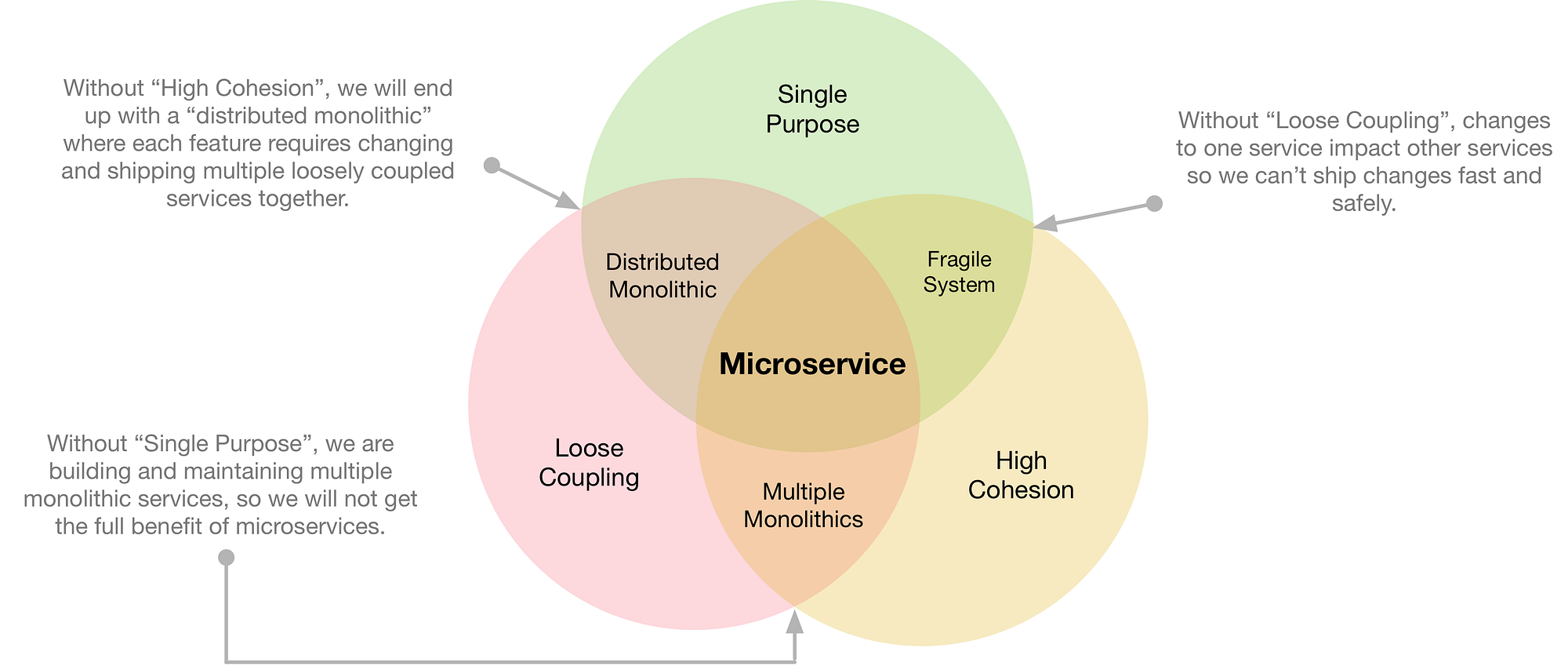

「微服务架构」七种微服务反模式

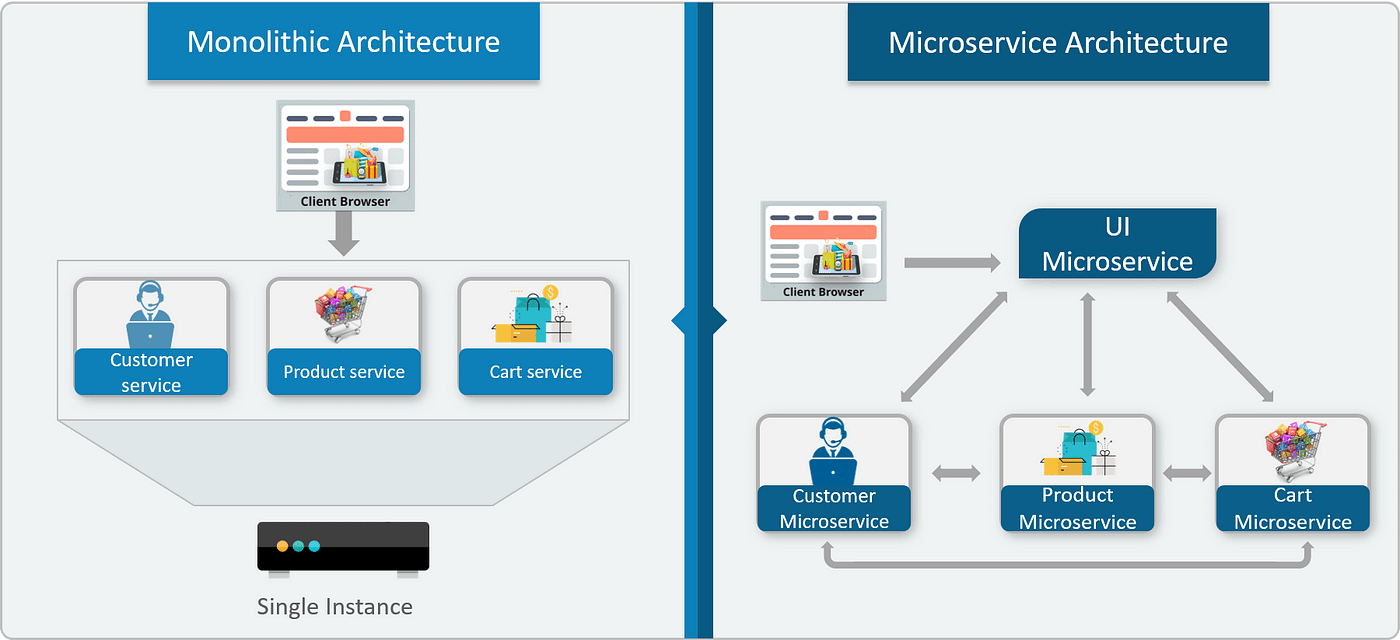

什么是微服务

流行语经常为进化的概念提供背景,并且需要一个良好的“标签”来促进对话。微服务是一个新的“标签”,它定义了我个人一直在发现和使用的领域。文章和会议描述了一些事情,我慢慢意识到,过去几年我一直在发展自己的个人经历。虽然有关微服务的行业和专业讨论已经成为Netflix,亚马逊和谷歌等公司以及成功完成这项工作的从业者的焦点,但我有一些个人经验可以为成功的微服务实施提供见解。

任何架构的三个标准和最常见的业务驱动因素是:

- 提高敏捷性 - 及时响应业务需求以便业务增长的能力

- 改善客户体验 - 改善客户体验,从而减少客户流失

- 降低成本 - 降低添加更多产品,客户或业务解决方案的成本

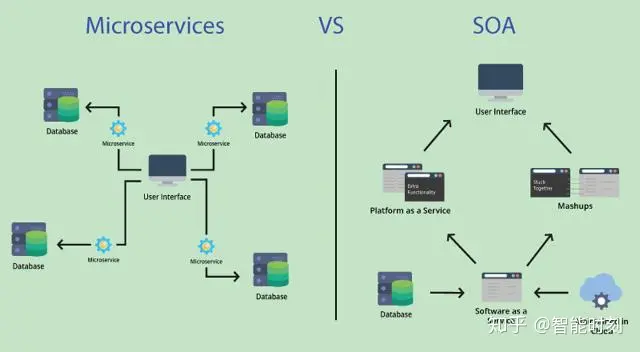

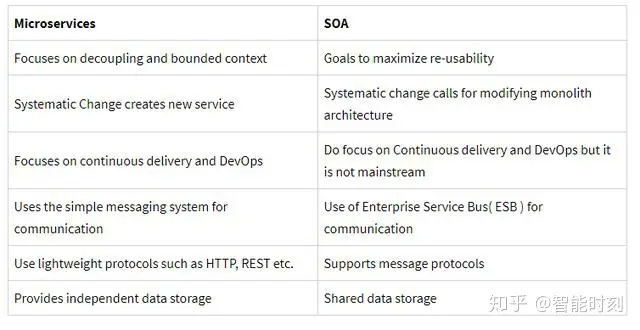

事实上,我们所有人都在努力在日常工作中这样做。 SOA创建了一个业务一致的软件框架,使企业能够实现这一目标。几家大型软件供应商已经出现并声称他们的产品套件可以使企业提供SOA。

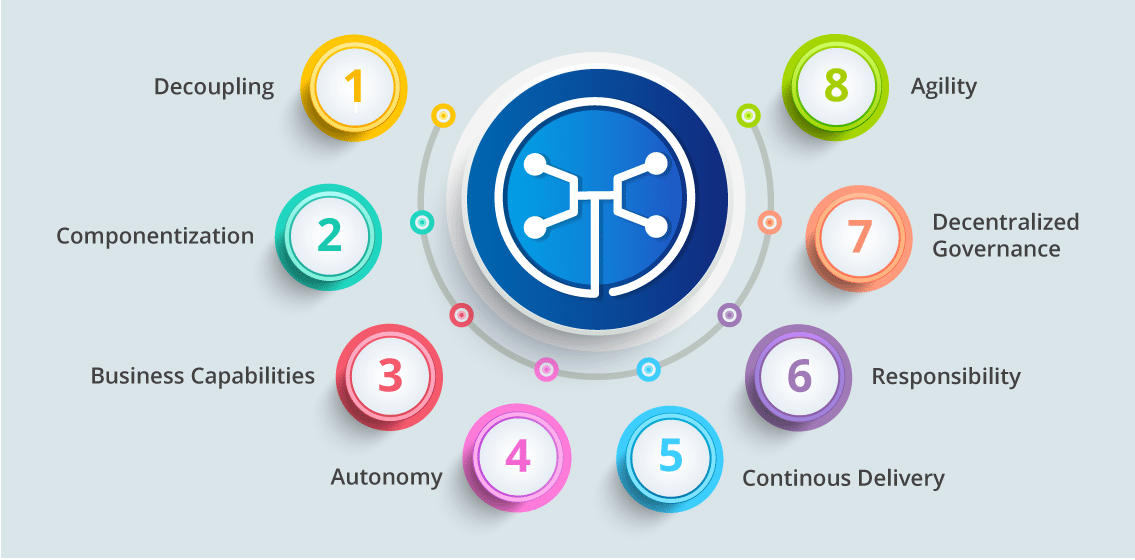

如果您没有合适的人员,文化和投资,SOA将无法实现业务价值。微服务架构与SOA并没有根本的不同,目标和目标是相同的,但是方法略有改进,事实上,我只是说微服务仅仅是SOA可扩展的。微服务使应用程序/系统迫切需要从单一实现转移到服务于许多应用程序的分布式分散服务平台。微服务是独立的,它将敏捷性和应用程序演变视为企业数字化转换。微服务的成功取决于服务独立性和服务灵活性。

我将微服务定义为“通过构建细粒度服务以支持分布和组织为功能域的业务功能来提供SOA的方法”。没有模式是魔术棒或银弹。您应该正确构思和定制模式企业应该专注于解决支持架构所需的项目以构建自适应平台。

一些企业的SOA实施失败了 - 因为他们没有完全分析他们的业务能力模型,并认为开发Web服务意味着SOA或从大型供应商购买SOA套件会使他们启用SOA或无法显示SOA及其业务驱动因素/目标。

举例

经验的一个例子可能会澄清这一点。在过去的一份工作中,该企业的目标是提高敏捷性,客户体验并降低成本。我们决定构建一个标准的多租户SOA平台。该方法旨在开发细粒度的服务,以便我们可以经常进行更改,并为平台部署小的,可管理的更改。如果我们今天采用相同的方法,我们可能会称之为微服务架构。那时我们没有这个词,但它才有意义。

服务是基于业务能力模型建模的,第一个版本进展顺利。它们是基于JMS同步服务的XML,主要侧重于提供向代理,Web和语音通道应用程序公开的声明平台所需的功能。它使我们能够为我们的应用程序无缝部署频繁,小的更改和A / B功能支持。

当需求逐渐增加(并且它们总是如此)时,由于应用程序和消费者之间的集成复杂性,很难快速发布解决方案。集成,功能测试和生产发布需要紧密协调。随着业务开始扩展,更改频率比初始版本高出10倍,并且由于交付生命周期中的大多数任务都是手动的,因此上市时间不符合业务预期。很快,由于糟糕的微服务自动化和生命周期管理导致交付熵,我们的目标都没有实现。

经验教训 - 不要做这些事情,而是......做其他事情

这让我分享了我在旅途中学到的一些课程,以便您在使用微服务上路时能够密切关注这些项目

- 1)凝聚力混乱

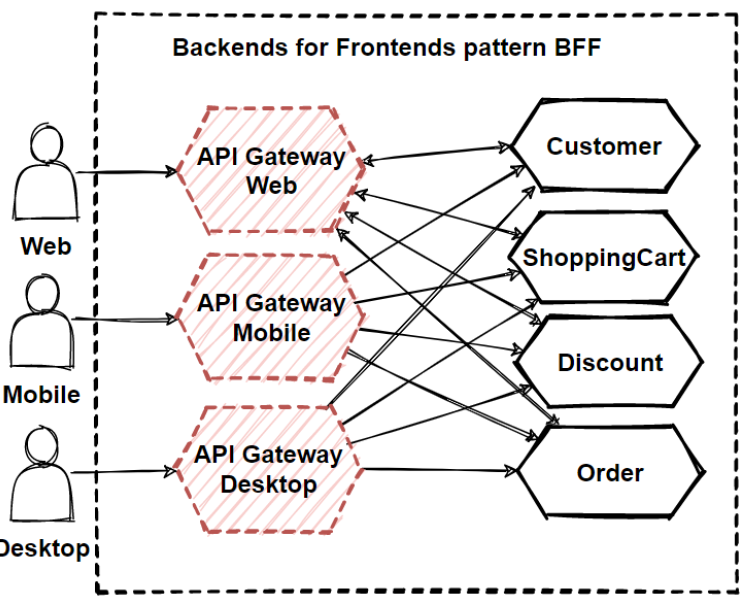

我们开发了一项服务,以获取客户信息,旨在提取客户政策信息,个人信息和他们注册的计划。一段时间以来,它开始做的不仅仅是获取客户信息。随着新要求的出现,该服务经历了频繁的更改和部署。它无法扩展并满足所需的可用性。它成了众所周知的“泥球大球”。它是怎么到达那里的?对于初学者来说,没有关于功能性关注分离的治理。如果一个有影响力的消费者要求在这一项服务中加入不相关的逻辑来减少往返行程,那么这个功能就毫无疑问地被打了。也许网关或BPM层本可以避免这种情况,但是没有时间......只是时间来制定另一个业务功能点。

预防性治疗是为了管理与服务无关的业务功能。服务必须与业务能力明确对齐,不应试图在其边界之外做某事。关注的功能分离对于架构管理至关重要,否则会破坏敏捷性,性能和可伸缩性,最终建立紧密耦合的架构,导致传递熵和内聚混乱。

- 2)不认真对待自动化

我们没有自动部署策略和ops服务监控(运行时QoS指标)。它显然增加了部署期间的运营费用和手动错误。多次生产部署导致配置错误导致中断。这些服务始终以HA模式部署,因此容器数量是服务总数的3倍。操作团队无法手动处理每项服务的配置。经过一段时间后,操作人员开始抱怨架构效率低下,因为他们无法处理增加的容器数量。

这是什么疫苗?配方有多种成分。如果您还没有这样做,持续部署是每个企业都应该追求的必须投资和文化变革。至少,如果你没有办法自动测试和部署 - 不要做微服务。微服务的目标是以我们需要改变的速度来提高敏捷性;质量保证涉及每项服务都具有自动化单元,功能,安全性和性能测试。当我们开发与我们无法控制的服务集成的服务时,服务虚拟化是另一个强大的概念。

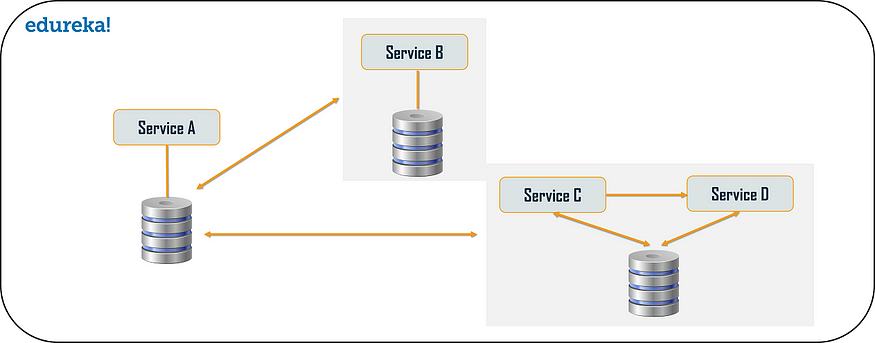

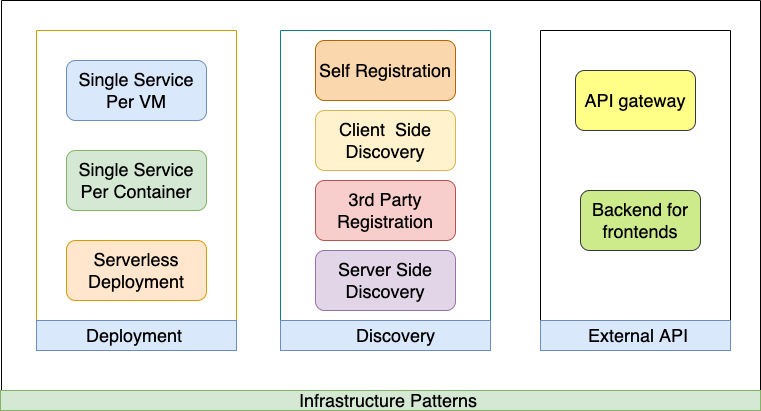

- 3)分层服务架构

人们用SOA做出的一个常见错误是误解了如何实现服务的可重用性。团队主要关注技术凝聚力,而不是关于可重用性的功能。例如,若干服务用作数据访问层(ORM)以将表公开为服务;他们认为这将是高度可重复使用的。这创建了由横向团队管理的人工物理层,这导致了交付依赖性。创建的任何服务都应该是高度自治的 - 意味着彼此独立。

创建多个技术,物理层的服务只会导致交付复杂性和运行时效率低下。我们最终拥有包装服务,编排服务,业务服务和数据服务。这些服务模型提供了技术问题。各个团队成立以管理这些层,最终导致业务逻辑蔓延,没有单一的业主能力,失去效率,总是有一个责备游戏。

服务中的层的逻辑分离很好,但是,不应该有任何进程外调用。尝试将服务视为一个原子业务实体,它必须实现一切以实现所需的业务功能。自包含服务比分层服务更具自主性和可扩展性。在多个服务中重写一些常用代码是完美的,这很好,并且保持自治级别是一个很好的权衡。最重要的是,没有技术问题分开的服务,而是必须根据业务能力将它们分开。由于这种特性,集装箱化的概念正在蓬勃发展。

- 4)依靠消费者签字

我们有来自三个不同渠道的多个应用程序所消耗的服务,即代理,网络和语音。代理渠道是我们的主要渠道,因此服务必须等待他们在投入生产之前签字。它延迟了语音和Web应用程序的生产版本。是什么将这三个通道紧紧地联系在一起?

当涉及通道特定功能时,该服务不是松散耦合的。为您的服务提供独立性。您提供的每项服务都必须具有测试套件,该套件应涵盖所有当前和未来消费者的所有服务功能,安全性,性能,错误处理和消费驱动测试。这必须作为自动回归测试的构建管道的一部分包含在内。

- 5)手动配置管理:

当我们开始做大量服务(并且由于缺乏服务生命周期治理而导致的不可避免的蔓延表现)时,管理每个服务的配置失控。由于密码错误,URL错误,值不正确等配置失败,我们的大部分生产部署都不顺利。手动管理这些变得越来越难。如果我们只使用应用程序配置管理工具作为PaaS或CD的一部分......但我们没有。

6)版本避免:

天真地,我们认为只需要一个版本的服务。然后我们开始添加主要的次要版本以适应多个消费者和频繁的变化。最终,每个版本都必须是主要版本,因为服务依赖于消费者签名。结果,容器的数量增加得非常快,并且管理它们变得非常痛苦。缺乏运行时治理是导致此问题的另一个方面。有些企业愚蠢地试图避免版本控制。假设变更是不可避免的,需要对服务进行架构。制定策略来管理向前兼容的服务更改,并让您的消费者优雅地升级。否则,它将导致消费者紧密绑定到服务版本并在发生更改时中断。

随着微服务世界所期望的服务数量的增长,复杂性也在增长。有一个版本控制策略,可以让消费者进行优雅的迁移,并确保提供商可以透明地部署更改,而不会影响任何人。限制生产中并排主要版本的数量并管理它们。

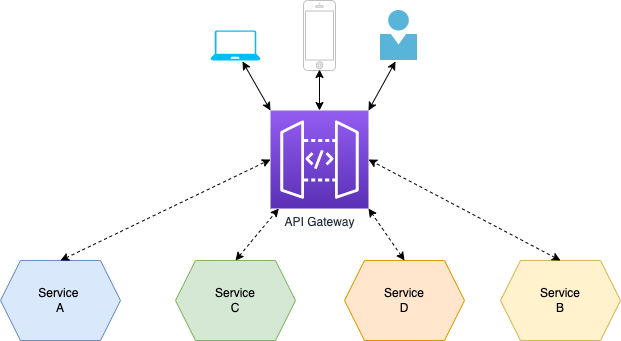

- 7)在每个服务中构建网关

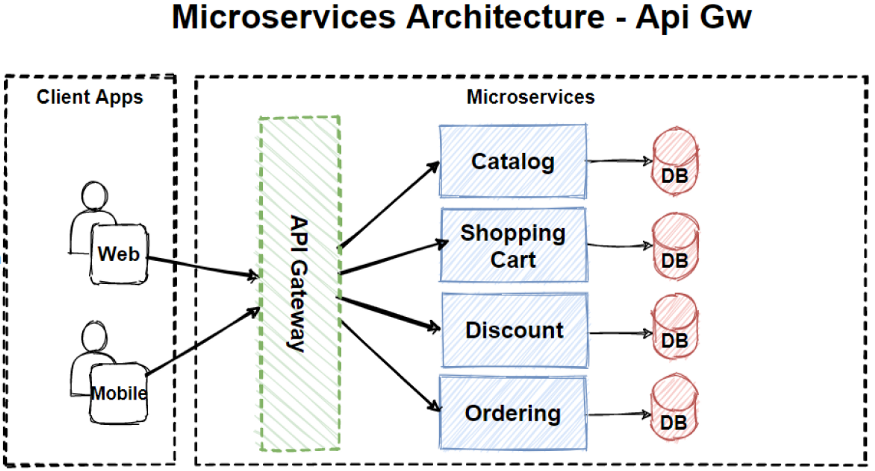

我们没有API网关,我们没有运行时治理(我们不知道谁在什么时间消耗什么以及以什么速度消费)。我们开始在每个服务中实现最终用户身份验证,限制,协调,转换和路由等。它增加了每个服务的复杂性,并且我们失去了从服务到服务的实现的一致性,因此我们不知道谁实现了什么和哪里。最重要的是,我们的一些服务是为满足一个消费者的非功能性需求而构建的,而不是另一个。如果我们有一个网关,应用一些数据过滤和丰富模式就可以做到。要是。

投资API管理解决方案,以集中,管理和监控一些非功能性问题,并且还可以消除消费者管理多个微服务配置的负担。可以使用API网关编排可以减少Web应用程序往返的跨功能微服务。

结论

微服务的目标是解决三个最常见的问题,即改善客户体验,高度敏捷地满足新要求,并通过将业务功能作为细粒度服务来降低成本。这不是一个灵丹妙药,需要一个规范的平台,以高质量的敏捷方式提供服务。从其他错误中学习(我的)并避免在架构和交付过程中列出的上述模式。这是我们谈论集装箱化,云采用等之前的第一步。我希望本文能为您的企业提供一些思考,并在将这些反模式编织到您的架构之前解决这些反模式。大多数项目将推动组织内部的文化变革,不能仅靠自己完成,确保与您的高管和高级领导者建立伙伴关系。

- 50 次浏览

「微服务架构」亚马逊引领其自有微服务架构的原因

新堆栈”的真实故事,一次又一次,是关于具有巨大服务器需求的公司如何受到现有架构无法满足这些需求的限制,如何为自己解决问题,然后转而将其解决方案转售给 剩下的世界。 我们多么快地忘记了最早的例子,但也许仍然是最好的,是亚马逊。

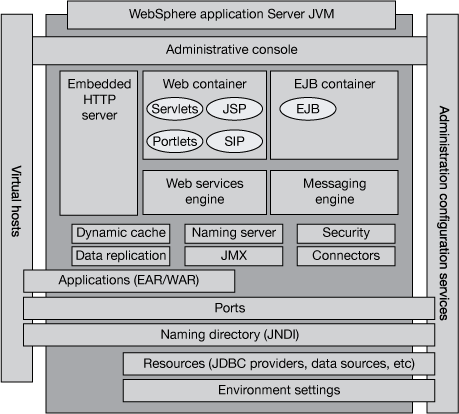

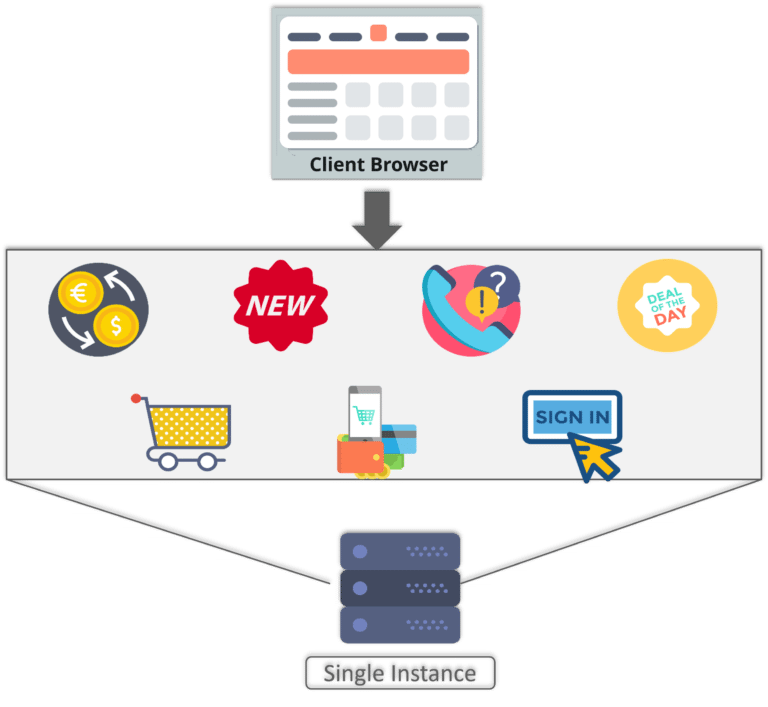

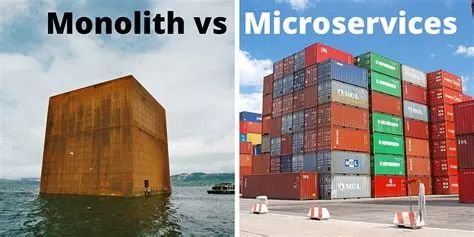

“如果你回到2001年,”亚马逊AWS产品管理高级经理Rob Brigham表示,“亚马逊零售网站是一个庞大的单体架构。”

布里格姆星期三在亚马逊举行的2015年拉斯维加斯发布会上发表了一个主要参与人数很多的主要舞台。 他随行的幻灯片显示了一个公认的“2001”单体,这次高耸于辉煌的华盛顿山湖旁边,可能就在附近。 他对亚马逊的历史时机或者他自己的历史时机的聪明才智只是嗤之以鼻。

“现在,不要误会我的意思。 它的架构分为多层,这些层中有很多组件,“Brigham继续说道。 “但他们都非常紧密地联系在一起,他们表现得像一个巨大的巨石。 现在,许多创业公司,甚至是大公司内部的项目,都是以这种方式开始的。 他们采取一体化的方法,因为它很快就能快速行动。 但随着时间的推移,随着该项目的成熟,随着您在其上添加更多开发人员,随着它的增长和代码库变得越来越大,架构变得越来越复杂,这个整体将为您的流程增加开销,而软件开发生命周期也是如此。 开始减速。“

Brigham提出了软件开发生命周期(SDLC)作为开发团队结构的主题 - 特别是,当处理像Amazon.com这样的单一应用程序在2001年面临的实质内容时,开发人员将彼此区分开来,将团队从最终目标中分离出来。他们真正革命性地解决这个问题的方法成为了导致云计算创建的原型之一(美国宇航局的星云项目是其中之一)。

Brigham还透露的是,原始Amazon.com的非常类似tarball的粘性激发了另一个革命性的概念:服务架构的解耦。也许亚马逊没有发明微服务,也许它不是敏捷方法的先驱。但进化并不总是首先在一个地方发生。有大量证据表明亚马逊确实主动提出了这些概念。

Brigham讲述了亚马逊工程团队的故事,该工程团队在2000年有一项艰巨的任务,即协调数百名开发人员的进程内更改,解决他们之间的所有冲突,将它们合并为一个版本,并生成等待的主版本要移入生产的队列。 “即使你有那么庞大的新版本,”他说,“它仍然会在这个交付渠道上增加很多开销。整个新的代码库需要重建。所有测试用例都需要重新运行,以确保没有任何冲动。然后你需要整个应用程序,并将它全部部署到你的完整生产车队。“

亚马逊的方法不是摆脱管道,而是简化它。该公司的持续部署工具 - CodeDeploy,CodePipeline和CodeCommit - 围绕真正的云原生Web应用程序构建,其中该管道的各个部分可以编写脚本并自动化。 Rob Brigham表示,从世纪之交开始,亚马逊制造的建筑和物流变化直接导致了它现在为开发团队提供的工具。

上个月,Pivotal工程师Rohit Kelapure在详细描述整体架构的分解中描述了SpringOne 2GX会议的记忆,亚马逊的Brigham将他和他的同事们如何“将其分开”与Amazon.com单体相关联面向服务的架构。

“我们完成了代码,并提取了功能单元,这些功能单元只用于一个目的,我们用网络服务接口包装了这些功能单元,”他说。例如,有一项服务在零售商的产品详细信息页面上呈现“购买”按钮。另一个人有结账时计算正确税的功能。

在它们创建时,这些单一用途的功能似乎很容易实现。但想象一下数百个开发团队,其中一些由当时的数十个开发人员组成(而不是更舒适的“两个比萨”大小,不超过八个),其简单,单一用途的功能必须合并在一起一周又一周......以及之后的月份,随着SDLC的结构变得更大更庞大。

解耦管道

单一功能问题的解决方案是创建一个规则,开发人员必须遵守该规则,这些功能只能通过自己的Web服务API与世界其他地方进行通信。 “这使我们能够创建一个非常高度分离的体系结构,”Brigham说,“只要这些服务符合标准的Web服务接口,这些服务就可以彼此独立地迭代而不需要任何协调。”

服务的去耦使创建第一个自动部署系统之一,与原型的大部分时间今天亚马逊提供的客户 - 适当命名的“阿波罗”它帮助引进管道模型亚马逊的文化,它可能是Brigham在会议中明智地应用了一些自由编辑,因为这个过程不可能很简单。

但他对这方面很直率:通过能够看到管道作为图形化的东西,具有大小和形状,亚马逊的工程师可以更加确定他们需要多少改变他们的流程。当然,它们可以实现自动化,但为什么要实现冗余自动化?

“我们仍然注意到代码更改要花费很长时间才能从开发人员签到,到生产中运行,客户可以使用它,”他说。 “因此,作为一家以数据为导向的公司,我们对此进行了研究。 我们测量了代码更改在整个部署生命周期中跨越多个团队所花费的时间。 当我们将这些数据相加,并查看结果,并查看平均花费的时间时,我们坦率地感到尴尬。 这大约是几个星期。“

打破这些行动有助于工程师意识到这个管道中段的顺序和排列导致了“死时间” - 没有发生任何事情的间隔。 这尤其发生在部门之间的人工交接之间 - 其个性化应该引入流程完整性的交接,但实际上,这导致了低效率,浪费的空间和长长的队列。

“对于像亚马逊这样以效率而自豪的公司 - 对于一家在我们的履行中心内使用机器人来移动实体商品的公司,一家希望使用无人机将包裹部署到您家门口的公司 - 您可以想象它有多疯狂, “他说,”我们在软件交付过程中使用人来传递这些虚拟位。“

Brigham的演讲引发了CodePipeline的演示,其中包括在部署管道中发生的事件的内联脚本,以及与Amazon和GitHub上的私有存储库的集成。 亚马逊在这一点上表示,它正在避免将开发商店锁定为亚马逊品牌的做事方式,这与其合作伙伴生态系统之外的一些人所说的相反。

在这一点上你可能会想到Rob Brigham正在向合唱团讲道,或者说他正在捕鱼以获得亚马逊应该为这个行业创造的一些应得的赞誉。 事实上,令人尴尬的是,虽然这可能是为了观众中的很多人并观看现场直播而承认,亚马逊2001年的故事是他们2015年的故事。

- 80 次浏览

「微服务架构」从SOA进化看微服务架构治理

许多组织已经从SOA转移,但微服务的引入已经改变了治理游戏。 吐温泰勒解释了事情的变化。

微服务为IT的各个方面带来变化,尤其是IT治理的完成方式。 用英国政府数字服务部技术和运营副主任迈克尔·布伦顿 - 斯帕尔的话来说,"Microservices trade complicated monoliths for complex interacting systems of simple services."(微服务 交易(交换/替代) 用于简单服务的复杂交互系统的复杂整体 )

这组复杂的简单服务需要相互交流,并以与传统巨石/单体不同的方式进行管理。但这在实践中意味着什么?来!我们讨论一下。

分散的微服务治理

整体治理是集中的。决策是自上而下的,并且保持严格的控制以确保整个组织和应用程序堆栈的一致性。随着时间的推移,这种模式退化,创造了一个技术和架构停滞不前的系统,并减缓了创新的步伐。团队被迫仅仅遵循既定的事情顺序,而不是寻找新的,创造性的问题解决方案。

对于微服务治理,分散模型效果最好。正如应用程序本身被分解为众多相互依赖的服务一样,大型孤立的团队也被分解为小型的多功能团队。这是从开发,测试和IT团队转变为较小的DevOps团队的过程。

团队可以使用他们的首选语言和工具来构建他们拥有的服务,而不是使用相同的编程语言或技术框架来解决整个组织中的所有问题。这将导致缺乏统一性,这实际上可能是一个好处而不是一个缺点。首先,当每个决策涉及的繁文缛节较少时,解决方案的实施速度会更快。而且,由于构建服务的团队拥有其实施和维护,因此对服务的运行拥有更多的所有权,并且他们能够将其发展到更高的水平。

因此,对于刚刚创建并且没有单体历史的应用程序,这种分散的治理模型何时开始?它不是最低可行产品(MVP)阶段,因为在那时,应用程序只不过是一个想法。然而,当一个应用程序投入生产时,它很快就需要采用微服务架构,这就是分散治理开始的时候。

创新与治理

创新速度是实施DevOps的关键目标之一。但IT对治理的关注似乎与此结果相矛盾。这就是为什么IT和开发团队在尝试在创新和实际治理之间找到适当平衡时彼此之间往往会相互争吵的原因。

然而,这是一种错误的二分法。真正的创新不会忽视良好的治理,而伟大的治理应该支持最好的创新。因此,开发和运营团队处于同一方并具有相同的优先级和目标的DevOps原则是良好治理的推动因素。

对于微服务,分散治理是必要的。

DevOps团队必须明白,通过选择他们选择的平台和工具的能力,我们有责任遵守IT部门制定的企业标准。这就是为什么亚马逊在大约十年前刚刚开始作为云供应商时采用了“你建立它,你运行它”的座右铭。亚马逊网络服务公司希望其开发人员与IT共享对其提供的应用程序和功能的稳定性和可靠性的责任。这一原则有助于推动它成为当今领先的基础设施即服务平台。

在不牺牲控制的情况下加速治理的一种方法是自动执行任务。这种自动化可以在治理的不同方面发生,例如安全性和可靠性。

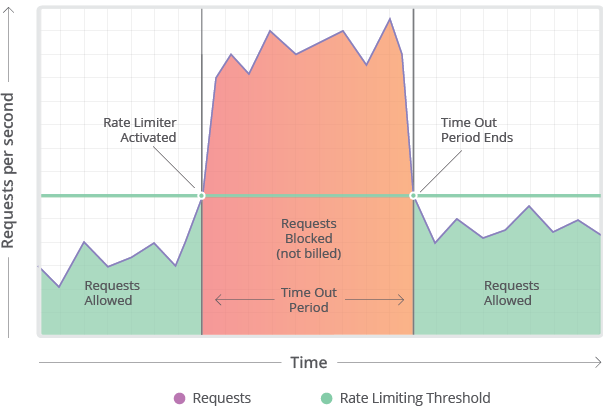

安全

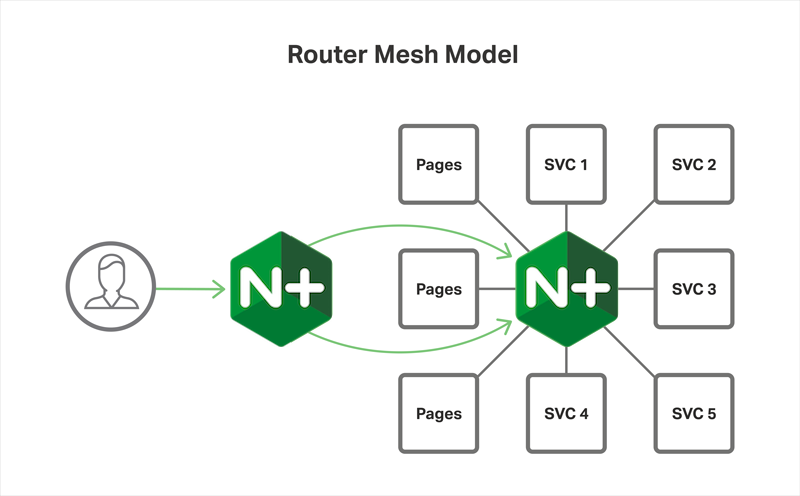

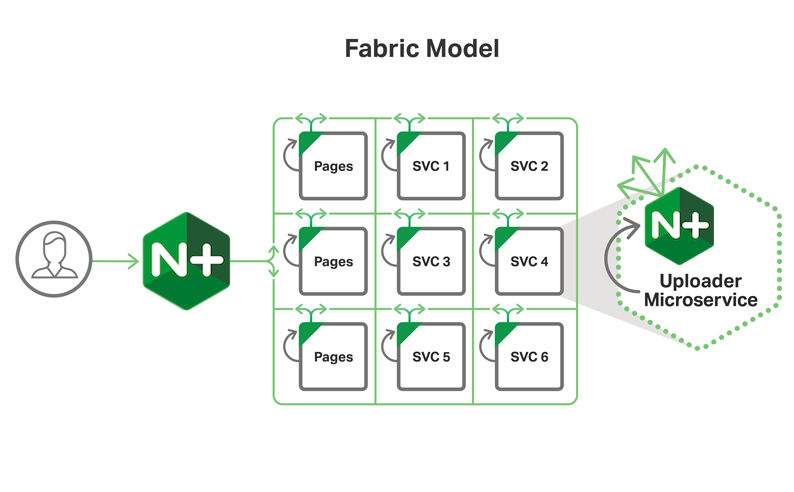

自动化安全涉及策略的组合。与单个大型单片应用程序相比,分布式,API可访问的应用程序对攻击者具有更多潜在的入口点,但通常,使用访问控制规则,Web应用程序防火墙(WAF)的组合可以更容易地保护这些入口点。规则,身份验证和速率限制。自动执行这些任务需要一个可以处理负载平衡,内容缓存,安全策略等的现代Web服务器。

这种平台的一个例子是Nginx Plus。其ModSecurity WAF可保护应用程序层免受攻击,例如SQL注入,本地文件包含,跨站点脚本和某些类型的分布式拒绝服务攻击。此工具可用于静态分析代码,针对代码运行渗透测试和模糊输入,并识别常见的安全相关编程错误,例如无效输入。

可靠性

为了使微服务应用程序顺利运行,其服务需要能够彼此通信并且能够很好地协同工作。这需要良好的服务发现。随着为服务提供动力的底层节点或容器的更改,它们需要由系统识别。这样,服务仍然可见,并且可以成功路由请求。

此外,随着请求的激增,它们无法由单个实例处理,需要跨其他实例进行路由以共享工作负载。这种类型的服务发现和负载平衡 - 在协同工作时 - 使您能够构建可承担任何工作负载的可靠应用程序。

对于微服务治理,分散化是必要的。它提供了开发人员所渴望的创新和灵活性,同时保持了IT运营人员所需的安全性和可靠性。当您希望管理您的应用程序以使其更可靠和安全时,促进分散治理的工具是时间的需要。

- 36 次浏览

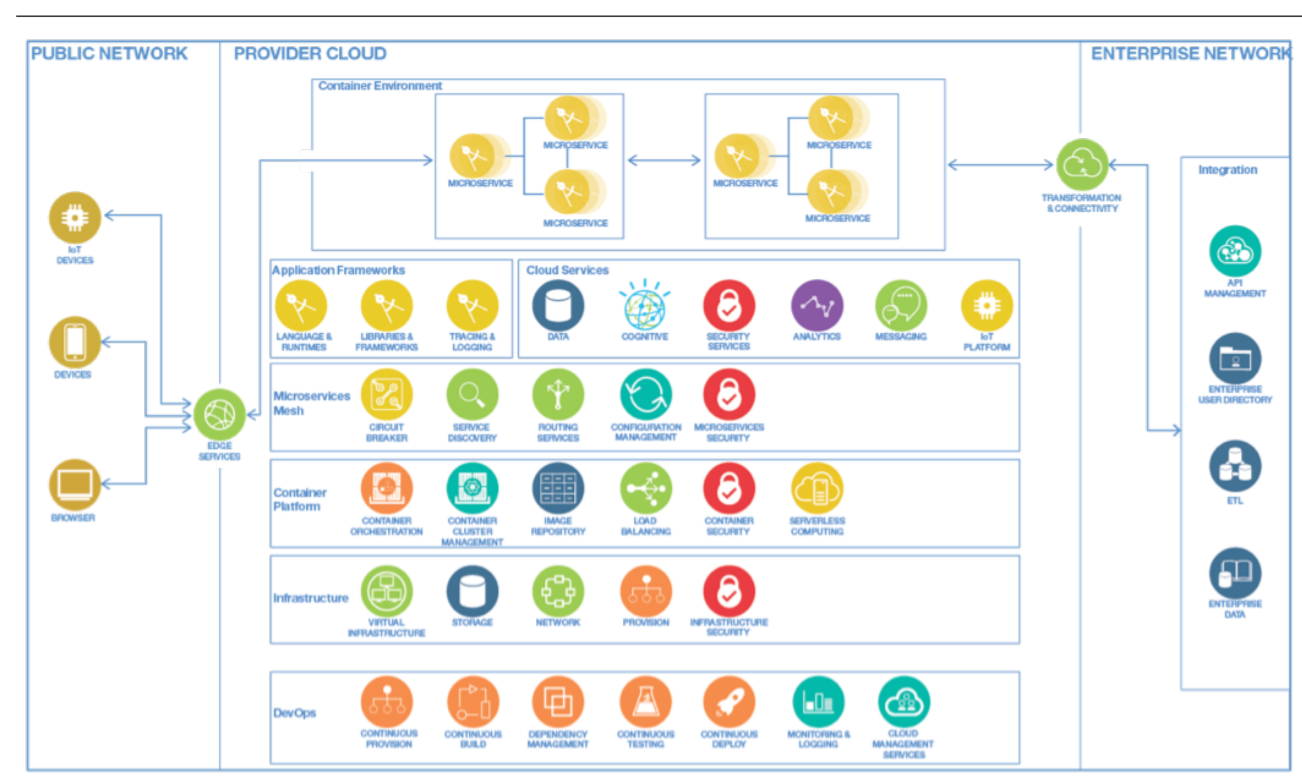

「微服务架构」企业微服务架构

首先,来自Darren的消息是,微服务架构并不是构建大规模企业应用程序的新方式。 Netflix和亚马逊等公司已经实施了微服务架构,在过去几年中提供了成功的产品。

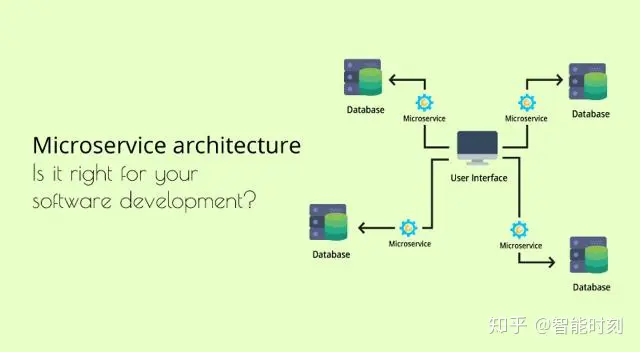

但是微服务架构适合您的组织吗?答案不是简单的是或否,但我会尝试用Darren的讲话作为指导来引导你找到答案。

微服务架构是一个将在多个方面影响您的组织的旅程 - 在文化,技术和运营方面。让我们考虑一个跨国企业的单体应用程序,该应用程序已经成熟多年并占据了市场主导地位。从软件工程师或架构师的角度来看,简化代码库的复杂区域以使其更易于维护是一种很好的做法。

那么当你遇到一个疯狂的大型Java类时,你会怎么做,这些Java类包含许多代码行和一个不幸的方法,占40%的类?一个自然(和明智)的事情是与团队进行某种形式的讨论,并提出一种策略,将类分解为多个较小的类和/或方法。现在问问自己为什么清理整体Java类很重要?

如果您的答案是更简单的单元测试,更容易进行代码审查,更改影响,那么我建议您将相同的思维过程应用于构成产品的整体服务和模块。

将monolith应用程序拆分为更小,可管理的服务有几个原因。如果您是组织中的业务负责人,以下可能是您的一些担忧:

- 进入新市场

- 支持创新

- 在业务功能和系统之间创建更好的一致性

- 改变治理结构以更好地支持快速决策

- 快速响应新的市场条件

- 抵御市场颠覆者

作为首席技术官或首席架构师,您有责任评估最能解决上述问题的不同解决方案,并设计符合组织愿景的系统。以下是在考虑微服务架构时需要关注的一些关键领域:

- 多种服务之间的依赖关系管理

- 端到端功能测试的大小

- 快速检测故障,正常故障并快速恢复

- 容器作为构建工件

- 跨组织边界重用组件/模块

- 公共使用服务的API合同

- 监控部署生命周期的各个阶段

- 集中式架构团队与分散式架构团队

- 基建自动化

架构师的角色随着微服务的采用而发展,并委托他或她承担挑战性的责任,从而形成架构治理。架构治理是组织尝试开始微服务之旅的关键因素之一,因为如果没有正确的顺序,该过程将很快导致微管理而不是微服务。

将monolith分成多个可管理服务的最大优势之一是使一个小团队能够全面管理其服务的生命周期 - 开发,测试和推向生产。这意味着企业架构师不再需要承担单个服务的内部工作负担,而是高度关注整个系统中服务之间的交互。此外,架构师应密切关注系统的整体运行状况,以确保每项服务以一致的方式生成与监控相关的指标。

为开发团队提供完全的权限,以便在构建服务时选择他们选择的技术堆栈并不意味着架构师不再对其实现有任何发言权。事实上,架构师受到高度鼓励,可以教育和影响开发团队。例如,考虑到服务必须处理的数据的高度非结构化特性,架构师可以建议使用NoSQL数据库而不是关系数据库。例如,Netflix将JVM的使用标准化为一个平台,以便他们可以跨服务使用标准库。

虽然架构师之一忙于与开发团队合作,但另一个人正在与“业务”团队合作,以使技术愿景与业务愿景保持一致。这对于建筑师来说是一个重要特征,因为系统需要能够适应产品愿景或用户反馈的变化。因此,架构师需要始终掌握行业中的最新趋势,工具和框架,并准备好为给定的工作应用正确的工具。

Darren谈到了“部署耦合”的概念,强调了许多单片系统和传统企业架构需要在单个版本中将所有系统的更改同步到生产中这一事实。这反过来导致长时间运行的测试周期从未捕获任何东西,并且感觉没有人可以失败,因为一个系统未达到其截止日期意味着其他所有人都被推出。

通过使用远程调用作为集成服务的机制,可以避免部署耦合。微服务社区建议使用REST over HTTP而不是其他远程通信协议(如RPC或SOAP),因为基于非HTTP的协议往往会将您绑定到特定平台或对互操作性施加限制。通过基于用户级合同使用HTTP集成服务,开发团队可以避免永无止境的端到端测试阶段的陷阱并保持合适的速度。

然而,管理数百个服务会使组织的操作复杂化。作为一个组织,您必须确保拥有可靠的DevOps基础架构,以便处理应用程序监视和警报。正如我上面提到的,架构师必须至少标准化服务发出日志的方式,以便运营团队可以监控整体系统运行状况,并且如果需要进一步调查,则能够深入到服务级别监控。

最后,每个组织都必须努力招募,培训和留住高素质的技术人员,因为“微观团队”之间的沟通和协作需要有效,技术上的刺激以及最重要的乐趣是至关重要的!

我希望这可以解决你对大型企业中微服务架构的一些担忧。我鼓励你观看这个非常有见地的视频录制,其中Darren更详细地讨论了这些非常关注的问题。如果您正在寻找有关微服务架构的其他材料,请查看Martin Fowler的文章或ThoughtWorks网站上的其他微服务洞察博客。

- 56 次浏览

「微服务架构」分散您的微服务组织

适应性 - 快速,轻松地进行变革的能力 - 已成为现代企业的首要目标,并迫使技术团队构建更容易,成本更低的平台。在这样的环境中工作,这些团队越来越多地被软件架构的微服务风格所吸引。吸引他们的是承诺加快软件更改的方法,而不会给业务带来不必要的危险。

微服务的工作方式在很大程度上可以通过支持软件组件和数据的分散来实现 - 更具体地说,通过将“单体”元素分解为更小,更容易更改的部分,并在网络上部署这些部分。要使这种架构运行良好,需要改变工作方式以及如何管理工作。采用微服务的组织是“脱离开发人员的方式”,并提供自由和自主来实现魔术。

在组织设计中,他们的目标是分散决策权。而不是让少数人为组织中的每个人做出架构和软件决策,分散化将使他们能够在执行工作的人员之间分配决策权。

直接向工人推行决策权使他们能够以更大的自由和自主权生产。在适当的情况下,这将导致更好,更快的变化。但是,如果您的组织弄错了,一系列错误的决策可能会降低变更速度 - 或者更糟糕的是,最终会损害您的业务。

诀窍是只分散那些可以帮助你加速的事情,而不会牺牲系统的安全性。

找到正确的权力下放战略是一个进化过程,需要您进行调整,分析和调整。为了帮助您开始正确的方向,以下是您应该考虑的三个最重要的问题:

我们应该针对哪些决策?

我们所有这一切的目标是增强您平台的可变性。因此,您应首先找到阻止变更发生的瓶颈。仔细研究功能和变化如何从概念转变为实施,并找到需要工作的人不能做的过程部分,因为他们正在等待其他人做出决定。

权力下放不是解除瓶颈的灵丹妙药。然而,在一个倾向于集中决策的组织中,权力下放可能会有所帮助。另一方面,如果您找不到因集中决策流程而导致员工陷入困境的许多情况,那么分散化不应成为您最关心的问题。

使微服务系统工作不仅仅需要改变有关组件大小的想法。组织中涉及创建和更改服务的所有区域都可以发挥作用。以下是可能成为微服务领域分散化候选人的决策类型的非详尽列表:

- 服务生命周期 - 服务何时创建或退役?他们叫什么?我们什么时候需要将它们分开?

- 服务实施 - 我们应该在每项服务中使用哪些工具,语言和架构?

- 系统架构 - 服务如何与其他人交谈?开发人员如何了解它们?

- 数据架构 - 如何在服务之间共享数据?

- 变更流程 - 何时可以更改服务?部署和QA有哪些工具和流程?

- 团队管理 - 谁在哪个团队服务?每个团队负责什么?团队成员做什么?

- 人员管理 - 人们如何被雇佣和解雇?员工如何激励和奖励?什么是休假政策?

- 安全管理 - 我们如何降低安全事件的风险?需要做些什么才能提高整个系统的安全性?

- 采购 - 可以购买哪些软件?使用开源软件需要哪些保护措施?

分析这些空间中的决策是如何制定的,这是值得的。它们如何影响系统的更改方式?哪些决策过程阻碍了你?哪些阻止人们进行创新?最后,在哪些情况下,更多的自由和自治会有益吗?

Netflix是一家能够以创新方式下放权力的公司的典范。其政策赋予员工权力,以决定他们需要多少时间来分散传统上受到严密控制的决策。

赋予员工指定自己的假期分配的权限可能听起来很奇怪。但是,如果您希望将组织的可变性提升到更高的档位,那么您应采取的确切方法是消除冗余和不必要的协调工作,同时避免引入新风险。追求构建软件的微服务风格的团队应该考虑在整个组织中进行这些优化。

这并不意味着分发假日决策的政策应该是微服务架构的原则。 Netflix可以做到这一点,因为它的文化和劳动力使这样的政策更容易实施。它的员工可以做出最适合整个系统的决策,而且公司因其对员工的选择而闻名。

并非每个组织都看起来像Netflix,很少有人在Netflix的在线视频内容传输领域运营。每家公司都有自己独特的约束和目标。您需要为自己发现自己的目标和约束。分析,洞察力和实验将帮助您确定权力下放工作的优先顺序,并引导您的系统实现适应性目标。

参与的人是谁?

人们做出的一些决定对他们公司的影响非常大。改变银行账户交易方式的决定对传统银行来说是有风险的。对于具有熟悉旧接口的大型用户群的软件公司而言,更改应用程序的用户体验的决定将是一种风险。

组织试图加强对这些类型决策的控制,以便最大限度地降低风险,从而实现决策权的集中化。例如,在过去的几年中,Apple以拥有一个高度集中的设计小组而闻名,该小组由相对较少的人组成,他们做出了大部分关于其产品设计的决策。

集中化是因为合适的人需要做出最重要的决策。通常,“合适的人”是那些拥有人才,专业知识和经验的人,这使我们能够充分信任他们以做出最佳决策。我们可以称这些人为我们的“明星”决策者。

如果一个组织只有星星,那么它的所有决定都可以分散。如果我们信任更多员工以做出最佳决策,我们会将更多决策分发给更多人。

在实践中,公司拥有数量有限的明星决策者。实际上,大多数团队都有一些明星与更多的决策者相结合,他们有能力但缺乏一些必要的经验或才能来做出完美的决策。

好消息是,你不需要一个全明星团队来采用分权策略。您只需要考虑如何将您的团队组织在一起以及您部署最佳决策者的位置。

微服务风格使这一切变得更加容易,因为决策的影响可以在实现个别变更的速度增加的同时受到限制。如果一个团队在处理微服务时做出了错误的决定,那么错误的爆炸半径应该很小并且包含在内。当系统变更便宜且容易时,团队可以快速改进以前的决策,使他们能够更快地做出最佳决策。

在这种环境中,你不受你的明星力量的限制 - 当目标是达到最佳决策时,你只需要提供一个系统,让有能力的工人获得自由和自主权。

谁拥有哪一部分?

没有立即做出决定。它基于选择,而选择又基于领域知识。决不应立即实施。有时它可能需要某人的祝福,而在其他时候,它可能需要高度专业化的技能或知识来实施。

管理专家Henry Mintzberg为我们提供了一个很好的模型,概述了决策过程的步骤:

- 研究和信息收集

- 产生选择

- 选择(做出选择)

- 授权选择

- 执行和实施

所有这一切的关键在于,在采用决策权力下放时,您不需要绝对。 Mintzberg的每个步骤都可以独立集中或分散,在平衡基于决策的系统变更的速度和安全性时,可以提供更大的灵活性。

考虑一家大公司典型招聘流程的情况:当找到新员工时,它是集中的人力资源部门,广播开放职位并邀请人们申请工作。同一个集中团队筛选候选人并生成该组中最佳的列表。然后将该清单移交给实际的招聘经理,该经理根据进一步的审查选择最佳候选人。从那里,招聘经理将球交还给人力资源中心团队,他们完成了文书工作并完成了整个过程。

这种集中式选择生成模式与分散式选择选择相结合是大公司中常见的选择。事实上,大多数采用微服务风格的组织都以某种形式使用它。

例如,集中式企业团队可以识别所有微服务团队应该使用的三种数据库。由各个团队决定选择,但他们可以从提供的菜单中进行选择。如果他们偏离批准的列表,他们将需要证明他们的决定,从而为集中团队提供反馈机制,他们可以重新评估菜单。

分散流程的选择,授权和执行部分可以使各个团队快速,大规模地进行迁移。集中研究和选择生成步骤,总体上损害了创新,但降低了决策的风险,从而对整个系统产生负面影响。这是一种流行的模式,因为它为大多数组织提供了正确的妥协方式。

当人们谈论微服务组织时,权力下放会出现很多,因为它是提高变革速度的有效方法。但不要忘记它只是等式的一部分。您的员工是谁,您的团队如何协调,以及他们所处理的所有系统,工具和环境同样重要。

您必须了解考虑如何制定决策 - 更重要的是,如何改进流程 - 是向变革友好型组织迈进的一种很好的方式。

- 23 次浏览

「微服务架构」微服务架构中的数据一致性

在微服务中,一个逻辑上原子操作可以经常跨越多个微服务。即使是单片系统也可能使用多个数据库或消息传递解决方案。使用多个独立的数据存储解决方案,如果其中一个分布式流程参与者出现故障,我们就会面临数据不一致的风险 - 例如在未下订单的情况下向客户收费或未通知客户订单成功。在本文中,我想分享一些我为使微服务之间的数据最终保持一致而学到的技术。

为什么实现这一目标如此具有挑战性?只要我们有多个存储数据的地方(不在单个数据库中),就不能自动解决一致性问题,工程师在设计系统时需要注意一致性。目前,在我看来,业界还没有一个广为人知的解决方案,可以在多个不同的数据源中自动更新数据 - 我们可能不应该等待很快就能获得一个。

以自动且无障碍的方式解决该问题的一种尝试是实现两阶段提交(2PC)模式的XA协议。但在现代高规模应用中(特别是在云环境中),2PC似乎表现不佳。为了消除2PC的缺点,我们必须交易ACID for BASE并根据要求以不同方式覆盖一致性问题。

Saga模式

在多个微服务中处理一致性问题的最着名的方法是Saga模式。 您可以将Sagas视为多个事务的应用程序级分布式协调。 根据用例和要求,您可以优化自己的Saga实施。 相反,XA协议试图涵盖所有场景。 Saga模式也不是新的。 它在过去已知并用于ESB和SOA体系结构中。 最后,它成功地转变为微服务世界。 跨越多个服务的每个原子业务操作可能包含技术级别的多个事务。 Saga Pattern的关键思想是能够回滚其中一个单独的交易。 众所周知,开箱即用的已经提交的单个事务无法进行回滚。 但这是通过引入补偿操作来实现的 - 通过引入“取消”操作。

除了取消之外,您还应该考虑使您的服务具有幂等性,以便在出现故障时重试或重新启动某些操作。 应监控故障,并应积极主动地应对故障。

对账

如果在进程的中间负责调用补偿操作的系统崩溃或重新启动,该怎么办? 在这种情况下,用户可能会收到错误消息,并且应该触发补偿逻辑,或者 - 当处理异步用户请求时,应该恢复执行逻辑。

要查找崩溃的事务并恢复操作或应用补偿,我们需要协调来自多个服务的数据。对账

是在金融领域工作的工程师所熟悉的技术。你有没有想过银行如何确保你的资金转移不会丢失,或者两个不同的银行之间如何汇款?快速回答是对账。

在会计中,对账是确保两组记录(通常是两个账户的余额)达成一致的过程。对帐用于确保离开帐户的资金与实际支出的资金相匹配。这是通过确保在特定会计期间结束时余额匹配来完成的。 - Jean Scheid,“了解资产负债表账户调节”,Bright Hub,2011年4月8日

回到微服务,使用相同的原则,我们可以在一些动作触发器上协调来自多个服务的数据。当检测到故障时,可以按计划或由监控系统触发操作。最简单的方法是运行逐记录比较。可以通过比较聚合值来优化该过程。在这种情况下,其中一个系统将成为每条记录的真实来源。

事件簿

想象一下多步骤交易。如何在对帐期间确定哪些事务可能已失败以及哪些步骤失败?一种解决方案是检查每个事务的状态。在某些情况下,此功能不可用(想象一下发送电子邮件或生成其他类型消息的无状态邮件服务)。在其他一些情况下,您可能希望立即了解事务状态,尤其是在具有许多步骤的复杂方案中。例如,预订航班,酒店和转机的多步订单。

复杂的分布式流程

在这些情况下,事件日志可以提供帮助。记录是一种简单但功能强大的技术。许多分布式系统依赖于日志。 “预写日志记录”是数据库在内部实现事务行为或维护副本之间一致性的方式。相同的技术可以应用于微服务设计。在进行实际数据更改之前,服务会写入有关其进行更改的意图的日志条目。实际上,事件日志可以是协调服务所拥有的数据库中的表或集合。

事件日志不仅可用于恢复事务处理,还可用于为系统用户,客户或支持团队提供可见性。但是,在简单方案中,服务日志可能是冗余的,状态端点或状态字段就足够了。

编配(Orchestration)与编排(choreography)

到目前为止,您可能认为sagas只是编配(orchestration )方案的一部分。但是sagas也可以用于编排(choreography ),每个微服务只知道过程的一部分。 Sagas包括处理分布式事务的正流和负流的知识。在编排(choreography )中,每个分布式事务参与者都具有这种知识。

单次写入事件

到目前为止描述的一致性解决方案并不容易。他们确实很复杂。但有一种更简单的方法:一次修改一个数据源。我们可以将这两个步骤分开,而不是改变服务的状态并在一个过程中发出事件。

更改为先

在主要业务操作中,我们修改自己的服务状态,而单独的进程可靠地捕获更改并生成事件。这种技术称为变更数据捕获(CDC)。实现此方法的一些技术是Kafka Connect或Debezium。

使用Debezium和Kafka Connect更改数据捕获

但是,有时候不需要特定的框架。一些数据库提供了一种友好的方式来拖尾其操作日志,例如MongoDB Oplog。如果数据库中没有此类功能,则可以通过时间戳轮询更改,或使用上次处理的不可变记录ID查询更改。避免不一致的关键是使数据更改通知成为一个单独的过程。在这种情况下,数据库记录是单一的事实来源。只有在首先发生变化时才会捕获更改。

无需特定工具即可更改数据捕获

更改数据捕获的最大缺点是业务逻辑的分离。更改捕获过程很可能与更改逻辑本身分开存在于您的代码库中 - 这很不方便。最知名的变更数据捕获应用程序是与域无关的变更复制,例如与数据仓库共享数据。对于域事件,最好采用不同的机制,例如明确发送事件。

事件第一

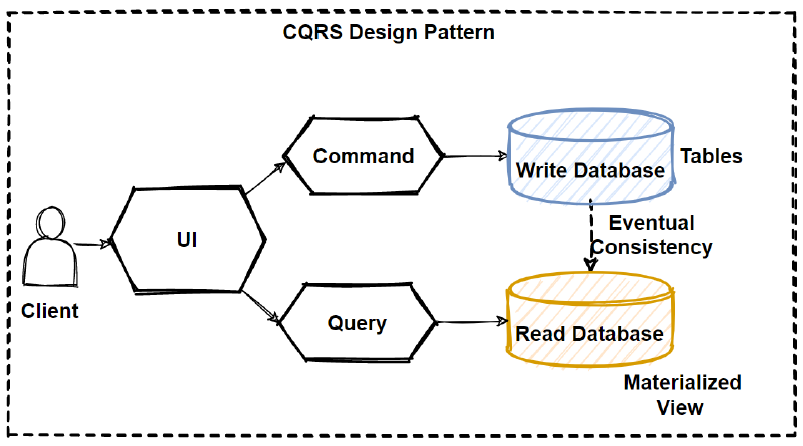

让我们来看看颠倒的单一事实来源。如果不是先写入数据库,而是先触发一个事件,然后与自己和其他服务共享。在这种情况下,事件成为事实的唯一来源。这将是一种事件源的形式,其中我们自己的服务状态有效地成为读取模型,并且每个事件都是写入模型。

事件优先方法

一方面,它是一个命令查询责任隔离(CQRS)模式,我们将读取和写入模型分开,但CQRS本身并不关注解决方案中最重要的部分 - 使用多个服务来消耗事件。

相比之下,事件驱动的体系结构关注于多个系统所消耗的事件,但并未强调事件是数据更新的唯一原子部分。所以我想引入“事件优先”作为这种方法的名称:通过发出单个事件来更新微服务的内部状态 - 包括我们自己的服务和任何其他感兴趣的微服务。

“事件优先”方法面临的挑战也是CQRS本身的挑战。想象一下,在下订单之前,我们想要检查商品的可用性。如果两个实例同时收到同一项目的订单怎么办?两者都将同时检查读取模型中的库存并发出订单事件。如果没有某种覆盖方案,我们可能会遇到麻烦。

处理这些情况的常用方法是乐观并发:将读取模型版本放入事件中,如果读取模型已在消费者端更新,则在消费者端忽略它。另一种解决方案是使用悲观并发控制,例如在检查项目可用性时为项目创建锁定。

“事件优先”方法的另一个挑战是任何事件驱动架构的挑战 - 事件的顺序。多个并发消费者以错误的顺序处理事件可能会给我们带来另一种一致性问题,例如处理尚未创建的客户的订单。

诸如Kafka或AWS Kinesis之类的数据流解决方案可以保证将按顺序处理与单个实体相关的事件(例如,仅在创建用户之后为客户创建订单)。例如,在Kafka中,您可以按用户ID对主题进行分区,以便与单个用户相关的所有事件将由分配给该分区的单个使用者处理,从而允许按顺序处理它们。相反,在Message Brokers中,消息队列具有一个订单,但是多个并发消费者在给定顺序中进行消息处理(如果不是不可能的话)。在这种情况下,您可能会遇到并发问题。

实际上,在需要线性化的情况下或在具有许多数据约束的情况(例如唯一性检查)中,难以实现“事件优先”方法。但它在其他情况下确实很有用。但是,由于其异步性质,仍然需要解决并发和竞争条件的挑战。

设计一致性

有许多方法可以将系统拆分为多个服务。我们努力将单独的微服务与单独的域匹配。但域名有多细化?有时很难将域与子域或聚合根区分开来。没有简单的规则来定义您的微服务拆分。

我建议务实并考虑设计方案的所有含义,而不是只关注领域驱动的设计。其中一个影响是微服务隔离与事务边界的对齐情况。事务仅驻留在微服务中的系统不需要上述任何解决方案。在设计系统时我们一定要考虑事务边界。在实践中,可能很难以这种方式设计整个系统,但我认为我们应该致力于最大限度地减少数据一致性挑战。

接受不一致

虽然匹配帐户余额至关重要,但有许多用例,其中一致性不那么重要。想象一下,为分析或统计目的收集数据。即使我们从系统中随机丢失了10%的数据,也很可能不会影响分析的业务价值。

与事件共享数据

选择哪种解决方案

数据的原子更新需要两个不同系统之间达成共识,如果单个值为0或1则达成协议。当涉及到微服务时,它归结为两个参与者之间的一致性问题,并且所有实际解决方案都遵循一条经验法则:

在给定时刻,对于每个数据记录,您需要找到系统信任的数据源

事实的来源可能是事件,数据库或其中一项服务。实现微服务系统的一致性是开发人员的责任。我的方法如下:

- 尝试设计一个不需要分布式一致性的系统。不幸的是,对于复杂的系统来说,这几乎是不可能的。

- 尝试通过一次修改一个数据源来减少不一致的数量。

- 考虑事件驱动的架构。除了松散耦合之外,事件驱动架构的强大优势是通过将事件作为单一事实来源或由于更改数据捕获而产生事件来实现数据一致性的自然方式。

- 更复杂的场景可能仍然需要服务,故障处理和补偿之间的同步调用。知道有时候你可能需要在之后进行调和。

- 设计您的服务功能是可逆的,决定如何处理故障情况并在设计阶段早期实现一致性。

- 35 次浏览

「微服务架构」微服务集成中的3个常见缺陷-以及如何避免它们

微服务风靡一时。 他们有一个有趣的价值主张,即在与多个软件开发团队共同开发的同时,将软件快速推向市场。 因此,微服务是在扩展您的开发力量的同时保持高敏捷性和快速的开发速度。

简而言之,您将系统分解为微服务。 分解并不是什么新鲜事,但是通过微服务,您可以为团队提供尽可能多的自主权。

例如,专用团队完全拥有该服务,可以随时部署或重新部署。 他们通常也会使用devops来控制整个服务。 他们可以做出相当自主的技术决策并运行他们自己的基础设施数据库。 被迫操作软件通常会限制有线技术选择的数量,因为当人们知道他们将来必须操作它时,往往会更频繁地选择无聊技术。

Microservices are about decomposition, but giving each component a high degree of autonomy and isolation (微服务是关于分解,但为每个组件提供高度自治和隔离)

微服务架构的一个基本结果是每个微服务都是与其他微服务远程通信的独立应用程序。 这使得微服务环境成为高度分散的系统。 分布式系统有其自身的挑战。 在本文中,我将向您介绍我在最近的项目中看到的三个最常见的陷阱。

1.沟通很复杂

远程通信不可避免地要尊重分布式编程的8个谬误。 隐藏复杂性是不可能的,并且许多努力(例如Corba或RMI)已经失败了。 一个重要原因是您必须在服务中设计失败,以便在失败是新常态的环境中取得成功。 但是有一些共同的模式和框架可以帮助你。 让我们从一个例子开始 - 我经常遇到的真实情况。

我想飞往伦敦。 当我收到办理登机手续的邀请时,我去了航空公司的网站,选择了我的座位,然后按下按钮取回我的登机牌。 它给了我以下回应:

让我们假设航空公司使用微服务(可能不是这种情况,但我知道有其他航空公司这样做)。

我注意到的第一件事:错误返回得相当快,网站的其他部分表现正常。所以他们使用了重要的失败快速模式。条形码生成中的错误不会影响整个网站。我可以做其他一切;我无法获得登机牌。快速失败非常重要,因为它可以防止本地错误导致整个系统崩溃。该领域众所周知的模式是断路器,隔板和维修网。这些模式对分布式系统的生存至关重要。

快速失败是不够的

但快速失败是不够的。它将故障处理卸载到客户端。在这种情况下,我个人不得不重试。在上述情况下,我甚至要等到第二天,直到问题得到解决,我才能拿到登机牌!对我而言,这意味着我必须使用自己的工具来坚持重试(我的日历),以确保我没有忘记。

为什么航空公司不自行重试?他们知道我的联系数据,并且可以在准备好时异步发送登机牌。更好的反应是:

这不仅会更方便,而且还会降低总体复杂性,因为需要查看故障的组件数量会减少:

您可以将相同的原则转移到服务到服务通信。每当服务本身可以解决故障时,它就会封装重要的行为。这使得所有客户的生活更加轻松,API更加清洁。解决故障可能是有状态的(有些人称之为长时间运行)。我认为状态处理是微服务中故障处理的关键问题。

当然,上面描述的行为并不总是你想要的,将故障移交给客户端就可以了。但这应该是根据业务需求做出的有意识的决定。

我观察到大多数情况下,另一个原因导致人们避免有状态重试:它伴随着状态处理的复杂性。该服务必须重试几分钟,几小时或几天。它必须可靠地执行此操作(请记住:即使系统重新启动,我也希望登机牌),这涉及处理持久状态。

如何管理持久状态?

我看到两种处理持久状态的典型方法:

存储在数据库中的实体等持久性事物。

虽然这开始非常简单,但通常会导致很多意外的复杂性。您不仅需要数据库表,还需要一些调度程序组件来进行重试。您可能需要一些监视组件来查看或编辑等待作业。如果整体业务逻辑发生变化,您仍需要进行版本控制,而您仍想进行重试。等等等等。

这种思路导致许多开发人员如上所述跳过正确的故障处理,导致整个架构的复杂性增加 - 以及糟糕的客户体验。

相反,我建议利用轻量级工作流引擎或状态机。

构建这些引擎是为了保持持久状态并处理围绕流语言,监视和操作的后续要求,扩展以处理高容量等等。

市场上有几个轻量级工作流引擎。他们中的许多人使用ISO标准BPMN来定义流,其中许多是开源的。在这里,我将使用Camunda的开源工作流引擎来说明基本原则(快速免责声明:作为该项目背后的公司的共同创始人,我明显偏向于我的工具选择,但这是我最熟悉的工作流引擎)。对于前面描述的简单用例,可以使用Java DSL轻松创建工作流:

另一种选择是在BPMN中以图形方式建模工作流程:

这些工作流引擎在架构方面非常灵活。许多开发人员认为工作流引擎是一个集中组件,但事实并非如此。没有必要引入集中组件!如果不同的服务需要工作流引擎,则每个服务都可以运行自己的引擎来维护服务的自治和隔离。本博文中有关架构选项的更多细节将对此进行详细讨论。

另一个误解是工作流迫使开发人员切换到异步处理。这也不是真的。在上面的示例中,当一切顺利运行时,登记组件可以同步返回登机牌。只有在出现错误时才会回退到异步处理。这可以很容易地反映为HTTP返回码,200表示“一切正常,这是你的结果”,202表示“得到它,我会给你回电话。”有一些具体的示例代码来处理这个,它利用了一个简单的信号。

我将工作流引擎视为工具箱的重要组成部分,用于正确的故障处理,这通常涉及长期运行的行为,如状态重试。

2.异步性需要注意

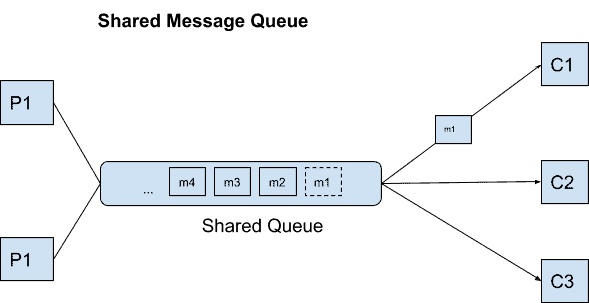

这导致我们进行异步通信,这通常意味着消息传递。异步性通常被认为是分布式系统中的最佳默认值,因为它提供了解耦,尤其是时间解耦,因为任何消息都可以独立于接收器的可用性发送。一旦服务提供商可用,该消息将立即发送,而无需额外的魔力。

因此,重试的问题已经过时,但会出现类似的问题:您必须担心超时问题。假设航空公司在登记方案中使用异步通信。登记组件向条形码生成服务发送消息,然后等待响应。您无需关心条形码生成器的可用性,因为消息总线将在适当的时候传递消息。

但是,如果请求或响应因任何原因而丢失怎么办?您是否会在办理登机手续时遇到困难,未能在没有注意到的情况下将登机牌发送给客户?我打赌很多公司这样做,这再次导致我,客户监控响应并采取行动,如果没有登机牌在超时内到达。同样,我必须利用我的个人调度基础设施(日历)。

更好的方法是让服务监控超时本身,并在条形码未能及时到达时执行回退。可能的后备是重新发送消息,这实质上是重试。

您也可以利用工作流自动化技术来处理此用例。 BPMN中的工作流可能如下所示:

作为奖励,您可以免费报告重试次数,典型响应时间以及无法及时处理的工作流程数量。操作员可以通过提供大量上下文来轻松检查和修复失败的工作流实例,例如消息中包含的数据以及消息发送的时间。纯粹的基于消息的解决方案通常会忽略这种级别的可见性和操作控制。

我甚至看到公司更进一步,使用工作流引擎而不是消息传递中间件来在微服务之间分配工作。如果工作流引擎不主动调用服务或发送消息(称为推送原则)但依赖于工作者要求工作(称为拉取原则),则这是可能的。现在,工作流引擎中的工作队列就像一个消息队列。当我问他们为什么喜欢工作流引擎时,他们说消息传递解决方案缺乏相同的可见性和工具质量,他们希望避免构建自己的操作工具。

3.分布式交易很难

事务是以全有或全无的方式执行的一系列操作。我们都从数据库中知道这一点。您开始一个事务,做一些事情,然后提交或回滚事务。这些事务称为ACID:原子,一致,隔离和持久。

在分布式系统中,您不能指望ACID事务。是的,有像XA这样的协议实现了所谓的两阶段提交。或WS-AtomicTransaction。或像Google Spanner这样复杂的实施。但目前的共识是,这些协议太昂贵,太复杂,或者根本无法扩展。 Pat Helland的“超越分布式交易的生活:Apostate的意见”是一个很好的背景阅读。

但当然,商业交易的要求并没有消失。在没有ACID的情况下解决业务交易的常见技巧是使用补偿。这意味着您可以对过去不正确执行的所有活动执行撤消活动。 BPMN具有此内置功能,因此您可以定义这些撤消活动,并且工作流引擎负责以正确的顺序可靠地执行它们。这次我将使用预订机票的例子:

这通常也被称为Saga模式,最近变得非常流行。我在“Saga:如何在没有两阶段提交的情况下实现复杂的业务交易”中写到了这一点,其中我还链接了其他来源和一些代码。

请注意,此方法与ACID事务不同,因为您可以具有不一致的中间状态。所以,我可以保留一个座位,但尚未预订有效的机票。或者我可以在没有付款的情况下买票。实际情况是,只要确保最终清理它们并使系统恢复到一致状态,通常可以忍受这些暂时的不一致。这称为最终一致性,这是分布式系统中的一个重要概念。 “在SoA网络中拥抱最终的一致性”指出它非常好:

最终的一致性通常会产生更好的性能,更简单的操作和更好的可伸缩性,同时要求程序员理解更复杂的数据模型。

好消息是工作流程自动化简化了补偿的处理。这是因为工作流引擎可以可靠地调用所有必要的补偿活动。

服务提供商 - 做好功课!

到目前为止,我已经提出了三种简单的补救措施来应对分布式系

- 重试

- 超时

- 赔偿金

所有这些都可以使用轻量级工作流自动化技术实现。但是为了利用这些配方,每个服务提供商都必须做好功课。这意味着

- 提供补偿活动和

- 实现幂等性。

虽然第一个要求应该是显而易见的(如果有取消票证的服务,我只能取消票证),第二个 - 幂等性 - 需要更多解释。

幂等

我谈了很多关于重试的事情。一个常见的问题是,如果我通过重试两次调用服务怎么办?这个问题问得好!

首先要确保您了解每种形式的远程通信都会遇到此问题!无论何时通过网络进行通信,都无法区分三种故障情形:

- 该请求尚未到达提供商

- 请求已到达提供商,但在处理期间它已爆炸

- 提供程序处理了请求,但响应丢失了

一种可能性是询问服务提供商是否已经看到此请求。但更常见的方法是使用重试并以允许重复调用的方式实现服务提供程序。这更容易设置。

我看到两种简单的方法来掌握幂等性:

- 自然的幂等性。有些方法可以随意执行,因为它们只是翻转一些状态。示例:confirmCustomer()

- 商业幂等。有时,您拥有允许您检测重复呼叫的业务标识符。示例:createCustomer(email)

如果这些方法不起作用,您需要添加自己的幂等性处理:

- 唯一身份。您可以生成唯一标识符并将其添加到呼叫中。这样,如果您在服务提供商端存储该ID,则可以轻松发现重复呼叫。如果您利用工作流引擎,您可能会让它完成繁重的工作(例如,当Camunda允许在启动期间对密钥进行重复检查时)。示例:charge(transactionId,amount)

- 请求哈希。如果您使用消息传递,则可以通过存储消息的哈希值来执行相同的操作。您可以再次利用工作流引擎,或者您可以使用具有内置租赁功能的数据库(如Redis)。

长话短说:在您的服务中注意幂等性。这将带来巨大的回报。

给我看一下代码

您可以使用BPMN和开源Camunda引擎找到实现我在此描述的模式的源代码

Java或C#。(需要的后台发消息)

摘要

在本文中,我介绍了三个常见的陷阱,我看到客户在整合微服务时踩到了:低估了远程通信的复杂性,忽略了异步性的挑战,忘记了商业交易。

通过重试,超时和补偿活动的状态模式引入处理这些情况的功能可以降低微服务基础架构的整体复杂性并增强其弹性。它还有助于:

- 将重要的故障处理和事务行为封装在它所属的位置:在服务本身的上下文中。

- 将故障或超时处理的工作量减少到更小的范围,从而降低整体复杂性。

- 简化服务API,只发布对客户真正重要的故障。

- 改善客户体验,客户可能是其他服务,内部员工,甚至是客户。

使用轻量级工作流引擎,您可以通过应用自行开发的解决方案来处理有状态模式,而无需投入大量精力或冒着意外复杂性的风险。随附的源代码提供了具体示例。

- 23 次浏览

「微服务架构」更多关于微服务-边界,治理,重用和复杂性

我最喜欢博客(而且从来没有得到足够的)的一件事就是反馈。我之前发表的文章“雕刻它 - 微服务,巨石和康威定律”,产生了一些评论/讨论,这些评论/讨论合在一起,保证了一个后续帖子。

其中一个讨论是与Ruth Malan和Jeff Sussna就治理进行的Twitter交流。杰夫认为分权治理的概念是“有争议的”,尽管他认为集权治理是“有问题的”和“僵化”。露丝观察到“或者至少是一个权衡轴和(组织)设计......? (甚至“联邦”也有广泛的解释)“。我为一些集中治理的需要辩护,但是克制,注意“管理比必要更深的会导致问题,例如:问题是BDUF(IMO)是B,而不是UF“。

当应用程序跨越多个团队,所有团队都独立部署时,将需要一些集中式治理。关键是制定道路规则,允许团队独立工作而不会相互干扰,不会尝试微观管理。这种编排需求不仅仅局限于技术方面。正如Tom Cagley在我上一篇文章中的评论所指出的那样“在考虑跨团队和组织边界的流程改进时,也可以利用你的论点”。团队之间冲突的流程模型很容易使分布式解决方案复杂化。

另一篇关于“雕刻它 - 微服务,巨石和康威定律”的评论,这一次来自Robert Tanenbaum,讨论了重用,并质疑图书馆在某些情况下是否是更好的选择。 Robert还观察到“敏捷原则告诉我们实现满足需求的最小体系结构,只有在需求超出最小实现时才能使用更复杂的体系结构”。我认为微服务和SOA架构更像是一种分区机制而不是重用工具。因为重复使用会带来更多的成本和负担,而不是大多数人认为,我倾向于不那么热衷于这方面。但是,我绝对同意,分布式架构可能更适合于演进过程的后续步骤,而不是起点。来自Chris Richardson的“微服务:分解应用程序的可部署性和可伸缩性”的引用很好地说明了(重点是我的):

使用微服务架构的另一个挑战是决定在应用程序生命周期的哪个阶段应该使用这种架构。 在开发应用程序的第一个版本时,您通常不会遇到此体系结构解决的问题。 此外,使用精心设计的分布式架构将减缓开发速度。

Michael Brunton-Spall的“什么是微服务及其重要性”为这种架构风格所涉及的权衡性质提供了更多背景:

微服务交易复杂的单块,用于简单服务的复杂交互系统。

一个巨大的整体可能是如此复杂,以至于很难对某些行为进行推理,但在技术上可以推理它。相互交互的简单服务将表现出紧急行为,而这些行为是不可能完全推理的。

对于复杂系统而言,级联故障更是一个问题,一个简单系统中的故障会导致其他系统出现故障。幸运的是,有一些模式,例如背压,死人的开关等等,可以帮助你减轻这种情况,但你需要考虑这一点。

最后,即使问题发生变化,微服务也可以成为解决问题的解决方案。因此,一旦构建,如果您的需求发生变化以使您的有界上下文调整,正确的解决方案可能是抛出两个当前服务并创建三个来替换它们,但通常更容易简单地尝试修改其中一个或两个。这意味着微服务可以很容易地在较小的情况下进行更改,但需要更多的监督才能在大的情况下进行更改。

引号中“复杂(complicated)”和“复杂(complex)”之间的区别尤为重要。所提到的紧急行为意味着复杂系统的行为只能在回顾中完全解释。这意味着分布式应用程序不能被视为具有部件之间空间的整体件,但必须根据其性质进行设计。这是Jeppe Cramon的一个主要主题,他在TigerTeam网站上围绕微服务的持续工作非常值得一读。

Jeppe在我的帖子的LinkedIn讨论中发表了一对评论。在那次讨论中,Jeppe指出,专注于业务能力的小型服务比整体服务更可取,但这与将几个巨型网络与Web服务连接起来并不相同。然而,主要关注的是服务“拥有”的数据的性质。我在上一篇文章中非常简短地提到了这一点,并提到需要权威性的一些概念(中央治理)。 Jeppe表示赞同,并指出整体结构导致多主数据架构,其中多个系统在同一实体上包含冗余的,可能相互冲突的数据。

底线?在我看来,这种架构风格具有增强企业运营的巨大潜力,前提是它没有过度营销(“SOA治愈秃头,肠易激综合症,促进世界和平......免费!!!”)。服务并不是将遗留系统毫不费力地转变为二十二世纪技术的秘诀。有一些警告,权衡和成本。一种务实的方法,考虑到这些以及潜在的好处,应该比昨天的“如果建立它和他就会来”的哲学更有可能取得成功。

- 37 次浏览

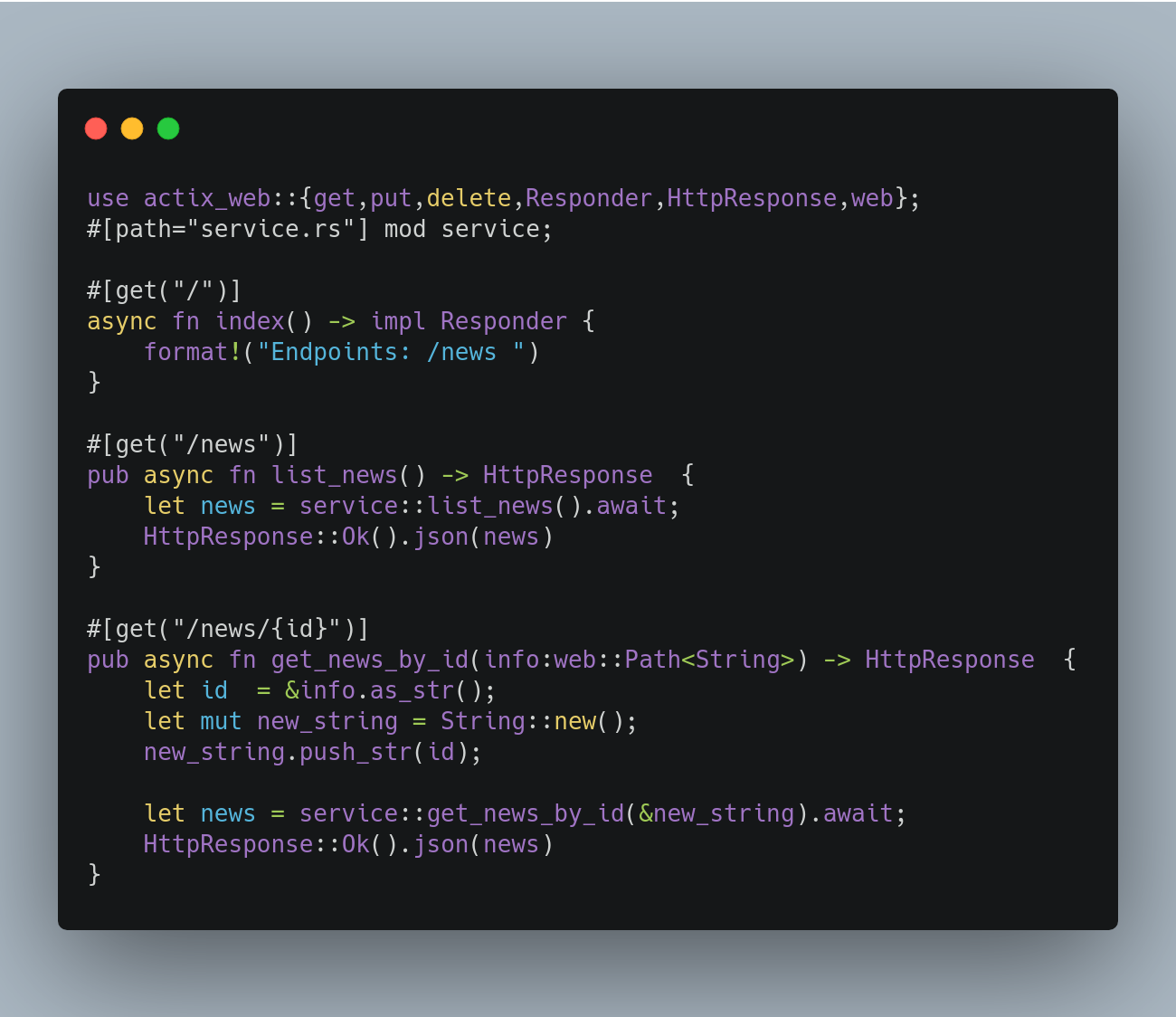

【Rust】用Rust构建微服务

Rust是一门很棒的语言,目前是我2019年和2020年(到目前为止)学习最多的语言。Rust几乎可以与任何语言进行互操作。Rust对容器和K8s也很好。今天我要展示如何构建一个简单的微服务。我们将使用Actix、Tokio Postgress和其他库。我们将使用postgres作为事实的来源,并在docker中运行它(为了开发)。我们还将使用Barrel +一些我创建的自定义移植结构。代码将全部是异步和非阻塞IO。希望你玩得开心,我们开始吧。

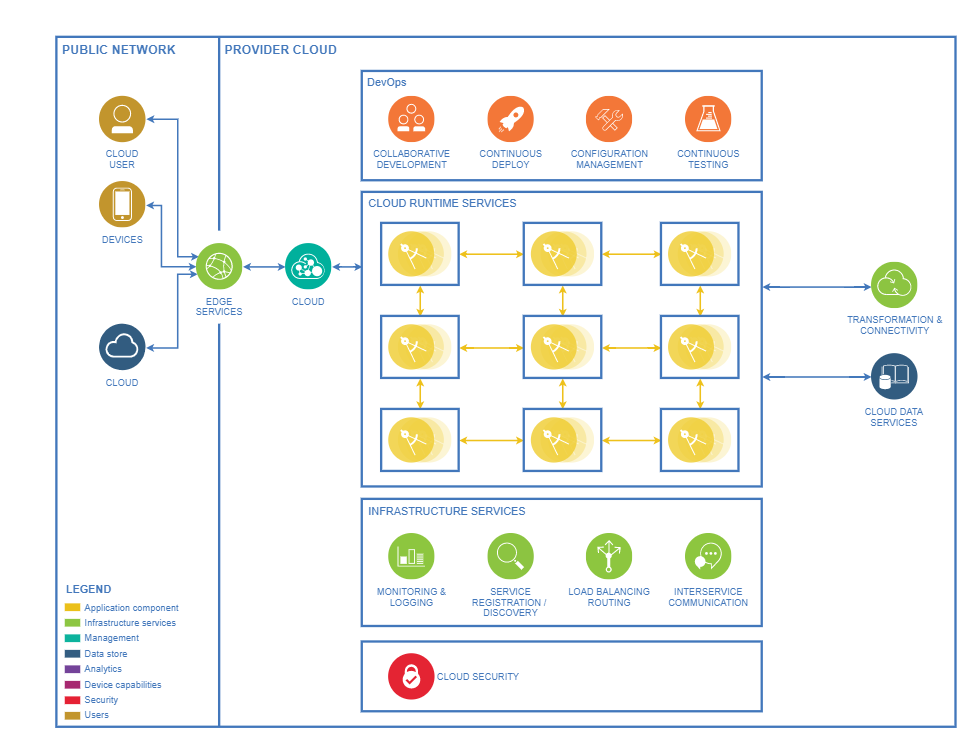

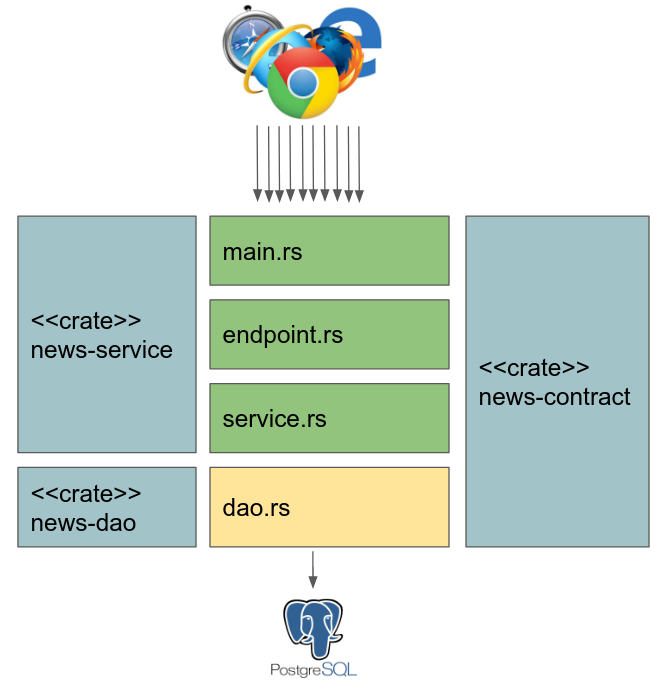

架构

这里我们有一个多层架构,其中业务规则和rest定义在news-contract中定义。SOA契约在news-contract + news-service中定义,结构(news)在news-contract中定义。rest endpoint definitions+服务是在news-service上定义的。postgress持久性在news dao中定义。

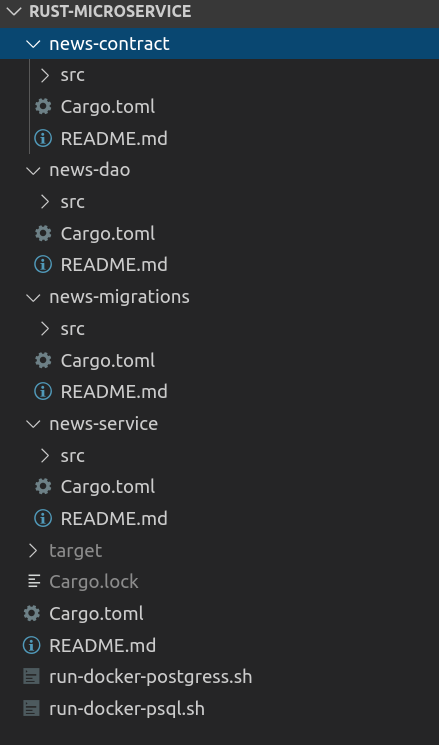

代码结构

我们有5个项目,有一个全局工作区,这是一个项目,顶层的。我们有news-contract:这是SOA契约的一部分,我们在代码中使用了新闻结构。

news-dao:我们有使用tokio postgres的反应式持久性代码和新闻资源的所有CRUD操作。

News-migrations:为了测试,我们使用barrel+自定义逻辑来创建表和添加数据。

News-service:这里有端点、服务实现和配置了actixweb框架的主类。

每个项目都有自己的依赖项,由Cargo.toml文件。

我们还有两个脚本处理Docker容器。一个运行Postgres,另一个运行psql。

迁移

现在让我们看看如何进行迁移(创建表并将记录添加到Postgres SQL中)。

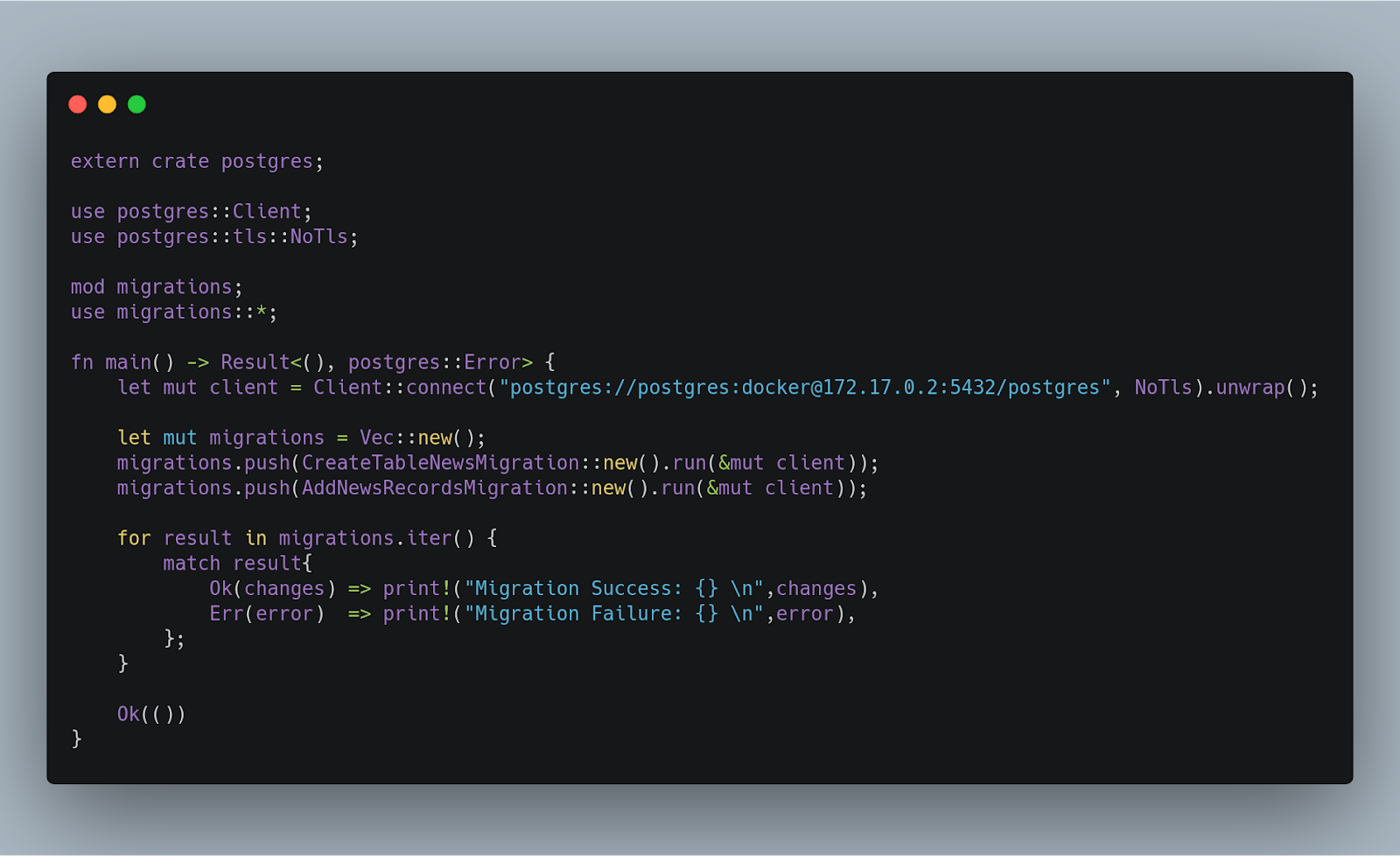

我们连接在docker上运行的Postgres数据库,创建一个包含所有迁移的向量,我们正在运行这个迁移。然后我们将进行一个for all迁移,逐个检查它们是否运行良好。

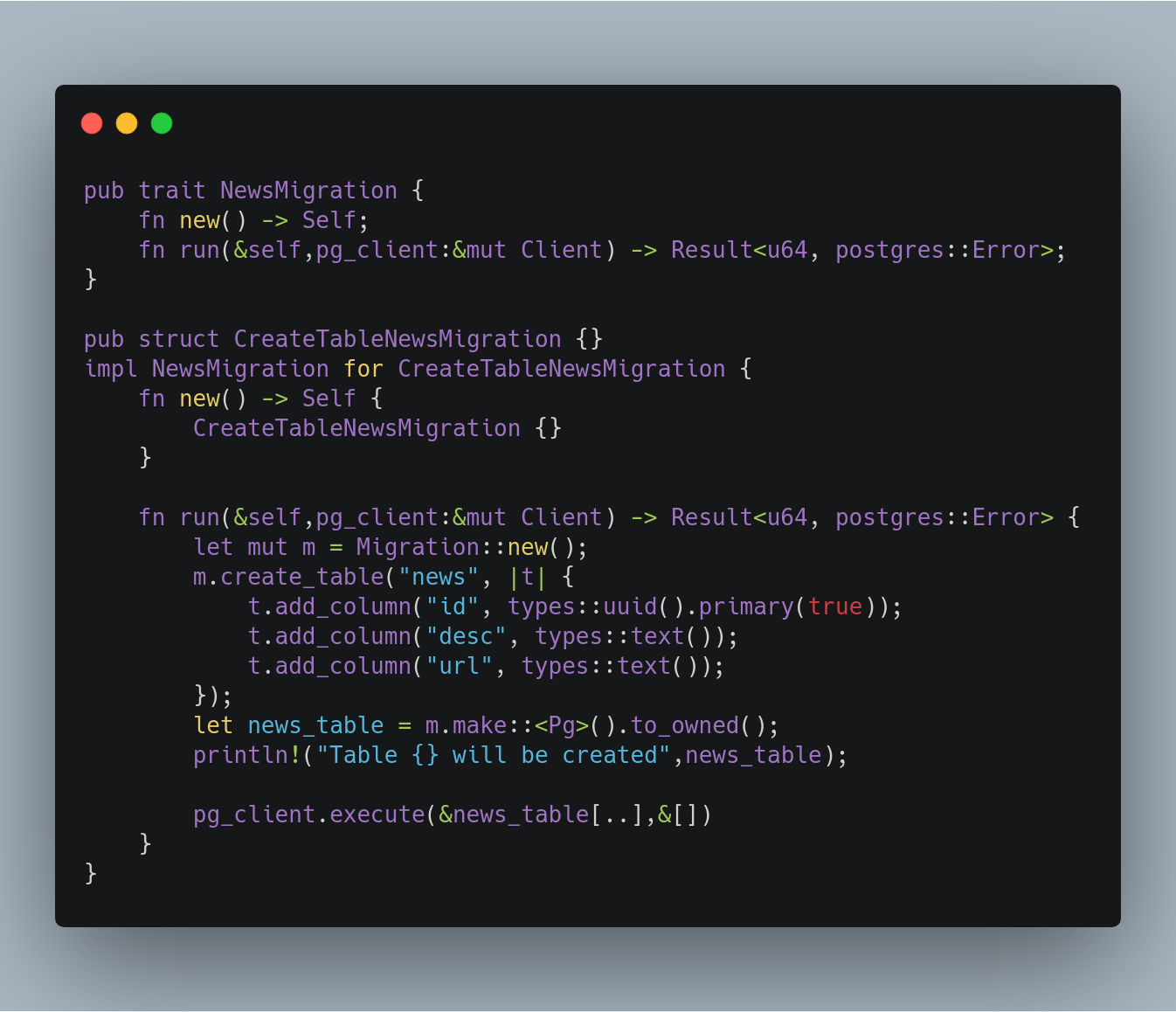

现在让我们看看下一个rust代码,什么是迁移。

我创建了一个名为NewsMigration的结构,其中有一个新的(用于创建结构的函数)和运行迁移的方法(run)。如您所见,我创建了第二个名为CreateTableNewsMigration的结构,以及一个使用(impl)的trait实现,在我使用的barrel代码中创建了一个表结构,barrel将生成Postgres SQL INSERT语法。最后,我们在Postress中使用pg\u客户机运行生成的脚本。在这里您可能会看到有点奇怪的代码:&news_table[..],在这里我们传递String news_表的引用,并传递一个片段([..]),复制字符串并传递方法。

SOA契约

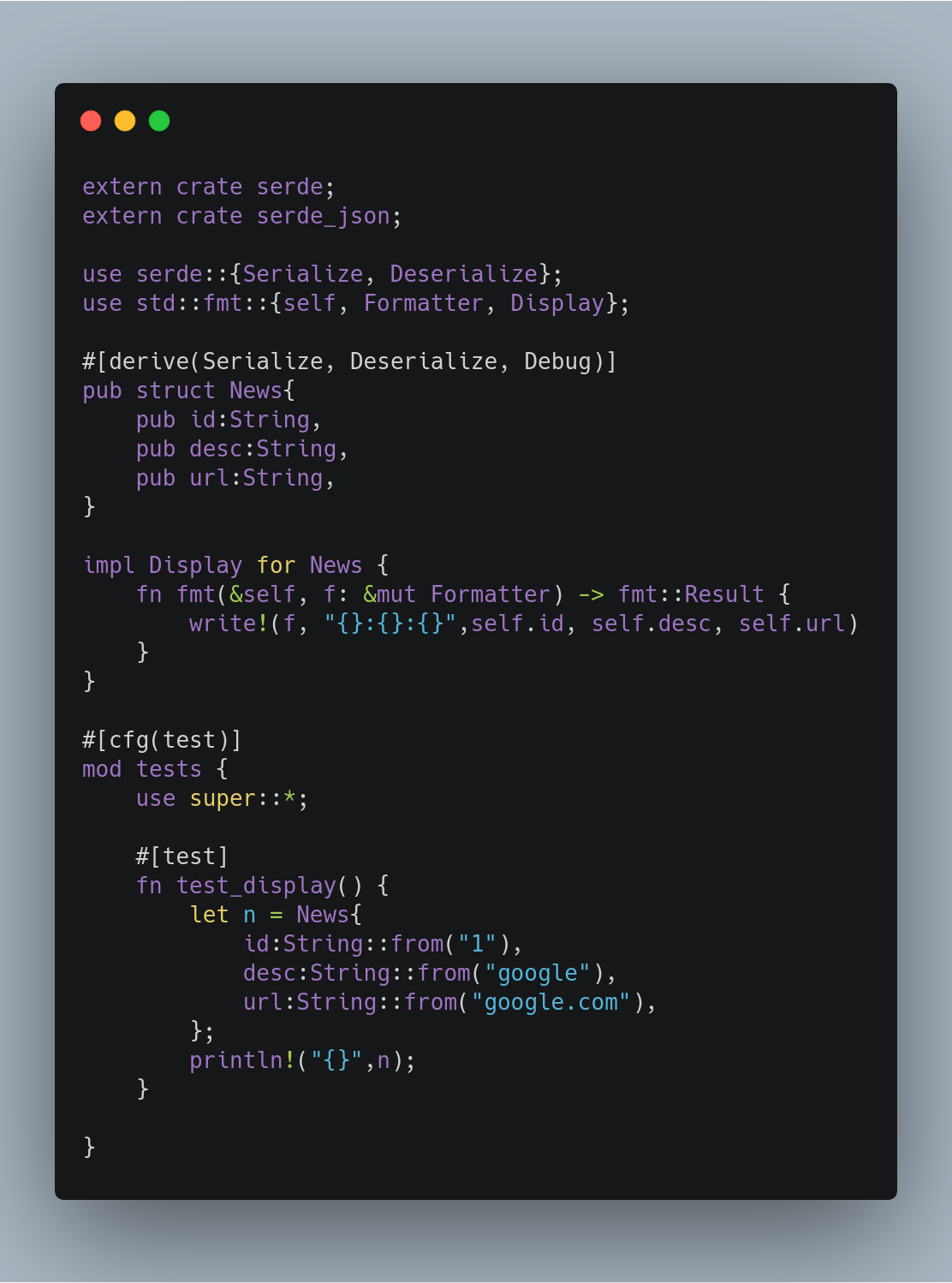

让我们来看看Soa合同的一部分,Struct新闻。

我们正在定义一个名为News的结构,我使用serde和serde_json来序列化和反序列化这个结构。我还实现了一个称为Display的特性,以便能够打印结构。最后,在文件的末尾有一个单元测试,我正在测试是否可以打印这个结构。

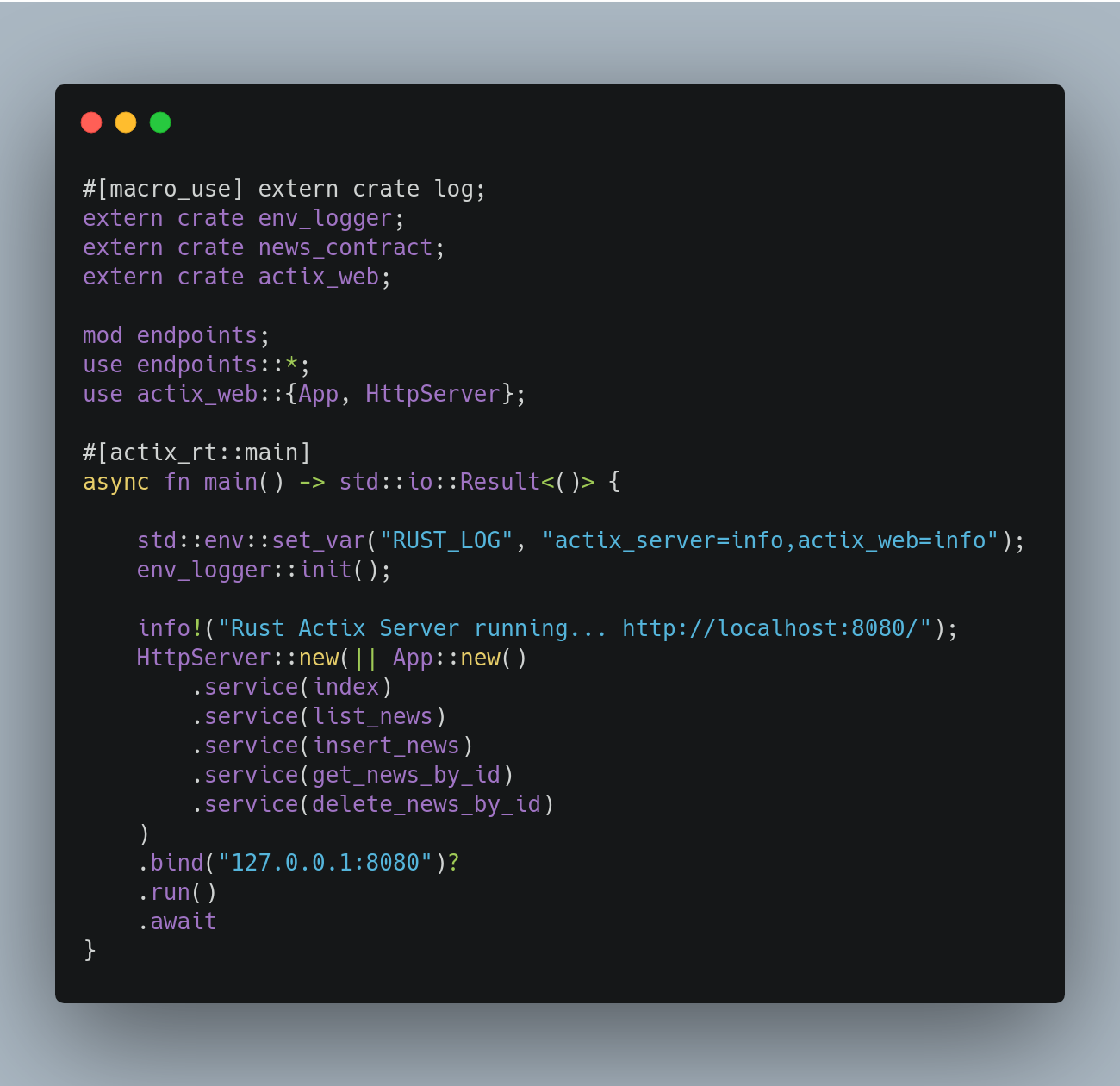

端点/服务

这里我定义了HttpServer actix,并定义了几个处理程序,比如:index、list、insert、get、delete等。所有信息都使用日志和env_logger创建来记录。

现在让我们看看端点.rs把剩下的定义归档。

这里有一些宏使用REST操作,比如PUT、DELETE和GET。每个函数处理程序都是公共的,基本上,这里我调用服务并从服务中获取结果并序列化为json结果。

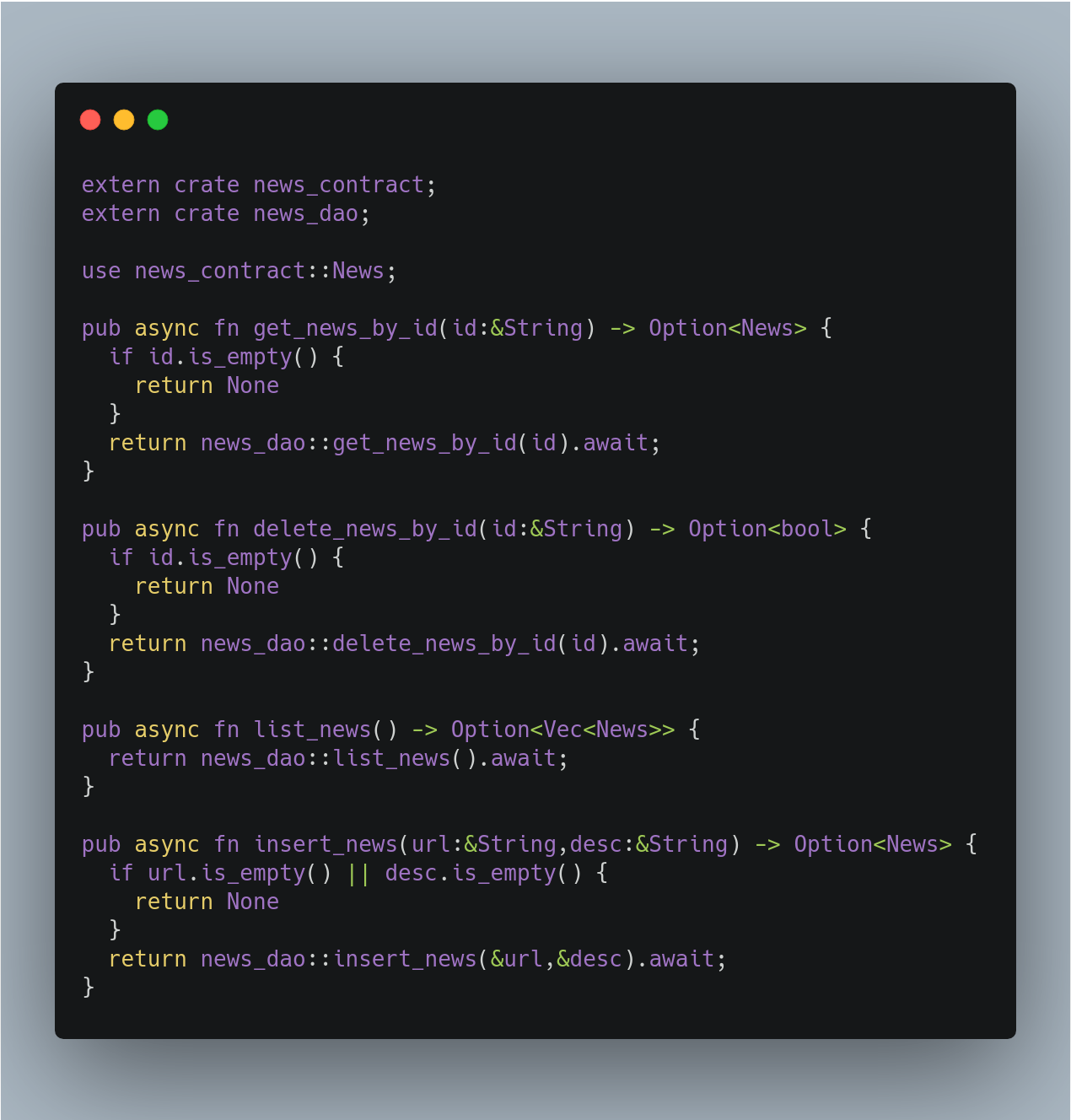

这是服务实现,我们这里没有任何REST或actix依赖关系。这里是实现验证、业务逻辑和委托给dao机箱的正确位置。CRUD上的所有函数都是异步的。

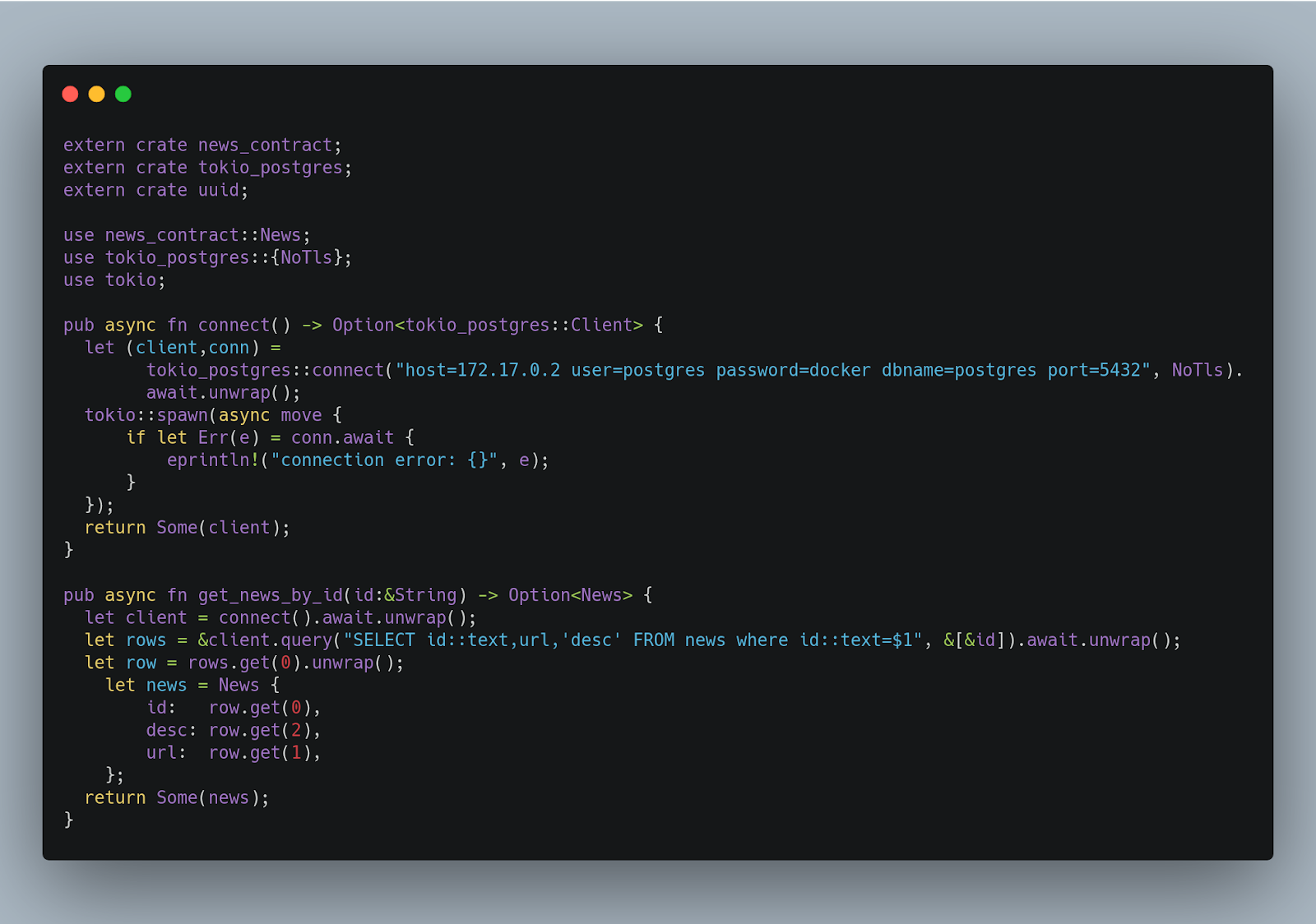

DAO

这是魔术发生的地方,我们有tokio-postgress编码。我们来看看。

这是DAO实现。有一种方法可以在名为connect()的postgres数据库上进行连接,该方法以异步和非阻塞的方式进行。在这里,我演示了如何通过id进行查找。使用tokio postgress客户端,我执行一个查询,通过SELECT查询执行WHERE by id。在postgress id中,handle作为一个UUDI,所以我需要转换为string,这就是为什么您看到id::text=$1,在同一行中,我用&[&id]传递从参数获得的id。DAO有更多的函数,您可以在mine GitHub中查看完整的代码。

视频:代码演练+死亡演示

让我们看看我用代码演练和死亡演示制作的视频。

原文:https://medium.com/@ilegra/building-a-microservice-with-rust-ef9641cf2331

本文:http://jiagoushi.pro/node/1412

讨论:请加入知识星球【全栈和低代码开发】或者小号【it_training】或者QQ群【11107767】

- 520 次浏览

【微服务】专家组:在过去十年的微服务中,我们学到了什么?

瓦特(Watt):这是微服务专家组。Chris早些时候谈到了最小化微服务中的设计时耦合。他是microservices.io的创建者,《微服务模式》一书的作者。他也是Java冠军,在微服务领域非常有经验。我期待着与你们一起深入研究其中的一些领域。当然,我们有詹姆斯·刘易斯,他是最早创造和定义术语或架构风格的人之一,我们今天称之为微服务。James是ThoughtWorks的软件架构师和主管。ThoughtWorks技术咨询委员会成员,以及创建技术雷达的小组成员,致力于推动业界采用开源和其他工具和技术。还有凯蒂·加曼吉。凯蒂是CNCF的生态系统技术倡导者。她的重点是更广泛的生态系统和能够帮助微服务生存和繁荣的工具。她帮助发展和领导最终用户社区,同时缩小与其他一些生态系统领域和单位的差距。她过去的角色包括云平台工程师,她构建了很多平台,这些平台都被云本地技术所吸引,其中包括Kubernetes。

微服务还和十年前一样吗?

我想也许我们可以从一个问题开始,实际上,微服务作为一个定义。它真的还意味着我们今天认为它意味着什么吗?James,你不久前创造了这个术语,如果我们考虑敏捷,敏捷在今天的含义可能并不完全相同,因为它今天的含义是一样的。微服务还和十年前一样吗?

理查森(Richardson):那是什么,詹姆斯?

刘易斯(Lewis):我不知道。我应该指出,出于完全开放的考虑,不仅是我,还有弗雷德·乔治。Adrian Cockcroft同时谈到了细粒度SOA和微服务。我认为这只是一种趋同进化,不管它叫什么。时机已经成熟的想法。当时,这在很大程度上是对以技术为中心的大规模软件开发方法的反应。我们专注于技术层和所有的工具和技术,我认为我们真的希望将其从技术层带到更多的业务中,更多地关注业务,发挥更多的DDD,发挥更多的业务能力理念。本质上,我认为它有点像极限编程。有人引用Kent Beck的话说,“它只是一次做了所有的好事,结果变成了11个。”我认为这才是微服务架构真正的意义所在。它将当时存在的许多想法汇集在一起。如果你想想当时的游击队面向服务的架构。吉姆·韦伯是这个想法的始作俑者。显然,领域驱动的设计,着眼于RESTful集成,这是其中的一个重要部分,并通过超媒体实现解耦。

现在它的意思是一样的吗?不,当然不是。十年后。正如你所说,Nikki,语义扩散是一件事。词语改变了它们的意思。事实上,回想起来,我想马丁和我都会同意,我们把名字搞错了。这是零碎的。它卡住了。真的,这和尺寸无关。然后,当马丁给某物命名时,它往往保持命名状态。

理查森(Richardson):你应该使用面向服务的架构,它会消除一些反模式。

Lewis:当然,Dan North更喜欢可替换组件架构,这可能是对其真正意义的更恰当描述。这是关于可替换性而不是可维护性的设计。这是最原始的东西。

微服务中的常见反模式

瓦特:我们尝试微服务已经有相当一段时间了。我认为我们做的很多事情可能都是对的,但我想说的是,有很多是反模式。你的同事们对你一次又一次看到的最流行或最常见的反模式有什么看法,对人们如何实现和使用微服务有什么看法?

理查森:我想说一个明显的原因是人们相信这就像一个神奇的精灵尘埃。我们的工程组织交付软件的速度很慢,我们只做微服务,一切都会很好。然而,在现实中,如果您的软件交付速度慢是因为您的流程,因为缺乏自动化测试,并且您编写的代码无法维护,那么在混合中添加微服务很可能会使事情变得更糟。我觉得在采用微服务之前,或者在采用微服务的同时,您实际上必须清理您的行为并提高组织的成熟度。假设微服务实际上是解决方案的一部分,因为不知何故,你只是改进了所有其他东西。那就足够了。

伽曼吉:我可以附和。我认为这是我所看到的一种模式,当容器的采用得到更多的动力时。这不是关于容器,也不是关于技术,而是关于理解你的问题是什么,并真正触及问题的核心。大多数时候,这也伴随着文化的转变或发展。这不仅仅是关于采用微服务,而是关于你真正理解你试图解决的问题,并尝试应用一些最佳实践。谈到反模式,已经有很多使用微服务的用例,但是仍然有一些代码没有得到很好的维护。部署起来仍然很困难。自动化不是它的一部分。Chris也提到了很多功能。成功的衡量标准也不一定是真正明确定义的。其他一些组织通过他们拥有的微服务数量来衡量他们的成功,这实际上不是你应该追求的目标,不是吗?这不仅仅是关于技术,而是关于文化的转变,真正理解你试图解决的问题的根源。

理查森:我曾经和一个组织合作过。首席信息官读了我写的一本电子书,然后对微服务充满了热情,自上而下,8000人的组织,他刚刚宣布做微服务。这被转化为KPI,进而转化为奖金和其他东西,基本上就像许多微服务决定了你的奖金一样。

分布式事务

刘易斯:我们根本不是这个意思。这是我以前的客户,很有趣。这是关于分布式事务的。当您最终拥有大量服务,并且不得不协调事务并在这些微服务之间进行编排时,这可能是一场噩梦。Sam Newman和我在我们的培训课程中经常说,如果您认为您可能需要分布式事务,最好将这些事务放在一起,因为它们可能需要在同一个位置。我记得在一个组织中,他们有实体服务,然后是业务编排服务,该服务将协调这些事件和服务之间的事务。他们将其实现为ThreadLocal,因此每个调用都将存储在堆栈中的ThreadLocal中。如果他们需要解除分布式事务,他们会解除堆栈并对每个服务发出回滚。我们认为,这是一个很好的开始,因为这是一个很难解决的问题。那么,如果你需要两个呢?如果您需要其中两个,以防需要扩展,会发生什么?他们说,我们有一个计划。我们要把动ZooKeeper 带进来。现在他们遇到了所有的问题,因为现在他们也遇到了ZooKeeper 的问题。我们都知道这可能有点诡计,因为每次他们对其中一个微服务发出请求时,他们也必须与ZooKeeper 交谈。这很有趣。如果您正在构建微服务架构,我也觉得分布式事务是值得注意的。

理查森:我以前讲过,不管怎样,暗物质,暗能量,都是关于希望你分解的相互冲突的力量。那么,在服务和交易之间产生吸引力的力量就是抵制竞争的一个关键吸引力。

瓦特:我认为,在我们工作的一些客户中,我也看到了分布式的整体,在那里有很多服务,比如实体服务反模式,我认为当你从整体分解到微服务时,只是有一些非常传统的概念。然后,您必须将所有内容与事务以及跨越多个调用的所有这些内容放在一起。

Kubernetes如何影响和塑造微服务

就微服务而言,你现在无法摆脱的一件事是Kubernetes似乎与微服务齐头并进,有时甚至在这些句子中互换使用。在我们前进的过程中,库伯内特斯是如何影响和塑造微服务的?

Gamanji:Kubernetes的引入几乎就是容器的采用。对于Kubernetes,我们有一个容器编排器来帮助我们部署这些容器。这不仅仅是关于部署应用程序,而是关于Kubernetes带来的一些额外功能。例如,我们讨论的是可伸缩性。我们有一个水平吊舱自动缩放器,它可以自动识别何时需要缩放应用程序。它具有就绪性和活动性探测,这将确保应用程序重新启动,或者容器重新启动,以确保服务启动并运行。我们还有很多其他功能,如声明性配置,我们与物理基础架构层分离,因为我们需要考虑的是如何在Kubernetes世界中使用资源(如部署、副本集、服务等)定义应用程序。

然而,对于Kubernetes,它还是一种承载应用程序的机制。这并不一定意味着您可以在开发应用程序的阶段应用一些最佳实践。在很多情况下,整个单体都被部署到Kubernetes平台上。它要跑了。这将消耗大量资源。这将不是运行应用程序的最有效方式。它实际上也能让你做到这一点。有了Kubernetes,我认为它能让我们更快地,比如让我们把人们放在一个好的、积极的角度。它使应用程序能够更快地部署,但同时,它具有我刚才提到的一些功能:可达性、自动化、可伸缩性、就绪性探测、活动性探测等等。所有这一切实际上是真正的转变,从如何部署应用程序转变为只部署应用程序,将其容器化。实际上,只需使用Docker或BuildPack之类的工具对其进行打包,无论内部选择什么工具,这就足以让它真正准备好部署到集群中。

刘易斯:我刚才在看ThoughtWorks技术雷达和Kubernetes第一次出现在2015年的《评估》中,当时我认为谷歌只是开源的。微服务最早出现在这之前,Docker也出现在这之前。我认为我们所说的库伯内特斯所支持的模式,它们是更古老的模式。我不知道是否有人记得Dropwizard,它是一种有点时尚的格式。在Dropwizard之前,有一个Java库,来自同一个人Coda Hale,名为Metrics。这是一个典型的示例,放入一个简单的库,然后点击一个端点,每个应用程序都会有这个库。每个应用程序都有一个端点,它将为您提供服务正常运行时间、请求-响应延迟等等。现在,它已经从应用程序发展到基础架构。我认为这真的很吸引人,就像本质复杂性的演变一样,它仍然存在于业务代码中。然后是偶然复杂性,这是Martin Fowler的出发点,偶然复杂性正在迁移到您的网络、服务网格、侧车、容器运行时和编排工具中。我认为这是我们正在进行的一个有趣的轨迹。也许我们最终只需要一个业务分析师就可以将东西拖放到一起,然后部署到Kubernetes中。

Kubernetes是正确的抽象级别吗

瓦特:你认为Kubernetes是正确的抽象级别吗,或者你认为我们仍然需要在其上构建更多的生态系统,以使人们更容易构建微服务,因为有些东西的级别相当低?

理查森:我有几个不同的观点。我认为最重要的是,微服务架构的本质并不是真正的技术或基础设施相关。这一切都是关于正确识别服务边界、服务责任、它们的API和协作。这就是微服务架构的本质。就开发系统时必须做出的众多决策而言,这些是绝对关键的决策。我认为微服务采用的另一个反模式是,它正在反转它,然后思考,让我们找出我们的部署技术、工具和文字技术。这在很大程度上是一种反模式。这实际上都是关于服务定义的。

Kubernetes适合哪里?我将其视为许多可能的部署选项之一。一个明显的替代方案是无服务器,比如将东西打包成AWS Lambdas,然后在AWS或谷歌云功能上运行?如果这不适合,那么,可以考虑使用基于Docker的解决方案。ECS是一种更简单的选择,甚至是Kubernetes。那么Kubernetes实际上相当不错。到处都有。它从树莓皮到公共云,以及介于两者之间的一切。这很吸引人。我将其视为一种部署选项,而不是本质上与微服务定义相关的东西。

加曼吉:我可以在这里加一点,因为我认为,随着Kubernetes的流行,与此同时,我们有了另一种非常突出的文化模式。我在这里明确地定义了DevOps。同样,这不是一个部署过程。这是团队之间协作方法的文化转变。我认为这实际上非常重要,因为当我们讨论定义我们的服务可以做什么时,特别是在架构中,我们有无数的服务,并且有不同的团队控制它们。您如何确保您的API可用?您如何确保同步并了解如何使用API?如果您有一个功能需求,您如何联系该团队?我认为,DevOps文化更强调这一点,它引入了基础架构层,让平台团队与应用程序团队更紧密地协作,以确保服务或应用程序所需的所有需求也将由平台团队来满足。我认为这是关于定义应用程序的,但同时,下一个阶段是如何将其交付给消费者。有时需要更清楚地了解应用程序将部署在何处,以便充分利用现有的基础设施。这也伴随着团队之间的协作处理。

Lewis:这很有趣,不是吗,这个标准化的想法也很有趣,因为我们以前有一个叫做领域应用程序协议的东西,你可以考虑RESTful架构中的微格式。这是我真的看不到团队谈论这么多了。我想这又回到了你刚才说的,克里斯,重要的一点是这些东西是如何交流的?API是什么?我知道我可以通过什么协议和这边的另一个团队交谈?我使用的团队是服务边界的同义词。我认为这似乎正在消失。我不知道是否有其他人看到过。我们实际上要坐下来解决一个难题,即边界是什么?我们的服务之间的接口是什么?让我们商定一种相互交谈的通用方式?因为这本质上就是语义鸿沟。这就是语义问题,你不能通过技术来真正解决它,你只能通过人们相互交谈来解决它。

让人们与技术方面合作改变组织方面的挑战

瓦特:在之前的一些会谈中,围绕着如何解决其中一些挑战的实际工作所需的协作进行了大量讨论。康威定律也经常出现在围绕组织设计服务方面,反之亦然。我认为,我们经常会发现,使用微服务架构是为了帮助组织更快地发展,但这通常不会发生,因为组织实际上不会同时发生变化。我不知道你在这方面有什么经验。在让人们与技术方面合作改变组织方面,您在人力方面遇到了多少挑战?

理查森:人类,他们是麻烦。我使用成功三角的概念。这就像为了快速、频繁、可靠和可持续地交付软件,您需要三个方面的结合。从流程的角度来看,它是精益的,而且是DevOps。从组织的角度来看,这是一个松散耦合的产品团队网络。然后从架构的角度来看,它是一个松散耦合的模块化架构,有时是微服务,有时是一个整体。为了实现快速可靠的软件开发目标,您需要这三个方面。

刘易斯:这就像一句古老的格言,当持续交付是一种新事物,构建管道是一种新事物时,你会发现人们会花几个月的时间定义和构建完美的构建管道,让你的软件投入生产。我们可以按需将软件投入生产,速度非常快。太好了,什么软件?我们没有任何软件。这是一个经典[听不见00:22:47]。如果其他人看到了这一点,你肯定会想,你的构建管道有多好?因为如果你没有任何可用的软件来推动它,那就是解决真正的业务问题或产生真正的成果,那么你就不会交付任何东西。

Gamanji:从工程团队的角度来看,在内部做好战略提升工作是非常重要的。如果我们采用新的概念来部署应用程序或在内部创建应用程序,我认为创建员工可以遵守的内部标准非常重要。我认为这是非常重要的,清晰的沟通、透明和提高技能的机会。我认为人类的问题永远都会存在。但我们似乎有不同的方法来处理它。

刘易斯:组织会找到一切可能不改变的理由。Eli Goldratt几年前,我认为在《目标》(the Goal)的一篇[听不见的00:23:57]中,他谈到了范式转换,组织中的人们最难做的事情就是转换范式。有点像微服务风格的架构,采用云原生,这是一个巨大的转变。这是一个巨大的范式转变,因为它是关于人的。这是关于团队结构的。我想我们忘记了一些事情,比如,对于亚马逊,杰夫·贝佐斯(Jeff Bezos)没有说构建微服务。他说还有很多其他的东西,其他的约束,其他的强制功能,包括直接看到你的客户,建立产品团队,就像Chris说的,拥有小的授权团队,他们自己管理一切。都是这些东西。这就是一种范式转变。Eli Goldratt说,你需要三件事来改变一个范例。您需要做的第一件事是在现有的范例中尝试其他一切。你需要承受巨大的压力。你需要有人帮助你迈出第一步。当然,ThoughtWorks总是可以提供帮助的。

理查森:我也是。

瓦特:你也是,凯蒂?

伽曼吉:是的。我在这里。

如何影响管理层和领导层以适应变化

瓦特:我不知道你们中是否有人读过《团队拓扑》这本书,并且随着旅程的发展,不得不改变团队。有时您可能会有一个完整的产品团队启动,但您可能会有处于不同交互模式的平台团队。我认为这是一个可能在过程中丢失的东西,因为你发现公司倾向于建立,他们说,这是我们的结构,这是我们做事的方式。它不会随着组织和架构的实际变化而变化。对于如何真正影响管理层和领导层,使其能够认识到这一点并加以适应,您有什么建议或看到什么吗?

理查森:我认为最终,一家公司不盈利或盈利能力下降是大多数商人的最终动机。大多数组织往往不会有这样的直接危机,但如果他们有,那么这就是改变和变革的真正令人信服的原因之一。我曾经与一位客户合作过,他们是一家非常成功的公司,但他们有一块老化的单体,它是预先部署的。因为它太大太旧了,他们很难对它进行测试。它是有缺陷的,客户害怕升级,因为这意味着停机。这转化成了一个企业可以理解的问题,因为它涉及资金。然后,这实际上促使他们开始研究微服务架构,这样他们就可以切块,然后对它们进行彻底的测试。

Gamanji:我认为这是相同的问题空间,但它也可以应用于不同的领域。Chris一直在谈论采用或鼓励使用微服务。在采用Kubernetes作为平台时,我看到了一种非常类似的模式。同样,归结到相同的核心原则,每个企业都希望有一个与众不同的优势,这将使他们能够尽快向客户部署其功能。为此,有时候,当涉及到平台时,我们可以真正提供一个非常好的用例,这不仅可以降低维护基础架构的成本,而且可以使您的团队拥有更多的控制权,并且可能更容易地执行一些生命周期管理操作,例如升级和更新集群,确保有机会引入新技术,例如,服务网格。同样,拥有业务差异通常要归结于技术。在公司的不同阶段,可以采用微服务,也可以采用容器和Kubernetes,或者呼叫提供商等等。我认为这是一个正在经历的问题,即公司或组织如何盈利?

刘易斯:关于团队拓扑的话题,还有一本非常棒的书《动态重新团队》。海蒂写了这本精彩的书。这是关于实际改变团队结构的不同技术。不一定是团队拓扑,它是从平台团队到产品团队,再到它是什么。在人员轮换、保持人员新鲜、保持人员想法、保持人员参与方面。我所见过的公司中最好的例子就是制作数据库工具的Redgate,它做到了这一点,而且做得非常好。它们最初用于SQL Server,现在也可以使用其他数据库。他们做得非常成功。他们可以让员工在不同的产品之间来回走动。他们几乎有一个海报会议,每隔几个月,开发人员就会在合理的范围内选择要开发的产品。我认为这使Redgate能够做到这一点。我认为在许多组织中,尤其是大型组织中,你看不到的是,他们拥有真正的变革型领导。他们已经建立了一种学习文化,不仅仅是在他们的团队中围绕技术实践、模式和事物,而是围绕管理实践和变革型领导。我认为这是很多组织所缺少的一点,那就是我们不仅仅停留在自己的方式上。我们不会永远这样做。我们必须适应。我们必须学习。我们必须学习新技术、新风格、新的组织结构,并与管理者一样跟上该领域的最新发展,而不是坚持我们一直在做的事情。

瓦特:我认为,有时试图让这些倡议从基层开始,除非你得到管理层和领导层的认可,否则是行不通的,真的,因为你可以一直尝试,直到脸色发青,但如果高层不理解,这肯定是一个挑战。

微服务的下一次演变

关于微服务的未来,以及我们的发展方向,您是否了解CNCF或您的客户在微服务方面的最新趋势?下一个进化是什么,或者下一个我们应该关注的东西是什么?

Gamanji:我想在这里提到一些方法或工具,特别是在应用程序开发方面。当我们谈论Kubernetes和cloud native时,它围绕着集群,围绕着如何使用Kubernetes资源在配置中定义应用程序,等等。然而,现在有一个转变,重点完全放在应用程序开发人员身上。开放应用程序模型就是这样构建的,两年前在2019年被外包。这几乎允许将重点从基础架构层转移到应用程序层。最重要的是,您将能够在config中的代码中定义应用程序,并且能够跨云提供商部署它。这不仅仅是关于Kubernetes的,如果您想在数据中心或云提供商中部署它,您也可以使用这个特定的工具。

另一件我想从云原生空间提到的事情是Gitpod,它专注于应用程序开发阶段。Gitpod实际上是一个编纂本地开发环境的工具。这是一个巨大的使能器,特别是当有人在本地创建或开发应用程序时,如果遇到bug,他们将能够将其完全编码。它都基于Git存储库,您可以像一个文件一样挥舞,甚至可以像Git存储库一样挥舞,就像一切都在那里一样。其他人将能够完全重新创建它。这将是另一位工程师的镜像。这种可移植的开发环境,也一直是人们关注的焦点。

当然,就应用程序的实际部署而言,我们有不同的方法,同样可以使应用程序更快地推送到生产环境中。这就是GitOps非常突出的地方。这也是一种机制,您可以将应用程序的所需状态存储在Git存储库中。但是,它改变了开发人员将应用程序部署到集群的方式。对于所有这些工具和方法,我想说的是,Kubernetes将留下来。我们有许多调查证实了这一数据。我们有一个来自VMware的关于Kubernetes状态的最新调查,而且每年他们都看到生产中使用Kubernetes的数量在增加。现在不仅仅是基础设施,我们正在努力提高开发人员的体验。这就是我提到的所有这些工具和方法能够真正蓬勃发展的地方,它们最近实际上获得了很多动力。

瓦特:詹姆斯,你觉得怎么样?

刘易斯:对我来说,技术是一回事。这正在演变。发生了巨大的爆炸。我做了一次演讲,回顾了微服务最初出现的地方,以及它之前的内容和之后的内容。在监控、日志记录和容器编排方面,您会遇到这种巨大的爆炸。真是太棒了。我相信,这种情况会继续下去,因为这会让很多人赚很多钱。我认为我们还没有破解更多关于领域的东西,更多关于业务架构的东西。正如克里斯所说,边界是什么。在开始编写代码方面做得很出色,很多是模式,其他人也在做类似的工作。对我来说,这是一条至今仍未落地的信息。是关于生意的。这是关于团队结构的。它关注于如何解决业务问题。我认为可能仍然有太多的注意力集中在技术上。我认为我们仍然需要纠正这一点。没有多少人还在读埃里克·埃文斯的蓝皮书。虽然Data Mesh现在显然又重新流行起来,但它的受欢迎程度似乎在下降。我认为领域驱动的设计、业务能力等仍然是微服务领域的核心。

理查森:技术将继续发展。我觉得这不是微服务的核心。这是一个笑话,但也许XML将取代YAML卷土重来。我只是想说。

刘易斯:而不是在YAML或JSON中隧道XML。

Gamanji:我们将在这里用YAML替换所有东西。实际上有一个项目,它允许您使用Excel电子表格管理应用程序。如果需要,情况可能会变得更糟。

理查森:一切都是YAML。真有趣。实际上,我希望Lisp是一种配置语言,我觉得这是一种更好的方法。我觉得这个问题有两个层次。第一,我完全同意詹姆斯关于编纂设计最佳实践的观点。我认为领域驱动设计和Eric Evans的蓝皮书是关键,以及相关的东西。另一部分是关于整体与微服务的争论。首先,我们应该停止使用Twitter讨论架构。这是一个可怕的格式。所有这些辩论,如果你在推特上说,单体是好的。参与程度超出了预期。我希望我们都能就monolith架构适用于何处以及微服务架构适用于何处达成一致,因为很明显,它们都适用于何处,我们只需要确定何时适用。我希望这场辩论能得出一些结论。

刘易斯:对我来说,技术是一回事。这正在演变。发生了巨大的爆炸。我做了一次演讲,回顾了微服务最初出现的地方,以及它之前的内容和之后的内容。在监控、日志记录和容器编排方面,您会遇到这种巨大的爆炸。真是太棒了。我相信,这种情况会继续下去,因为这会让很多人赚很多钱。我认为我们还没有破解更多关于领域的东西,更多关于业务架构的东西。正如克里斯所说,边界是什么。在开始编写代码方面做得很出色,很多是模式,其他人也在做类似的工作。对我来说,这是一条至今仍未落地的信息。是关于生意的。这是关于团队结构的。它关注于如何解决业务问题。我认为可能仍然有太多的注意力集中在技术上。我认为我们仍然需要纠正这一点。没有多少人还在读埃里克·埃文斯的蓝皮书。虽然Data Mesh现在显然又重新流行起来,但它的受欢迎程度似乎在下降。我认为领域驱动的设计、业务能力等仍然是微服务领域的核心。

理查森:技术将继续发展。我觉得这不是微服务的核心。这是一个笑话,但也许XML将取代YAML卷土重来。我只是想说。

刘易斯:而不是在YAML或JSON中隧道XML。

Gamanji:我们将在这里用YAML替换所有东西。实际上有一个项目,它允许您使用Excel电子表格管理应用程序。如果需要,情况可能会变得更糟。

理查森:一切都是亚马尔。真有趣。实际上,我希望Lisp是一种配置语言,我觉得这是一种更好的方法。我觉得这个问题有两个层次。第一,我完全同意詹姆斯关于编纂设计最佳实践的观点。我认为领域驱动设计和Eric Evans的蓝皮书是关键,以及相关的东西。另一部分是关于整体与微服务的争论。首先,我们应该停止使用Twitter讨论架构。这是一个可怕的格式。所有这些辩论,如果你在推特上说,单体是好的。参与程度超出了预期。我希望我们都能就monolith架构适用于何处以及微服务架构适用于何处达成一致,因为很明显,它们都适用于何处,我们只需要确定何时适用。我希望这场辩论能得出一些结论。

刘易斯:作为对这一点的提醒,每个人。我的一个同事Neal Ford显然在建筑领域非常有名,他写了很多关于它的东西。我想他们有一本书,他和马克,这是另一本即将出版的书。我想这叫做“建筑:硬的部分”,克里斯,他们已经谈论了很多。他们有一个非常好的扰流板,因为这是他们的孩子。他们有一个非常好的模型,围绕如何考虑服务的粒度或应用程序的粒度。注意那件事。

Gamanji:这是关于确定要部署的产品的最佳架构。同时,我想提醒大家,这也是关于迭代的。目前对你有用的东西可能在几年内对你不起作用。尝试为将来的问题构建,这将帮助您拥有可维护的代码库。

原文:https://www.infoq.com/presentations/panel-microservices-architecture/

- 26 次浏览

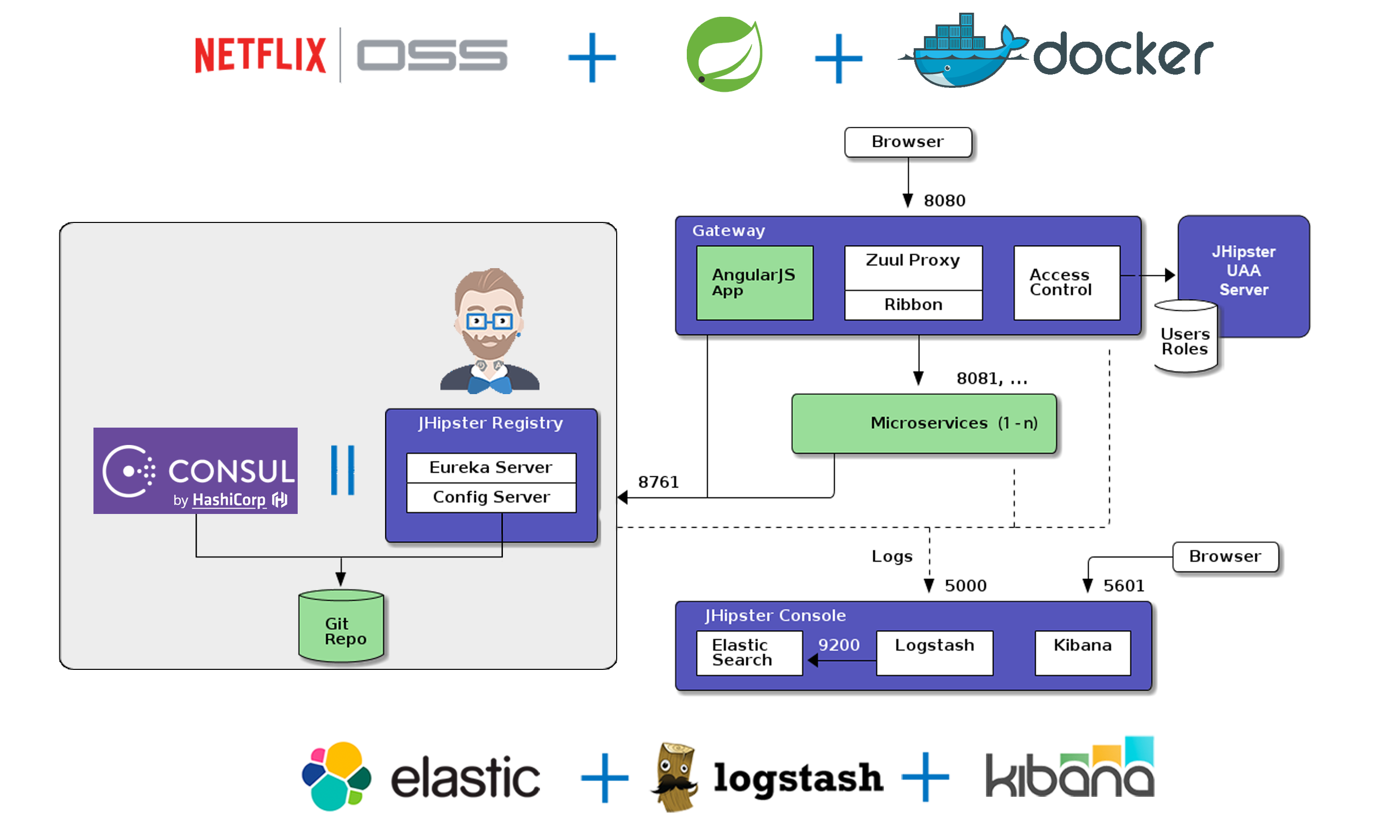

【微服务】使用Spring Boot&Swagger的微服务 - 第1部分

微服务作为消除软件组件之间隐藏的依赖关系并允许细粒度部署而不拖拽不必要的上下文的方式已经变得流行。通过这种方式,微服务可以促进敏捷开发团队的自主性,并允许应用程序更自然地发展,并在某些情况下更快地开发。

我喜欢Java,所以我将向您展示一个为JVM开发微服务的过程和框架。这是一系列文章的第一部分,介绍了端到端的服务开发。在我们将来的文章中讨论更具体的细节之前,第一篇文章(第1部分)将介绍一些基本方面。第2部分将介绍Swagger规范中的代码生成,之后的文章将深入介绍实现良好服务的一些功能。

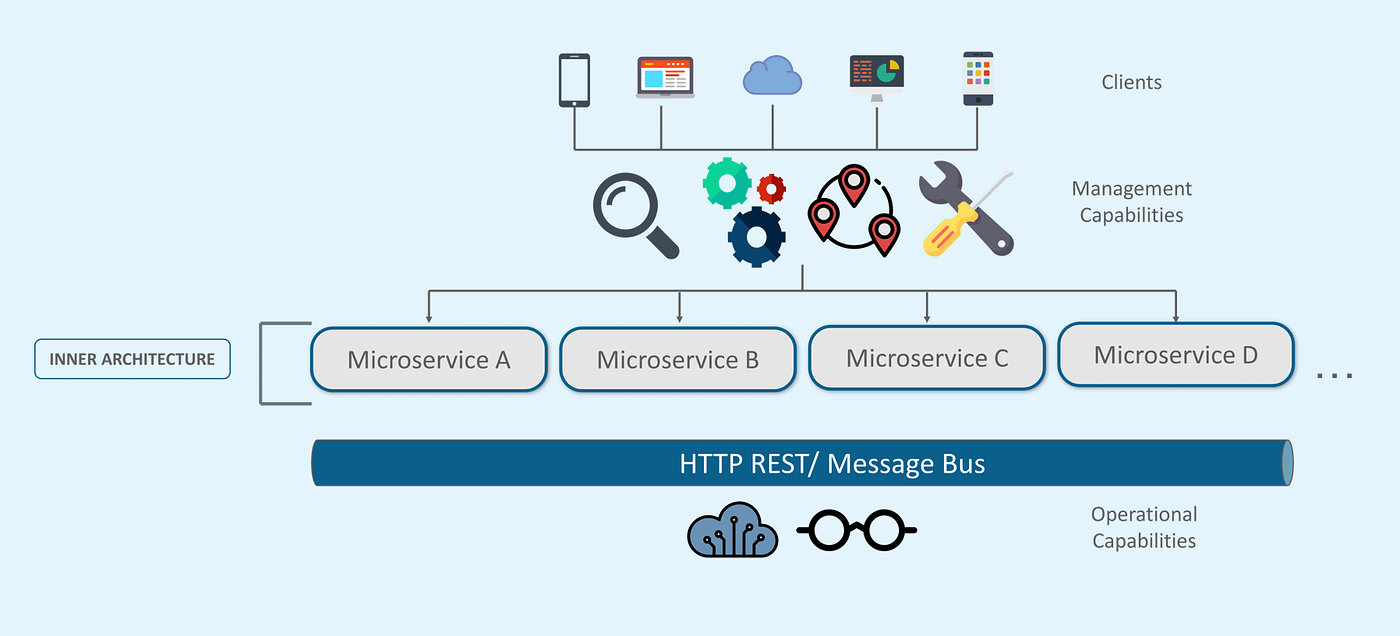

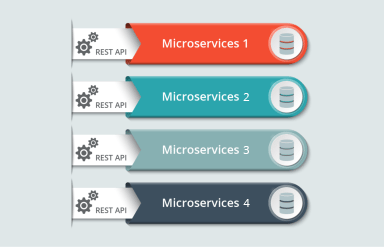

微服务特性

微服务的特征由James Lewis和Martin Fowler定义。我们可以总结一下技术特征:

- 单个运行时可执行文件 - 消除运行时库依赖性和对运行时容器打包的依赖性。

- 定义良好的API,支持单个有用的业务功能。

- 用于健康监控和记录的标准接口,便于管理大量独立服务

- 在Spring平台中,以下库支持这些特性:

- Spring Boot提供了单一的可执行特性,它为每个微服务提供了自己的HTTP堆栈(遗憾的是,这些内存占用了一些成本)并允许每个服务独立部署和管理。

- 使用Swagger的“合同优先”开发支持业务功能(有关此内容的更多信息,请参阅下一节)。

- Spring Actuator支持健康监测

- Sleuth支持标准化日志记录

合同优先发展

微服务应该提供单一有用的业务功能。这里有一些细微差别,可以归结为一个微服务,代表其API表示中的抽象业务级别。微服务应该从基础技术细节(例如数据模式或实现细节)中抽象出服务的使用者。抽象允许服务实现发展,同时对消费者的干扰最小。

API设计中常见的反模式是从实现开始,然后生成API规范 - “点击优先”方法。由此产生的接口往往过于技术化,“开发人员充满敌意”,并与实现细节紧密结合。

更好的模式是首先与消费者和其他利益相关者合作设计服务API。然后可以在负责服务实现,消费者实现,测试等的不同开发团队之间共享API规范。

对于此服务,我们将使用Swagger设计REST-ish API,但原理和技术与我们是否为REST-ish无关。例如,可以使用protocol buffers或其他接口规范工具轻松设计RPC样式服务。

我们发现在自己的git存储库中管理API规范是有益的,与服务实现分开。好处包括:

- 由于我们只有API规范,因此在审核后可轻松容纳更改。

- 服务实现者和消费者可以并行地开始他们的开发工作,从而增加团队自治并减少跨团队依赖性。

- 为服务使用者提供测试服务模拟的能力。

让我们将流程分为以下几个步骤:

- 设置服务接口项目。

- 在Swagger文件中定义服务规范并生成代码存根。

- 设置使用生成的代码存根的服务实现项目。

服务接口

我们将构建一个简单的Hello World服务,该服务使用GET方法公开/ greeting资源,该方法在调用时以包含“Hello World”消息字符串的JSON有效负载进行响应。

首先创建一个名为api-helloworld-v1-interface的Hello World Interface项目。项目结构符合标准的maven项目结构。

pom.xml文件包含以下库的依赖项:

- Swagger Codegen Maven插件,用于根据Swagger规范构建服务器存根

- 用于拉出实现JAX-RS规范的CXF模块的Apache CXF依赖项

- JSON编组和解组的Jackson JSON Provider依赖项使用了JAX-RS。提供程序通过JAX-RS自动注册

- Spring Boot依赖和

- PojoBuilder为JSON序列化构建支持POJO。

完整的pom.xml文件在这里可用,但主要的兴趣在于Swagger Codegen插件的配置。

的pom.xml

<plugins> <plugin> <groupId>io.swagger</groupId> <artifactId>swagger-codegen-maven-plugin</artifactId> <version>2.2.2</version> <executions> <execution> <id>generate-client-jar</id> <phase>generate-sources</phase> <goals> <goal>generate</goal> </goals> <configuration> <inputSpec>src/main/resources/swagger.yml</inputSpec> <templateDirectory>src/main/resources/swagger-codegen-templates/jaxrs-cxf</templateDirectory> <language>jaxrs-cxf</language> <configOptions> <sourceFolder>src/gen/java</sourceFolder> <apiPackage>${swagger-gen.api.package}</apiPackage> <modelPackage>${swagger-gen.model.package}</modelPackage> <serializableModel>true</serializableModel> <useJaxbAnnotations>false</useJaxbAnnotations> <dateLibrary>java8</dateLibrary> </configOptions> </configuration> </execution> <execution> <id>generate-html</id> <phase>generate-sources</phase> <goals> <goal>generate</goal> </goals> <configuration> <inputSpec>src/main/resources/swagger.yml</inputSpec> <language>html</language> </configuration> </execution> </executions> </plugin> </plugins>

我们的Swagger Codegen插件配置为两个执行任务:

- 生成代码存根,包括服务器端代码,客户端代码和模型POJO,

- 生成HTML文档。

对于代码生成,我们将输入规范提供为文件src / main / resources / swagger.yml。代码生成模板在文件夹src / main / resources / swagger-codegen-templates / jaxrs-cxf中提供。这些模板使用Mustache语法生成以下代码存根:

API:

代码gen插件使用此模板来定义Java接口。生成的Java接口在swagger规范中定义的每个operationId包含一个方法,该规范使用相应的HTTP方法,请求/响应媒体类型,查询参数,头参数,主体参数和表单参数进行注释。 swagger规范的tags:字段构成了以Api为后缀的Java接口名称的一部分

API实现:

如apiImpl.mustache文件中所指定,此模板生成API的存根实现。

模型POJO:

为Swagger规范中指定的每个对象生成POJO

正文参数:

将输入参数添加到生成的API方法中,这些API方法在API规范中定义为:body

我们使用代码生成语言作为jaxrs-cxf,因为CXF提供了一种使用HTTP绑定通过Annotations构建RESTFul服务的标准方法。

HTML生成非常简单,只需将输入规范指定为swagger.yml文件,将HTML指定为输出语言即可。

package-info.java

这为包级别文档和包级别注释提供了一个主页。

package com.example.api.hello.v1.model;

你好,client.yml

保存要与界面一起提供的可配置属性。

hello.endpoint:http:// localhost:8090 / api / v1 / hello

下一步

这篇文章讨论了我们可以用来开发Java和Spring中的微服务的工具的一些基本原理。我们已经审查了服务接口的项目设置和结构。在本系列的下一部分中,我们将讨论Swagger API定义并查看源代码生成过程。

- 30 次浏览

【微服务】复杂系统:微服务与人类

普罗布斯特:我叫凯瑟琳·普罗布斯特。我是谷歌的工程总监。我在这里向你们介绍复杂系统、微服务和人类。让我们从一个可能会有点意外的问题开始。北极熊与微服务有什么关系?乍一看,你可能会说他们之间可能没什么关系。让我们再深入一点。你可能知道,北极熊吃海豹。很容易理解北极熊的数量与海豹的数量有着密切的关系。如果你再往前走几步,事情就会变得复杂得多,速度也会快得多。让我们这样做吧。随着气候的变化,北极熊和海豹的栖息地也在发生变化。栖息地的变化对海豹以及北极熊种群的影响实际上要复杂得多。那么食物链上的其他动物呢,比如企鹅或磷虾。很快,你就会发现你的生态系统很难让我们真正了解。

微服务架构的行为方式

我认为,在某些方面,微服务体系结构的行为是相似的。我们很少有一个服务实际吃另一个服务,但我们确实有那些复杂的关系。让我们深入探讨一下。如果你已经开始了微服务的旅程,你可能已经从一个架构图开始,这个架构图看起来有点像我们左边的那个。您已经考虑了您的业务逻辑。你想要完成的事情。你的系统必须做什么。您已经绘制了一个架构图,它清楚地说明了所有内容的位置、行为方式以及您将要创建的服务之间的关系。

随着时间的推移,事情变得越来越复杂。也许你会组建新的团队。你有一个商业理由需要有新的功能,或者你意识到你的一项服务仍然包含了太多的行为,你想打破它。然后,当然,您要添加数据库,您要添加缓存,等等。很快,您就到了一个很难看到所有关系甚至写下架构中所有服务之间的所有关系的地步。事实上,这就是理论。实际上,当你与拥有非常复杂系统的公司交谈时,他们的系统看起来更像右边的一个,非常复杂的体系结构,其中许多公司拥有数百甚至数千个服务,并且它们都相互交互。也许并不是所有人都能直接互动,但他们之间有着很强的关系。当你看到如右图所示的东西时,实际上很难只写下体系结构和系统中发生的一切。

我想强调的是,从我的角度来看,这并不意味着巨石是正确的答案,微服务本身让生活变得艰难。这不是我的观点。我的观点是,如果你有和这里一样多的功能,需要数百或数千个服务,如果你把所有这些都放在一个整体中,你会有很多其他的问题。这不一定更容易推理。在我看来,有些情况下,巨石是正确的架构。在许多情况下,微服务也是正确的体系结构。微服务和复杂的微服务系统很难推理,这是我觉得我们应该接受的事实。事实上,该行业正在使用和构建许多工具来帮助我们理解这些系统。

当您构建微服务体系结构时,我们中的许多人都遵循某些最佳实践。例如,您在左侧看到的是一个关于此架构如何与团队协调的提示。有些团队可能拥有多个微服务。我们真正想要避免的反模式是,许多团队共同拥有一个服务。将这些职责清晰地分开确实有助于分解功能,使团队能够对其系统的各个部分进行单独的推理。然后,不仅是关于它的原因,而且也演变了他们在这个系统中的部分。

我们的人类系统就像我们的分布式系统一样

我认为有一个方面值得一提,那就是我们实际上已经有了一个由人组成的组织。我们在通常组织成团队的组织中工作。你可以在左边看到一个理论组织结构图。这看起来就像你在自己的公司里看到的一样。我们有这些组织结构图,还有这些团队组织。那么,组织结构图不一定能很好地映射到微服务架构上,也许它不应该。这些团队之间的相互关系实际上比你在组织结构图中看到的更微妙、更复杂。这是因为如果您有微服务,并且这些微服务之间存在依赖关系以及它们之间的交互,那么拥有它们的团队有时需要相互交互。微服务的构建方式使各个团队尽可能地独立和自主。我们还了解到,微服务仍然可以相互影响,因此,在这些团队之间建立这些强大的联系仍然是有益的。

复杂系统的两个层次

我想说的是,我们实际上有两个层次的复杂系统。我们有我们的微服务,然后我们有我们的人类组织,我们的人类系统覆盖,或者你可以称之为微服务系统的基础。没关系。关键是它们实际上是两个系统,它们都是复杂的。他们都以有趣的方式相互交流,我认为我们需要更深入地讨论和研究。

微服务系统

当我们谈论驯服这些系统的复杂性时,我的思维模式是这分为三个粗略的阶段。这不是唯一的分类方法。这有助于我在谈论如何更好地理解系统、如何创建一个系统、如何保持一个健康、良好运行的系统时,了解需要思考的问题。我的心智模型分为这三类。第一个bucket是配置和设置。这就是你想的,我的架构是什么样子的?我所做的基本设计选择是什么?例如,我是否创建服务网格,甚至是否创建微服务?我希望遵循的最佳实践是什么?

然后,创建系统。然后你就有了一个系统,这个系统需要不断地改变。我们已经讨论过添加新服务,但是在现有服务中也发生了许多变化。您需要改进业务逻辑,添加新功能,等等。在这个领域有很多工作正在进行,讨论如何快速、安全地将新代码交付到生产环境中,比如CI/CD、GitOps。我们的最佳实践是测试和缓慢推出更改。

第三个铲斗是第2天的操作。这意味着生产中正在运行的代码。您的客户正在与该代码交互。您希望确保生产中运行的任何东西都能保持运行,并为您的客户保持良好的运行。有一系列的工作正在进行,我会粗略地描述为掉进了那个桶里,比如负载测试。

了解系统可以承受的负载。监控非常基本的事情,比如日志监控、测试、混沌测试等等。同样,这是我的心理模型,边界有些模糊。显然,我们拥有的一些工具,比如Kubernetes,不仅可以帮助您进行配置和设置,还可以帮助您进行更改。负载测试不仅仅是测试已经在生产环境中运行的系统,它还帮助您进行安全的更改。粗略地说,我觉得它很有用,因为它帮助我理解,我需要注意哪些事情?在这些桶中,我使用了哪些工具来帮助我获得基本的理解?

事件/意外(incidents)

当我们谈论系统和保持系统健康时,我们经常谈论事件。这是一个重要的组成部分,但我想强调的是,拥有一个健康的系统不仅是为了防止事故,也是为了确保我们能够以合理的速度发展我们的系统,以便我们能够快速添加功能。比如说,他们不需要几年的时间来添加。我们的系统实际上是可观察的、经过良好测试的、可维护的。事故是健康系统的重要组成部分。因为我们希望我们的客户体验一个非常可靠的系统,他们可以以适合自己业务需求的方式进行交互。

让我们谈一谈事件。几乎从定义上讲,如果你做得对,事故或停机是令人惊讶的。为什么?因为我们中的许多人都会在事后进行尸检,或者在事情发生后进行反思,或者在事件发生后进行事件回顾。这些事件审查的全部目标是确保同一事件不再发生。如果您这样做是正确的,那么几乎按照定义,停机将让您感到惊讶。我想没关系。我认为接受这一点是可以的,并且说,是的,我们在不断改进。我们有时仍然会遇到麻烦,因为我们需要提供一个没有人可以解释的系统。我认为接受这一点是很好的一步。有助于使我们保持一种心态,不断改善系统的健康状况和对系统的理解。

例如,当事件发生时,它们可能发生在系统中彼此相距很远的部分,实际上很难看到这是如何发生的。你可以举一个例子,比如左边的服务,比如说,这是一个推荐系统。比如说,你推出了一种新的算法,可以帮助你更好地推荐,无论你想推荐什么。然后在右上角有一个系统,假设这是你的计费系统。显然,您的计费系统对您的业务非常重要,因为这是客户向您付款的方式。像左边的推荐系统这样的系统可能会对计费系统产生真正的负面影响。你可能会坐在那里想,为什么会这样?这不应该发生。这是正确的。它永远不应该这样。也许一个答案是你有一个隐藏的依赖。通常,在复杂的微服务系统中,您拥有这些依赖关系,您甚至可能没有意识到您拥有这些依赖关系,或者您没有意识到您拥有这些依赖关系的程度。再次回到我的三个bucket,也许服务网格可以真正帮助您了解这些依赖关系的位置以及它们的强度。

关于事件的另一个重要方面是,它们实际上可能在代码发布后的几天或几个月内发生。问题是,它可以在任何时间点命中。不管什么时候发生,感觉都很不方便。我们在右下角以Alice为例。也许她正在为其中一个系统待命,也许她正在为计费系统待命。一切都进行得很顺利,但是这个新的推荐算法在一段时间后对这个隐藏的依赖性产生了负面影响,现在影响到了她的系统。也许爱丽丝刚刚投入了一整天的工作,她真的很累,正要回家,然后警报响起。

人体系统

这真的让我们讨论了人类系统实际上如何影响我们的微服务系统的健康。当你们谈论人类系统时,我的心智模型实际上和我关于微服务系统的心智模型并没有什么不同。在这一点上,我仍然相信我们有这三个粗糙的桶,帮助我通过我需要思考和需要注意的事情进行推理。在第一个bucket中,我们有配置和设置。这是组织花费大量时间思考工作阶梯和组织文化的地方。如何激励人们。如何设定特定角色的期望。此外,这也是多样性、公平性和包容性发挥巨大作用的地方。真正创建一个高效运作的组织是本书的重点。

第二个因素是承认组织在不断变化。从积极的方面来说,我们有人得到提升,然后他们可能会有更多的发展空间。太好了。看到人们在事业上取得进步真是太好了。这是对我们所拥有的组织体系的改变。这可能意味着这个人现在承担了额外的责任,因此他们不再像以前那样关注系统的某个部分。也许这会留下一个缺口。同样,我们也有新人加入。显然,我们需要训练他们。我们有人离开球队,有时令人遗憾,有时却没有。无论哪种方式,这些都是系统的重大变化。然后,当然,当您移动整个组织时,组织会发生变化,并且需要真正确保新的组织运作良好,团队之间相互作用良好。这是本质上由组织本身推动的变化。

还有一类我称之为第二天操作的东西,只是为了与我们之前的操作相比较。这就是我所认为的外部力量和更广泛的文化变化。外部力量是我们所有组织都经历过的一件大事。一个非常明显的例子是新冠病毒,它不可能以一种全面的方式进行规划。作为一个组织,我们需要处理并充分利用它。我们需要做大量的工作来确保我们的组织仍然健康,尽管由于这些外部因素(如新冠病毒)给我们的组织和员工带来了各种压力。那么积极的文化变革就是我们所做的变革,再一次,也许是为了确保在那里工作的每一个人都感觉到自己的参与,并且能够表现出来,把他们最好的作品带到工作中去。

事件的真实性

如果你想一想这三个桶,你会花一点时间回想一下我们刚刚谈到的事件,爱丽丝在那里待命。她在呼叫计费系统,但它失败了。这三个桶与事件的结局有什么关系?我想说的是,事实上他们与此有很大关系。爱丽丝现在正经历着情绪的过山车。她可能很沮丧。她很害怕。她的晚餐计划被破坏了,她很沮丧。这里起作用的是整个文化,组织的基础文化。例如,她是否从同龄人那里得到了适当的培训?这很清楚。那么,还有,假设她发现她需要联系某人,她觉得这样做舒服吗?她是否拥有了解联系对象所需的正确工具?

通常,事故需要来自世界各地的专家。回到我们这里的事件示例。爱丽丝在这里的右边。她负责计费系统。左边是伊桑,他负责推荐系统。我敢肯定,由于推荐系统的改变,会有更多的人,比如对这种依赖性负责的人,出现问题。现在,让我们考虑一下相互关系。爱丽丝认识伊森吗?她和他接触感到舒服吗?他们一起工作吗?他们是否有共同努力解决这一问题的正确动机?或者,他们是否有动力将问题抛到一边,让其他人来处理,例如,因为他们担心这可能对他们的职业生涯意味着什么。所有这些文化因素在这一事件的发展过程中起着巨大的作用。我想强调的是,这不仅仅是事件。您可以对组织的健康状况提出同样的论点,影响您交付功能的速度、代码的可维护性等等。从我的角度来看,我们必须尽我们所能建立健康的组织,这不仅对组织中的人来说是健康的,这是非常关键的,而且他们实际上也会对底线产生影响。

这里的主要收获是,我相信两个复杂系统之间存在着复杂的相互作用。我们经常说,发生的任何事情都不是一个单一的根本原因,而是许多促成因素。同样,这可能是一个意外事件。它可能是一个延迟的功能启动或类似的事情。也许没有一个根本原因,但有几个因素,如一个人可能有冒名顶替综合征。也许有一个人不会承认他们不知道什么。也许我们没有适当的警报和指标。所有这些东西都相互作用,产生我们可能喜欢也可能不喜欢的结果。

一些现有技术

当我们谈论人类系统时,我会假设,事实上,有很多现有技术。从我的角度来看,我们需要将大量的现有技术带到我们的组织中,并利用它尽我们所能建立健康的组织。我在这里给你们举了一些例子,但这张幻灯片的真正目的是让你们思考哪些方面可以帮助我更好地了解公司?显然,在组织心理学方面有很多研究。还有其他一些领域也涉及到具体方面。例如,人为因素研究人为错误与环境之间的相互作用。你可能会想,我在做什么,让人们更容易慢慢地进行更改?我有什么系统?同样,这可能是我们前面提到的系统之一,比如Kubernetes或服务网格。有一些CI/CD工具在帮助自动化这些步骤方面非常有用,而不是强迫人们在许多步骤中手动操作,而他们可能不会这样做。

然后,这实际上与我在行为经济学中感兴趣的研究有关,比如说,与激励有关。我们是否在我们的环境和组织中建立了正确的激励机制?我们是否确保激励人们寻求帮助,激励他们与其他团队合作?或者,我们真的在为这样做制造障碍,或者不幸的是,将它们推开?这是我在这里举的另一个例子。让他们不要问别人。也许他们看到过这样的例子,他们的绩效评估受到了伤害,因为他们问了某人一个问题,而那个人反应不好。我们需要确保我们的组织是以一种能让我们在这里取得成功的方式建立起来的。

最后一点是关于动机。这真的是深思熟虑,人们真的能够带来他们最好的作品吗?他们是否有这样做的动机?他们学习新事物的动机是掌握吗?他们有权利自主吗?他们是否了解他们的工作如何与更广泛的情况相适应,以及为什么这很重要?同样重要的是要指出,不同的人受到不同事物的驱动,或者这些事物的不同组合。我认为,真正了解我们的组织,而不仅仅是推动一件事情,也是非常有帮助的。这些只是我认为我们可以学习的领域的例子。实际上,我认为这是一个重要的步骤,因为有这么多的工作和这么多的现有技术可以帮助我们真正理解如何使我们的人类系统更好,以及我们的微服务系统更好。

现在怎么办?微服务系统

我们怎么处理这些?我想我想让你们了解的一件主要事情是,从我的角度来看,微服务系统,是的,它们可以是超级复杂的。如果你有成百上千的微服务,它们可能很难解释。然而,正确的选择不是说“它们太复杂了,我不会走那条路。”从我的角度来看,在很多情况下,它们仍然是正确的选择。然后,正确的方法是接受,是的,它们很复杂。现在,我们该怎么办?这就是我要说的,这个行业实际上已经花费了大量的时间和精力来创建各种工具和方法来帮助我们理解和改进我们的系统。我在这里列出了一些。还有很多。我想说的一件事是,弄清楚你在用这些工具做什么实际上非常重要。我建议不要因为其他人都在采用这些工具而采用其中一种,你会说,“我会采用它,然后我会找出它是如何有用的,或者为什么我需要它。”相反,要非常清楚你在努力实现什么。也许我介绍的配置更改和第2天操作的心智模型有助于了解您需要了解的系统类型。为了使您的系统更加自动化、改进和稳定,您需要准备什么样的东西。我认为,明确目标是至关重要的。

现在怎么办?人类系统

当谈到人类系统时,我觉得我们经常谈论游戏日、教育论坛、设计审查和随叫随到的培训。我认为这些都是非常棒和非常重要的。我认为他们做得还不够。我认为我们需要更深入一层。这就是我在谈论文化和包容以及我们建立的合作激励机制时所要表达的意思,等等。因为我认为,如果你的组织运作不好,激励机制也不好,那么世界上所有的比赛日都不会让你处于一个好的位置。世界上所有的随叫随到培训都不会让你处于这样一种境地,即随叫随到的人都会感到舒适,如果这正是你的组织所鼓励的。我的观点是,我们真的需要更深入地思考我们建立的各种工作阶梯,我们建立的组织。我们的人民如何在其中发挥作用。我们如何持续改善组织健康。就我所处的位置而言,组织健康本身就非常关键。让人们觉得他们可以参加工作真的很重要。他们有一条职业道路。他们对此感到高兴。即使你不是出于这种动机,我认为有一个非常清楚的理由可以证明,组织健康对企业健康有着真正的影响。

问答

布莱恩特:在一个团队关系由门票和官僚制度驱动的组织中,你能建议一些快速的胜利来让这些关系更顺利地运行吗?

问题:显然,我认为这取决于组织。我曾见过一些组织,并与那些在组织中工作的人交谈过,在这些组织中,一切都是通过票证来完成的,一切都是通过票证解决的速度来衡量的。这就是激励人们的方式。从某种意义上说,我不知道有什么捷径可以解决整个问题。当我看到一些组织,他们希望做出重大转变,那么可能需要一段时间。将组织推进到一个不同的方向需要很多推动。话虽如此,我认为根据我的经验,当情况恶化到人们只是就门票和事件进行交流,然后把他们放在一个房间里或虚拟房间里,只是相互了解,这对我来说真的很有帮助。也有人发帖说,微笑可能会有所帮助。这也是一个很好的观点。

布莱恩特:接下来,你谈到让团队的开发者拥有微服务?这不会产生额外的筒仓吗?如果是这样,您如何管理或避免这种情况?

问题:我不确定它将如何创建额外的筒仓。根据我的经验,有一件事是有点反模式的,那就是如果你有一组人编写代码,另一组人可能对代码一无所知,但在凌晨3点出错时必须接听电话。这本身在理论上可能不是一个筒仓,但在实践中,这在这两支球队之间造成了差距。基本上,在一个团队中,团队不仅编写代码并推出更改,可能与另一个团队一起,而且在系统出现问题时,至少部分地处于钩子上,我认为这创造了一种感觉,我驱动它。我拥有它。我已经准备好了,这是我的。我认为这确实很有帮助。

布莱恩特:我见过Netflix的人谈论事物的全生命周期所有权,这非常有趣。

问题:当然也可以为单独的团队留出空间,比如SRE团队或类似的团队,这也是整个流程的一部分。我认为,尽可能让这些团队共同拥有它是非常有帮助的。

布莱恩特:我正在设计微服务,但我有大约10个服务,并且已经看到了很多集成问题?您如何管理这些服务中的混乱?

问题:系好安全带。我认为这是完全正确的。事情很快变得复杂起来。我认为这就是为什么在可观察性上有如此多的投资,在这个工具上,所以我们可以让我们的头脑绕过它。我认为,显然,我们需要大量的工具和仪器来尽可能多地了解系统。这也涉及到分布式跟踪和理解系统如何相互影响,等等。我想我的建议是,不要回避,但要投资。投资于尽可能地了解系统的行为。

布莱恩特:现在回到更多的人这边。你能举例说明你过去参与过的组织中的激励措施吗?

问题:我认为当你谈论激励时,人们通常首先开始谈论钱。当然,这是一个激励因素。老实说吧。我觉得有点深。我认为,从我的角度来看,当激励措施以一种创造正确行为的方式建立起来,并且实际上让人们快乐并发展他们的事业时,激励措施最有效。让我们回到这个例子,如果出现问题,开发人员可能还需要在凌晨3点拿起电话。也许在某些组织中,他们不会因此得到任何奖励。这意味着你没有以奖励他人的方式建立激励机制。即使是在绩效考核中,或是在同侪的强化下,或是在领导层的强制执行下,你实际上是在奖励,那么奖励就不同了。它是以不同的方式设置的。这就是我说的动机。例如,如果您需要一个团队协作良好的组织,您如何激励它?你可能不仅通过创建会议,而且还通过奖励那些真正推动合作的人来激励这种合作。

布莱恩特:你能推荐一些关于面对人类挑战的书吗?我知道你放了一些像丹·平克的经典书,就在那里。还有别的书吗?

问题:我有很多我喜欢的。我现在正在重读《轻推》。

布莱恩特:马尔科姆·格拉德威尔?

问题:不,是这个。这并不完全是关于商业的,但它确实讨论了如何创造小的激励和小的推动来慢慢改变行为。我真的很喜欢这样,因为我认为当你有一个大的组织,或者你正试图完成的一个大的改变,通常最好的行动方式就是慢慢地朝一个方向前进。这与商业无关,但一个具体的例子是,如果你尽量不吃太多糖果,而把糖果留在厨房而不是桌子上,你就会少吃糖果。这是关于轻推的建议。您可以将其应用于许多不同的情况。

布莱恩特:我读过这本书。这是一本很棒的书。

再次进入技术领域。如何最好地评估微服务系统。假设你是一名技术领导者。你已经进入了一个组织。您已经对愿景有所了解,并且希望了解技术方面和人员方面的情况。有什么建议吗?

问题:我想如果你对这个系统完全陌生,我首先要考虑的是,你的团队是否了解他们所有的上游和下游依赖关系?这并不总是被理解的。您的团队是否了解其系统的限制?这也不总是很好理解。如果您不能与所有这些下游服务通信,您的系统会发生什么情况?您是否设置了指标、仪表盘和其他设置?那是另一个。然后,我要看的另一件事是速度。您能够以多快的速度进行更改,并在生产中安全地实现这些更改?有时候,你的系统中生长的藤壶越多,事情就越慢。我认为这是另一个非常重要的方面。

布莱恩特:你如何衡量组织的健康状况?

问题:我们谈论微服务系统是复杂的。我认为人类是无限迷人的,人类的组织也许更是如此。当涉及到度量或评估组织的健康状况时,有很多事情。一些更明显的事情是,你的记忆力是什么?人们总是在沮丧中离开吗?这是出问题的明显迹象。我认为,当你也在观察你的组织的生产力时,有很多代理指标,人们会发现它们有很多缺点。我明白为什么。比如代理指标,比如提交了多少代码,或者我们能以多快的速度完成代码审查之类的事情?这些都是代理指标,但它们可以告诉你一些事情,也可以告诉你趋势。这是一件事。另外一件事,老实说,我发现你只需要和人们谈谈,因为每个人都有不同的观点。世界上所有的代理指标都无法让你更深入地了解人们在为什么而挣扎,人们在为什么而高兴。

原文:https://www.infoq.com/presentations/microservices-best-practices/

- 43 次浏览

【微服务】微服务安全 - 如何保护您的微服务基础架构?

在当今行业使用各种软件架构和应用程序的市场中,几乎不可能感觉到您的数据是完全安全的。 因此,在使用微服务架构构建应用程序时,安全问题变得更加重要,因为各个服务相互之间以及客户端之间进行通信。 因此,在这篇关于微服务安全的文章中,我将按以下顺序讨论您可以实施的各种方法来保护您的微服务。

- 什么是微服务?

- 微服务面临的问题

- 保护微服务的最佳实践

什么是微服务?

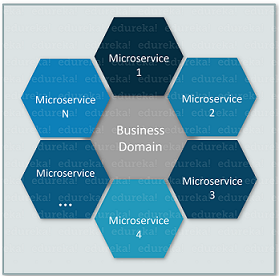

微服务,又名微服务架构,是一种架构风格,将应用程序构建为围绕业务领域建模的小型自治服务的集合。 因此,您可以将微服务理解为围绕单个业务逻辑相互通信的小型单个服务。

现在,通常当公司从单体架构转向微服务时,他们会看到许多好处,例如可扩展性、灵活性和较短的开发周期。但是,与此同时,这种架构也引入了一些复杂的问题。

那么,接下来在这篇关于微服务安全的文章中,让我们了解一下微服务架构面临的问题。

微服务面临的问题

微服务面临的问题如下:

问题1:

考虑一个场景,用户需要登录才能访问资源。现在,在微服务架构中,用户登录详细信息必须以这样一种方式保存,即用户每次尝试访问资源时都不会被要求进行验证。现在,这产生了一个问题,因为用户详细信息可能不安全,也可能被第 3 方访问。

问题2:

当客户端发送请求时,需要验证客户端详细信息,并且需要检查授予客户端的权限。因此,当您使用微服务时,可能会发生对于每项服务,您都必须对客户端进行身份验证和授权。现在,要做到这一点,开发人员可能会为每项服务使用相同的代码。但是,您不认为依赖特定代码会降低微服务的灵活性吗?好吧,它确实如此。因此,这是该架构中经常面临的主要问题之一。

问题3:

下一个非常突出的问题是每个单独的微服务的安全性。在这种架构中,除了第三方应用程序之外,所有微服务同时相互通信。因此,当客户端从 3 rd 方应用程序登录时,您必须确保客户端无法访问微服务的数据,这样他/她可能会利用它们。

好吧,上述问题并不是微服务架构中发现的唯一问题。我想说的是,根据您拥有的应用程序和架构,您可能会面临许多其他与安全相关的问题。关于这一点,让我们继续阅读这篇关于微服务安全的文章,并了解减少挑战的最佳方法。

微服务安全最佳实践

提高微服务安全性的最佳实践如下:

纵深防御机制

众所周知,微服务会采用任何细粒度的机制,因此您可以应用深度防御机制来使服务更加安全。通俗地说,深度防御机制基本上是一种技术,您可以通过它应用多层安全对策来保护敏感服务。因此,作为开发人员,您只需识别具有最敏感信息的服务,然后应用多个安全层来保护它们。这样,就可以确保任何潜在的攻击者都无法一次性破解安全,而必须向前尝试破解所有层级的防御机制。

此外,由于在微服务架构中,您可以在不同的服务上实施不同的安全层,因此成功利用特定服务的攻击者可能无法破解其他服务的防御机制。

令牌和 API 网关

通常,当您打开应用程序时,您会看到一个对话框,上面写着“接受许可协议和 cookie 许可”。这条消息意味着什么?好吧,一旦您接受它,您的用户凭据将被存储并创建一个会话。现在,下次您进入同一页面时,该页面将从缓存内存而不是服务器本身加载。在这个概念出现之前,会话集中存储在服务器端。但是,这是应用程序水平扩展的最大障碍之一。

令牌

所以,这个问题的解决方案是使用令牌,来记录用户凭据。这些令牌用于轻松识别用户并以 cookie 的形式存储。现在,每次客户端请求网页时,请求都会被转发到服务器,然后服务器会判断用户是否可以访问所请求的资源。

现在,主要问题是存储用户信息的令牌。因此,需要对令牌的数据进行加密,以避免对第三方资源的任何利用。 Jason Web 格式或最常见的 JWT 是一种定义令牌格式的开放标准,提供各种语言的库,并加密这些令牌。

API 网关

API 网关作为一个额外的元素通过令牌身份验证来保护服务。 API 网关充当所有客户端请求的入口点,并有效地向客户端隐藏微服务。因此,客户端无法直接访问微服务,因此,任何客户端都无法利用任何服务。

分布式跟踪和会话管理

分布式跟踪

在使用微服务时,您必须持续监控所有这些服务。但是,当您必须同时监控大量服务时,就会出现问题。为避免此类挑战,您可以使用一种称为分布式跟踪的方法。分布式跟踪是一种查明故障并确定故障原因的方法。不仅如此,您还可以确定发生故障的位置。因此,很容易追踪到哪个微服务面临安全问题。

会话管理

会话管理是保护微服务时必须考虑的重要参数。现在,只要用户进入应用程序,就会创建一个会话。因此,您可以通过以下方式处理会话数据:

- 您可以将单个用户的会话数据存储在特定服务器中。但是,这种系统完全依赖于服务之间的负载均衡,只满足水平扩展。

- 完整的会话数据可以存储在单个实例中。然后可以通过网络同步数据。唯一的问题是,在这种方法中,网络资源会耗尽。

- 您可以确保可以从共享会话存储中获取用户数据,从而确保所有服务都可以读取相同的会话数据。但是,由于数据是从共享存储中检索的,因此您需要确保您有一些安全机制,以便以安全的方式访问数据。

第一次会话和相互 SSL

第一次会议的想法很简单。用户只需登录应用程序一次,即可访问应用程序中的所有服务。但是,每个用户最初都必须与身份验证服务进行通信。好吧,这肯定会导致所有服务之间的大量流量,并且对于开发人员来说,在这种情况下找出故障可能很麻烦。

使用 Mutual SSL 后,应用程序通常会面临来自用户、第 3 方以及相互通信的微服务的流量。但是,由于这些服务是由第 3 方访问的,因此总是存在受到攻击的风险。现在,此类场景的解决方案是微服务之间的相互 SSL 或相互身份验证。这样,服务之间传输的数据将被加密。这种方法唯一的问题是,当微服务数量增加时,由于每个服务都会有自己的 TLS 证书,开发人员更新证书将非常困难。

3rdparty 应用程序访问

我们所有人都访问属于 3 rd 方应用程序的应用程序。 3 rd 方应用程序使用用户在应用程序中生成的 API 令牌来访问所需的资源。因此,第 3 方应用程序可以访问该特定用户的数据,而不是其他用户的凭据。好吧,这是针对单个用户的。但是,如果应用程序需要访问来自多个用户的数据怎么办?您认为如何满足这样的要求?

OAuth 的使用

解决方案是使用 OAuth。当您使用 OAuth 时,应用程序会提示用户授权 3 rd 方应用程序,使用所需的信息,并为其生成令牌。一般使用授权码来请求令牌,以确保用户的回调 URL 不被盗用。

因此,在提及访问令牌时,客户端与授权服务器进行通信,该服务器授权客户端以防止其他人伪造客户端的身份。因此,当您将微服务与 OAuth 结合使用时,服务充当 OAuth 架构中的客户端,以简化安全问题。

好吧,伙计们,我不会说这些是确保服务安全的唯一方法。您可以根据应用程序的架构以多种方式保护微服务。因此,如果您是一个渴望构建基于微服务的应用程序的人,那么请记住,服务的安全性是您需要谨慎的一个重要因素。关于这一点,我们结束了这篇关于微服务安全的文章。我希望你发现这篇文章内容丰富。

如果您想查看更多有关人工智能、DevOps、Ethical Hacking 等市场最流行技术的文章,您可以参考 Edureka 的官方网站。

请注意本系列中的其他文章,这些文章将解释微服务的其他各个方面。

- 1. What is Microservices?

- 2. Microservices Architecture

- 3. Microservices vs SOA

- 4. Microservices Tutorial

- 5. Building Microservices Application Using Spring Boot

- 6. Microservices Security

原文:https://medium.com/edureka/microservices-security-b01b8f2a9215

- 43 次浏览

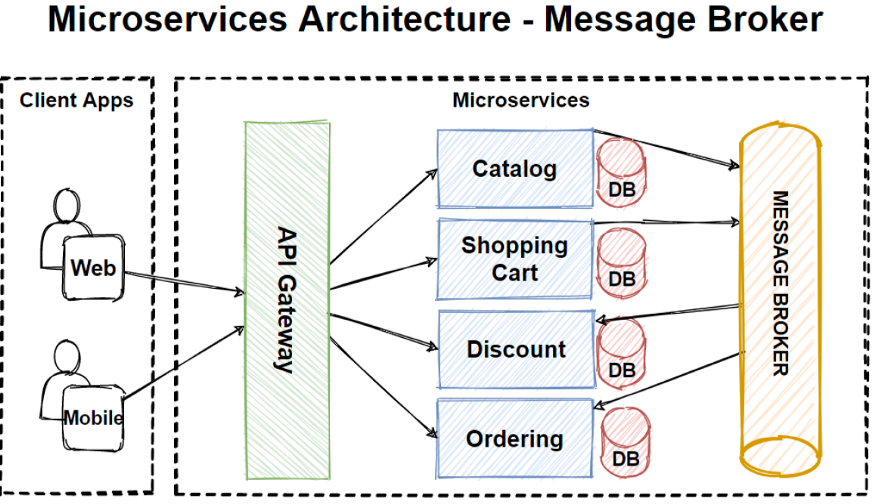

【微服务】微服务间通信的最佳实践

一个好的 API 架构对于有效处理微服务之间的通信很重要。不要害怕创建新的微服务,并尽可能地尝试解耦功能。例如,与其创建一个通知服务,不如尝试为电子邮件通知、SMS 通知和移动推送通知创建单独的微服务。

在这里,我假设您有一个 API 网关来管理请求、处理到负载平衡服务器的路由并限制未经授权的访问。

通讯类型

- 同步协议:HTTP 是一种同步协议。客户端发送请求并等待服务的响应。这与客户端代码执行无关,它可以是同步的(线程被阻塞)或异步的(线程未被阻塞,并且响应最终会到达回调)。这里的重点是协议(HTTP/HTTPS)是同步的,客户端代码只有在收到 HTTP 服务器响应后才能继续其任务。

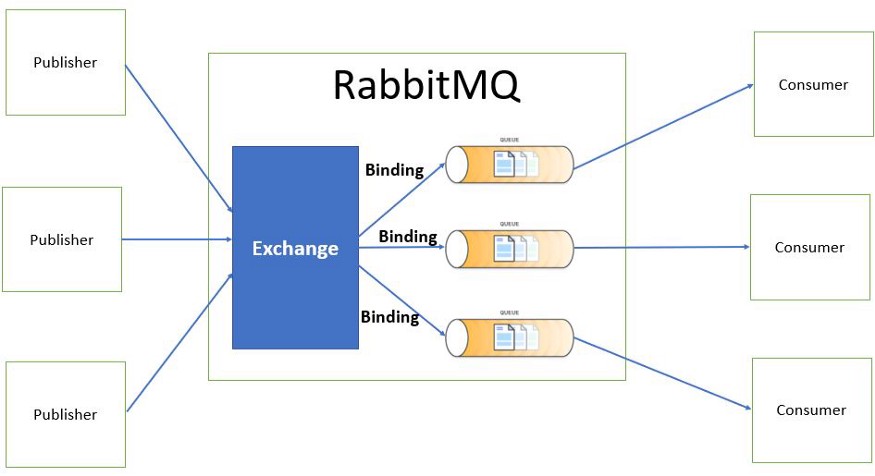

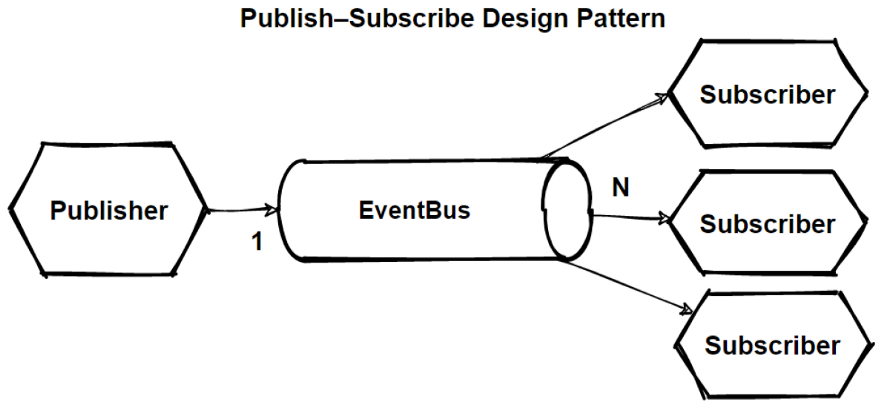

- 异步协议:其他协议如 AMQP(许多操作系统和云环境支持的协议)使用异步消息。客户端代码或消息发送者通常不等待响应。它只是将消息发送到消息代理服务,例如 RabbitMQ 或 Kafka(如果我们使用的是事件驱动架构)。

为什么你应该避免同步协议

- 如果您不断添加相互通信的新微服务,那么在代码中使用端点会造成混乱,尤其是当您必须在端点中传递额外信息时。例如,身份验证令牌。

- 您必须等待耗时的调用才能获得响应。

- 如果响应失败并且您有重试策略,那么它可能会造成瓶颈。

- 如果接收器服务关闭或无法处理请求,那么我们要等到服务启动。例如,在电子商务网站中,用户下订单并请求发送到发货服务以发货,但发货服务关闭,我们丢失了订单。一旦完成,如何将相同的订单发送到运输服务?

- 接收方可能无法一次处理大量请求,因此应该有一个地方让请求必须等待,直到接收方准备好处理下一个请求。

为了应对这些挑战,我们可以使用一个中间服务来处理两个微服务之间的通信,也称为“消息代理”。

RabbitMQ 被广泛用作消息代理服务,如果您将 Azure 云作为托管服务提供商,您也可以使用 Azure 服务总线。

如何使用RabbitMQ来处理微服务之间的通信

可能存在发件人想要向多个服务发送消息的情况。 让我们看看 RabbitMQ 如何处理的下图。

当发布者发送消息时,它被 Exchange 接收,然后 Exchange 将其发送到目标队列。消息保持在队列中,直到接收方接收并处理它。

交换类型

- 直接交换根据消息路由键将消息传递到队列。这是默认的交换类型。

- 扇出交换将消息传递到所有队列。

- Header Exchange 根据消息头标识目标队列。

- 主题交换类似于直接交换,但路由是根据路由模式完成的。它不使用固定的路由键,而是使用通配符。

例如,假设我们有以下路由模式。

- order.logs.customer

- order.logs.international

- order.logs.customer.electronics

- order.logs.international.electronics

“order.*.*.electronics” 的路由模式只匹配第一个词是“order”,第四个词是“electronics”的路由键。

“order.logs.customer.#”的路由模式匹配任何以“order.logs.customer”开头的路由键。

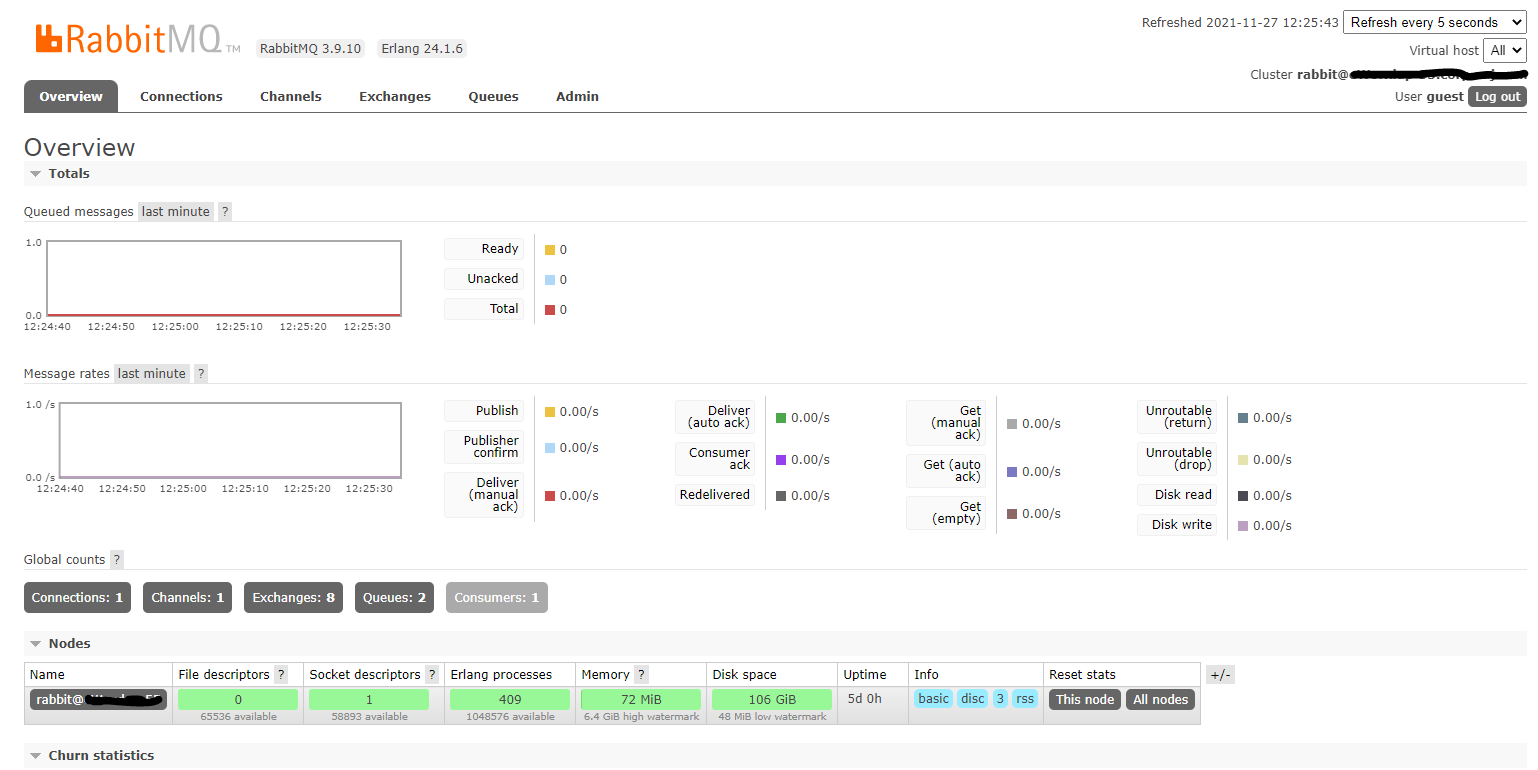

实现RabbitMQ

安装

按照此链接在 Windows 上安装 RabbitMQ。安装后 RabbitMQ 服务将在 http://localhost:15672/ 上启动并运行。在用户名和密码中输入“guest”登录,您将能够看到所有静态信息。

创建发件人服务

RabbitMQ 启动并运行后,创建两个控制台应用程序

Sender:向RabbitMQ发送消息

Receiver:从RabbitMQ接收消息

向两个应用程序添加包“RabbitMQ.Client”。

using System;

using RabbitMQ.Client;

using System.Text;

class Send

{

public static void Main()

{

var factory = new ConnectionFactory() { HostName = "localhost" };

using(var connection = factory.CreateConnection())

using(var channel = connection.CreateModel())

{

channel.QueueDeclare(queue: "hello", durable: false, exclusive: false,

autoDelete: false, arguments: null);

string message = "Hello World!";

var body = Encoding.UTF8.GetBytes(message);

channel.BasicPublish(exchange: "", routingKey: "hello",

basicProperties: null, body: body);

Console.WriteLine(" [x] Sent {0}", message);

}

Console.WriteLine(" Press [enter] to exit.");

Console.ReadLine();

}

}

上面的代码将创建一个到 RabbitMQ 的连接,创建一个队列“hello”并向队列发布一条消息。

using RabbitMQ.Client;

using RabbitMQ.Client.Events;

using System;

using System.Text;

class Receive

{

public static void Main()

{

var factory = new ConnectionFactory() { HostName = "localhost" };

using(var connection = factory.CreateConnection())

using(var channel = connection.CreateModel())

{

channel.QueueDeclare(queue: "hello", durable: false,

exclusive: false, autoDelete: false, arguments: null);

Console.WriteLine(" [*] Waiting for messages.");

var consumer = new EventingBasicConsumer(channel);

consumer.Received += (model, ea) =>

{

var body = ea.Body.ToArray();

var message = Encoding.UTF8.GetString(body);

Console.WriteLine(" [x] Received {0}", message);

};

channel.BasicConsume(queue: "hello", autoAck: true, consumer: consumer);

Console.WriteLine(" Press [enter] to exit.");

Console.ReadLine();

}

}

}

上面的代码将创建一个到 RabbitMQ 的连接,创建一个队列(如果它还没有创建),并注册一个将接收和处理消息的处理程序。

在运行发送方和接收方应用程序时,您将能够看到在 RabbitMQ 门户上创建的队列,以及表示收到新消息的图形上的尖峰。从门户中,您将能够看到哪个服务有待处理的消息,您可以添加该服务的另一个实例以进行负载平衡。

一开始你可以使用rabbitMQ,事情会很顺利。但是当复杂性增加并且您有很多端点调用其他服务时,它就会造成混乱。很快,您会发现自己围绕驱动程序创建了一个包装器,这样您就可以减少需要编写的代码量。例如,每次您调用另一个服务的端点时,您都必须提供身份验证令牌。然后你会发现自己需要处理 ack 与 nack,你将为此创建一个简单的 API。最终,您将需要处理有害消息——格式错误并导致异常的消息。

要处理所有这些工作流,您可以使用 NserviceBus。让我们讨论一个项目结构:

考虑到这种架构,ClientUI 端点将 PlaceOrder 命令发送到 Sales 端点。 因此,Sales 端点将使用发布/订阅模式发布 OrderPlaced 事件,该事件将由 Billing 端点接收。

NserviceBus 配置:

class Program

{

static async Task Main(string[] args)

{

await CreateHostBuilder(args).RunConsoleAsync();

}

public static IHostBuilder CreateHostBuilder(string[] args)

{

return Host.CreateDefaultBuilder(args)

.UseNServiceBus(context =>

{

var endpointConfiguration = new EndpointConfiguration("Sales");

//configure transport - configure where your message will

//be published/saved

//you can configure it for RabbitMq, Azure Queue, Amazon

//SQS or any other cloud provider

endpointConfiguration.UseTransport<LearningTransport>();

endpointConfiguration.SendFailedMessagesTo("error");

//When a message fails processing

//it will be forwarded here.

endpointConfiguration.AuditProcessedMessagesTo("audit");

//All messages received by an endpoint

//will be forwarded to the audit queue.

return endpointConfiguration;

});

}

}

然后使用 IMessageSession 对象发送消息:

public class HomeController : Controller

{

static int messagesSent;

private readonly ILogger<HomeController> _log;

private readonly IMessageSession _messageSession;

public HomeController(IMessageSession messageSession, ILogger<HomeController> logger)

{

_messageSession = messageSession;

_log = logger;

}

[HttpPost]

public async Task<ActionResult> PlaceOrder()

{

string orderId = Guid.NewGuid().ToString().Substring(0, 8);

var command = new PlaceOrder { OrderId = orderId };

// Send the command

await _messageSession.Send(command)

.ConfigureAwait(false);

_log.LogInformation($"Sending PlaceOrder, OrderId = {orderId}");

dynamic model = new ExpandoObject();

model.OrderId = orderId;

model.MessagesSent = Interlocked.Increment(ref messagesSent);

return View(model);

}

}

最后,添加一个处理程序来接收和处理消息:

public class PlaceOrderHandler :

IHandleMessages<PlaceOrder>

{

static readonly ILog log = LogManager.GetLogger<PlaceOrderHandler>();

static readonly Random random = new Random();

public Task Handle(PlaceOrder message, IMessageHandlerContext context)

{

log.Info($"Received PlaceOrder, OrderId = {message.OrderId}");

return Task.CompletedTask;

}

}

这是 NserviceBus 和 RabbitMQ 的基本实现。

概括

在服务之间通信时避免使用同步协议。 使用 RabbitMQ 在服务之间进行通信并在消息从源传送到目标之前临时保存它们。 使用 NserviceBus 解耦应用程序代码和消息代理,并管理长时间运行的请求。

原文:https://irfanyusanif.medium.com/how-to-communicate-between-microservice…

- 38 次浏览

【微服务】构建应用程序的顶级微服务设计模式

在当今市场上,微服务已成为构建应用程序的首选解决方案。 众所周知,它们可以解决各种挑战,但是,熟练的专业人员在使用此架构时经常面临挑战。 因此,相反,开发人员可以探索这些问题中的常见模式,并可以创建可重用的解决方案来提高应用程序的性能。 因此,在这篇关于微服务设计模式的文章中,我将讨论构建成功的微服务所必需的顶级模式。

本文将介绍以下主题:

- 什么是微服务?

- 用于设计微服务架构的原则

- 微服务的设计模式

什么是微服务?

微服务,又名微服务架构,是一种架构风格,将应用程序构建为围绕业务领域建模的小型自治服务的集合。在微服务架构中,每个服务都是自包含的并实现单一的业务能力。如果想详细了解微服务,可以参考我的微服务架构一文。

用于设计微服务架构的原则

用于设计微服务的原则如下:

- 独立自主的服务

- 可扩展性

- 权力下放(去中心化)

- 弹性服务

- 实时负载均衡

- 可用性

- 通过 DevOps 集成实现持续交付

- 无缝 API 集成和持续监控

- 故障隔离

- 自动配置

微服务的设计模式

- 聚合器

- API 网关

- 连锁或责任链

- 异步消息

- 数据库或共享数据

- 事件溯源

- 分支

- 命令查询职责分离器

- 断路器

- 分解

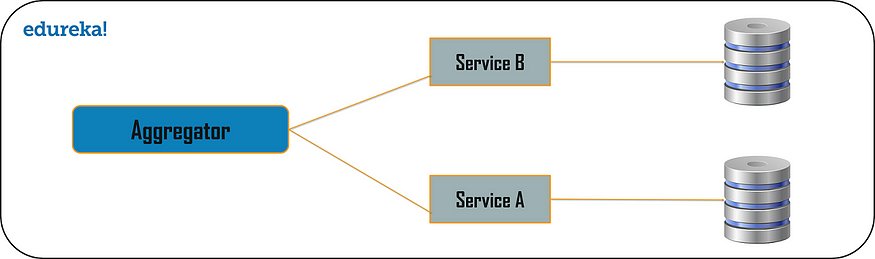

聚合器模式

计算世界中的聚合器是指收集相关数据项并显示它们的网站或程序。因此,即使在微服务模式中,聚合器也是一个基本的网页,它调用各种服务来获取所需的信息或实现所需的功能。

此外,由于输出源在将单体架构分解为微服务时被划分,因此当您需要通过组合来自多个服务的数据来输出时,这种模式被证明是有益的。因此,如果我们有两个服务,每个服务都有自己的数据库,那么具有唯一事务 ID 的聚合器将从每个单独的微服务收集数据,应用业务逻辑并最终将其发布为 REST 端点。稍后,收集到的数据可以由需要收集到的数据的各个服务使用。

聚合设计模式基于 DRY 原则。基于此原则,您可以将逻辑抽象为复合微服务,并将特定业务逻辑聚合到一个服务中。

因此,例如,如果您考虑两个服务:服务 A 和 B,那么您可以通过将数据提供给复合微服务来同时单独扩展这些服务。

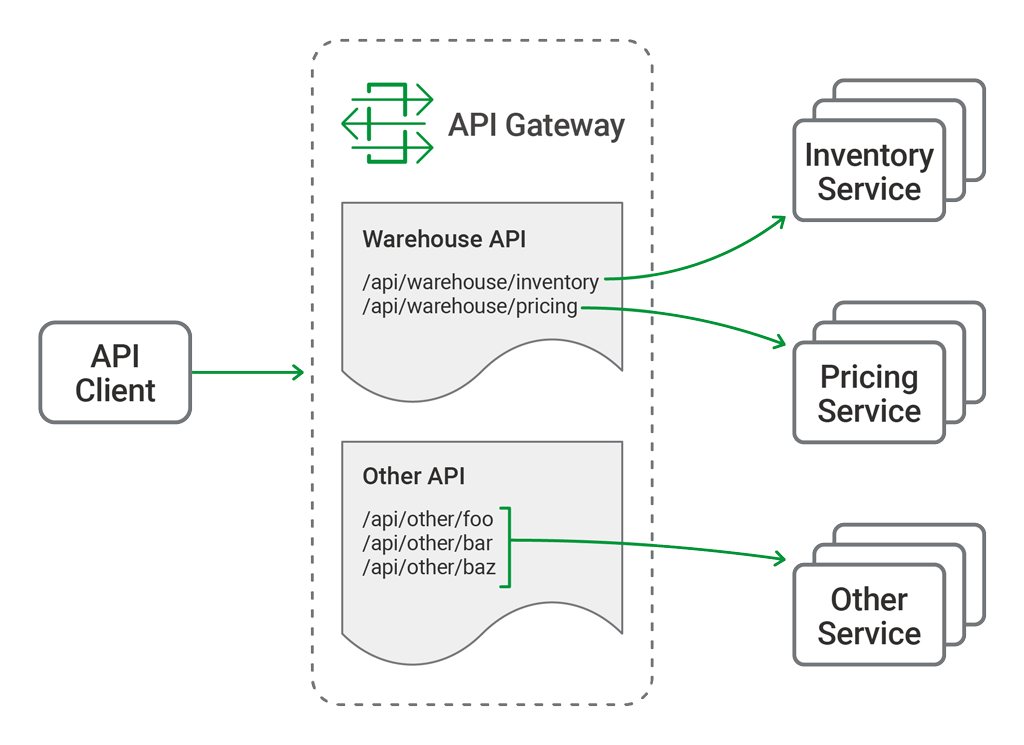

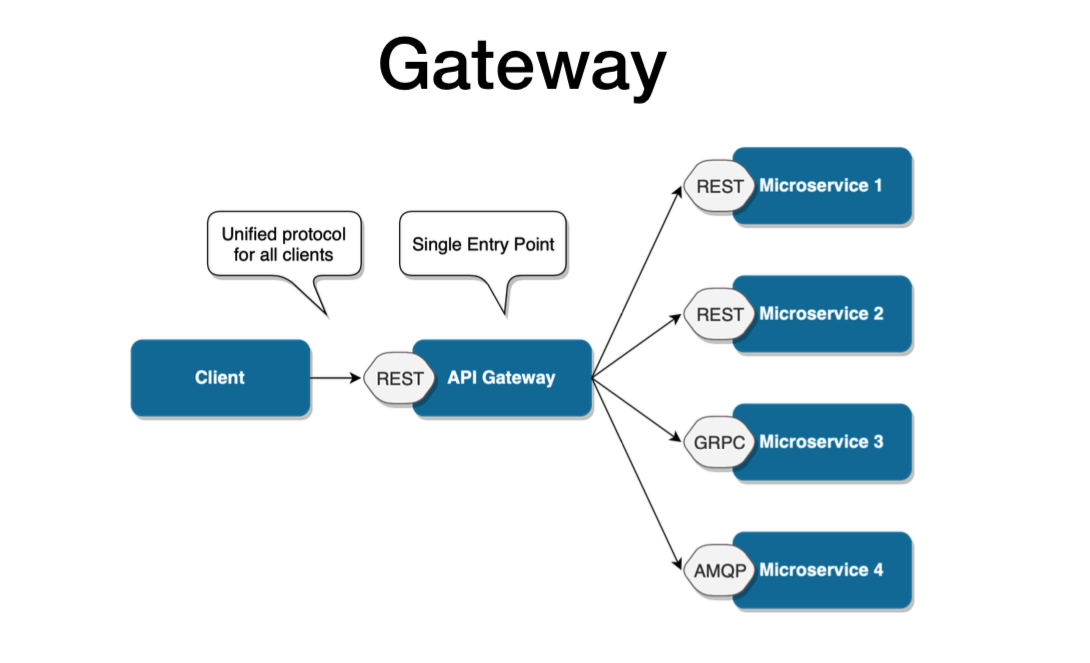

API 网关设计模式

微服务的构建方式使得每个服务都有自己的功能。但是,当应用程序被分解为小型自治服务时,开发人员可能面临的问题可能很少。问题可能如下:

- 如何从多个微服务请求信息?

- 不同的 UI 需要不同的数据来响应同一个后端数据库服务

- 如何根据消费者需求从可重用的微服务中转换数据

- 如何处理多个协议请求?

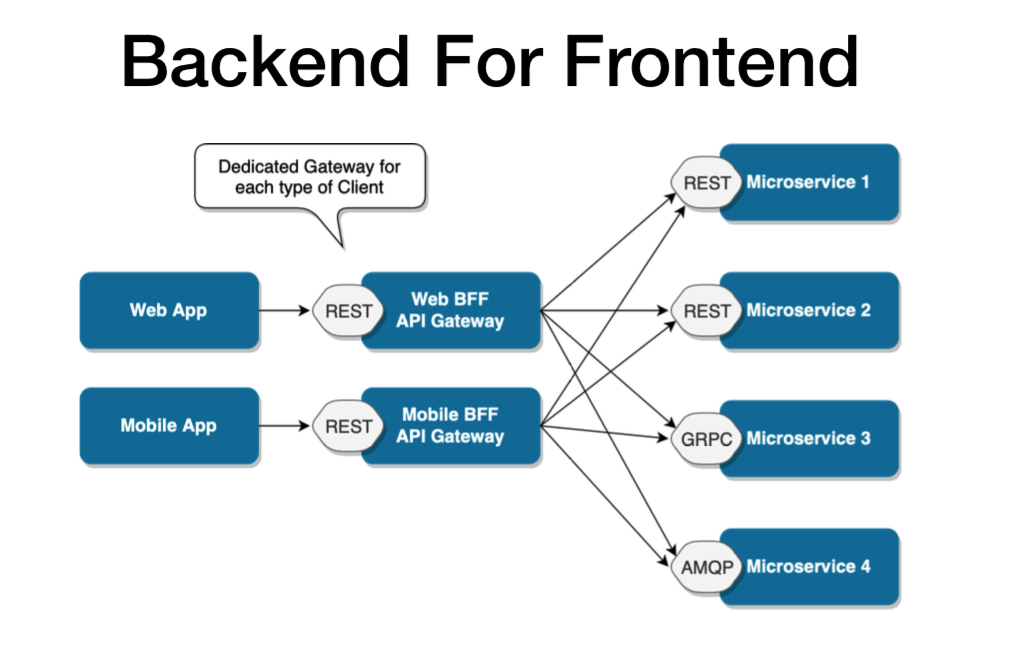

好吧,这些问题的解决方案可能是 API 网关设计模式。 API 网关设计模式不仅解决了上述问题,还解决了许多其他问题。这种微服务设计模式也可以被认为是代理服务,将请求路由到相关的微服务。作为聚合器服务的一种变体,它可以将请求发送到多个服务,并类似地将结果聚合回组合或消费者服务。 API Gateway 还充当所有微服务的入口点,并为不同类型的客户端创建细粒度的 API。

借助 API Gateway 设计模式,API 网关可以将协议请求从一种类型转换为另一种类型。同样,它也可以卸载微服务的身份验证/授权责任。

因此,一旦客户端发送请求,这些请求就会传递到 API 网关,该网关充当入口点,将客户端的请求转发到适当的微服务。然后,在负载均衡器的帮助下,处理请求的负载并将请求发送到相应的服务。微服务使用服务发现作为指导来找到它们之间的通信路径。然后微服务通过无状态服务器相互通信,即通过 HTTP 请求/消息总线。

链式或责任链模式

链式或责任链设计模式产生单个输出,该输出是多个链式输出的组合。因此,如果您将三个服务排成一条链,那么,来自客户端的请求首先由服务 A 接收。然后,该服务与下一个服务 B 通信并收集数据。最后,第二个服务与第三个服务通信以生成合并的输出。所有这些服务都使用同步 HTTP 请求或响应进行消息传递。此外,在请求通过所有服务并生成相应的响应之前,客户端不会得到任何输出。所以,总是建议不要做长链,因为客户端会等到链完成

您需要了解的另一个重要方面是,从服务 A 到服务 B 的请求可能看起来与服务 B 到服务 C 不同。同样,从服务 C 到服务 B 的响应可能看起来与服务 B 到服务 A 完全不同。

异步消息设计模式

从上面的模式中,很明显客户端在同步消息中被阻塞或等待很长时间。 但是,如果您不希望消费者等待很长时间,那么您可以选择异步消息传递。 在这种类型的微服务设计模式中,所有服务都可以相互通信,但它们不必按顺序相互通信。 因此,如果考虑 3 个服务:服务 A、服务 B 和服务 C。来自客户端的请求可以直接同时发送到服务 C 和服务 B。 这些请求将排在队列中。 除此之外,请求还可以发送到服务 A,其响应不必发送到请求所经过的同一服务。

数据库或共享数据模式

对于每个应用程序,都存在大量数据。因此,当我们将应用程序从其单体架构分解为微服务时,非常重要的是要注意每个微服务都有足够的数据量来处理请求。因此,系统可以为每个服务拥有一个数据库,也可以为每个服务拥有一个共享数据库。您可以使用每个服务的数据库和每个服务的共享数据库来解决各种问题。问题可能如下:

- 数据重复和不一致

- 不同的服务有不同的存储需求

- 很少有业务可以查询数据,有多种服务

- 数据去规范化

好吧,为了解决前三个问题,我认为您可以使用每个服务的数据库,因为它将由微服务 API 本身访问。因此,每个微服务都有自己的数据库 ID,这会阻止系统中的其他服务使用该特定数据库。除此之外,为了解决反规范化问题,您可以为每个服务选择共享数据库,为每个微服务对齐多个数据库。这将帮助您为分解为微服务的单体应用程序收集数据。但是,您必须记住,您必须将这些数据库限制为 2-3 个微服务;否则,扩展这些服务将是一个问题。

事件溯源设计模式

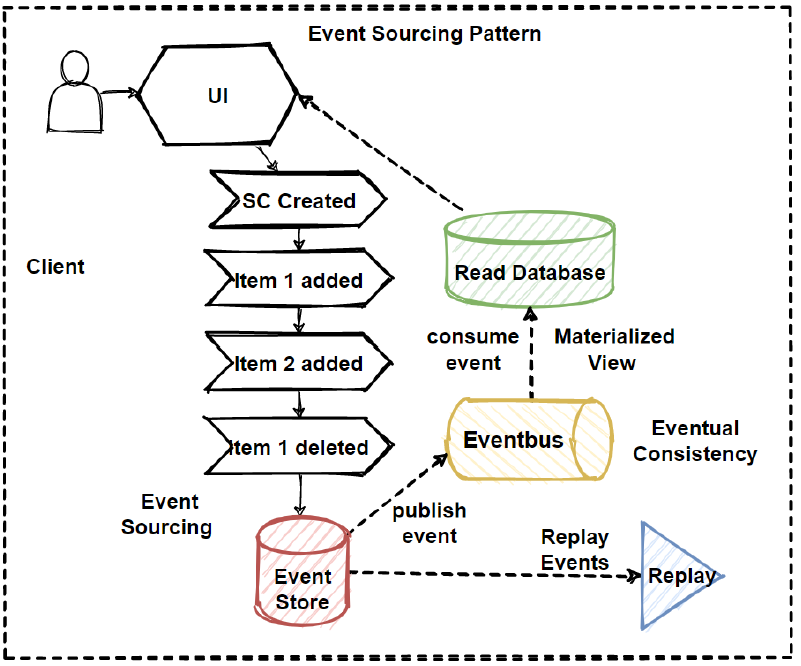

事件源设计模式创建有关应用程序状态更改的事件。 此外,这些事件被存储为一系列事件,以帮助开发人员跟踪何时进行了哪些更改。 因此,借助此功能,您可以随时调整应用程序状态以应对过去的变化。 您还可以查询这些事件以了解任何数据更改,并同时从事件存储中发布这些事件。 发布事件后,您可以在表示层上看到应用程序状态的变化。

分支模式

分支微服务设计模式是一种设计模式,您可以在其中同时处理来自两个或多个独立微服务的请求和响应。 因此,与链式设计模式不同,请求不是按顺序传递的,而是将请求传递给两个或多个互斥的微服务链。 这种设计模式扩展了聚合器设计模式,并提供了从多链或单链产生响应的灵活性。 例如,如果您考虑一个电子商务应用程序,那么您可能需要从多个来源检索数据,而这些数据可能是来自各种服务的数据的协作输出。 因此,您可以使用分支模式从多个来源检索数据。

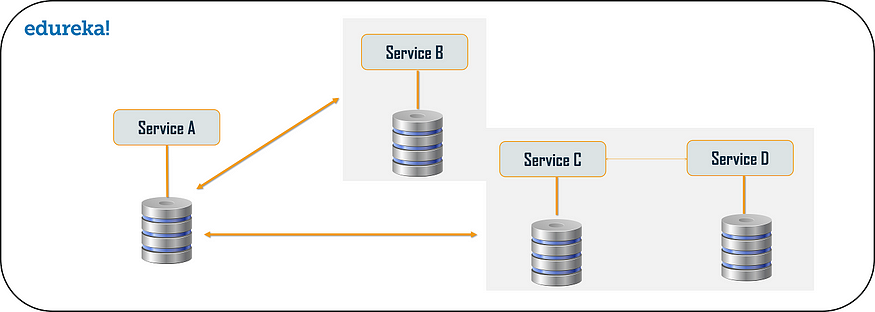

命令查询职责分离器 (CQRS) 设计模式

每个微服务设计都有每个服务模型的数据库或每个服务的共享数据库。 但是,在每个服务的数据库模型中,我们无法实现查询,因为数据访问仅限于一个数据库。 因此,在这种情况下,您可以使用 CQRS 模式。 根据这种模式,应用程序将分为两部分:命令和查询。 命令部分将处理与 CREATE、UPDATE、DELETE 相关的所有请求,而查询部分将处理物化视图。 通过使用上述事件源模式创建的一系列事件来更新物化视图。

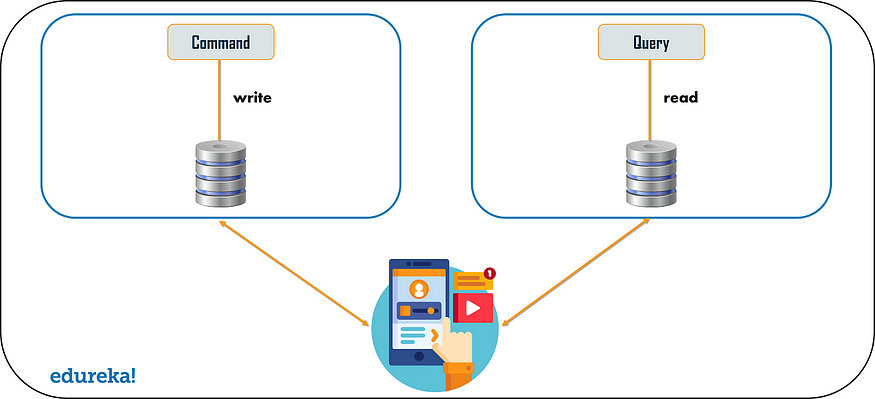

断路器模式

顾名思义,断路器设计模式用于在服务不工作时停止请求和响应过程。因此,例如,假设客户端正在发送从多个服务检索数据的请求。但是,由于某些问题,其中一项服务已关闭。现在,您将面临主要两个问题:首先,由于客户端不知道某个特定服务已关闭,因此请求将不断发送到该服务。第二个问题是网络资源枯竭,性能低下,用户体验差。