云计算

云计算 intelligentx- 232 次浏览

AWS 平台

【AWS云】部署MERN堆栈应用在AWS上构建弹性三层体系结构

QQ群

视频号

微信

微信公众号

知识星球

👋 介绍

大家好,我叫安基特·乔达尼。我是DevOps和Cloud的爱好者。我最近刚从大学毕业,在DevOps和云计算领域建立了自己的职业生涯。我写了很多关于can和Devops的博客和项目,你可以在我的Hashnode个人资料Ankit Jodhani上看到这一点。事实上,我是Showwcase的新手。我正在考虑在Showwcase上发布下几个博客并分享知识。我要感谢皮尤什·萨奇德娃提供的宝贵指导。我参加了Blog-A-Thon-Unlocking the Power of Technical Writing,这是Showwcase与GrowIn社区合作组织的一项在线活动,我要感谢双方的这一惊人举措。所以这个博客是“blog-A-Thon”的一部分#博客马拉松#showwcase#growinconsunity

📚 提要

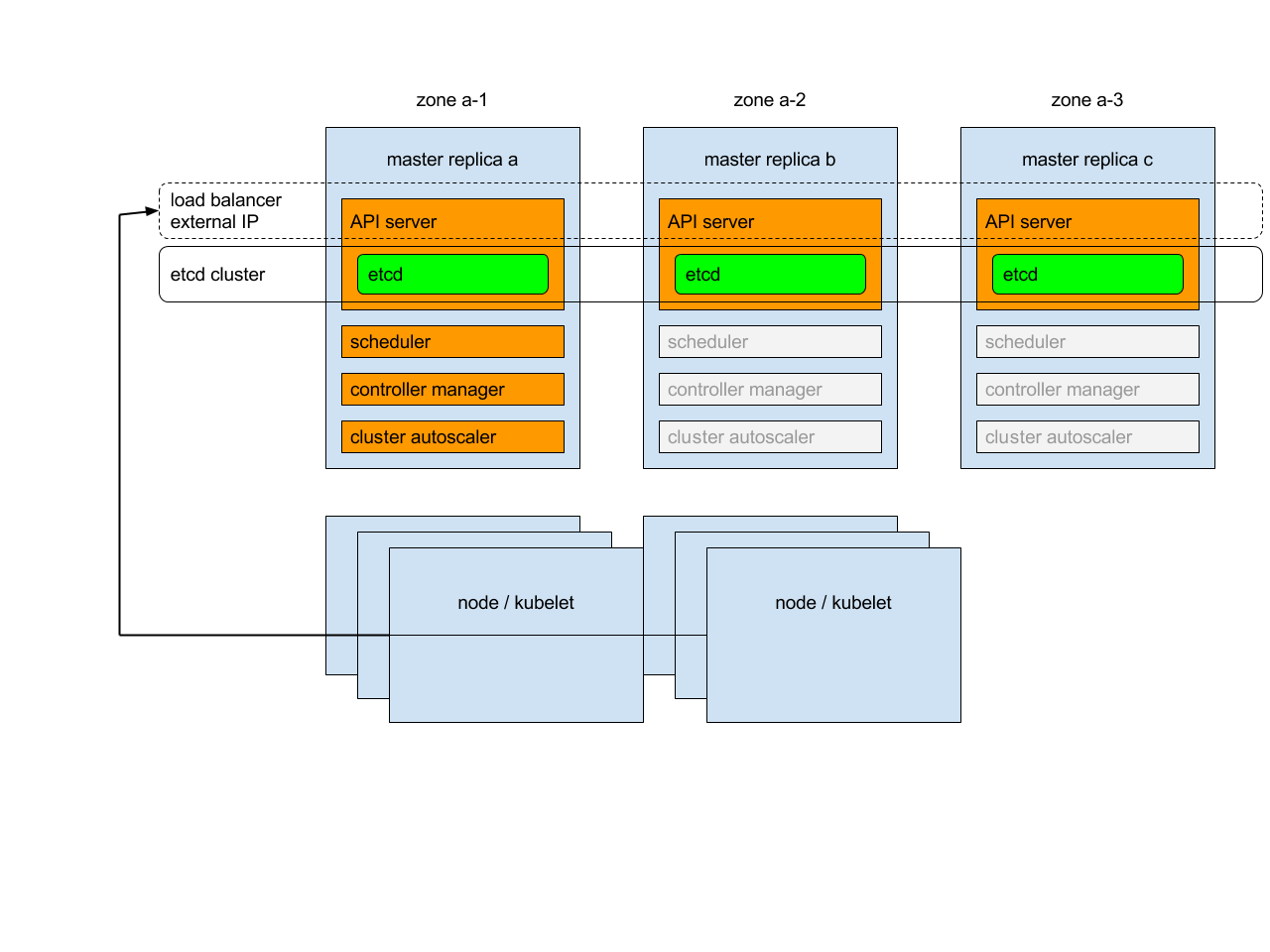

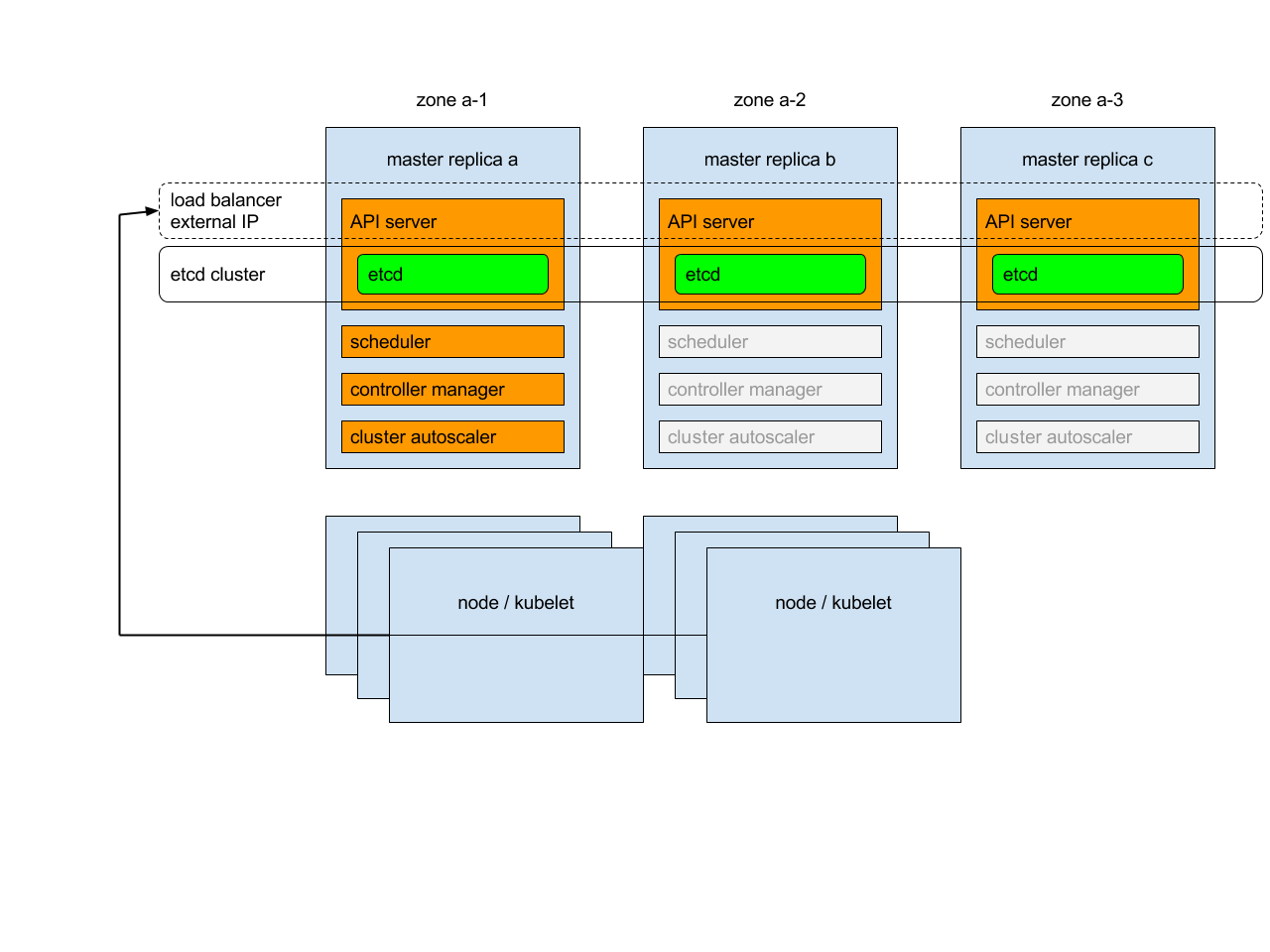

在这个博客中,我将向您展示我们如何构建弹性三层架构在AWS上部署MERN堆栈应用程序:实现高可扩展性、高可用性和容错。在这个项目中,我们将使用多区域部署,一个将是主要区域,另一个将用于灾难恢复。在这里,我们将遵循“温暖待机”灾难恢复策略。以便我们的用户在发生灾难时面临更低的停机时间。让我向你简要介绍一下这个项目。

🔹 故事

当用户请求网站时,DNS服务Route 53会处理该请求,并将其引导到为客户端提供服务的CDN(内容交付网络)CloudFront。如果CloudFront需要访问web服务器(前端),那么它会将请求路由到web服务器的应用程序负载均衡器,然后重定向到web服务器。成功接收静态页面后,客户端的浏览器可以对数据进行API调用。这些API调用通过路由53路由,路由53将它们发送到应用程序服务器(后端服务器)的ALB。ALB然后将请求引导到应用程序服务器,在那里处理数据。此外,应用服务器可以在RDS数据库中存储一些数据。并且我们的数据库仅由应用服务器访问。但我们部署基础设施的地方有可能因为某种灾难而瘫痪。在这种情况下,CloudFront将为web轮胎进行故障转移,Route 53将为应用轮胎进行故障切换。并且两者都开始利用DR区域的资源。这就是我们实现弹性的方式。如果你没有一个想法,那么不要担心,一旦你看到了架构,它就会很容易。

我将使用AWS云,但你可以使用任何你喜欢的云。或多或少的步骤将是相似的。

📋 先决条件

- 📌 AWS帐户

- 📌 Linux基础知识

AWS服务列表

- 🌍 亚马逊CloudFront

- 🌐 亚马逊路线53

- 💻 亚马逊EC2

- ⚖️ 亚马逊自动缩放

- 🪪 亚马逊证书管理员

- 🪣 亚马逊备份服务

- 🗄️ 关系数据库服务

- ☁️ 亚马逊专有网络

- 🔐 亚马逊WAF

- 👁️ 亚马逊CloudWatch

💡 执行计划

- 🤔 什么是三胎结构

- 🏠 项目的架构

- 🚀 带屏幕截图的分步指南

- 🧪 测试

- 🧼 资源清理

- 🥳 结论

🤔 什么是三胎架构

三层体系结构是一种将应用程序分为三层的软件体系结构模式。

🔸表示层➡️ 处理用户交互

🔸应用层(后端逻辑)➡️ 处理业务逻辑和数据处理

🔸数据层(数据库)➡️ 管理数据存储和检索

每一层都有不同的职责,允许模块化、可扩展性和可维护性。该体系结构促进了关注点的分离,并便于在不影响其他层的情况下轻松更新或修改特定层。

🏠 项目架构

让我们看看今天项目的架构。我们将遵循一种目标驱动的方法,这有助于我们付出最小的努力,并取得很多成果。了解我们将要构建的内容并了解您可以遵循以下体系结构是非常重要的。我请求你看一遍。它在构建这个项目时帮了你很多忙。

我花了几个小时创建了这个下面的动画架构,如果你喜欢,请喜欢我的博客,并在LinkedIn上关注我。

这里没有动画的建筑设计

🚀分步指南

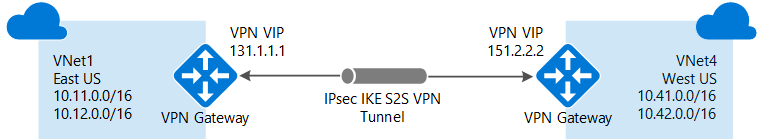

我们正在遵循“热备用”灾难恢复策略,因此我们将在部署期间使用两个区域。美国东部-1 AKA北弗吉尼亚州为初级,美国西部-2 AKA俄勒冈州为次级或DR。

🔹 虚拟专用计算机

首先,我们将在这两个地区建立专有网络,将我们的资源与互联网隔离开来。下图包含所有子网、它们的IP范围及其用途。如果你有更好的想法,你可以使用自己的专有网络设置。如果你是初学者,请创建VPC,如下所示。

- 18 次浏览

【云治理】亚马逊计算服务水平协议

此亚马逊计算服务水平协议(此“SLA”)是一项政策,规定您或您所代表的实体(“您”)根据AWS客户协议的条款使用包含的产品和服务(下面列出)( Amazon Web Services,Inc。与其关联公司(“AWS”,“我们”或“我们”)与您之间的“AWS协议”)。此SLA使用包含的产品和服务单独应用于每个帐户。除非本协议另有规定,否则本SLA受AWS协议条款的约束,资本化条款具有AWS协议中规定的含义。我们保留根据AWS协议更改本SLA条款的权利。

包含的产品和服务

- 亚马逊弹性计算云(Amazon EC2)

- 亚马逊弹性块商店(Amazon EBS)

- 亚马逊弹性容器服务(Amazon ECS)

- 适用于Amazon ECS的Amazon Fargate(亚马逊Fargate)

服务承诺

AWS将使用商业上合理的努力使每个可用的包含产品和服务具有至少99.99%的每月正常运行时间百分比(在下面定义),在每种情况下,在任何月度计费周期(“服务承诺”)期间。如果任何包含的产品和服务不符合服务承诺,您将有资格获得如下所述的服务积分。

定义

“每月正常运行时间百分比”是通过从100%中减去任何包含的产品和服务(如果适用)处于“区域不可用”状态的月份的百分比来计算的。每月正常运行时间百分比测量不包括直接导致的停机时间或间接来自任何Amazon Compute Services SLA排除(定义如下)。

“可用区(Availability Zone)”和“AZ”表示由区域代码后面的字母标识符标识的区域内的隔离位置(例如,us-west-1a)。

“区域不可用(Region Unavailable”)”和“区域不可用(Region Unavailability)”是指:

对于只有一个AZ的区域(Regions),当您运行实例或任务(一个或多个容器)的任何其他区域中的AZ和一个AZ(如果适用)同时对您“不可用”。

对于所有其他区域,当您运行实例或任务(一个或多个容器)的同一区域中的多个AZ(如果适用)同时对您“不可用”。

“不可用”和“不可用”是指:

对于Amazon EC2,Amazon ECS或Amazon Fargate,当所有正在运行的实例或正在运行的任务(如果适用)没有外部连接时。

对于Amazon EBS,当所有连接的卷执行零读写IO时,队列中有待处理的IO。

“服务信用”是按照下面的规定计算的美元信用额度,我们可以将其退回到符合条件的帐户。

服务承诺和服务积分

服务积分计算为您支付的总费用的百分比(不包括一次性付款,例如为预留实例支付的预付款),适用于Amazon EC2或Amazon EBS(以两者中不可用,或两者均为不可用)受月度结算周期影响的区域,其中区域不可用性按照以下时间表发生。

每月正常运行时间百分比 服务信用百分比

小于99.99%但等于或大于99.0%10%

低于99.0%30%

我们将仅针对未来的Amazon EC2或Amazon EBS付款应用任何服务积分。我们可以自行决定向您用于支付不可用性的结算周期的信用卡发放服务积分。服务积分不会使您获得AWS的任何退款或其他付款。仅当适用的每月结算周期的信用额度大于1美元(1美元)时,服务信用将适用并发布。服务积分不得转让或应用于任何其他帐户。除非AWS协议另有规定,否则我们对提供Amazon EC2或Amazon EBS的任何不可用,不履行或其他失败的唯一和排他性补救措施是,根据以下条款获得服务积分(如果符合条件)这个SLA。

信用申请和付款程序

要获得服务积分,您必须通过在AWS Support Center中打开案例来提交索赔。要符合资格,我们必须在事件发生后的第二个结算周期结束时收到信用申请,并且必须包括:

主题行中的“SLA信用请求”字样;

您声明的每个不可用事件的日期和时间;

受影响的EC2实例ID或受影响的EBS卷ID;和

您的请求记录记录错误并确认您声称的中断(这些日志中的任何机密或敏感信息应删除或替换为星号)。

如果此类请求的每月正常运行时间百分比由我们确认且小于服务承诺,那么我们将在您的请求得到确认的月份之后的一个结算周期内向您发放服务积分

区域和可用区概念

每一个区域都是完全独立的。每个可用区都是独立的,但区域内的可用区通过低延迟链接相连。下图阐明了区域和可用区之间的关系。

Amazon EC2 资源要么具有全球性,要么与区域或可用区相关联。有关更多信息,请参阅 资源位置。

区域

每个 Amazon EC2 区域都被设计为与其他 Amazon EC2 区域完全隔离。这可实现最大程度的容错能力和稳定性。

当您查看您的资源时,您只会看到与您指定的区域关联的资源。这是因为区域间彼此隔离,而且我们不会自动跨区域复制资源。

当您启动实例时,必须选择位于同一地区的 AMI。如果 AMI 在其他区域,您可将该 AMI 复制到您使用的区域。有关更多信息,请参阅 复制 AMI。

请注意,在区域之间传输数据需要收费。有关更多信息,请参阅 Amazon EC2 定价 - 数据传输。

可用区

当您启动实例时,您可以自己选择一个可用区或让我们为您选择。如果您的实例分布在多个可用区且其中的某个实例发生故障,则您可对您的应用程序进行相应设计,以使另一可用区中的实例可代为处理相关请求。

您也可使用弹性 IP 地址来掩蔽某个可用区中的实例所发生的故障,方法是快速将该地址重新映射到另一可用区中的实例。有关更多信息,请参阅 弹性 IP 地址。

可用区由区域代码后跟一个字母标识符表示;例如,us-east-1a。为确保资源分配到区域的各可用区,我们将可用区独立映射到每个账户的标识符。例如,您的可用区 us-east-1a 与其他账户的可用区 us-east-1a 所表示的可能不是同一个位置。您无法在不同账户之间协调可用区。

随着可用区中内容的增加,我们对其进行扩展的能力会逐渐受限。如果发生此情况,我们可能会阻止您在扩展能力受限的可用区内启动实例,除非您在此可用区中已拥有实例。最终,我们还可能将扩展能力受限的可用区从新客户的可用区列表中删除。因此,您的不同账户在一个区域中可用的可用区数量可能不同。

您可以列出您的账户可用的可用区。有关更多信息,请参阅 描述您的区域和可用区。

可用区

您的账户会确定适用于您的地区。例如:

- AWS 账户提供多个区域,因此您可在满足您要求的位置启动 Amazon EC2 实例。例如,您可能希望在欧洲区域启动实例以更多符合欧洲客户的要求或满足法律要求。

- 您只能通过AWS GovCloud(美国)账户访问AWS GovCloud(美国)区域。有关更多信息,请参阅AWS GovCloud(美国)区域。

- 您只能通过 Amazon AWS (中国) 账户访问中国(北京)区域。

下表列出的是 AWS 账户提供的地区。您不能通过 AWS 账户描述或访问其他区域,例如AWS GovCloud(美国)或中国(北京)。

代码名称us-east-1

美国东部(弗吉尼亚北部)

us-east-2

美国东部(俄亥俄州)

us-west-1

美国西部(加利福尼亚北部)

us-west-2

美国西部(俄勒冈)

ca-central-1

加拿大 (中部)

eu-central-1

欧洲(法兰克福)

eu-west-1

欧洲(爱尔兰)

eu-west-2

欧洲 (伦敦)

eu-west-3

欧洲 (巴黎)

ap-northeast-1

亚太区域(东京)

ap-northeast-2

亚太区域(首尔)

ap-northeast-3

亚太区域 (大阪当地)

ap-southeast-1

亚太区域(新加坡)

ap-southeast-2

亚太区域(悉尼)

ap-south-1

亚太地区(孟买)

sa-east-1

南美洲(圣保罗)

有关更多信息,请参阅 AWS 全球基础设施。

每个区域的可用区的数量和映射可能因 AWS 账户不同而异。要获取可用于您的账户的可用区列表,您可以使用 Amazon EC2 控制台或命令行界面。有关更多信息,请参阅 描述您的区域和可用区。

- 55 次浏览

SaaS云

- 30 次浏览

【SaaS云】SaaS洞察(01):为什么在SaaS市场我选择美国而不是中国?

本文是“洞察:SaaS”系列文章之一,是该系列的第一篇文章。

很多朋友问我为什么不在中国创办 SaaS 公司。中国是一个大市场,你是中国人。在中国,你知道如何经营企业,如何适应当地文化。在中国创业有很多好处。

长期以来,全世界都习惯于从硅谷抄袭。美国硅谷一直走在全球科技潮流的前沿。来自世界各地的人们来到美国学习新技术和商业模式,然后在自己的国家实施。然而,随着世界变得更加全球化,越来越多的科技公司在亚洲和欧洲如雨后春笋般涌现,许多外国人将在美国开展业务以进行全球竞争。如果公司的产品好,应该可以在最大的市场上竞争。

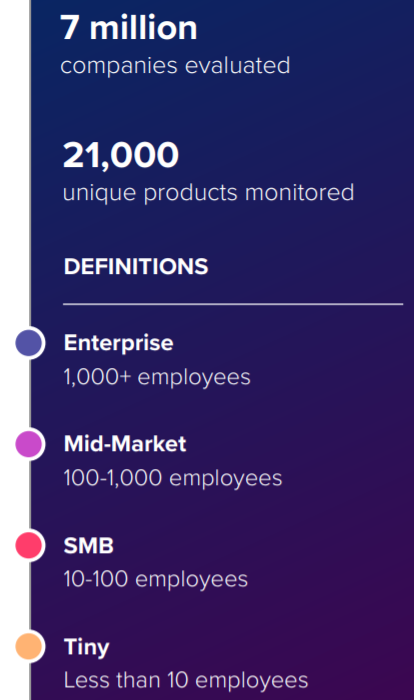

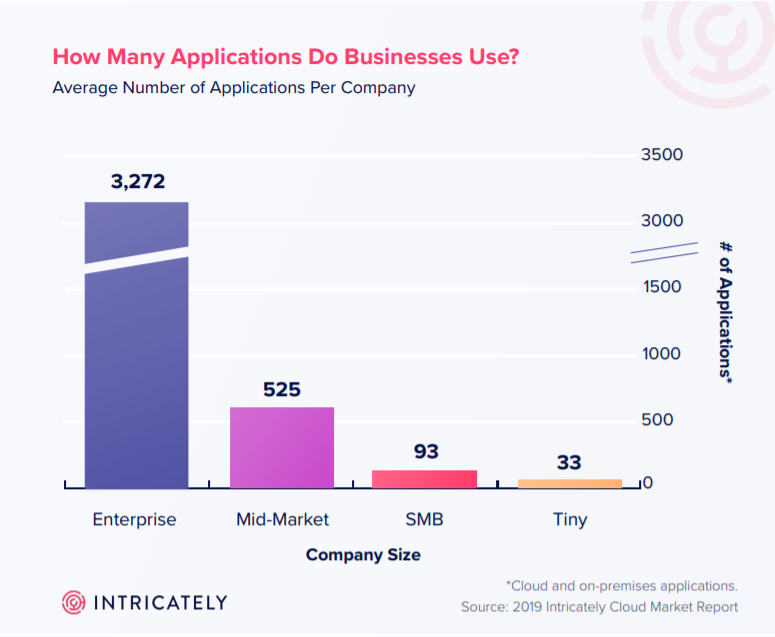

1、美国的SaaS市场是中国的10倍。

Salesforce、Zoom、Slack、ServiceNow、Zendesk、Mailchimp、WorkDay 和 Twilio 只是美国 SaaS 公司的几个例子。他们的市值超过 200 亿美元,年收入超过 10 亿美元。在中国,没有 10 亿年 ARR 的 SaaS 公司。中国和美国在SaaS市场上的差距是十倍以上。尽管越来越多的中国VC投资SaaS行业,但中国VC市场对SaaS的整体接受度远低于美国市场。

不是中国风投不了解SaaS,而是只是中国SaaS公司还没有给出满意的答案。这很大程度上是中美企业在客观服务市场上的差距造成的。鉴于许多中国 SaaS 公司自称是中国的 Salesforce 和中国的 Slack,它们的表现却不尽如人意。为了评估未来趋势,风险投资家需要数据而不是故事。中国有 3,000 家 SaaS 公司可以在互联网上找到,另外还有 4,000 到 6,000 家可能从数据中丢失。典型场景是客户流失率高,收支不平衡,营销能力不足。

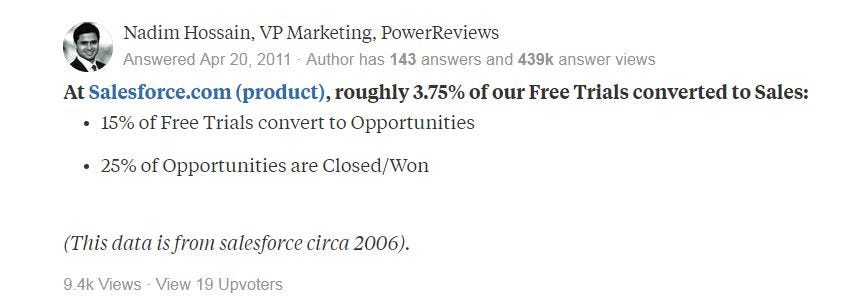

2、美国客户的支付习惯远超中国。

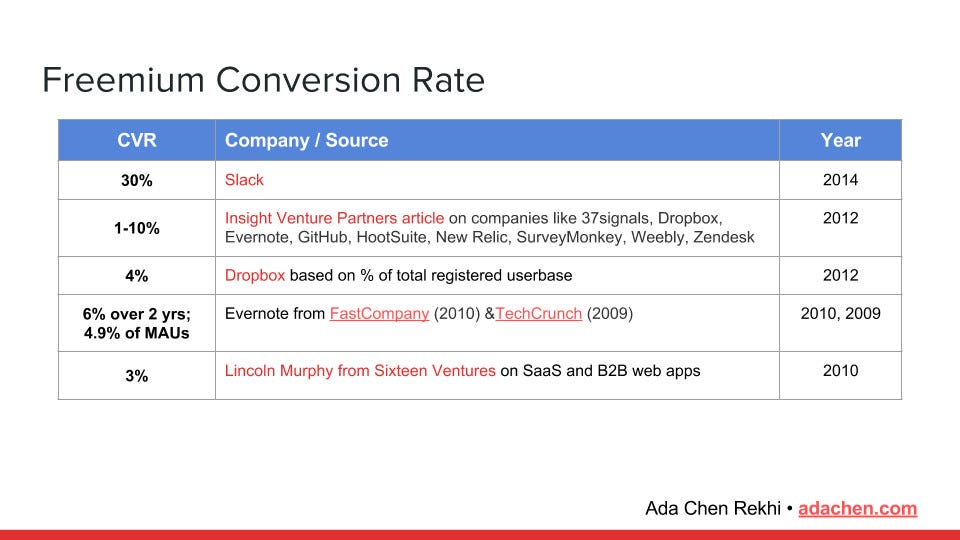

美国的公司愿意在 SaaS 上花钱,因为他们相信它可以帮助他们解决问题并提高效率。 此外,在过去十年中,这种支付意愿逐渐增加。 2006 年,Salesforce 的 Free Trail 只有 3.75% 转化为销售额。免费试用的转化率已达到 10-30%,与今天的同级别产品相比。 卓越的公司可以达到 50% 的成功率。 当前的中国市场类似于 2006 年的美国市场。中国企业不习惯为软件即服务付费。 教育市场需要很长时间。

这里有些例子:

免费增值和免费试用转换基准:

SaaS提高了美国公司的业务运营效率。如果你能给我带来 10% 的低效率提升,我愿意支付一大笔费用。另一方面,中国和其他新兴市场的许多公司尚未达到微调业务的阶段。您可以间接带来的收入金额对企业主很重要。因为很多SaaS工具都无法解决这个问题,所以企业不愿意为SaaS买单。

另一方面,必须承认,中国SaaS公司生产的产品远少于美国公司。许多产品在其官网上缺乏透明的价目表和大量的演示请求。没有文档或任何开放的 API。试用产品需要很长时间,最终使用它时没有AHA时刻。为什么客户愿意付款?很多SaaS产品没有差异化竞争,只能用低成本的策略打败它们。整个行业的健康状况不佳。

3、美国市场一般接受在线支付和自下而上的购买。

由于产品介绍、常见问题解答和企业网站上的文档,客户在联系您之前通常会进行很长时间的自我教育。与通过联系销售获取信息相比,客户更有可能自行获取信息。客户通过使用免费版本和试用版来决定是否订购 SaaS 产品,而且购买的决策者通常是公司员工,而不是 CEO/CIO。当组织中的大量人员使用您的 SaaS 并且它在他们的工作流程中变得根深蒂固时,他们升级到更高级的版本是有意义的。 Slack 的设计初衷是供团队成员使用,然后逐渐供整个公司使用。

Product-Led Growth的SaaS产品往往脱颖而出,客户能感受到产品的价值。 SaaS公司必须不断改进他们的产品才能吸引更多的客户。推动公司增长的是产品,而不是销售。这是国际业务的理想选择。在上海,我也可以发展。如果每个客户都必须触摸 FAE 才能购买,我作为外国人不适合我。

基于上述原因,我选择美国作为 Kiwicode 的目标市场。我从不谈论做一家中国大公司;相反,我强调专注于建立一家优秀的全球公司的重要性。

下一篇文章《洞察:SaaS(2)SaaS是一种商业模式》发表。如果您喜欢我的文章,请给我鼓掌和反馈。

原文:https://medium.com/kiwicode/insight-saas-1-why-do-i-choose-the-us-over-…

- 36 次浏览

【SaaS云】SaaS洞察(02) : SaaS是一种商业模式

本文是“洞察:SaaS”系列文章之一,您可以阅读上一篇文章“洞察:SaaS(1)SaaS市场我为什么选择美国而不是中国?”。

SaaS 是 Software as a Service 的缩写。近年来,许多SaaS公司已经变得众所周知。许多企业家也开始了自己的 SaaS 业务。互联网上有无数文章解释了 SaaS 的好处。您可以自行查找。本文将解释为什么 SaaS 是一种成功的商业模式,为什么它是神奇的,以及为什么 XaaS(任何即服务)尚未获得关注。

首先,SaaS 有两个基本组件:

- 经常性收入

- 软件

请注意,缺少任何部分都不是可行的商业模式。

1. 经常性收入

SaaS公司向客户收取订阅费用,不是一次性的大笔费用,而是少量的经常性费用。客户可以选择按月或按年付款。

78代表SaaS公司商业模式的持续收益。假设您在一月份获得了第一位客户,他每月向您支付 1 美元。如果你在第二个月继续工作并获得一个新客户,那么你二月份的收入将是 2 美元,其中包括第一个月的老客户以及二月份获得的新客户。以此类推,如果你每个月都能找到一个稳定的客户,并且每个月都没有失去客户,那么你的年收入为:

这就是持续收入的魅力,以及它的可预测性。 因为SaaS产品的价格往往是买断产品的十分之一,并且允许客户随时取消订阅计划,因此获客周期更短,每个月获客的新客户数量是可预测的。 这就是为什么资本市场更喜欢 SaaS 公司的原因,因为他们的收入有庞大的客户群支持,而且他们的收益和增长是可预测的。

我们在这里假设一个完美的场景,其中客户续订率为 100%; 如果是 90%,则情况看起来不太好。

假设每年新的可持续收入每年增长20%,但老客户保留率只有90%。

这意味着 SaaS 公司的增长率与传统公司相近,年收入增长 20%。 老客户留不住,公司的增长速度主要取决于新客户的获取速度。 SaaS 业务的魔力已经消退。

SaaS公司采取允许保留客户支付更多费用以抵消客户损失的方法。 SaaS 提供更好的产品,帮助客户实现目标,并允许客户升级他们的计划或购买新的交叉产品。

如果 Net Dollar Retention(NRR) > 0,则增加的购买部分大于损失部分,假设 NRR 为 5%:

相比较而言,20%的增长率的公司很普通,优秀的SaaS公司的净美元留存率可以达到120%。

2. SaaS 商业模式严重依赖软件。

就成本而言,即使是 SaaS 模式也不是那么健康。 客户获取成本 (CAC) 现在逐季上升,发现许多 SaaS 企业很难实现收支平衡。 鉴于软件的边际成本在逐渐下降,如果SaaS演进成XaaS,Anything as a Service,拥有大量留存客户,成本会随着MRR的增长而上升,如下图所示:

留住客户将导致收入和成本增加。除了软件,只有边际成本较低的产品才能作为服务+。并非一切都可以变成 XaaS。

SaaS 收取传统软件 10% 到 20% 的费用,以换取稳定且可预测的收入流。如果为商品 X 增加一项服务,也需要大幅降价; X的毛利率一定非常高。否则,无法保证公司的长期发展。 SaaS产品的毛利率在80%左右。如果 X 的商品毛利率可以忽略不计,大幅降价将导致订阅收入的可预测损失。

随着经常性收入百分比的增长,SaaS 公司的价值更高。

考虑两家公司:一家是通用软件公司A,另一家是SaaS公司B。

为客户定制软件的一次性费用是 A 的主要收入来源,而 SaaS 产品的订阅收入是 B 的。 A公司必须根据客户的增加比例增加工程师和AM的数量。管理成本和获取客户的能力都受到考验。与A公司相比,B公司的获客能力和获客效率更胜一筹。获客能力更容易标准化培训,因为B是标准化的SaaS产品,可以批量获客,以更少的CAC投入获得更多的客户。这就是为什么拥有经常性收入来源比拥有零星收入来源更可取的原因。

下一篇《洞察:SaaS(3) SaaS的核心指标——NDR》发表。如果您喜欢我的文章,只需给我一些掌声和反馈。

原文:https://medium.com/kiwicode/insight-saas-2-saas-is-a-business-model-45d…

- 21 次浏览

【SaaS云】SaaS洞察(14) : SaaS的护城河

我们在上一篇文章《洞察:SaaS(13)入站销售和内容营销》中介绍了为什么 SaaS 产品应该优先考虑入站销售和内容营销。 SaaS产品的护城河是什么,SaaS产品的护城河不是什么?

许多商业专家对“公司护城河”一词有自己的定义和示例。我现在不打算详细说明它们。护城河的简单概念是阻止您的竞争对手与您有效竞争的障碍,从而使您获得竞争优势。这道屏障就是公司的护城河。投资者经常询问护城河。设置壁垒的公司不太可能面临竞争,从而降低了投资风险。事实上,没有完美的护城河。除了答案之外,投资者在提出这个问题时,还会关注企业家的心态、行业经验以及对竞争的看法。

SaaS行业有一定的进入门槛,但并不是特别高,竞争也很激烈。对于希望提高公司竞争力的 SaaS 企业家来说,建立自己的护城河至关重要。除了其行业和专业服务部门外,每家 SaaS 公司都将拥有自己的一套护城河。例如,中国的地方政府将监督当地产业的发展。一个区域是由同一行业的集中度来规划的。例如,广东将专注于电子设备。与当地政府部门建立稳固的关系是电子设备制造SaaS的护城河。我们将介绍的第二个主题是通用 Moat,它可广泛用于大多数 SaaS。

什么不是 SaaS 公司 Moat?

1. 研究与技术

许多组织的护城河是他们的“深度技术”和“研究”能力。这只是你团队的优势和优势,不是护城河的。没有任何技术可以由一个团队掌握。这不是护城河,无论你的团队中有多少所谓的科学家和技术人员。其他企业也可以组建一支称职的技术团队。没有可量化的基准来确定某人是否具有出色的技术能力。使用适当的技术来解决客户问题是 SaaS 的全部意义所在。这个想法是使技术适应现场。比纯技术更有价值的是知道如何使用它来提高业务能力。大型组织在科学研究技能方面总是优于小型企业。他们拥有更多的人才,但并非所有大公司都有垄断所有市场的技术能力。因此,无论是技术还是研究都不会成为 SaaS 公司的护城河。

2.先发优势

具有先发优势的SaaS企业可以及早抢占市场份额。您可能会通过在其他人之前推出产品而获得优势,但不能保证您将是第一个到达终点的人。 SaaS市场是一个2B市场。这个市场以其不断培养和获取客户而闻名。在短时间内,没有任何 SaaS 业务可以主宰所有市场。即便是在CRM、BPM、HR等拥有明确领导者的成熟市场,后发者也能稳步赢得客户。客户会购买您的产品,然后离开。暂时的成功不是一切,也不是护城河。

3. 新颖的营销和销售渠道

如果一家 SaaS 公司吹嘘它有一种新的获取客户的方式,而且这种方式是绝对保密的,而且没有其他人知道,那他肯定是在撒谎。获客法是最容易模仿跟进策略的策略。如果公司的客户获取方法有效,竞争对手将立即复制。改变产品需要很长时间,但营销却不会。吸引客户的手段也不是 SaaS 公司的护城河。

4. 更加努力

许多创始人会声称他们工作非常努力,他们的团队非常具有创业精神。但是,总会有人比你更努力。虽然努力工作是必不可少的,但如果你声称这是护城河,那你就是在误导自己。对于SaaS业务来说,选择比艰辛更重要,认知比辛劳更重要。如果努力工作能保证成功,那么有人会每周工作 7 天,每天工作 16 小时。谁不睡觉,谁就赢了。这显然是对事实的歪曲。努力工作显然不是 Moat 的作风。

什么可以变成 SaaS 护城河?

1.网络效应。

护城河的一个突出例子是网络效应。 Facebook 已经根据人们的联系创建了自己的护城河。提供软件即服务 (SaaS) 的公司与社交媒体公司不同,因为很难找到基于强大连接的解决方案。但是,我们可以稍微改变一下观点:SaaS 使用得越频繁,对客户的价值就越高。这是可行的。 DocuSign 就是一个很好的例子。使用 Docusign 的公司越多,其产品的价值就越大。如果客户 A 要求签订使用 Docusign 的合同,合作伙伴 B 可以使用该产品。如果客户 A 的所有未来客户都使用 Docusign,Docusign 非常有价值。

如果SaaS为上下游企业提供交易平台,既定的护城河就可以得到改善。例如,Wix 等许多 Web 制作公司拥有大量生产 Wix 模板的供应商。供应商越多,客户购买的可能性就越大,付费客户越多,供应商就越多。这种双边集团的价值随着交易量的增长而同步上升,也是网络效应的一种变体表现。

2. 持续的品牌发展。

品牌的力量,尤其是对于 SaaS 企业而言,是巨大的。知名的 SaaS 更容易吸引客户。在产品功能相似的基础上,以品牌为主导的可以吸引更多的客户,而强大的品牌可以帮助您筑起护城河。另一方面,品牌建设是一个长期的过程,SaaS公司如果没有持续的投入,很难建立强大的品牌。

3.重置成本。

重置成本可能是任何 SaaS 业务最关键的护城河。通过出色的用户体验和持续的成功使用,SaaS 提供商可以显着提高客户的更换成本。客户会担心切换到新的供应商是否会产生类似的结果,以及他们是否会承担大量的学习费用。对抗竞争最有力的保障是提升您的产品体验。竞争对手必须超越你才能取代你。

增加产品更换成本是大多数 SaaS 组织可用的一种选择。

几年之内,每家公司都将更换其购买的 SaaS 产品。

只有当更换的好处超过更换的费用时,才会进行更换。

如何提高自己的防守能力?

对于 SaaS 组织而言,数据是增加更换成本的关键方式。由您的 SaaS 产品创建的客户数据是一项宝贵的资产。通过充分利用这些数据来增加更换成本,为客户提供更大的价值。例如,CRM 可以存储公司的所有客户和交易数据。如果更改 CRM 提供商,此信息将丢失。大多数企业认为这是不可接受的。 CRM 公司也可以根据这些信息提供营销优化解决方案。这是公司在没有数据的情况下无法提供的服务,而 Moat 也可以使用。

用户行为是替代价格上涨的一种被忽视的方式。您必须了解用户的习惯。例如,您的客户是否经常使用 PC 或手机登录您的产品?什么是最流行的浏览器和操作系统?您已经针对他们的需求优化了您的产品。客户会发现它易于使用,并且不会考虑更换 SaaS。这有效地消除了更换的可能性。

以客户为中心,不断满足新需求。客户的要求总是在变化。 15年前营销产品必须针对电子邮件营销,但现在它们必须与社交媒体营销抗衡。客户过去需要外呼呼叫中心,但现在他们需要电话机器人。市场每十年就会不断创新。为了留住客户,您必须随时了解市场变化并继续满足新客户的需求。

如果你声称你的市场竞争者不多,你不需要考虑如何建立护城河,那么你可能面临一个更困难的问题:你可能没有竞争,因为你的市场是' t值得竞争对手与你竞争。

下一篇文章《洞察:SaaS(15)SaaS为什么需要用户体验?》发表。如果您喜欢我的文章,只需给我一些掌声和反馈。

原文:https://medium.com/kiwicode/insight-saas-14-the-moat-of-saas-c931a3af05…

- 15 次浏览

【SaaS云】SaaS洞察(17) : 低代码或无代码不是未来

我们在上一篇文章“洞察:SaaS (16) PaaS”中讨论了 PaaS;今晚,我们将讨论流行的低代码和无代码。

低代码和无代码平台是可以用很少或没有代码构建应用程序的地方。用户可以通过拖放快速创建定制应用程序。用户生成的界面或业务流程在这些Low Code和No Code平台中都会被转换成固定的代码组合,这些组合会有预定的转换算法。这肯定会延长开发时间,但它有许多难以克服的问题,所以我并不乐观地认为 Low Code 或 No Code 将成为编程的可行替代方案。

1. Low Code 或 No Code 有一个明确的限制,即缺乏强大的表达能力。

如果你想完全取代计算机语言作为编写程序的一种方式,你需要同等水平的表达能力,这对于那些拖动图形的人来说是无法实现的。我想用一个非常简单的场景作为例子。该应用程序包含两个组件:一个开关和一个按钮。当开关打开时,按钮是蓝色的并且可以点击。当开关关闭时,按钮变为灰色,无法按下。

必须在编码中设置布尔变量。布尔值可以通过开关改变。当 bool 变量为 true 时,Button 变为蓝色并可点击。为false时变为灰色且不可点击。在低代码/无代码平台中,您很难通过拖放来完成此关键信息的输入。您可以轻松拖放蓝色按钮和灰色按钮,但不能将开关钩到按钮上。低代码/无代码平台隐藏了他们不希望您输入的信息。编程中的细节不缺;相反,它会自动替换。低码/无码使用方便,但灵活性受到严重限制。

亚历山大·伊尔格写道:

使用低代码,你是你使用的框架或工具的囚徒。

低代码和无代码可以解决某些场景中的问题。将游戏扩展到无限复杂的情况注定要失败。 Low Code / No Code 也可以灵活地解决客户问题,但受限于自身设定的边界。无法满足严格的定制要求。

2.黑匣子

所有低代码/无代码程序都类似于黑匣子。您无法影响其内部质量。当您使用某些平台的转换代码片段功能时,您会发现这些脚本不能简单地移植到您的项目中。本质上,低代码/无代码平台的可视化组件的所有代码都是直接从绘图转换而来的。工程师也不应该直接使用它。

使用低代码生成不符合既定最佳实践的代码可能会违反组织的合规措施。

而这种黑匣子还处于起步阶段。将一些有用的开源库添加到您的项目中几乎是不可能的。为了实现快速的拖放定制,Low Code / No Code 会与内部代码实现混为一谈,难以连接其他库。这是由于黑匣子的封闭性。你别无选择,只能接受;您不能参与更改其输出。

因此,以Low Code/No Code为核心定位的公司表现不是很好。它有几个缺陷:

- 您无法回答您可以解决哪个具体问题的问题,虽然看起来所有问题都可以解决,但没有问题可以完全解决。您可以智能地提供某些类似表单的应用程序或行业模板。例如,您可以轻松地为企业流程管理、库存管理和电子商务模板创建应用程序。 SaaS公司一旦专注于提升产品能力,也可以推出Low Code/No Code产品,你的获客能力一定无法与专业的SaaS竞争。

- 只能满足长尾小客户的肤浅需求。这些客户的支付意愿无法得到保证。无法满足长尾消费者的深度需求。您只能帮助他们进行演示,而不是真正的产品,因为低代码/无代码没有表现力。如果消费者要求并坚持接收代码,它将成为基于项目的业务。企业服务企业要把握客户的深层次需求,解决客户无法解决的关键问题。

- 没有护城河。有很多 Low Code / No Code 的竞争对手,不是因为市场大,而是因为进入门槛太低。目前可以使用用于拖放、流程管理和图形编程的开源库,例如 Scratch。任何人都可以快速构建低代码/无代码平台。在大多数情况下,No Code 平台的一般代码行数为 100,000 行(包括所有库)。

- 低代码/无代码平台如果定位在数据和内部系统中,就不可能实现“产品标准化”。如果他们专注于解决组织内部的信息不流通和低效率,那么仅依赖低代码/无代码产品是不可能的。为了克服这一挑战,您需要人员发展和客户参与。由于Low Code/No Code无法完全解决定制化问题,只能依靠人工参与系统开发,需要获取客户数据权限和深度客户参与。项目总价值中低代码/无代码的比例随着项目的扩大而减少。可怜,只能用引流工具来形容。标准产品无法达到与定制产品相同的效果。 SaaS公司将增加定制项目的数量以获得订单。从 SaaS 转变为典型的软件开发公司。

只要问题在预定情况下得到解决,低代码/无代码仍然有价值。那么,什么样的公司需要 Low Code / No Code 开发呢?

SaaS公司的PaaS平台经常使用低代码/无代码。 SaaS公司的定位很明确:它旨在解决某种客户问题。这些 PaaS 是同一场景的自然扩展,无代码和低代码特别合适。

低代码是否有可能在未来解决表达性问题,而不像计算机语言看起来那样复杂?要以相同程度的信息实现这一目标,您必须开发一种不同于人类语言的新表达方式。

朋友们,如果你想开发低码/无码平台,请小心。

圣诞节快乐!下一篇文章《洞察:SaaS(18)SaaS的通用定价模型(第1部分)》发布。如果您喜欢我的文章,只需给我一些掌声和反馈。

原文:https://medium.com/kiwicode/insight-saas-17-low-code-or-no-code-is-not-…

- 88 次浏览

Salesforce

Salesforce诊断网络问题以排除性能下降

Knowledge :000213798

描述问题:

您或您的用户要么无法连接Salesforce,要么您的连接比正常速度慢得多。

这些问题可能是最难解决的,因为它们会使您的团队陷入停顿。

有时,它们可能是由一些看似无害的事情引起的,比如安装一个新的包、实现一个新的共享规则或启用一个特性。

然而,到目前为止,这些问题最常见的原因是您的用户和Salesforce应用程序之间的联系——Internet服务提供商(ISP)和网络。

ISP和网络问题将是本文的重点,其最终目标是为您提供有效地解决此类问题的工具,以推动快速的解决方案。

解决办法

故障排除:

1。检查Trust

在这些情况下,首先要做的是检查status.salesforce.com/status。在这个页面上,我们报告实例的可用性和性能问题。在上图中,如果我们与ISP合作解决任何网络问题,我们也会偶尔发布一般的状态信息。

2。问你的同事。

检查你的整个团队是否也正在经历同样的绩效水平,他们是否已经找到了缓解的方法。例如,您总是使用硬线连接,但是您有一个使用WiFi的同事,他们没有遇到这个问题。此外,如果您的公司有多个办公室或远程员工,请尝试与他们核实——他们看到更好的表现了吗?您的团队在所有的组织(包括沙箱)中都有相同的性能体验吗?如果这些场景中的任何一种都适用于此问题,那么您很可能遇到的是网络问题,而不是Salesforce特有的问题。

3. 运行Ping到Salesforce

从基于Windows系统的系统点击开始按钮,在搜索栏中键入“cmd”。顶部的结果应该是一个名为“cmd”的条目——点击这个。在生成的控制台窗口中,键入

ping - n 100(实例).salesforce.com

你的具体实例在哪里?例如:如果你在na5上,它会在哪里

ping - n 100 na5.salesforce.com。

您将开始看到在屏幕上运行的文本行。根据您到Salesforce的具体路线,这可能需要几分钟才能完成。这个结果的输出将类似于na17.salesforce.com的ping测试:

这些结果表明,当时我与指定的实例有很好的连接。误差的迹象包括:

包丢失大于10%(我的包显示为零丢失)

大量的往返时间。虽然时间之间的差异约为100ms是很常见的,但如果您的往返时间平均为105ms,最大为500ms,则表明您可能存在一些网络问题。

4。运行一个Traceroute到Salesforce

traceroute会告诉我们你的流量是如何到达Salesforce的。它还将有助于确定可能发生的问题。要运行traceroute,请返回命令提示符并输入

路径跟踪程序(实例).salesforce.com

下面是我跑到我们的北美实例NA17 (tracert na17.salesforce.com)的traceroute:

要阅读这篇文章,从第一行开始——这是你的流量离开你的电脑后的第一个停止。可能是10.X.X.X。或者是192.168.X.X 数量。这些都是为私有网络所保留的,在追踪器的后面也相当常见。在这条路线的后面,他们只是表示在退出之前,通信正在通过ISP的内部网络。

你看到的3个数字是到达特定跳点的时间。需要注意的是,这些数字并不代表当前跳转和前一个跳转之间的时间差异,而是代表该跳转之前的累计时间。当你观察一个traceroute时,你在寻找第一个点,在这个点上,时间之间的差异非常大(例如:50 ms 283 ms, 29 ms),或者对于那些始终比前一个跳高得多的时间。您也可以将“*”视为一个条目。这表明服务器没有收到回复。这些未必是问题的征兆,尤其是当你接触到Salesforce的时候。出于安全原因,某些网络不会对traceroutes中使用的包进行应答。一旦进入数据中心,Salesforce也会这样做。如果您看到一个跳有一个超时,那么只要事情看起来正常,这可能不是问题。需要注意的是,您的“正常”traceroute和ping结果将根据您的系统和数据中心的地理位置而变化。例如,如果你在澳大利亚,正在连接美国东部的数据中心,250-300ms的往返时间并不是不寻常的。然而,从澳大利亚到东京数据中心的300毫秒的往返时间是不寻常的。

5。查找奇怪的路由决策和节点特定的问题。

ISP经常更新他们的网络,比如调整路由选择和增加新线路。他们这样做是为了保持网络的健康,并试图优化某些流量模式。有时,这些更改可以通过不太理想的路径将请求路由到Salesforce。例如,如果您正在从加州访问一个基于北美的Salesforce实例,但是正在通过新加坡进行路由,然后返回应用程序,那么您肯定会看到加载时间增加。这将在ping和traceroute的结果中显示为一致的高往返时间,+300 ms,每个跳的时间之间的差异很小,并且接近0个包丢失。您还可以看到在一跳的跨度中有两个100ms以上的大跳转。这是洲际跳跃(intercontinental hop)的典型行为,或者你的交通跨越了显著的地理距离。

如果你是建立在同一地区数据中心(APXX纳克萨玛斯实例的北美,亚洲,欧洲/非洲EUXX)和你碰巧注意到一个大跳在你的路由跟踪,你可以去[IP地址].ipaddress.com找到特效IP地址的地理位置跳在哪里发生。

如果您注意到这类问题,请联系您的ISP,因为他们控制您的请求到Salesforce的路径。

另一个网络路由问题的例子如下:

在这个traceroute中,我们可以看到5 个* ' s在第6和第7行。我们可以看到的另一件事是,第5和第7行都属于第3级通信公司,我们正在跨大西洋航行。因为这是一次横跨大西洋的跳跃,我们不需要担心时间增加了大约75毫秒。我们应该关注的是,我们的跨大西洋的跳跃是不一致的。如果这与第3步中的ping绑定,您可能会看到包丢失。在这种情况下,你应该联系你的ISP,让他们知道你找到了什么。您的ISP应该能够修改您的流量使用不同的跨大西洋链接的路径,或者至少联系他们的合作伙伴(本例为第3级)以进一步研究这个问题。

6。联系销售团队支持

如果您仍然无法确定任何网络问题,请将您使用上述步骤收集的所有信息发送给Salesforce support。我们将密切关注您的组织,并与我们的网络运营团队进行评估。

- 26 次浏览

【Salesforce 】Force.com中的应用程序性能分析指南

在本指南中,您可以了解Force.com的性能分析工具及其相关的方法,这些工具是通过来自salesforce.com客户支持和我们自己的工程团队的建议了解的。例如,在使用功能单元测试来验证您的应用程序是否按设计工作时,salesforce.com建议使用性能分析,这样您的应用程序就可以处理数据量和复杂的共享配置,这些配置可能随组织的大小和成功而增长。如果您是Force.com的架构师或开发人员,或者是经验丰富的Salesforce管理员,那么这些技巧可以帮助您正确地编写应用程序代码,并使其为用户提供的价值最大化。

注意:本指南适用于具有编程顶点和Visualforce经验,并对Force.com多租户体系结构有基本了解的读者。

性能分析工具和资源的概述

我们鼓励您熟悉这些性能分析工具和资源,使用这些简短的描述和与上述描述的链接相关的更全面的资源。

开发人员控制台

开发人员控制台是您可以用来在Salesforce组织中创建、调试和测试应用程序的工具的集合。Developer Console提供了许多用于分析性能的面板。根据详细的执行日志(您可以通过使用与logs选项卡关联的日志检查器来打开日志),您可以查看总体请求的图形时间线、操作的聚合性能、调控器限制的统计信息,以及对已执行单元的深入分析。在本指南中,我们使用Developer Console作为引导您完成性能分析过程的主要工具。

调试日志

调试日志记录执行事务时发生的数据库操作、系统进程和错误。每次用户执行包含在筛选条件中的事务时,系统都会为用户生成一个调试日志。可以调整每个日志包含的细节级别。虽然调试日志文件显示为纯文本,但是很难解释它们的原始日志行。本指南向您展示了如何使用开发人员控制台在性能分析时有效地分析这些行。

工作台

Workbench是一个强大的、基于web的工具套件,可以从开发人员社区获得。为管理员和开发人员设计的这个工具允许您在salesforce.com组织的Web浏览器界面中直接描述、查询、操作和迁移数据和元数据。Workbench还为Force.com api的测试和故障排除提供了许多高级特性。本指南使用Workbench演示如何轻松地通过API运行查询并获得性能分析所需的信息。

架构师核心资源

开发人员Force的架构核心资源页面是在Force.com平台上构建声音实现的最佳实践库。在这个页面上,您可以找到许多与性能优化相关的白皮书、网络研讨会和博客文章的链接。这些资源可以帮助您了解在对应用程序进行性能分析时应该寻找什么,以及如何应用最佳实践来克服与性能相关的挑战。对该内容的引用贯穿本指南。

性能分析:方法论

性能分析任务的一个典型的高级流程是这样的。

- 定义任务的范围。将业务场景分为操作、功能或简单地按页面划分。

- 对于每个任务,度量应用程序的性能(例如,Visualforce页面)并识别潜在的瓶颈。

- 识别并解决瓶颈的根本原因。

- 比较结果并重复步骤1、2和3,直到您消除瓶颈或最小化它们的影响。

- 使用更大的数据量和具有不同共享设置的用户迭代性能分析步骤,以便您能够尽可能全面地评估性能影响。

使用调试日志和开发人员控制台

要在Force.com平台上开始性能分析,您需要:

- 启用系统管理员配置文件和开发模式的用户。如果您还没有使用该概要文件的用户,请管理员在自己的Developer Edition组织中免费创建一个或创建一个。

- 将实际使用该应用程序的非管理员Salesforce用户

为了说明分析方法,并避免过多地关注如何解决性能较差的代码,我们来看一个非常简单的场景。

注意:我们假设您已经使用了通用的Web分析工具,如Chrome开发工具、Firebug或Fiddler来识别网络问题和资源优化机会。

下面的基本Visualforce页面显示总销售额和活动销售订单的数量,这两个都是根据它们的机会阶段名称进行分组的。

如果您想使用自己的Developer Edition或沙箱组织来遵循本指南中所示的步骤,请使用下面的示例代码,这应该是开箱即用的。如果您是Visualforce新手,请从Visualforce开发人员指南和Visualforce工作簿开始。

Visualforce page source

Apex controller source

在开发人员控制台中查看Visualforce页面调试日志

尽管可以使用开发人员控制台运行和调试匿名Apex的日志,但不能使用它直接呈现和收集Visualforce页面的调试日志。在跳转到开发人员控制台之前,您必须首先收集性能分析所需的调试信息。如果您的页面中有多个Visualforce组件,那么您可能希望将它们分开并逐个配置它们,除非它们具有依赖关系并影响彼此的性能。

步骤1:设置两个用户。

要获取Visualforce页面的日志,您必须使用两个用户:一个管理员用户来设置和分析调试日志,另一个非管理员用户来访问Visualforce页面。让测试用户设置适当的权限和共享配置,以便您以后可以访问Visualforce页面。从单独的浏览器中,使用管理员用户为测试用户启用调试日志。

提示:通过选择适当的日志级别来设置调试日志过滤器,这样您就可以专注于与应用程序所做的工作和您想要配置的内容相关的领域。这里有一个示例设置配置,可以用于此场景。

步骤2:执行你的Visualforce请求。

通过测试用户,通过访问Visualforce页面并完成您想要配置的任何操作来执行请求。

步骤3:打开测试用户的日志。

提示:要查看新日志,请打开日志、测试和问题面板并单击logs选项卡。找到您的日志并双击该行,将日志加载到开发人员控制台。

步骤4:禁用调试日志。

在收集您需要的信息之后,总是停止保留调试日志。如果您让调试日志继续运行,当您达到组织范围内的50mb调试日志限制时,它们可能会覆盖其他重要的日志。此外,每个用户最多只能收集20个调试日志。一旦达到这个限制,就必须为用户重置调试日志集合。

使用开发人员控制台配置Visualforce页面

现在您已经有了要处理的日志,请开始进行高级分析,以找出请求的哪个部分持续时间最长。

提示:通过按CTRL+P或单击Debug |查看日志面板来设置开发控制台,然后选择以下面板。

然后移动窗格(面板边框),使控制台看起来像下面的布局。这种布局将允许您关注性能分析所需的信息。单击这里快速浏览每个面板。

步骤1:阅读请求的时间线。

通过单击执行概述面板中的Timeline选项卡打开时间轴图。此面板将为您提供请求事务的每种类型的持续时间的良好可视化表示。对于这个场景,数据库查询占用了大部分执行时间(2.9秒/ 98.78%)。

根据性能分析的情况,您可能会看到一些不那么明显的东西。例如,更短的Apex事件的突发可能会被重复执行,并且会占用大量的执行时间。下面的示例展示了这样一个请求的外观。虽然“DB”的单个橙色条最初可能表示瓶颈,但该请求仅占总时间的2.5%。您还应该注意表示重复爆发的窄的绿色垂线,它们通常是由无效的顶点循环逻辑引起的。

在不同的情况下,您可能还会看到Visualforce页面需要很长时间才能呈现。如果您曾经有过这种类型的事务,请通过参考Visualforce性能:最佳实践来识别编码反模式,它列出了许多客户可能遇到的Visualforce性能缺陷。

步骤2:确定执行的事件正在做什么。

一旦您确定数据库事件占用了大量的总体请求时间,下一步就是确定这个事务正在做什么。打开执行日志面板并选择“Filter”以获取识别瓶颈所需的信息。对于本例,按类别筛选,只显示与“DB”相关的事件,如本屏幕截图所示。

提示:您可以通过悬停在任何现有列上并单击小的下拉图标来定制执行日志面板的列,如下所示。

因为这个示例非常简单,所以您只能看到一些日志行,其中的顶部显示正在执行的SOQL SELECT语句,最后一个显示结果行数。您现在已经确定了需要检查和调整的SOQL语句

注意:如果您有多个日志行,您可以使用时间戳来标识与您关注的时间轴对齐的行。您还可以按照下一步来评估每个请求的持续时间。

步骤3:检查性能基准。

从堆栈树面板中,单击Performance Tree选项卡并展开树。此选项卡将为您提供相应的持续时间(以毫秒为单位)、堆大小和为您的请求执行的每个组件的迭代。如果你有多个单位,从最长的事件开始,沿着你的列表工作。

提示:通过单击似乎会在Performance Tree选项卡上造成瓶颈(最长持续时间)的单元,您可以自动将一个过滤器应用到执行日志,并在时间戳中发现空白。禁用过滤器并查看位于此间隙中的事件。

查看性能树中显示的统计信息,验证它们是否与执行日志中显示的内容匹配。然后注意持续时间、堆大小和迭代次数。使用这些度量作为您在不同条件下运行的测试和调优Visualforce代码后运行的测试的基准。

步骤4:量表测试。

对更大的数据量和不同的用户(例如,数据可见性有限的用户和访问所有数据的管理员)重复相同的步骤。

一旦您开始添加数万条记录,您可能会发现执行时间变得更长。(前面的示例代码最终会遇到调控器限制,比如“System”。通过使用开发人员控制台,您可以检查您离各种Force.com调控器的限制有多近,或者您已经超出了这些限制有多远。下面的示例显示了您可能会收到的一些与限制相关的Visualforce错误。

现在您已经发现,需要向应用程序中添加诸如分页或过滤之类的逻辑,以便处理更大的数据集,并最终为用户提供良好的性能体验。

使用Workbench对数据进行概要分析

继续前面的场景,使用Workbench按照以下步骤进一步进行性能分析。对数据集进行概要分析,并评估我们在前一步中发现的潜在的非选择性SOQL语句的选择性。

步骤5:发现SOQL查询性能问题。

使用“已删除和归档的记录:”选项并选择“Include”以获得对象的总体数据量的准确表示。通过使用点单击接口或直接在文本区域中输入语句构建SOQL语句,如下所示。

查找大量的软删除行并清除它们,以实现最佳的查询性能。(也可以参考具有大数据量的部署的最佳实践。)

注意:还可以参考存储使用菜单查看对象的记录计数。(从设置中,单击管理用户|用户。)但是,这个页面是异步处理的。如果您添加或删除大量记录,那么更改可能不会立即反映在此页面中。更重要的是,数据不反映软删除的行。当分析性能时,包括基本记录计数中的软删除行数是很重要的,因为这些行会影响查询性能。

步骤6:评估查询的选择性。

要对每个筛选条件的选择性进行概要分析,请分解您的WHERE子句并对每个筛选器运行SELECT count()查询,如上面的图所示。对于和操作符,结合过滤器并评估查询的选择性。对于或操作符,您必须分别评估每个过滤器的选择性。确保您已经索引了选择字段,并且您正在遵循充分利用Force.com查询优化器的最佳实践。如果查询花费很长时间或超时,这表明您有性能瓶颈。要了解更多关于Force.com查询优化器的信息,请阅读本文并观看这个网络研讨会。要了解更多关于其选择性阈值的信息,请参阅数据库查询和搜索优化备忘单。

在Force.com平台上进行概要分析时需要考虑的事项

在分析时,考虑以下内容。

- 调控器限制——在执行日志中使用关键字“LIMIT_USAGE”来检查累积限制使用。确定接近极限的区域。

- 不同的共享设置——通过添加不同角色的用户来迭代性能分析步骤。这种策略可以让您发现数据量和共享计算开销可能带来的性能影响。如果您只使用管理员用户运行测试,那么您可能无法描述这些性能影响——系统不会为已经访问了所有数据的用户执行与共享相关的计算。

- 数据库缓存效果——Force.com平台在后台使用缓存技术来提高查询性能。基于没有缓存影响的请求获得基线基准测试是理想的,但是不能阻止事务使用缓存。在完成第一次概要运行之后,还要进行基于类似条件的其他运行,并比较结果。例如,如果您开始与用户A进行测试,那么运行您的测试几次。最有可能的是,后续的测试会运行得更快,直到某个点。类似地,当您切换到用户B或使用不同的数据集时,遵循相同的策略并运行几次测试。虽然在配置文件运行期间可以看到更好的查询性能,但是不要基于您将始终看到最佳测试结果的假设来设计业务操作和作业。

- 索引的使用——对于查询级别的性能分析,您无法确定您的SOQL请求是否实际使用了索引。但是,您可以通过使用没有任何自定义索引的自定义字段交换查询来测试和查看查询在没有索引的情况下的执行情况。一旦获得查询的基线性能,就可以在该自定义字段上创建索引,或者切换回具有索引的原始字段,以评估索引的效果。

- 负载测试——对于内部实现,负载测试——包括压力、带宽或并发用户测试——通常是性能测试的一部分。在Force.com平台上,负载测试的目标是测试Force.com调控器的限制。这个测试可能会发现一些问题,比如达到顶点并发限制,因为许多用户同时发出请求,运行时间超过5秒。但是,在Force.com平台上不推荐使用具有不现实业务场景的工具来查找服务器容量边界。收集关键信息,如服务器级资源统计信息,以及识别瓶颈是不可能的,而且在大多数情况下,您仅仅是无法获得准确的结果,因为您已经达到了调控器的限制。在运行任何负载测试之前,使用salesforce.com客户支持记录一个案例。

下一个步骤

前面的分析步骤可以帮助您识别和评估应用程序的性能瓶颈。它可能需要多次迭代,您还可能需要额外的帮助来让应用程序执行和扩展,以便满足您的业务需求。

Salesforce.com客户支持和我们的工程团队都配备了工具和标准流程,可以为您的性能分析增加更多的洞察力。例如,如果您发现您没有看到任何应用程序性能改进,即使在您硬删除了您的记录之后,您可能想要请求salesforce.com的客户支持进行物理删除。

您还可以通过salesforce.com客户支持来联系我们的工程团队,他们可以为您提供Force.com查询优化器分析。根据分析结果,团队可能建议使用选择性过滤器并创建自定义索引。团队还可以分析数据库级的统计数据,并可能创建瘦表。

注意:要利用这些服务,您必须获得开发人员支持。

总结

调试日志、开发人员控制台和工作台是您可以用来主动识别性能瓶颈并比较测试结果的工具。理解优化性能的最佳实践是重要的,但是当您试图构建可伸缩的、性能良好的应用程序时——在实现中应用这些最佳实践更重要。

相关资源

- 使用开发人员控制台进行高级测试和调试

- 深入开发人员控制台

- 开发人员控制台

- 工作台

- 视觉效果和顶点的性能调优

- 具有大数据量的部署的最佳实践

- 数据库查询和搜索优化备忘单

- 最大化Force.com SOQL、报告和列表视图的性能。

- 架构师核心资源

- 66 次浏览

【Salesforce 】Salesforce 5大性能问题

Salesforce是SaaS市场上的重量级公司,而Salesforce的问题可能会影响到成千上万的用户。Salesforce有一个在线状态指示板,许多用户利用它来监视应用程序,并确定它是否正常工作并按照预期执行。不过,trust.salesforce.com实际上只是一个Salesforce内部的仪表板,这样你就可以检查Salesforce基础设施和数据中心的所有功能是否正常。它并没有真正显示Salesforce 90%的交付路径上发生了什么。认为它是Salesforce的“检查引擎灯”:它告诉你引擎(应用程序代码)是否运行良好,但它并没有告诉你道路的状况(互联网),是否有道路建设(有限的带宽),或其他车辆占用交通(对资源的竞争)。仅仅因为“引擎”运行良好,并不意味着你能开得很快,很快到达目的地。

Salesforce是一个关键的应用程序,公司依靠它来保持业务向前发展。因此,对于it团队来说,重要的是要意识到并关注可能出现的或已经发生的性能问题,并知道如何在这些问题影响公司运营并最终影响业务之前做出响应和纠正。这里强调的许多问题并不是Salesforce特有的。它们只是在我们的客户群中观察到的成功的SaaS服务示例,而Salesforce提供的插件生态系统要比其他SaaS提供商大得多。

顶级Salesforce问题

以下是我们认为的企业SaaS服务(如Salesforce)的五大性能问题:

1。具体地点的问题。

Salesforce在全球有174个实例(2018年7月更新),其中56个在北美。与Salesforce实例和所有Salesforce插件的位置相关的办公室位置是理解Salesforce应用程序性能的一个因素。它实际上是Salesforce用户看到的许多性能问题的核心。减少物理距离和网络跳跃到Salesforce的数量会对性能产生巨大的影响。这似乎不是什么大事;没有人会注意到20或30毫秒的延迟。当20或30毫秒被加载到Salesforce web页面上的75个对象上,用户在这个关键任务SaaS应用程序上花费了数小时时,它们就会累积起来。

大多数其他SaaS服务都没有选择您的帐户供应位置的选项。您应该利用Salesforce的这个选项,选择与您的用户地理位置最近的实例,因为这将提供最好的性能。

2。低估娱乐流量的影响。

现在,每个员工都随身携带一台或多台能够传输高清视频和音频的设备,其中大部分设备将自动连接到公司的无线网络。随着人们带着移动设备工作,并使用本地无线网络流媒体,你可以发现你的带宽容量正在紧张或被消耗,导致诸如Salesforce这样的关键应用程序急需资源。我们遵循了我们自己的最佳实践,为个人设备建立了一个单独的无线网络,因此Salesforce拥有大量可用的带宽。缓解移动设备问题的一种方法是为你的员工正在使用的所有平板电脑、智能手机和其他移动设备建立一个独立的客户无线网络,并防止他们通过使用MAC地址过滤进入常规的内部网络。这样,您就可以分别为每个网络提供带宽,允许您控制不同设备的可用容量。

3. .低质量的带宽。

当web或SaaS应用程序(如Salesforce)运行缓慢时,许多公司认为它们应该投资于更多的带宽。这是一个真正的问题,但在升级office带宽之前,应该先看看这是否真正阻碍了他们的Salesforce性能。例如,在我们波士顿的办公室里,我们得到的带宽是250mbps,而Salesforce实例的带宽连接非常高,但是我们与Salesforce的连接速度是5mbps。

对于大多数我们工作的公司来说,获得更多的带宽并不能使Salesforce更快或更好地发挥作用。让它表现得更好的是获得更高质量的带宽。Web应用程序是基于tcp的,具有保证的交付,并且少量的数据包丢失将对Web应用程序的性能产生不可思议的影响。当一个web应用程序有3%到5%的包丢失(也由基于流的应用程序的重传速率表示)时,该应用程序的总体用户体验将是糟糕的。解决方案是确保您没有遇到包丢失和在当前的Internet连接上重新传输,并确保您和ISP的网络设备正常工作。许多公司从住宅级升级到商务级或其他专用电路的原因是为了确保更严格的公差、更好的设备以及减少web应用程序丢失数据包的机会。

4.智能缓存。

像Salesforce这样的Web应用程序有大量的JavaScript和CSS文件,以便提供丰富的用户体验,这种体验可以与人们在桌面应用程序中体验到的体验相媲美。因此,您将有3、4或5 MB的JavaScript文件需要时间下载,特别是当您有包丢失时。这一特定页面有多个插件使用我们的销售团队总页面大小5 MB。因为它很少改变,如果你可以在你的网络启用高速缓存,并创建一个缓存的导数它存储在本地,你会支持大文件下载和为用户创造一个更好的体验当加载Salesforce。

5。插件使用。

普通的Salesforce客户在Salesforce有7个插件,每个插件都可以极大地帮助或损害Salesforce的最终用户体验。您的大部分数据传输实际上可能来自这些第三方插件,它们与Salesforce合作,提供领先的来源、营销、销售和会计功能。因此,您想要探索您的插件使用了多少带宽,以及这些插件在哪里使用。在选择可用的插件时,应该考虑这些插件的性能影响,而不仅仅是它们的特性。要评估这些插件的全部性能影响,您需要一个工具,该工具使用一个真正的合成事务来度量最终用户的完整体验,因为这将使您能够看到,不仅Salesforce在正常工作,而且您的插件也在正常工作。

这些是您和您的IT团队可以监视的基本领域,以定位、避免和解决Salesforce性能问题。即使您在如何运行Salesforce方面做得很好,您也需要确保整个底层基础架构能够交付高质量的Salesforce体验。在AppNeta,我们花了大量的时间来确保我们的工具能够监控像Salesforce这样的SaaS应用程序,在它们影响用户体验之前及时发现这些问题。

- 33 次浏览

【Salesforce 】Salesforce架构师的网络最佳实践

2014年7月更新

对于在Salesforce平台上实现应用程序的架构师或开发人员来说,在分析应用程序性能时,网络性能测试变得越来越重要。本指南涵盖了帮助您识别风险并找到网络相关挑战的解决方案的最佳实践。

介绍

分析应用程序性能和运行性能测试是关键的“实验室”活动,以验证您的Apex和SOQL代码是为可扩展性而优化的,Visualforce页面设计是遵循最佳实践的。但是,为了确保您的应用程序已经为现实世界做好准备,您还需要考虑到用户将从具有不同级别网络连接的不同地理位置访问它。作为架构师,您的任务是成功地启动一个应用程序,即使使用这种网络变体,该应用程序也能运行良好。您肯定不希望在产品上线后听到终端用户说“为什么我的页面加载时间这么长,而我的同事可以在一秒钟内加载它?”继续阅读,学习最佳实践,帮助您识别风险,并作为架构师找到解决网络相关挑战的方法。

评估Salesforce用户的网络性能

如果有人问“为什么我的页面加载时间这么长,而我的同事可以在一秒钟内加载它?”“用户的设置可能不同,呈现内容的时间和大小也不一样。”为了确保你在将苹果和苹果进行比较,并将重点放在网络上,你必须有一个理想的受控设置:

在两个或多个不同的位置至少有两个几乎相同的终端(PCs)。在地理上更接近Salesforce数据中心(即:,以及其他远程站点(例如。)。

使用相同的浏览器和用户(或用户集)访问目标(例如,Visualforce页面),以排除尽可能多的变量。

使用相同的工具来度量时间(以下部分将对此进行解释)。

在类似的时间范围内运行测试,以评估与网络带宽相关的问题,并多次排除缓存影响。

如果您无法访问远程位置来运行测试,那么可以使用Charles或Shunra之类的工具以及netem和ipfw之类的实用工具来人为地添加延迟和带宽限制,以模拟不同的网络环境。

一旦有了受控的测试设置,您就可以收集基准统计数据并使用它们来迭代地评估性能调优工作。不管你如何设置你的测试,或者你选择使用什么工具来运行它们,我们最终追求的是两件事:

- 减少负载。

- 减少网络延迟。

为了简单起见,我们将在下面几节中逐一讨论。但是,请记住,这两者都要看,而不仅仅是一个。

减少负载

减少有效载荷的目标是减少网络时间。由于您正在测试和比较内容大小一致的相同页面,因此在服务器端和在客户端呈现的时间应该非常相似。下载资源所花费的时间差异越大,与请求的总持续时间相比,它所占的比例越大,通过检查页面设计和减少负载,您可能会得到更多的网络性能改进。

您不需要使用花哨的应用程序性能监视(APM)工具来评估负载。您可以使用免费的浏览器工具来收集关键指标。Chrome、Firefox和Internet Explorer都有类似的工具,它们可以为您提供从页面请求发送到Salesforce到用户感知到页面被“加载”到整个呈现过程完成的时间的图形表示。您还可以使用Fiddler或Charles等工具进行高级分析。

当这样做时,不要太过迷于字节大小,工具会显示每个被下载的资源。交换数据不会按位(或按字节交换数据)进行。它们以分组的形式通过电线传送。例如,如果您处理了几个映像文件以减少这里和那里的一些字节,但是没有看到性能有多大的提高,很可能是因为您没有减少每个资源下载的数据包的实际数量。如果你有一个高度图形化,动态页面有很多资源,比如图像、CSS或者JS文件,结合他们或拼接,然后削减他们可能会有更大的效果比减少一小部分的大小和仍然需要十(希望不是数百)资源并行下载。您还可以使用其他通用的web应用程序优化技术来最小化下载负载、减少往返行程和握手等。

更重要的是,确保检查Visualforce性能最佳实践,并在Salesforce1平台上构建高效的Visualforce页面。例如,删除不必要的Visualforce标记,这会增加页面视图状态的大小。通过仔细选择用户所需的字段和使用诸如分页之类的技术,限制在页面上加载和显示的数据量。如果您有一个多步骤的向导应用程序,该应用程序将引导用户遍历一个流程,请考虑实现一个解决方案,使页面之间的转换成为无状态。如果您有一个允许用户使用大量字段更新记录的表单,那么只发送delta信息,而不发送整个数据集。

减少网络延迟

当您通过优化应用程序来减少目标页面的有效负载时,您还应该在得出结论之前查看网络层,您无法使最终用户更接近Salesforce服务器。

您可以使用诸如Traceroute (Traceroute)或更高级的工具来进行更深入的分析。在salesforce,我们有几个第三方工具可以持续地监视和收集各种网络相关的度量,我们还可以根据需要部署这些工具,以便从远程站点解决问题(请联系客户支持以获得帮助)。这些工具可以让我们很好地了解RTT、BGP路由以及帮助发现问题区域的包丢失率等细节。下面几节将解释如何使用这些度量来确定如何减少网络时间。您最有可能参与您的IT、网络工程或ISP团队,以获取统计数据并进行深入分析。

减少延迟

使用Salesforce时,大多数浏览器页面或移动应用程序请求都是突发的事务,每个请求都需要多次往返Salesforce服务器,以建立连接、发送/接收数据,并确认交换的每个数据包。

从网络的角度来看,你应该注意两个关键方面:

- 实例不是分布在多个数据中心(除了在地理远程数据中心待命的灾难恢复克隆之外)。换句话说,在任何特定的时刻,用户事务都是连接到我们的数据中心的。

- Salesforce.com采用与运营商无关的体系结构,它通过连接到多个行业领先的网络供应商,这些供应商直接位于每个数据中心边界的边缘,拥有高带宽的骨干。这提供了冗余和灵活性,以便为通过Internet连接的用户提供最佳的网络性能。

虽然由于用户和Salesforce之间的地理距离而增加的延迟是固定的,但是可能有机会减少特定于用户网络的“拓扑”延迟。确保你至少涵盖以下内容:

- 优化BGP - BGP路由在确定数据包通过internet发送时的延迟方面起着重要作用。在极端的情况下,您的数据包可以通过更长的方式在全球发送到Salesforce,也可以跳过过多的中继点,每次都增加了延迟。虽然优化BGP有时更像是一门艺术,而非科学,但我们在仔细研究和改变网络路由偏好之后,看到了巨大的收获。使用网络监视和分析工具,比如千分之一和Appneta提供了发现问题的洞察力。

- 避免不稳定路径——最短路径不一定是最好的路径。考虑由于网络稳定性问题的影响,如数据包丢失和数据抖动。如果任何一端在给定的时间范围内都没有收到预期的包(例如,放弃等待另一端的确认),那么它将重新提交最后一个包,然后等待多次,每次都乘以并增加总体延迟。由于RTOs和SRTTs的增加,地理延迟的影响变得更糟。与BGP分析类似,监视工具可以识别具有稳定性问题的路径。基于调查,您可以与您的网络团队和isp一起优化路由,以修复或避免已知的具有稳定性问题的路径。这将导致数据包重新传输的减少,这意味着在冗余的数据包交换上浪费的时间更少。

- 识别瓶颈——您的网络中可能存在一个正在增加延迟的中间设备。通过使用Wireshark之类的工具,并与您的IT/网络团队和Salesforce支持紧密合作,包级跟踪分析可能会发现与次优或在您的办公室或托管数据中心中配置不当的设备相关的优化机会。您可能还会发现,除了salesforce提供的资源之外,对其他资源的访问也显示出性能问题。

- 避免重定向——每个重定向添加到整个RTT中,并导致许多往返重定向服务器的往返,以完成SSL握手。评估并避免不必要的重定向。例如,启用My Domain并将登录请求指向My Domain URL,而不是常规登录页面。如果已经实现了SSO,请确保将SAML断言发送回My Domain端点。请参阅本指南,了解可以应用于减少由于重定向造成的延迟的其他技术。

利用CDN

如果您有一个构建在Force.com站点上的公共页面,并且没有通过SSL提供服务,salesforce提供了一个缓存选项,允许您利用我们合作伙伴的内容交付网络(CDN)。CDN通过从地理位置更靠近用户的缓存服务器上提供静态资源来提高页面加载时间。这种方法对减少网络延迟也有类似的效果。

带宽利用率最大化

如果您知道您有一个本地分支办公室,它的吞吐量有限,许多用户共享这条线,那么这可能是需要研究的内容。然而,让1Gbps企业骨干离开您的办公室并不意味着您不必担心带宽,因为带宽利用率受到延迟和TCP窗口大小的限制。对于涉及到的所有各方来说,控制TCP窗口大小配置可能并不容易,但是对于存在问题的客户机PC来说,这是一个值得研究的调优机会。有关细节,请阅读下面的内容。要了解更多关于使用salesforce的带宽需求,请阅读本文的帮助文章。

集成设计注意事项

如果您将Salesforce之外的服务集成为应用程序设计的一部分,请考虑以下内容:

- 可以使用mashup (i-frame)技术直接与客户端进行调用,而不是通过salesforce平台进行多次往返。这种方法对减少网络延迟也有类似的效果。

- 握手和数据传输最小化(通过批处理和压缩)以减少有效负载也很重要。应该仔细调整超时设置,以平衡延迟,避免占用连接太长时间。对于API调用,并行化(如果可能的话)可以帮助减轻延迟的一些负面影响。

- 幂等性也是一个关键的设计考虑因素,尤其是在网络连接不佳的情况下。您应该假设在完成之前任何事务都可能失败,并且所有来自远程服务器/服务的请求都应该工作,并且只工作一次,以允许多个重试,而不会带来数据完整性问题。

总结

确保您的页面加载时间目标不仅在您的开发实验室设置中得到满足,而且对于具有额外延迟或次优网络连接的远程用户也是如此。研究web页面优化技术以及消除网络瓶颈以减少网络时间。这将确保您不会听到终端用户“为什么我的页面加载时间这么长?”

- 77 次浏览

【Salesforce 】在Salesforce Lightning Experience(闪电体验)提高性能和速度

Knowledge :000250291

描述

如果您或您的用户在使用闪电体验时正在经历缓慢的页面加载时间,它可能与以下一种或多种问题类型有关。

- 地理

- 设备

- 浏览器

- Salesforce组织配置问题

请审阅以下的问题描述和缓解策略,以提高您的销售团队为闪电用户的性能。

解决办法

地理问题

从不同的地理位置访问主机实例(例如,一个组织在北美托管,但用户从亚洲访问它)。

由于客户端设备和远程web服务器之间的延迟问题;或客户网络拓扑,如虚拟专用网络,在Salesforce环境中重新路由到客户的org之前,需要通过公司办公室或数据中心路由通信。

潜在的缓解措施

评估网络延迟:请公司的网络管理员或IT专业人员在连接到Salesforce环境时评估网络延迟。它们可以运行“ping”或“traceroute”等实用程序来收集数据,然后确定优化网络连接速度的方法。您还可以在这里测量下载和上传速度到您的Salesforce实例:https://[instance .salesforce.com/speedtest.jsp。

设备和Browser-Related问题

使用笔记本、台式机或虚拟桌面基础设施,没有足够的处理能力或内存。或者有多个应用程序在争夺设备的资源,比如CPU和内存。

使用带有消耗大量CPU或内存的插件或扩展的web浏览器。

同时运行太多的浏览器选项卡。每个选项卡消耗内存和CPU周期。

潜在的缓解措施

评估浏览器处理能力:

使用Octane来度量浏览器对客户端设备(笔记本、桌面、工作站或虚拟桌面)的处理能力:https://chromium.github.io/octane/。如果辛烷值小于15000,闪电体验性能可能会比较慢。高端客户端设备的辛烷值通常大于3.2万。辛烷值越高,闪电体验性能越好。你可以尝试以下步骤来提高客户的Octane 值:

- 确保笔记本电脑完全充电或连接电源。当笔记本电脑用低电量运行时,它会以较低的速度运行以节省电力。

- 如果可能,关闭在客户端设备上运行的其他应用程序。

- 如果可能,将浏览器设置重置为原始默认设置。

- 删除未使用或不必要的浏览器插件和扩展。

- 将客户端设备升级到具有更多处理能力和内存的模型。

禁用不必要的插件和扩展:

浏览器插件和扩展对闪电体验性能的影响取决于它们消耗多少CPU能量或内存资源。禁用特定的插件或扩展,以查看更改是否会导致更高的辛烷值。对于每个浏览器来说,禁用插件的方法是不同的。例如,在Chrome中,通过输入:Chrome://plugins/或Chrome://extensions/。

使用最新的浏览器版本或补丁:

浏览器供应商通常会发布更新的版本或补丁,并进行修复,以提高性能、安全性或稳定性。

切换浏览器:

性能因浏览器而异。Chrome一直是最快的闪电体验浏览器,而ie浏览器通常是最慢的。

重新启动浏览器或设备:

每周重新启动浏览器和客户端设备一次可能会有所帮助。运行各种应用程序的客户端设备或浏览器可能比需要的时间更长。释放这些资源使浏览器和操作系统的资源管理更加高效,允许浏览器和操作系统在经常使用的应用程序(如Lightning Experience)上花费更多的时间和系统资源。

Salesforce组织配置

- 使用未经优化的Visualforce实现。

- 激活Aura调试模式。

- 使用具有复杂结构、大量组件或数百个字段的闪电页面。这些类型的页面需要更多的时间来处理和呈现。

潜在的缓解措施

优化您的Visualforce页面:

遵循我们在优化Visualforce性能开发人员文档的最佳实践中提供的指导方针。

禁用Aura调试模式:

您的组织可能已经启用了Aura调试模式,以便更容易地在Lightning组件中调试JavaScript代码。但是运行Aura调试模式会降低闪电体验的性能。要在sandbox和production orgs中关闭此模式,请转到Setup,选择Lightning组件,然后取消选择Enable Debug模式复选框。

重新配置处理密集型页面:

如果您的Salesforce org有大量字段、低效的自定义组件或复杂的页面配置的页面,请考虑降低它们的复杂性,以提高呈现加载时间。

- 流线化最初仅对与用户功能相关的字段可见的字段的数量。您可以使用配置文件来实现这一点。

- 将页面上的元素(包括字段、相关列表和自定义组件)分解为选项卡。在第一个选项卡上显示最需要的信息,并将辅助信息移动到后面的选项卡上。将不太重要的组件移动到一个或多个Lightning页面选项卡之后。不在主选项卡中的组件不会在初始页面加载中呈现,而是只按需呈现。例如,将新闻和Twitter组件移动到次要的“新闻”选项卡。

- 所示。细节:将细节组件放置在辅助选项卡中,或者减少显示在细节面板中的字段。这将对组件的呈现时间产生线性影响。

- 所示。相关列表:将相关列表组件放在辅助选项卡中,可以使用新的“相关列表”组件在主页面上显示一个或两个关键的相关列表。将相关列表的数量减少到3个或更少。

- 自定义组件:通过使用或不使用组件进行测试来量化自定义组件的影响。有些组件可以重构为闪电动作或应用通用优化。

Lightning组件执行最佳实践

为了了解更多关于闪电经验的有用的最佳实践,请回顾我们的Lightning Experience(闪电组件)性能最佳实践。

- 23 次浏览

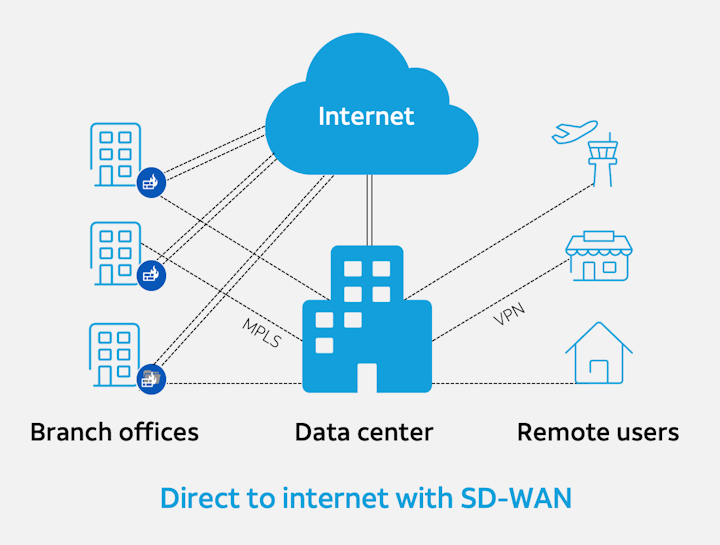

【网络技术】软件定义广域网(( SD-WAN)的兴起

满足现代网络的安全需求

SaaS产品将软件、存储和计算资源转换为存在于传统网络之外的服务器上的服务。

随着组织变得更加移动和地理上分散,曾经为它们提供良好服务的传统集中式广域网(WAN)模型开始崩溃。远程用户——曾经是例外——已逐渐成为常态,许多人在跨越多个时区的较小分支机构工作,或者在家办公,或者在旅途中工作。

扩大这种业务分散化的趋势是向Office 365等软件即服务(SaaS)产品的转变,以及应用程序向云服务平台(包括亚马逊AWS和微软Azure)的迁移。这些SaaS产品将软件、存储和计算资源转换为存在于传统网络之外的服务器上的服务。

这给优化、管理和保护基础设施的团队带来了挑战。尽管传统的防火墙可以防止流量流入数据中心或其他物理位置,但它们不能为直接连接到Internet或基于云的资源的远程用户提供可见性或安全性。

SWG发展

随着公司将工作负载和应用程序转移到云上,安全Web网关(SWGs)的出现可以解决这些问题并加速数字转换。从本质上说,这些技术允许移动和远程工作人员直接访问internet,而不必通过数据中心路由流量,从而使安全团队能够执行基本任务,如URL过滤,并保护用户免受基于web的威胁。它们还可以执行其他重要的安全任务,比如HTTPS(加密)流量检查,在某些情况下,还可以执行数据丢失预防(DLP)、云访问安全代理(CASB)功能,甚至使用沙箱技术实现针对零日攻击的保护。

由于该技术的性质会让人把它与端点上的传统杀毒软件以及有状态或下一代防火墙(NGFW)和入侵预防系统(IPS)等安全设备进行比较,因此购买者可能会对swg是作为一种补充还是替代感到困惑。为了解决这些问题,我们首先需要检查帮助形成swg发展的压力,并将它们的出现和用例放入上下文中。

SD-WAN的加速

一种称为软件定义广域网(SD-WAN)的现代方法利用一种体系结构,将不同类型的广域网连接转换为单个虚拟实体,从而提供广泛的好处。有了SD-WAN,组织可以用更便宜的商品互联网如宽带、光纤和LTE来增加他们的MPLS线路,允许组织以比实施额外的专用电路更低的成本快速增加额外带宽。拥有由不同技术支持的多个网络链接也是对网络弹性和业务连续性的投资。如果恶劣的天气或施工人员切断了其中一条网络连接,SD-WAN可以几乎无缝地将流量路由到可行的线路,直到服务恢复。

但是为了将分支和远程用户直接连接到internet而部署SD-WAN确实会产生一些影响,最明显的是安全性问题。在传统的轮辐式架构(hub-and-spoke architecture)中,进出网络只有一条路。但在新的模式下,现在出现了许多网络突发事件,有时甚至在一个广阔的地理区域内出现成百上千次。每一个到internet的连接都代表了攻击的途径,因此,必须实施安全措施。

加强安全措施

基于云的SWG为管理员提供了一种跨其用户应用统一安全策略的方法,几乎可以在他们进行业务并提供集中可见性的任何地方,允许管理员随时了解在他们的网络上发生了什么活动。与SD-WAN一起,它克服了传统的用户因远离网络核心而遭受性能较差和安全性较差的问题。SWG通过限制可以访问的内容来保护用户免受基于web的威胁。它们还为组织提供了一种解决方案,以实现网络管理的目的,在对网络性能影响最小的情况下对加密的web流量执行细粒度检查。基于云的架构更容易扩大规模,因为随着企业扩张,无论是增加新办公室、整合公司收购,还是进行合并,都不需要购买昂贵的安全设备就可以增加容量。

随着时间的推移,许多组织发现SWGs可以替代其当前安全基础设施的元素,如SSL/TLS检查设备、入侵预防系统(IPS)和一些分支办公室位置的防火墙。在某些情况下,SWGs可能与其他技术具有重叠的功能,但应该将其理解为互补而不是直接替代。例如,尽管SWGs可以执行web过滤和深度包检查,并防止基于web的恶意软件,但它们并不打算取代端点安全性。它们也不应该与web应用程序防火墙(WAFs)混淆,后者是专门为高度保护web服务器不受外部攻击而设计的,例如分布式拒绝服务(DDoS)泛滥。

在当今的数字化商业环境中,为了实现商业目标并保持竞争力,企业已经变得更加分散和移动。这就产生了一种新型的虚拟广域网,其中数据中心是一种资源,但不再是网络的中心。尽管许多网络仍然保留了这种遗留架构的元素,但未来属于更扁平化、更动态、适应性更强的拓扑,这些拓扑将员工的生产力置于技术层次之上。SWGs和SD-WAN是互补的元素,可以帮助组织实现其网络和安全性的现代化,以便它们能够扩展以支持新的计划。

本文:http://jiagoushi.pro/node/1345

讨论:请加入知识星球【CXO智库】,小号【it_strategy】或者QQ群【1033395421】

- 30 次浏览

云原生

- 81 次浏览

【云原生】云原生与文化有关,而不是容器

关键要点

- 即使没有一个微服务,也有可能实现云原生服务

- 在开始云本机转换之前,必须弄清楚云本机对您的团队意味着什么,以及要解决的真正问题是什么

- 如果发布涉及繁重的仪式、不经常发布,并且如果所有的微服务必须同时发布,那么微服务体系结构的好处就不会实现

- 持续集成和部署是您要做的事情,而不是购买的工具

- 过度的治理扼杀了云计算的速度,但是如果你没有足够的关注正在被消耗的东西,就会有严重的浪费

在去年的伦敦QCon上,我提供了一个关于文化而不是容器的云本地会话。让我开始思考文化在cloud native中的作用的是一篇来自Bilgin Ibryam的InfoQ文章。Bilgin所做的一件事是将云本地架构定义为许多通过智能管道连接的微服务。我看了之后觉得它和我写的应用程序完全不同,尽管我以为我写的是云本地应用程序。我是IBMGarage的一员,帮助客户获得云本地服务,但我很少在我的应用程序中使用微服务。我创建的应用程序大部分看起来不像比尔金的图表。这是不是意味着我做错了,或者云本地的定义有点复杂?

我不想单挑比尔金,因为比尔金的文章被称为“后库伯内特斯时代的微服务”,所以如果他在那篇文章中不经常谈论微服务,那就有点可笑了。同样,几乎所有的云原生定义都将其等同于微服务。我到处都看到这样的假设:微服务等于本地服务,云本地服务等于微服务。甚至云原生计算基金会也曾将云原生定义为所有关于微服务和所有关于容器的内容,其中包含一些动态编排。说cloud native并不总是涉及微服务,这让我处于一个特殊的位置,因为我不仅说Bilgin错了,我还说cloud native计算基金会错了——他们对cloud native了解多少?我肯定我知道的比他们多,对吧?

嗯,显然我不知道。在这件事上我站错了历史的一边。我承认这一点(尽管我站在历史的错误一边,但我注意到CNCF已经更新了他们对cloud native的定义,尽管微服务和容器仍然存在,但它们似乎不像以前那么强制性,所以一点历史可能站在我这边!)。不管是对是错,我还是会死在我的小山上;这种云本地服务比微服务更重要。微服务就是一种方式。他们不是唯一的方法。

事实上,你在我们的社区里看到了一系列的定义。如果你问一群人“云原生”是什么意思,有些人会说“生于云”。这是在微服务成为一种东西之前,云原生的最初定义。有人会说这是微服务。

有些人会说,“哦,不,不仅仅是微服务,而是Kubernetes上的微服务,这就是云原生的方式”。我不喜欢这个,因为对我来说,cloudnative不应该是一个技术选择。有时我会将Cloud native用作DevOps的同义词,因为许多Cloud native原则和实践与DevOps所教授的内容相似。

有时我看到cloudnative被用作“我们正在开发现代软件”的一种说法:“我们将使用最佳实践;它是可以观察到的;它将是健壮的;我们将经常发布并自动化所有内容;简言之,我们将利用过去20年所学的一切,以这种方式开发软件,这就是为什么它是云本地的”。在这个定义中,云只是一个给定的-当然它在云上,因为我们在2021年开发这个。

有时我看到Cloud native只是指云。我们已经习惯于听到云本地的说法,以至于每次我们谈论云时,我们都会觉得必须在后面加上一个'-native',但我们实际上只是在谈论云。最后,当人们说Cloud native时,有时他们的意思是幂等的。问题是,如果你说Cloud native表示幂等,其他人会问,“什么?我们所说的“幂等”是什么意思?如果我拿走它,关掉它,然后再启动它,没有什么坏处。这是云服务的基本要求。

有了所有这些不同的定义,我们不完全确定在使用Cloud native时要做什么,这有什么奇怪的吗?

为什么?

“我们到底在努力实现什么?”是一个极其重要的问题。当我们在考虑技术选择和技术风格时,我们想从“我在做云计算,因为其他人都在这么做”退后到“我到底在解决什么问题?”公平地说,CNCF在他们对云计算的定义前面有一个“为什么”。他们说,“CloudNative是指使用微服务更快地构建伟大的产品。”;我们使用微服务是因为它们能帮助我们更快地生产出优秀的产品。

这是我们后退一步,以确保我们了解我们正在解决的问题。为什么我们不能更快地生产出优秀的产品呢?跳过这一步很容易,我想我们每个人有时都会为此感到内疚。有时候,我们真正想解决的问题是,其他人都在做,所以我们害怕错过,除非我们开始做。一旦我们这样说,FOMO就不是一个很好的决策标准。更糟糕的是,“我的简历看起来很枯燥”绝对不是选择科技的正确理由。

为什么是云?

我想知道为什么我们应该以云本地的方式做事;我们想退一步说,“我们为什么要在云上做事呢?”原因如下:

- 成本:当我们第一次开始把东西放到云上时,价格是主要的动力。我们说,“我有这个数据中心,我必须支付电费,我必须付钱给维护它的人。我要买所有的硬件。当我可以使用其他人的数据中心时,我为什么要这样做?“在您自己的数据中心和其他人的数据中心之间节省成本的原因是您自己的数据中心必须为最大的需求储备足够的硬件。这可能是大量的容量,大部分时间都没有使用。如果是别人的数据中心,你可以集中资源。当需求量很低时,你就不会为额外的容量买单。

- 弹性:云为你省钱的原因就是因为这种弹性。你可以扩大规模;你可以缩小。当然,这已经是老新闻了。我们都认为弹性是理所当然的。

- 速度:我们现在对云感兴趣的原因是速度。不一定是硬件的速度,尽管有些云硬件可以快得让人眼花缭乱。云是使用gpu的一种很好的方式,它或多或少是使用量子计算机的唯一方式。不过,更普遍地说,我们可以通过云将一些东西推向市场,比我们必须将软件打印到CD-rom上并将其发送给人们,甚至我们必须在自己的数据中心中建立实例时要快得多。

12个因素

成本节约、弹性和交付速度都很好,但我们只需在云上就可以做到这一点。为什么我们需要云本地?我们之所以需要Cloud native,是因为很多公司发现他们试图去云计算,结果被电死了。

事实证明,在云上,事情需要以不同的方式编写和管理。阐明这些差异导致了12个因素。这12个因素是一组关于如何编写云应用程序以避免触电的规定。

你可以说这12个因素描述了如何编写云本地应用程序,但这12个因素与微服务完全无关。他们都是关于你如何管理你的国家。他们是关于你如何管理日志的。这12个因子帮助应用程序变得幂等,但“12个因子”比“幂等因子”更吸引人。

这12个因素是在Docker上市前两年公布的。Docker容器彻底改变了云的使用方式。集装箱很好,很难夸大它们的重要性。他们解决了许多问题,创造了新的建筑可能性。因为容器非常简单,所以可以跨多个容器分发应用程序。一些公司在100、200、300、400或500个不同的容器上运行单个应用程序。与这种工程能力相比,一个仅仅分布在六个容器中的应用程序似乎有点不够。面对如此少的复杂性,人们很容易想到“我一定是做错了。我不是一个好的开发人员,因为他们在那里”。

事实上,不。这不是一个看你能有多少集装箱的竞争。容器是很好的,但是容器的数量应该根据你的需要来调整。

速度

让我们试着记住-你还需要什么?当我们想到云的时候,我们通常会想到它的速度。我们需要大量集装箱的原因是我们想更快地将新产品推向市场。如果我们有很多集装箱,我们要么把完全一样的东西运到市场上,要么以同样的速度运到市场上,那么突然之间,那些集装箱只是一种成本。它们并没有帮助我们,而且我们正在处理将应用程序分散在整个基础设施中所带来的复杂性。如果我们有这样一个惊人的架构,允许我们对市场做出反应,但我们没有反应,那就是浪费。如果我们有这样的架构,那就意味着我们可以走得很快,但我们不能走得很快,那也是一种浪费。

如何在云原生中失败

这让我想到了如何在Cloud native失败。作为背景,我是个顾问。我是IBM车库里的一名全栈开发人员。我们与初创公司和大公司合作,帮助他们进入云计算领域,并从云计算中获得最大收益。作为其中的一部分,我们帮助他们解决有趣、棘手的问题,我们帮助他们比以前更快地完成软件开发。为了确保我们真正从云计算中获得最大的收益,我们做了一个精益启动,极限编程,设计思维,DevOps;和云本机。因为我是一名顾问,我看到很多客户都在云端之旅中。有时进展顺利,有时也有这些陷阱。以下是我见过的一些聪明客户陷入的陷阱。那么,什么是云本地的呢?

最早的陷阱之一是魔法变形的含义。如果我说的是Cloud native,我指的是一件事,而你说的是Cloud native,我指的是另一件事,我们的沟通会有问题。。。

有时这并不重要,但有时会有很大的不同。如果一个人认为目标是微服务,而另一个人觉得目标是拥有一个幂等系统,哦。或者,如果一个组织的一部分人想进入云计算,因为他们认为这将使他们更快地进入市场,但另一部分人进入云计算只是为了提供与以前完全相同的速度,但更具成本效益,那么我们可能会有一些冲突。

微服务嫉妒

通常,导致人们对目标产生某些困惑的原因之一是,我们有一种自然的倾向,那就是看别人,做奇妙的事情,并想模仿他们。我们想自己去做那些奇妙的事情,而不去考虑我们的环境以及它们是否适合我们。我们IBM的一个同事在和客户谈论微服务时有一个启发。他说,“如果他们开始谈论Netflix,他们只是一直在谈论Netflix,他们从来没有提到一致性,他们从来没有提到耦合,那么他们这样做可能不是出于正确的原因。”

有时我们和客户交谈,他们会说,“好吧,我想让微服务现代化。”好吧,微服务不是我们的目标。没有客户会在你的网站上说,“哦,微服务。顾客会看你的网站,判断它是否满足他们的需求,是否简单愉快,以及其他所有这些。微服务可能是达到这一目的的一个很好的手段,但它们本身并不是一个目标。我还应该说:微服务是一种手段。它们不一定是实现这一目标的唯一手段。

我在IBM车库的一位同事与亚太地区的一家银行进行了一些交谈。这家银行在回应客户时遇到了问题,因为他们的软件都是陈旧的、笨重的、陈旧的。他们还有一个人员问题,因为他们所有的COBOL开发人员都年迈,离开了工作岗位。所以银行知道他们必须现代化。在这种情况下,主要的驱动力不是老龄化的劳动力,而是竞争力和灵活性。他们被竞争对手打败了,因为他们有大量的COBOL代码,而且每次修改都是昂贵而缓慢的。他们说,“好吧,要解决这个问题,我们需要摆脱所有的COBOL,我们需要切换到一个现代的微服务架构。”

到目前为止,还不错。我们正准备加入一些云计算,当时银行补充说他们的发布委员会每年只开两次会。在这一点上,我们回过头来。银行闪亮的新架构将拥有多少微服务并不重要;这些微服务都将被组装成一个巨大的整体发布包,并每年部署两次。这就占用了微服务的开销而没有好处。因为这不是一个看你有多少个容器的竞争,很多容器和缓慢的释放将是一堆绝对没有人赢。

许多微服务被锁定在缓慢的发布节奏中,这不仅不是一场胜利,也可能是一场惨败。当组织尝试微服务时,他们并不总是像图中那样以一个漂亮的解耦微服务架构结束。相反,它们最终会形成一个分布式的整体。这就像一块普通的巨石,但更糟。这种情况之所以特别糟糕,是因为正常的、非分布式的monolith具有编译时类型检查和同步的、有保证的内部通信等功能。在单个进程中运行会损害您的可伸缩性,但这意味着您不能被分布式计算的谬误所困扰。如果你使用同一个应用程序,然后只在互联网上涂抹它,不进行任何类型检查或投资于网络问题的错误处理,你就不会有更好的客户体验;你的客户体验会更糟。

在很多情况下,微服务是错误的答案。如果你是一个小团队,你不需要有很多独立的团队,因为每个独立的团队大约有四分之一的人。假设您没有任何独立发布部分应用程序的计划或愿望,那么您将不会从microservices的独立性中获益。

为了在应用程序的所有这些组件之间提供安全可靠的通信和可发现性,您需要一个服务网格之类的东西。你可能在技术曲线上非常先进,或者对技术曲线有点陌生。你要么不知道什么是服务网格,要么说,“我知道什么是服务网格。太复杂,太夸张了。我不需要服务网。我只打算用我自己的服务网来代替,“这不一定会给你你所希望的结果。您最终仍然会得到一个服务网格,但您必须维护它,因为它是您编写的!

不做微服务的另一个很好的理由是,有时域模型没有那些自然的断开点,这些断开点允许您获得漂亮整洁的微服务。在这种情况下,说“你知道吗?我就不干了。”

云原生意大利面

如果你不离开这个blob,那么你就会遇到下一个问题,那就是Cloud原生的意大利面。当我看Netflix微服务的通讯图时,我总是感到有点惊慌失措。我相信他们知道自己在做什么,他们已经弄明白了,但在我看来,它看起来完全像意大利面。做这项工作需要很多真正扎实的工程和专业技能。如果你没有这方面的专业知识,那么你最终会陷入一个混乱的局面。

我是来和一个挣扎的客户救火的。他们正在开发一个新的应用程序,所以他们当然选择了微服务,尽可能的现代化。他们对我说的第一句话是“任何时候我们改变任何代码,其他的东西就会中断。”这不是微服务应该发生的事情。事实上,这与我们都被告知的如果我们实现微服务会发生什么完全相反。微服务的梦想是它们是解耦的。可悲的是,脱钩并不是免费的。它当然不会仅仅因为你分发了东西就神奇地发生。当你分发东西的时候,你只会遇到两个问题而不是一个。

云原生的意大利面还是意大利面。

我的客户机代码如此脆弱且相互关联的原因之一是,它们有相当复杂的对象模型,其中一些类中有大约20个类和70个字段。在微服务系统中处理这种复杂的对象模型是很困难的。在本例中,他们查看了他们的复杂对象模型,然后决定,“我们知道在我们的微服务之间有公共代码是非常糟糕的,因为这样我们就没有解耦。相反,我们将在所有六个微服务中复制并粘贴这个公共对象模型。因为我们剪切粘贴它而不是链接到它,所以我们是解耦的。如果某件事发生变化时,某件事发生了变化,那么无论代码是链接的还是复制的,都存在耦合。

在这种情况下,什么是“正确”的做法?在理想情况下,每一个微服务都整齐地映射到一个域,而且它们是完全不同的。如果你有一个大的域和很多小的微服务,那就有问题了。解决方案是要么确定域确实很大并合并微服务,要么进行更深层次的域建模,尝试将对象模型分解为不同的有界上下文。

即使是最干净的域分离,在任何系统中,组件之间总会有一些接触点——这就是它成为一个系统的原因。这些接触点很容易出错,即使它们很小,尤其是如果它们是隐藏的。你还记得火星气候轨道器吗?与“坚忍不拔”不同的是,它的设计目的是从安全距离环绕火星运行,而不是在火星上着陆。不幸的是,它离火星太近,被火星的引力吸引,坠毁了。失去探测器是可悲的,而其根本原因是悲剧性的。轨道器由两个模块控制,一个在探测器上,另一个在地球上。探测器舱是半自主的,因为大部分时间从地球上看不到轨道器。大约每三天行星就会排列一次,它就会出现在人们的视野中,地球上的研究小组会对其轨道进行微调。我想指令大概是“哦,我想你需要向左移动一点,如果你不向右移动一点,你会错过火星的”,除了数字。

这些数字导致了这个问题。地球舱和探测器舱是由两个不同的小组建造的两个不同的系统。探测器使用英制单位,喷气推进实验室地面小组使用公制单位。尽管这两个系统看起来是独立的,但它们之间有一个非常重要的耦合点。地面小组每次传达指令时,他们所传达的信息都会以一种无人预料的方式被解读。

这个故事的寓意是,分发系统没有帮助。这个系统的一部分在火星上,另一部分在地球上,你再也找不到比这个更分散的了。

微服务需要消费者驱动的合约测试

在这种情况下,解决方案,正确的做法是真正明确耦合点是什么,以及各方的期望是什么。一个很好的方法是消费者契约驱动的测试。合同测试在我们的行业中还没有得到广泛的应用,尽管它是解决一个大问题的一个干净的解决方案。我认为问题的一部分是,他们可能有点棘手的学习,这已经减缓了采用。关于测试的跨团队协商也可能很复杂——尽管如果关于测试的协商太难,那么关于实际交互参数的协商将更加困难。如果您正在考虑探索契约测试,Spring契约或Pact是一个很好的起点。哪一个适合你取决于你的背景。springcontract很好地集成到了Spring生态系统中,而Pact是框架无关的,支持多种语言,包括Java和Javascript。

契约测试远远超出了OpenAPI验证的功能,因为它检查api的语义,而不仅仅是语法。这是一个比“好吧,两边的字段都有相同的名称,所以我们很好”更有用的检查,它允许你检查,“当我得到这些输入时,我的行为是预期的行为吗?我所说的关于那个API的假设仍然有效吗?“这些是你需要检查的东西,因为如果它们不是真的,事情会变得非常糟糕。

许多公司意识到了这种风险,并且意识到当他们在做微服务时,系统存在不稳定。为了确信这些东西能够协同工作,它们在发布它们之前会强制执行一个UAT阶段。在发布任何微服务之前,有人需要花几个星期的时间测试它在更广泛的系统中是否正常工作。有了这样的开销,释放就不会经常发生了。这就引出了经典的反模式,它实际上不是持续集成和持续部署,也不是I/D。

为什么不支持持续集成和部署

我和很多客户交谈,他们会说,“我们有一个CI/CD。”a会敲响警钟,因为CI/CD不应该是你买的、放在服务器上、欣赏的工具,说“有CI/CD。”CD/CD是你必须要做的事情。这些字母代表持续整合和持续部署或交付。Continuous在这个上下文中的意思是“经常集成”和“经常部署”,如果您不这样做,那么它就是不连续的。

有时我会无意中听到这样的评论:“我将在下周将我的分支合并到我们的CI系统中”。这完全忽略了“CI”中“C”的意思,它代表着连续性。如果你每周合并一次,那是不连续的。这几乎与连续相反。

“D”部分可能更像是一场斗争。如果每六个月才部署一次软件,那么CI/CD服务器可能很有用,但是没有人做CD。可能有“D”,但每个人都忘记了“C”部分。

到底多久才有理由去主打?连续性必须是多连续?甚至我也承认,对连续性的一些严格定义是在团队中编写软件的一种荒谬的方法。如果你把每个角色都推到了主角色,那在技术上是连续的,但这会导致团队的混乱。如果你把每一个承诺都整合起来,并且目标是一小时做几次,那可能是一个相当好的节奏。如果你经常提交并整合每几次提交,你每天都要推几次,所以这也很好。如果您正在进行测试驱动开发,那么在获得一个通过的测试时集成是一个很好的模式。我是一个大倡导者,以主干为基础的发展。TBD在调试、支持机会主义重构以及避免同事们的大意外方面有许多好处。基于主干的开发的技术定义是,您需要每天至少集成一次以计数。我有时听到“一天一次”被描述为“ok”和“只是不连续”之间的酒吧。一周一次真的是问题重重。

你每个月都要进一次,真是太可怕了。当我加入IBM时,我们使用了一个构建系统和一个名为CMVC的代码存储库。就上下文而言,这是大约二十年前的事,我们整个行业都年轻,更愚蠢。我在IBM的第一个工作是帮助构建WebSphereApplicationServer。我们有一个大型的多站点构建,团队每周开会六天,包括星期六,讨论任何构建失败。这个调用有很多关注点,您不希望在WebSphereBuild调用上调用。我刚离开大学,对一个团队的软件开发一无所知,所以一些高级开发人员把我放在他们的翅膀下。我仍然记得的一条建议是,避免在WebSphereBuild调用中的方法是将所有更改保存在本地计算机上六个月,然后将它们全部推到一个批中。

在这个项目上,我还很小,我想,好吧,这似乎不是一个正确的建议,但我想你知道得最好。事后,我意识到WebSphereBuild的崩溃很严重,因为人们在尝试与同事集成之前已经保存了六个月的更改。显然,这没用,我们改变了我们的做事方式。

你应该多久整合一次?

下一个更难的问题是,你应该多久发布一次?就像集成一样,有一系列合理的选择。你可以释放每一个推力。很多科技公司都这么做。如果您在一次迭代中部署一次,那么您仍然处于良好的公司中。一刻一刻都有点难过。你可以每两年发布一次。它现在看起来慢得离谱,但在过去糟糕的日子里,这是我们行业的标准模式

您应该多久部署一次生产?

使部署到生产中的每一个推送都成为可能的原因是部署和发布并不相同。如果我们的新代码太不完整或太吓人,无法实际向用户显示,我们仍然可以部署它,但要将它隐藏起来。我们可以将代码实际放在产品代码库中,但没有任何关联。那很安全。如果我们已经有点太纠结了,我们可以使用特性标志来打开和关闭函数。如果我们觉得更冒险,我们可以做A/B或朋友和家人测试,这样只有一小部分用户看到我们可怕的代码。金丝雀部署是另一个变种预先检测噩梦,在他们击中主流使用。

不释放有两个坏的后果。它延长了反馈周期,这会影响决策,让工程师感到悲伤。从经济上讲,这也意味着有库存(工作软件)摆在货架上,而不是拿出来给客户。精益原则告诉我们,库存闲置,不产生回报,是浪费。

接下来的对话是,为什么我们不能发布这个?什么阻止了更频繁的部署?许多组织害怕他们的微服务,他们想对整个组件进行集成测试,通常是手动集成测试。一位拥有大约60个微服务的客户希望确保,工程师的某些闪光点不可能在不发布其他59个微服务的情况下发布一个微服务。为了实现这一点,他们在一个大批量中为所有的微服务提供了一条管道。这显然不是微服务的价值主张,即它们是可独立部署的。可悲的是,他们觉得这样做最安全。

我们还看到,由于对质量和完整性的担忧,实际上不愿意交付。当然,这些并不可笑。你不想激怒你的顾客。另一方面,正如里德·霍夫曼所说,如果你不为你的第一次发布感到尴尬,那就太晚了。持续改进是有价值的,让事物得到利用也是有价值的。

如果发布不频繁,而且是单一的,那么你就有了这些漂亮的微服务架构,可以让你走得更快,但你走得真的很慢。这是糟糕的生意,也是糟糕的工程。

假设你经常部署。所有保护用户不受半生不熟特性影响的东西,比如自动测试、特性标志、A/B测试、SRE,都需要大量的自动化。通常,当我开始与客户合作时,我们会遇到一个关于测试的问题,他们会说,“哦,我们的测试不是自动化的。”这意味着他们实际上不知道代码是否在任何特定点工作。他们希望它能工作,而且上次检查时它可能已经工作了,但是如果不运行手动测试,我们无法知道它现在是否工作。

问题是,倒退发生了。即使所有的工程师都是最完美的工程师,但外面的世界却不那么完美。他们依赖的系统可能会异常地运行。如果依赖项更新改变了行为,即使没有人做错了什么,也会有一些事情发生破坏。这让我们回到“我们不能发货,因为我们对质量没有信心”。好吧,让我们确定质量的信心,然后我们就可以发货了。

我谈过合同测试。这是便宜和简单的,可以在单元测试级别完成,但是当然,您也需要自动化集成测试。您不希望依赖手动集成测试,否则它们将成为瓶颈。

“CI/CD”似乎已经取代了我们词汇表中的“构建”,但在这两种情况下,它是作为一个工程组织所拥有的最有价值的东西之一。它应该是你的朋友,应该是无处不在的存在。有时候,构建的工作方式是它在Jenkins系统的某个地方运行。有人有点勤奋,不时地去检查网页,发现网页是红色的,然后去告诉同事,最后有人解决了这个问题。更好的是,只是一个被动的构建指标,每个人都可以看到,而不打开一个单独的页面。如果显示器变红了,很明显,有些东西发生了变化,而且很容易看到最近的变化。如果你有一个项目,交通灯就可以工作。如果你有微服务,你可能需要一些像瓷砖一样的东西。即使你没有微服务,你可能会有几个项目,所以你需要比交通灯更完整的东西,即使交通灯很可爱。

“我们不知道什么时候构键坏了”

如果您投资于构建监控,那么您最终会遇到窗口中断的情况。我已经找到了客户,我做的第一件事就是查看了构建,然后我说,“哦,这个构建好像坏了。”他们说,“是的,已经坏了几个星期了。”那时,我知道我有很多工作要做!

为什么烫发坏了?这意味着你不能做自动化集成测试,因为没有什么东西能使它脱离构建。事实上,您甚至不能进行手动集成测试,因此服务间的兼容性可能会恶化,而且没有人会知道。

新的回归不会被发现,因为构建已经是红色的。也许最糟糕的是,它创造了一种文化,这样当其他构建之一变红时,人们就不会那么担心了,因为它更像是:“现在我们有两个红色的。也许我们可以得到整套,然后如果我们把它们都弄红的话,它们就匹配了。

被锁住的完全僵硬的,不灵活的,不云的云

这些都是发生在团队层面的挑战。它们是关于我们作为工程师如何管理我们自己和我们的代码。但是,当然,特别是当你进入一个具有一定规模的组织时,你最终会遇到另一系列的挑战,这就是组织对云所做的。我注意到一些组织喜欢把云变成一个封闭的、完全僵硬的、灵活的、不阴云的云。

你如何使云不阴云密布?你说,“嗯,我知道你可以走得很快,我知道你所有的自动化支持都走得很快,但我们有一个过程。我们有一个架构审查委员会,它很少开会,“它将在项目准备好交付后一个月开会,或者在最坏的情况下,它将在项目交付后一个月开会。即使这东西已经运出去了,我们也要走一趟。该体系结构将在经过实地验证后在纸上进行审查,这是愚蠢的。

有人给我讲过一个故事。一位客户向他们投诉说,IBM卖给他们的一些供应软件不起作用。所发生的事情是,我们承诺,我们漂亮的资源调配软件将允许他们在10分钟内创建虚拟机。这是几年前的事了,那时“十分钟内的虚拟机”是先进而酷的。我们向他们保证会很棒的。

当客户安装并开始使用它时,他们并不觉得它很好。他们本以为可以获得10分钟的资源调配时间,但他们看到的是,他们花了3个月的时间来调配一个云实例。他们回来对我们说,“你的软件完全坏了。你把它卖错了。看,这要花三个月的时间。”我们对此感到困惑,所以我们进去做了一些调查。事实证明,他们已经实施了84步的预批准流程,以获得其中一个实例。

“此配置软件已损坏”

技术在那里,但是文化不在那里,所以技术不起作用。这太可悲了。我们拿这个云来说,它是一个美丽的云,它有所有这些奇妙的属性,它让一切变得非常简单,然后组织的另一部分说,“哦,这有点可怕。我们不希望人们真的能做事。我们把它关在笼子里吧!”那种旧式的繁文缛节式的治理是行不通的——而且对每个人来说都很烦人。它不会给出结果。更糟糕的是,这并不能让事情变得更安全。这可能会让他们更不安全。这肯定会让事情变得更慢、更费钱。我们不应该这么做。

我和另一个客户,一家大型汽车公司谈过,他们的云资源调配确实有问题。获取实例需要很长时间。他们认为,“我们要解决这个问题的方法是从供应商A转移到供应商B。”这可能是可行的,只是他们的内部采购实际上很慢。转换供应商将绕过其已建立的采购流程,因此可能会在一段时间内加快速度,但最终,他们的治理团队会注意到新供应商,并实施控制。一旦发生了这种情况,他们就会实施监管,恢复现状。他们本可以承担所有的改变成本,但实际上却没有任何好处。这有点像-我很抱歉地说,我有时很想这样做-如果你看着你的炉子,你决定,“哦,那炉子很脏。打扫会很困难,所以我要搬家,这样我就不用打扫烤箱了。”但是,当然,同样的事情也会发生在另一所房子里,新的烤箱也会变脏。你需要一个更可持续的过程,而不仅仅是更换供应商,以试图超过自己的采购。

如果只有开发人员在改变,如果只有开发人员在使用云计算,那么它就行不通了。这并不意味着一个开发者驱动的免费模式是正确的。如果没有一些治理围绕着它,那么云可以成为一个神秘的钱坑。我们中的许多人都有这样的问题:看着一张云账单,心里想着“嗯,是的,那么大,我不知道这是怎么回事,也不知道是谁在做。”

用云提供硬件是如此容易,但这并不意味着硬件是免费的。还得有人付钱。容易配置的硬件也不能保证硬件是有用的。

当我第一次学习Kubernetes的时候,我当然试过了。我创建了一个集群,但后来我被跟踪了,因为我有太多的工作在进行中。两个月后,我回到我的集群,发现这个集群£一个月1000英镑…而且完全没有价值。那太浪费了,我想起来还是畏缩。

我们的技术允许我们做的很多事情就是让事情更有效率。伟大的管理顾问彼得德鲁克(peterdrucker)说:“没有什么比高效地做那些根本不应该做的事情更无用的了。”高效地创建没有价值的Kubernetes集群是不好的。除了价格昂贵,还有生态影响。有一个库伯内特斯群£价值1000英镑的电能什么都不做对地球不是很好。

对于我描述的许多问题,一开始看起来像是技术问题,实际上是人的问题。我觉得这个有点不同,因为这个看起来像是人的问题,实际上是技术问题。这是一个工具实际上可以提供帮助的领域。例如,工具可以通过检测未使用的服务器并帮助我们将服务器追溯到发起人来帮助我们管理浪费。目前还没有实现这一点的工具,但它正变得越来越成熟。

云来管理你的云

这个云管理工具最终在云上,因此您最终处于递归状态,需要一些云来管理您的云。我的公司有一个多云管理器,它可以查看您的工作负载,计算出工作负载的形状,以及您可以在财务上拥有它的最佳提供商,然后自动进行移动。我想我们可能会看到越来越多这样的软件,它看着它说,“顺便说一句,我可以告诉你,实际上已经有两个月没有流量到他的Kubernetes集群了。你为什么不和霍莉说几句话呢?”

微服务运维混乱

管理云成本变得越来越复杂,这反映了一个更普遍的情况,即云操作越来越复杂。我们正在使用越来越多的云提供商。越来越多的云实例如雨后春笋般涌现。我们到处都有星团,那我们到底该怎么做呢?这就是SRE(站点可靠性工程)的用武之地。

站点可靠性工程旨在使操作更具可重复性和更少的繁琐,以使服务更可靠。它实现这一点的方法之一是将一切自动化,我认为这是一个令人钦佩的目标。我们越是自动化发布之类的事情,我们就越能做到这一点,这对工程师和消费者都有好处。最终的目标应该是释放不是一个事件;一切照旧。

使发布变得非常枯燥。

我们对可恢复性充满信心,而正是SRE给了我们对可恢复性的信心。

我有另一个悲惨的太空故事,这次来自苏联。上世纪80年代,一位工程师想对苏联名为“火卫一”的太空探测器的代码进行更新。当时,是机器代码,都是0和1,都是手写的。很明显,你不想在没有检查的情况下,用手写的机器代码对环绕地球飞行的航天器进行实时更新。在任何推送之前,代码将通过一个验证器,这相当于机器代码的一个linter。

这很有效,直到自动检查器被破坏,需要进行更改。一位工程师说:“哦,但我真的很想做这个改变。我将绕过自动检查,直接把我的代码推送到太空探测器上,因为,当然,我的代码是完美的。”于是他们用手写的机器代码,在没有检查的情况下,对环绕地球飞行的航天器进行了实时更新。可能会出什么问题?

所发生的是一个非常微妙的错误。事情似乎进展顺利。不幸的是,工程师忘记了其中一条指令上的一个零。这将指令从预期指令更改为停止探针充电鳍旋转的指令。火卫一的鳍朝向太阳,这样它就可以收集太阳能,不管它面对的是什么方向。在电池没电之前的两天里,一切正常。一旦探测器没电了,他们就无能为力,因为整个探测器都死了。

这是一个完全不可恢复的系统的例子。一旦它死了,你就再也拿不回来了。你不能只是做些什么然后把它恢复到一个干净的太空探测代码的副本中,因为它在太空中。

像这样的系统是不可恢复的。我们中的许多人相信,我们所有的系统几乎都像太空探测器一样不可恢复,但事实上,很少有系统是可恢复的。

我们真正想要的是在这个频谱的顶端,在那里我们可以在毫秒内返回,没有数据丢失。如果出了什么问题,就说“平,修好了”。这真的很难达到,但有一大堆中间点是现实的目标。

如果我们恢复得很快,但数据丢失了,那就不太好了,但我们可以接受。如果我们有交接和人工干预,那么对经济复苏来说会慢得多。当我们考虑频繁地部署并且非常无聊地部署时,我们希望确信我们已经达到了上限。我们到达那里的方式,切换不好,自动化,好。

云计算的成功之道

这篇文章包含了一大堆关于我所看到的可能出错的悲惨故事。我不想给你留下这样的印象:每件事都会出问题,因为很多时候,事情确实进展得很好。CloudNative是开发软件的一种很好的方式,它可以让团队感觉更好,降低成本,让用户更快乐。作为工程师,我们可以花更少的时间在工作上,花更多的时间在我们真正想做的事情上……而且我们可以更快地进入市场。

为了达到这种快乐的状态,我们必须在整个组织中保持一致。我们不能让一个小组说“微服务”,一个小组说“快速”,一个小组说“旧式治理”。这几乎肯定行不通,会有很多脾气暴躁的工程师和愤愤不平的财务官员。相反,一个组织应该在一个整体的层面上同意它试图实现的目标。一旦这个目标达成一致,它应该优化反馈,确保反馈循环尽可能短,因为这是合理的工程。

关于作者

霍莉·康明斯是IBM公司战略的创新领导者,曾在IBM车库担任过几年顾问。作为车库的一部分,她为各个行业的客户提供技术创新,从银行到餐饮,从零售到非政府组织。Holly是Oracle Java冠军、IBM Q大使和JavaOne摇滚明星。她与人合著了曼宁的《行动中的企业OSGi》。

原文:https://www.infoq.com/articles/cloud-native-culture

本文:http://jiagoushi.pro/node/1506

讨论:请加入知识星球【首席架构师圈】或者小号【cea_csa_cto】或者QQ【2808908662】

- 85 次浏览

云架构

【云应用架构】Azure 云设计模式概览

这些设计模式对于在云中构建可靠、可扩展、安全的应用程序很有用。

每个模式都描述了该模式解决的问题、应用该模式的注意事项以及一个基于 Microsoft Azure 的示例。 大多数模式都包含代码示例或代码片段,它们展示了如何在 Azure 上实现该模式。 但是,大多数模式都与任何分布式系统相关,无论是托管在 Azure 上还是其他云平台上。

云开发面临的挑战

数据管理

数据管理是云应用的关键要素,影响着大部分质量属性。出于性能、可扩展性或可用性等原因,数据通常托管在不同的位置并跨多个服务器,这可能会带来一系列挑战。例如,必须保持数据一致性,并且数据通常需要跨不同位置同步。

设计与实施

好的设计包括组件设计和部署的一致性和连贯性、简化管理和开发的可维护性以及允许组件和子系统在其他应用程序和其他场景中使用的可重用性等因素。在设计和实施阶段做出的决策对云托管应用程序和服务的质量和总拥有成本产生巨大影响。

消息

云应用程序的分布式特性需要一个连接组件和服务的消息传递基础架构,理想情况下以松散耦合的方式来最大化可扩展性。异步消息传递被广泛使用,并提供了许多好处,但也带来了诸如消息排序、毒消息管理、幂等性等挑战。

模式目录

- 77 次浏览

【云架构】Azure虚拟数据中心:网络透视图

概观

将本地应用程序迁移到Azure为组织提供了安全且经济高效的基础架构的优势,即使应用程序迁移的变化很小。但是,为了充分利用云计算的灵活性,企业必须改进其架构以利用Azure功能。

Microsoft Azure提供具有企业级功能和可靠性的超大规模服务和基础架构。这些服务和基础架构提供了多种混合连接选择,因此客户可以选择通过公共Internet或私有Azure ExpressRoute连接访问它们。 Microsoft合作伙伴还通过提供经过优化以在Azure中运行的安全服务和虚拟设备来提供增强功能。

客户可以选择通过互联网或Azure ExpressRoute访问这些云服务,Azure ExpressRoute提供专用网络连接。借助Microsoft Azure平台,客户可以将其基础架构无缝扩展到云中并构建多层架构。 Microsoft合作伙伴还通过提供经过优化以在Azure中运行的安全服务和虚拟设备来提供增强功能。

什么是虚拟数据中心?

从一开始,云就是一个托管面向公众的应用程序的平台。企业开始了解云的价值,并开始将内部业务线应用程序迁移到云端。这些类型的应用程序带来了额外的安全性,可靠性,性能和成本考虑因素,这需要在提供云服务方面提供额外的灵活性。这为旨在提供这种灵活性的新基础架构和网络服务铺平了道路,同时也为扩展,灾难恢复和其他考虑因素提供了新功能。

云解决方案最初设计用于在公共频谱中托管单个相对隔离的应用程序。这种方法运作良好几年。然后,云解决方案的好处变得明显,并且在云上托管了多个大规模工作负载。解决一个或多个区域中部署的安全性,可靠性,性能和成本问题在整个云服务生命周期中变得至关重要。

以下云部署图显示了红色框中的安全间隙示例。黄色框显示了跨工作负载优化网络虚拟设备的空间。

虚拟数据中心(VDC)的概念源于扩展以支持企业工作负载的必要性,同时平衡处理在公共云中支持大规模应用程序时引入的问题的需求。

VDC实施不仅代表云中的应用程序工作负载,还代表网络,安全性,管理和基础架构(例如,DNS和目录服务)。随着越来越多的企业工作负载转移到Azure,重要的是要考虑这些工作负载所依赖的支持基础架构和对象。仔细考虑资源的结构可以避免必须管理的数百个“工作负载孤岛”的扩散分别具有独立的数据流,安全模型和合规性挑战。

VDC概念是一组建议和最佳实践,用于实现具有共同支持功能,特性和基础结构的单独但相关的实体的集合。通过VDC的镜头查看您的工作负载,您可以实现由于规模经济而降低的成本,通过组件和数据流集中优化的安全性,以及更轻松的操作,管理和合规性审计。

注意

重要的是要了解VDC不是一个独立的Azure产品,而是各种功能和功能的组合,以满足您的确切要求。 VDC是一种考虑您的工作负载和Azure使用情况的方法,可以最大限度地提高云中的资源和功能。这是一种在Azure中构建IT服务的模块化方法,同时尊重企业的组织角色和职责。

VDC实施可以帮助企业在以下方案中将工作负载和应用程序迁移到Azure中:

- 托管多个相关工作负载。

- 将工作负载从本地环境迁移到Azure。

- 跨工作负载实施共享或集中的安全性和访问要求。

- 为大型企业适当地混合Azure DevOps和集中式IT。

解锁VDC优势的关键是集中式中心和分支网络拓扑结构,其中包含Azure服务和功能:

- Azure Virtual Network,

- Network security groups,

- Virtual network peering,

- User-defined routes, and

- Azure Identity with role-based access control (RBAC) and optionally Azure Firewall, Azure DNS, Azure Front Door, and Azure Virtual WAN.

谁应该实施虚拟数据中心?

任何决定采用云的Azure客户都可以从配置一组资源的效率中受益,供所有应用程序共同使用。根据规模,即使是单个应用程序也可以从使用用于构建VDC实现的模式和组件中受益。

如果您的组织拥有用于IT,网络,安全性或合规性的集中式团队或部门,那么实施VDC可以帮助实施策略点,职责分离,并确保底层公共组件的一致性,同时为应用程序团队提供尽可能多的自由和控制。适合您的要求。

正在寻找DevOps的组织也可以使用VDC概念来提供授权的Azure资源,并确保他们在该组内具有完全控制权(公共订阅中的订阅或资源组),但网络和安全边界保持合规通过集线器VNet和资源组中的集中策略。

实施虚拟数据中心的注意事项

在设计VDC实施时,需要考虑几个关键问题:

身份和目录服务

身份和目录服务是所有数据中心的关键方面,包括本地和云。身份与VDC实施中的服务访问和授权的所有方面相关。为帮助确保只有授权用户和进程访问Azure帐户和资源,Azure使用多种类型的凭据进行身份验证。其中包括密码(访问Azure帐户),加密密钥,数字签名和证书。 Azure多重身份验证是访问Azure服务的附加安全层。多重身份验证通过一系列简单的验证选项(电话,短信或移动应用程序通知)提供强大的身份验证,并允许客户选择他们喜欢的方法。

任何大型企业都需要定义身份管理流程,该流程描述VDC实施内部或跨VDC实施的个人身份,身份验证,授权,角色和权限的管理。此过程的目标应该是提高安全性和生产力,同时降低成本,停机时间和重复的手动任务。

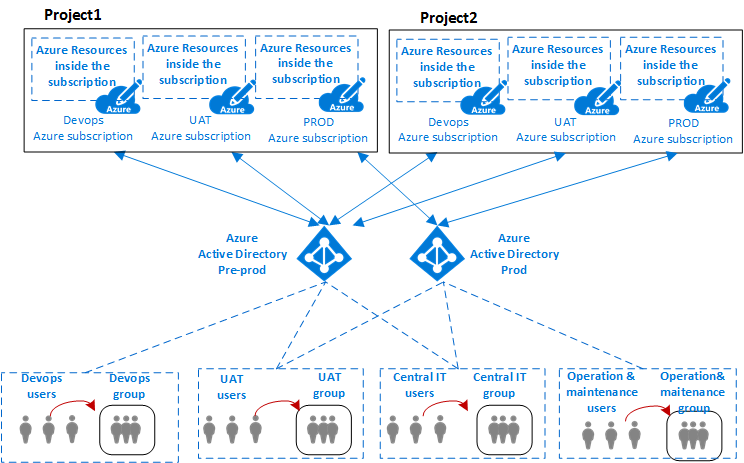

企业组织可能需要针对不同业务线的高要求的服务组合,并且员工在涉及不同项目时通常具有不同的角色。 VDC要求不同团队之间的良好合作,每个团队都有特定的角色定义,以使系统运行良好的治理。责任,访问和权利矩阵可能很复杂。 VDC中的身份管理是通过Azure Active Directory(Azure AD)和基于角色的访问控制(RBAC)实现的。

目录服务是一种共享信息基础结构,用于定位,管理,管理和组织日常项目和网络资源。这些资源可以包括卷,文件夹,文件,打印机,用户,组,设备和其他对象。目标服务器将网络上的每个资源视为对象。有关资源的信息存储为与该资源或对象关联的属性的集合。

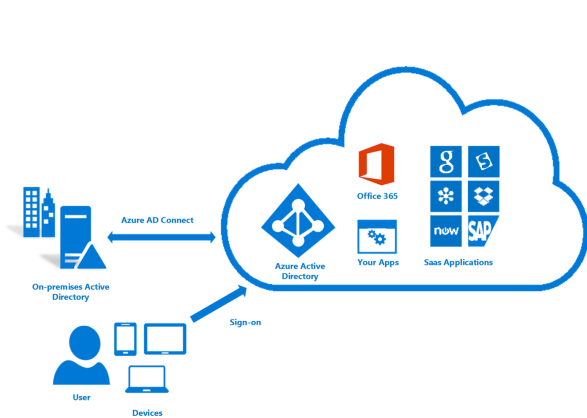

所有Microsoft在线业务服务都依赖Azure Active Directory(Azure AD)来登录和其他身份需求。 Azure Active Directory是一种全面,高度可用的身份和访问管理云解决方案,它结合了核心目录服务,高级身份管理和应用程序访问管理。 Azure AD可以与本地Active Directory集成,以便为所有基于云和本地托管的本地应用程序启用单点登录。本地Active Directory的用户属性可以自动同步到Azure AD。

单个全局管理员不需要在VDC实现中分配所有权限。相反,目录服务中的每个特定部门,用户组或服务都可以拥有在VDC实施中管理自己的资源所需的权限。构建权限需要平衡。权限过多会影响性能效率,权限过少或松散会增加安全风险。 Azure基于角色的访问控制(RBAC)通过为VDC实施中的资源提供细粒度的访问管理,有助于解决此问题。

安全基础设施

安全基础结构是指VDC实现的特定虚拟网段中的流量隔离。该基础结构指定了如何在VDC实现中控制入口和出口。 Azure基于多租户架构,可通过使用VNet隔离,访问控制列表(ACL),负载平衡器,IP过滤器和流量策略来防止部署之间的未授权和无意的流量。网络地址转换(NAT)将内部网络流量与外部流量分开。

Azure结构将基础架构资源分配给租户工作负载,并管理与虚拟机(VM)之间的通信。 Azure虚拟机管理程序强制虚拟机之间的内存和进程分离,并安全地将网络流量路由到客户操作系统租户。

连接到云

VDC实施需要连接到外部网络,以便为客户,合作伙伴和/或内部用户提供服务。这种连接需求不仅指互联网,还指本地网络和数据中心。

客户通过使用Azure防火墙或其他类型的虚拟网络设备(NVA),使用用户定义的路由的自定义路由策略以及使用网络安全组的网络过滤来控制哪些服务可以访问并可从公共Internet访问。我们建议所有面向Internet的资源也受Azure DDoS保护标准的保护。

企业可能需要将其VDC实施连接到本地数据中心或其他资源。在设计有效的体系结构时,Azure与本地网络之间的这种连接是一个至关重要的方面。企业有两种不同的方式来创建这种互连:通过互联网传输或通过私人直接连接。

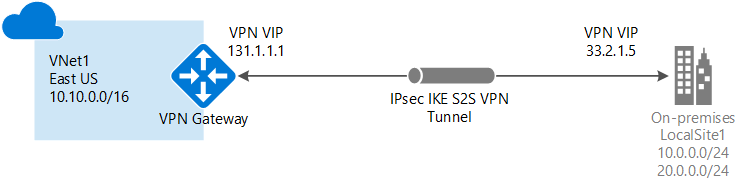

Azure站点到站点VPN是通过安全加密连接(IPsec / IKE隧道)建立的本地网络和VDC实施之间的Internet上的互连服务。 Azure站点到站点的连接非常灵活,可以快速创建,并且不需要任何进一步的采购,因为所有连接都通过Internet连接。

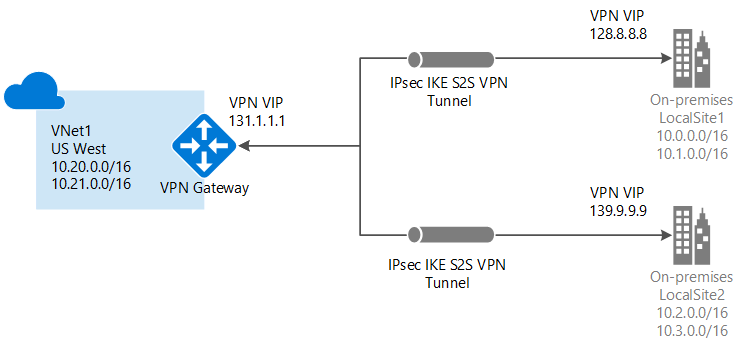

对于大量VPN连接,Azure虚拟WAN是一种网络服务,可通过Azure提供优化的自动分支到分支连接。虚拟WAN允许您连接和配置分支设备以与Azure通信。连接和配置可以手动完成,也可以通过虚拟WAN伙伴使用首选提供商设备完成。使用首选提供程序设备可以简化使用,简化连接和配置管理。 Azure WAN内置仪表板提供即时故障排除洞察,可帮助您节省时间,并为您提供查看大规模站点到站点连接的简便方法。

ExpressRoute是一种Azure连接服务,可在VDC实施与任何本地网络之间实现专用连接。 ExpressRoute连接不会通过公共Internet,提供更高的安全性,可靠性和更高的速度(高达10 Gbps)以及一致的延迟。 ExpressRoute对VDC实施非常有用,因为ExpressRoute客户可以获得与私有连接相关的合规性规则的好处。使用ExpressRoute Direct,您可以以100 Gbps的速度直接连接到Microsoft路由器,以满足具有更大带宽需求的客户。

部署ExpressRoute连接通常涉及与ExpressRoute服务提供商合作。对于需要快速启动的客户,通常最初使用站点到站点VPN在VDC实施和本地资源之间建立连接,然后在与服务提供商的物理互连完成后迁移到ExpressRoute连接。

云中的连接

VNets和VNet对等是VDC实现中的基本网络连接服务。 VNet保证了VDC资源的自然隔离边界,VNet对等允许同一Azure区域内甚至跨区域的不同VNets之间的相互通信。 VNet内部和VNets之间的流量控制需要匹配通过访问控制列表(网络安全组),网络虚拟设备和自定义路由表(用户定义的路由)指定的一组安全规则。

虚拟数据中心概述

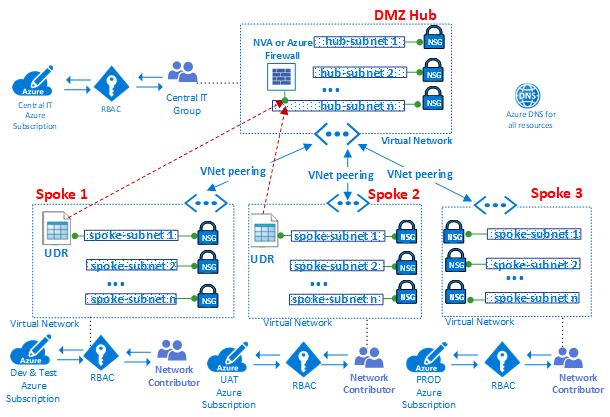

拓扑

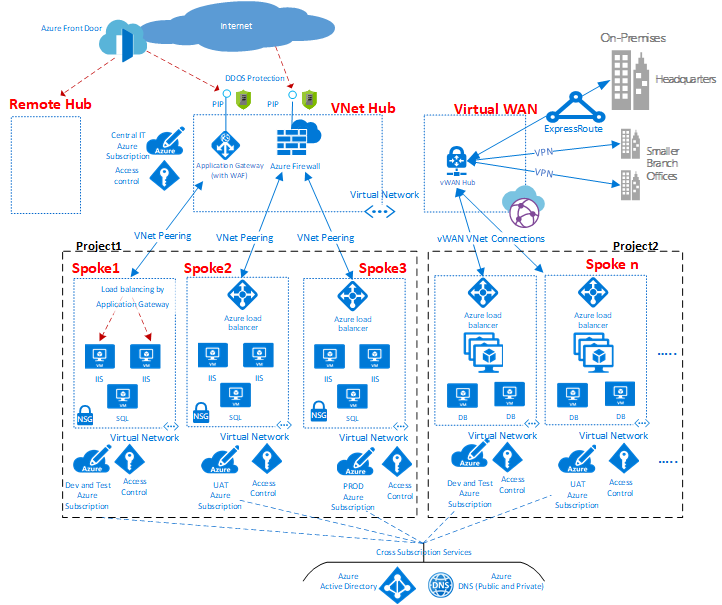

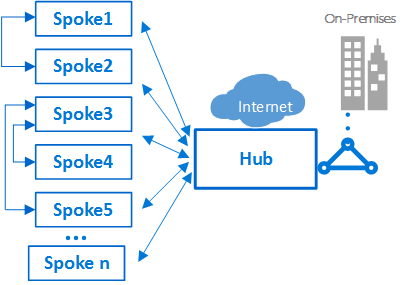

Hub and spoke是用于为虚拟数据中心实现设计网络拓扑的模型。

如图所示,Azure中可以使用两种类型的中心和辐条设计。用于通信,共享资源和集中安全策略(图中的VNet Hub),或虚拟WAN类型(图中的虚拟WAN),用于大规模分支到分支和分支到Azure通信。

集线器是中央网络区域,用于控制和检查不同区域之间的入口或出口流量:互联网,内部部署和辐条。中心和分支拓扑为IT部门提供了一种在中央位置实施安全策略的有效方法。它还可以减少错误配置和暴露的可能性。

集线器通常包含辐条消耗的公共服务组件。以下示例是常见的中央服务:

- Windows Active Directory基础结构,用于对从不受信任的网络访问的第三方进行用户身份验证,然后才能访问分支中的工作负载。它包括相关的Active Directory联合身份验证服务(AD FS)。

- 一种DNS服务,用于解析辐条中工作负载的命名,如果未使用Azure DNS,则访问本地和Internet上的资源。

- 公钥基础结构(PKI),用于在工作负载上实现单点登录。

- 辐条网络区域和互联网之间的TCP和UDP流量的流量控制。

- 辐条和内部部署之间的流量控制。

- 如果需要,可以在一个辐条和另一个辐条之间进

VDC通过在多个辐条之间使用共享中心基础设施来降低总体成本。

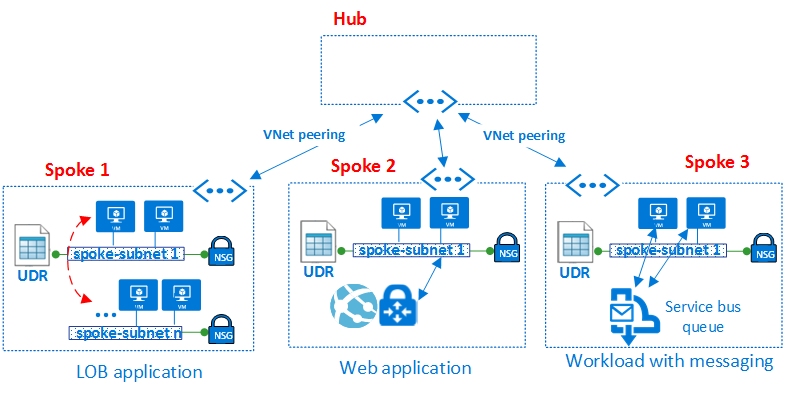

每个辐条的角色可以是托管不同类型的工作负载。辐条还提供了一种模块化方法,可以重复部署相同的工作负载。例如开发和测试,用户验收测试,预生产和生产。辐条还可以隔离并启用组织内的不同组。 Azure DevOps组就是一个例子。在辐条内部,可以部署基本工作负载或复杂的多层工作负载,并在层之间进行流量控制。

订阅限制和多个集线器

在Azure中,每个组件(无论何种类型)都部署在Azure订阅中。在不同Azure订阅中隔离Azure组件可以满足不同LOB的要求,例如设置差异化的访问和授权级别。

单个VDC实施可以扩展到大量辐条,但是,与每个IT系统一样,存在平台限制。中心部署绑定到特定的Azure订阅,该订阅具有限制和限制(例如,最大数量的VNet对等;有关详细信息,请参阅Azure订阅和服务限制,配额和约束)。在限制可能成为问题的情况下,通过将模型从单个集线器辐条扩展到集线器和辐条集群,架构可以进一步扩展。可以使用VNet对等,ExpressRoute,虚拟WAN或站点到站点VPN来连接一个或多个Azure区域中的多个集线器。

多个集线器的引入增加了系统的成本和管理工作量。只有通过可扩展性,系统限制或冗余以及最终用户性能或灾难恢复的区域复制才能证明这一点。在需要多个集线器的场景中,所有集线器都应努力提供相同的服务集,以便于操作。

辐条之间的互连

在单个辐条中,可以实现复杂的多层工作负载。可以使用同一VNet中的子网(每个层一个)实现多层配置,并使用网络安全组过滤流。

架构师可能希望跨多个虚拟网络部署多层工作负载。通过虚拟网络对等,辐条可以连接到同一集线器或不同集线器中的其他辐条。此方案的典型示例是应用程序处理服务器位于一个辐条或虚拟网络中的情况。数据库部署在不同的辐条或虚拟网络中。在这种情况下,很容易将辐条与虚拟网络对等互连,从而避免通过集线器进行转换。应执行仔细的体系结构和安全性检查,以确保绕过集线器不会绕过可能仅存在于集线器中的重要安全性或审核点。

辐条也可以与作为集线器的辐条互连。此方法创建两级层次结构:较高级别(级别0)的轮辐成为层次结构的较低轮辐(级别1)的中心。 VDC实施的辐条需要将流量转发到中央集线器,以便流量可以在本地网络或公共互联网中传输到其目的地。具有两级集线器的体系结构引入了复杂的路由,消除了简单的集线器 - 辐条关系的好处。

虽然Azure允许复杂的拓扑结构,但VDC概念的核心原则之一是可重复性和简单性。为了最大限度地减少管理工作,简单的中心辐条设计是我们推荐的VDC参考架构。

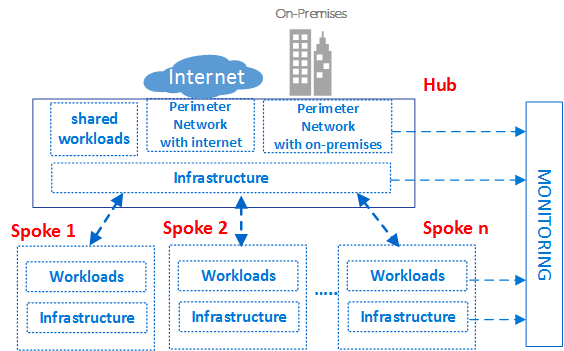

组件

虚拟数据中心由四种基本组件类型组成:基础架构,外围网络,工作负载和监控。

每种组件类型都包含各种Azure功能和资源。您的VDC实现由多个组件类型的实例和相同组件类型的多个变体组成。例如,您可能有许多不同的,逻辑上分离的工作负载实例,它们代表不同的应用程序。您可以使用这些不同的组件类型和实例来最终构建VDC。

前面的VDC高级概念体系结构显示了在轮辐辐射拓扑的不同区域中使用的不同组件类型。该图显示了体系结构各个部分中的基础结构组件。

作为一般的良好实践,访问权限和特权应该是基于组的。处理组而不是单个用户可以通过提供跨团队管理它的一致方式来简化访问策略的维护,并有助于最大限度地减少配置错误。在适当的组中分配和删除用户有助于使特定用户的权限保持最新。

每个角色组的名称都应该有唯一的前缀。此前缀可以轻松识别哪个组与哪个工作负载相关联。例如,托管身份验证服务的工作负载可能具有名为AuthServiceNetOps,AuthServiceSecOps,AuthServiceDevOps和AuthServiceInfraOps的组。集中角色或与特定服务无关的角色可能以公司为前提。例如CorpNetOps。

许多组织使用以下组的变体来提供角色的主要细分:

- 中央IT集团Corp拥有控制基础架构组件的所有权。网络和安全性的例子。该组需要在订阅,控制中心以及辐条中的网络参与者权限方面担任贡献者。大型组织经常在多个团队之间分配这些管理职责。例如,网络运营CorpNetOps小组专门关注网络和安全运营CorpSecOps小组负责防火墙和安全策略。在这种特定情况下,需要创建两个不同的组来分配这些自定义角色。

- 开发测试组AppDevOps负责部署应用程序或服务工作负载。该组担任IaaS部署或一个或多个PaaS贡献者角色的虚拟机贡献者角色。请参阅Azure资源的内置角色。可选地,开发/测试团队可能需要对集线器内的安全策略(网络安全组)和路由策略(用户定义的路由)或特定辐条进行可见性。除了工作负载的贡献者角色之外,该组还需要网络阅读器的角色。

- 运营和维护组CorpInfraOps或AppInfraOps负责管理生产中的工作负载。该组需要成为任何生产订阅中的工作负载的订阅贡献者。一些组织还可能评估他们是否需要一个额外的升级支持团队组,其中包括生产中的订阅贡献者和中心中心订阅。附加组修复了生产环境中的潜在配置问题。

VDC的设计使得为管理集线器的中央IT组创建的组在工作负载级别具有相应的组。除了仅管理中心资源外,中央IT组还能够控制订阅的外部访问和顶级权限。工作负载组还能够独立于中央IT控制其VNet的资源和权限。

VDC被分区以跨不同的业务线(LOB)安全地托管多个项目。所有项目都需要不同的隔离环境(Dev,UAT,生产)。针对每个环境的单独Azure订阅提供了自然隔离。

上图显示了组织的项目,用户和组与部署Azure组件的环境之间的关系。

通常在IT中,环境(或层)是部署和执行多个应用程序的系统。大型企业使用开发环境(进行更改和测试)和生产环境(最终用户使用的环境)。这些环境是分开的,通常在它们之间有几个暂存环境,以便在出现问题时允许分阶段部署(部署),测试和回滚。部署体系结构差别很大,但通常仍然遵循从开发(DEV)开始到生产结束(PROD)的基本过程。

这些类型的多层环境的通用体系结构包括用于开发和测试的Azure DevOps,用于分段的UAT和生产环境。组织可以利用单个或多个Azure AD租户来定义对这些环境的访问权限。上图显示了使用两个不同Azure AD租户的情况:一个用于Azure DevOps和UAT,另一个用于生产。

不同Azure AD租户的存在会强制实现环境之间的分离。同一组用户(例如中央IT)需要使用不同的URI进行身份验证,以访问不同的Azure AD租户,以修改Azure DevOps或项目的生产环境的角色或权限。访问不同环境的不同用户身份验证的存在减少了由人为错误导致的可能中断和其他问题。

组件类型:基础设施

此组件类型是大多数支持基础结构所在的位置。这也是您的集中式IT,安全和合规团队花费大部分时间的地方。

基础设施组件为VDC实施的不同组件提供互连,并且存在于集线器和辐条中。管理和维护基础架构组件的责任通常分配给中央IT和/或安全团队。

IT基础架构团队的主要任务之一是保证整个企业中IP地址架构的一致性。分配给VDC实施的专用IP地址空间必须一致,且不与内部部署网络上分配的专用IP地址重叠。

虽然本地边缘路由器或Azure环境中的NAT可以避免IP地址冲突,但它会增加基础架构组件的复杂性。管理的简单性是VDC的关键目标之一,因此使用NAT来处理IP问题并不是一种推荐的解决方案。

基础架构组件具有以下功能:

- 身份和目录服务。 Azure中对每种资源类型的访问权限由存储在目录服务中的标识控制。目录服务不仅存储用户列表,还存储特定Azure订阅中资源的访问权限。这些服务可以仅存在于云中,也可以与存储在Active Directory中的本地标识同步。

- 虚拟网络。虚拟网络是VDC的主要组件之一,使您能够在Azure平台上创建流量隔离边界。虚拟网络由单个或多个虚拟网段组成,每个网段都有一个特定的IP网络前缀(子网)。虚拟网络定义了一个内部周边区域,IaaS虚拟机和PaaS服务可以在其中建立私人通信。一个虚拟网络中的VM(和PaaS服务)无法直接与不同虚拟网络中的VM(和PaaS服务)通信,即使两个虚拟网络都是由同一客户在同一订阅下创建的。隔离是一项关键属性,可确保客户虚拟机和通信在虚拟网络中保持私密。

- 用户定义的路由。默认情况下,基于系统路由表路由虚拟网络中的流量。用户定义的路由是自定义路由表,网络管理员可以将其关联到一个或多个子网,以覆盖系统路由表的行为并定义虚拟网络中的通信路径。用户定义路由的存在可确保来自分支的出口流量通过特定的自定义VM或网络虚拟设备以及集线器和辐条中存在的负载平衡器进行传输。

- 网络安全组。网络安全组是一组安全规则,用作IP源,IP目标,协议,IP源端口和IP目标端口的流量过滤。网络安全组可以应用于子网,与Azure VM关联的虚拟NIC卡,或两者。网络安全组对于在集线器和辐条中实施正确的流量控制至关重要。网络安全组提供的安全级别是您打开的端口以及用于何种目的的功能。客户应该使用基于主机的防火墙(如IPtables或Windows防火墙)应用其他每个VM过滤器。

- DNS。 VDC实施的VNets中的资源名称解析通过DNS提供。 Azure为公共和专用名称解析提供DNS服务。专用区域在虚拟网络和虚拟网络中提供名称解析。您可以让私有区域不仅跨越同一区域中的虚拟网络,还跨越区域和订阅。对于公共解决方案,Azure DNS为DNS域提供托管服务,使用Microsoft Azure基础结构提供名称解析。通过在Azure中托管您的域,您可以使用与其他Azure服务相同的凭据,API,工具和计费来管理DNS记录。

- 订阅和资源组管理。订阅定义了在Azure中创建多组资源的自然边界。订阅中的资源在名为“资源组”的逻辑容器中组合在一起。资源组表示组织VDC实现资源的逻辑组。

- RBAC。通过RBAC,可以映射组织角色以及访问特定Azure资源的权限,从而允许您将用户限制为仅某个操作子集。使用RBAC,您可以通过为相关范围内的用户,组和应用程序分配适当的角色来授予访问权限。角色分配的范围可以是Azure订阅,资源组或单个资源。 RBAC允许继承权限。在父作用域中分配的角色也授予对其中包含的子项的访问权限。使用RBAC,您可以分离职责并仅授予他们执行工作所需的用户访问权限。例如,使用RBAC让一个员工管理订阅中的虚拟机,而另一个员工可以管理同一订阅中的SQL DB。

- VNet对等。用于创建VDC基础结构的基本功能是VNet Peering,这是一种通过Azure数据中心网络连接同一区域中的两个虚拟网络(VNets)的机制,或跨区域使用Azure全球主干网的机制。

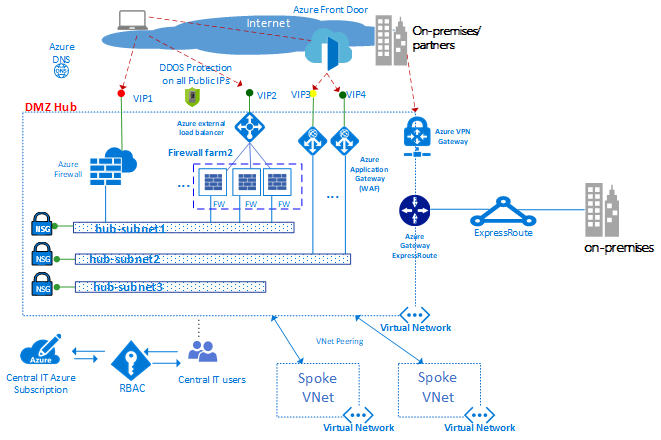

组件类型:周边网络

外围网络组件支持本地或物理数据中心网络之间的网络连接,以及与Internet之间的任何连接。这也是您的网络和安全团队可能花费大部分时间的地方。

传入数据包应在到达辐条中的后端服务器之前流经集线器中的安全设备。例如防火墙,IDS和IPS。在离开网络之前,来自工作负载的互联网数据包也应该流经外围网络中的安全设备。此流程的目的是策略执行,检查和审计。

外围网络组件提供以下功能:

- 虚拟网络,用户定义的路由和网络安全组

- 网络虚拟设备

- Azure负载均衡器

- 具有Web应用程序防火墙(WAF)的Azure应用程序网关

- 公共知识产权

- Azure前门与Web应用程序防火墙(WAF)

- Azure防火墙

通常,中央IT和安全团队负责外围网络的需求定义和操作。

上图显示了两个可以访问互联网和本地网络的周边的强制执行,两者都驻留在DMZ中心。在DMZ中心,使用Web应用防火墙(WAF)和/或Azure防火墙的多个服务器场,可以扩展到Internet的外围网络以支持大量LOB。在集线器中还允许根据需要通过VPN或ExpressRoute进行连接。

- 虚拟网络。集线器通常构建在具有多个子网的虚拟网络上,以托管不同类型的服务,这些服务通过NVA,WAF和Azure应用程序网关实例过滤和检查进出互联网的流量。

- 用户定义的路由使用用户定义的路由,客户可以部署防火墙,IDS / IPS和其他虚拟设备,并通过这些安全设备路由网络流量,以实施安全边界策略,审计和检查。可以在集线器和辐条中创建用户定义的路由,以保证流量通过VDC实施使用的特定自定义VM,网络虚拟设备和负载平衡器进行转换。为了保证驻留在分支中的虚拟机生成的流量转移到正确的虚拟设备,需要在分支的子网中设置用户定义的路由,方法是将内部负载均衡器的前端IP地址设置为下一个-跳。内部负载均衡器将内部流量分配给虚拟设备(负载均衡器后端池)。

- Azure防火墙是一种托管的,基于云的网络安全服务,可保护您的Azure虚拟网络资源。它是一个完全状态的防火墙,具有内置的高可用性和不受限制的云可扩展性。您可以跨订阅和虚拟网络集中创建,实施和记录应用程序和网络连接策略。 Azure防火墙为您的虚拟网络资源使用静态公共IP地址。它允许外部防火墙识别源自您的虚拟网络的流量。该服务与Azure Monitor完全集成,用于记录和分析。

- 网络虚拟设备。在集线器中,可访问Internet的外围网络通常通过Azure防火墙实例或防火墙或Web应用程序防火墙(WAF)进行管理。

- 不同的LOB通常使用许多Web应用程序。这些应用程序往往遭受各种漏洞和潜在的攻击。 Web应用程序防火墙是一种特殊类型的产品,用于检测针对Web应用程序(HTTP / HTTPS)的攻击,比通用防火墙更深入。与传统防火墙技术相比,WAF具有一组保护内部Web服务器免受威胁的特定功能。

- Azure防火墙或NVA防火墙都使用通用管理平面,具有一组安全规则来保护辐条中托管的工作负载,并控制对本地网络的访问。 Azure防火墙内置可扩展性,而NVA防火墙可以在负载均衡器后面手动扩展。通常,与WAF相比,防火墙场具有较少的专用软件,但具有更广泛的应用范围,可以过滤和检查出口和入口中的任何类型的流量。如果使用NVA方法,则可以从Azure市场中找到并部署它们。

- 对于源自Internet的流量使用一组Azure防火墙(或NVA),对于源自本地的流量使用另一组Azure防火墙(或NVA)。两者仅使用一组防火墙是一种安全风险,因为它在两组网络流量之间不提供安全边界。使用单独的防火墙层可以降低检查安全规则的复杂性,并明确哪些规则对应于哪个传入网络请求。

- 我们建议您使用一组Azure防火墙实例或NVA来处理源自Internet的流量。使用另一个用于源自本地的流量。两者仅使用一组防火墙是一种安全风险,因为它在两组网络流量之间不提供安全边界。使用单独的防火墙层可降低检查安全规则的复杂性,并明确哪些规则对应于哪个传入网络请求。

- Azure负载均衡器提供高可用性第4层(TCP,UDP)服务,该服务可以在负载平衡集中定义的服务实例之间分配传入流量。从前端端点(公共IP端点或专用IP端点)发送到负载均衡器的流量可以通过或不使用地址转换重新分配到一组后端IP地址池(例如网络虚拟设备或VM)。

- Azure负载均衡器也可以探测各种服务器实例的运行状况,当实例无法响应探测时,负载均衡器会停止向不正常的实例发送流量。在VDC中,外部负载平衡器部署到集线器和辐条。在集线器中,负载平衡器用于有效地将流量路由到辐条中的服务,并且在辐条中,负载平衡器用于管理应用程序流量。

- Azure Front Door(AFD)是Microsoft高度可用且可扩展的Web应用程序加速平台,全局HTTP负载均衡器,应用程序保护和内容交付网络。 AFD在Microsoft全球网络边缘的100多个位置运行,使您能够构建,操作和扩展动态Web应用程序和静态内容。 AFD为您的应用程序提供世界一流的最终用户性能,统一的区域/邮票维护自动化,BCDR自动化,统一的客户端/用户信息,缓存和服务洞察。该平台提供Azure本地开发,运营和支持的性能,可靠性和支持SLA,合规性认证和可审计安全实践。

- 应用程序网关Microsoft Azure应用程序网关是一种专用虚拟设备,提供应用程序交付控制器(ADC)即服务,为您的应用程序提供各种第7层负载平衡功能。它允许您通过将CPU密集型SSL终止卸载到应用程序网关来优化Web场的生产力。它还提供其他第7层路由功能,包括传入流量的循环分配,基于cookie的会话关联,基于URL路径的路由,以及在单个Application Gateway后面托管多个网站的功能。 Web应用程序防火墙(WAF)也作为应用程序网关WAF SKU的一部分提供。此SKU为Web应用程序提供保护,使其免受常见Web漏洞和漏洞攻击。 Application Gateway可以配置为面向Internet的网关,仅内部网关或两者的组合。

- 公共知识产权。使用某些Azure功能,您可以将服务端点关联到公共IP地址,以便可以从Internet访问您的资源。此端点使用网络地址转换(NAT)将流量路由到Azure虚拟网络上的内部地址和端口。此路径是外部流量进入虚拟网络的主要方式。您可以配置公共IP地址以确定传入的流量以及将其转换到虚拟网络的方式和位置。

- Azure DDoS保护标准在基本服务层上提供了专门针对Azure虚拟网络资源进行调整的其他缓解功能。 DDoS Protection Standard易于启用,无需更改应用程序。通过专用流量监控和机器学习算法来调整保护策略。策略应用于与虚拟网络中部署的资源相关联的公共IP地址。示例是Azure负载均衡器,Azure应用程序网关和Azure Service Fabric实例。在攻击期间和历史记录中,可以通过Azure Monitor视图获得实时遥测。可以通过Azure Application Gateway Web应用程序防火墙添加应用程序层保护。为IPv4 Azure公共IP地址提供保护。

组件类型:监控

监视组件提供所有其他组件类型的可见性和警报。所有团队都应该有权访问他们可以访问的组件和服务。如果您有一个集中的服务台或运营团队,则需要对这些组件提供的数据进行集成访问。

Azure提供不同类型的日志记录和监视服务,以跟踪Azure托管资源的行为。 Azure中工作负载的治理和控制不仅基于收集日志数据,还基于根据特定报告事件触发操作的能力。

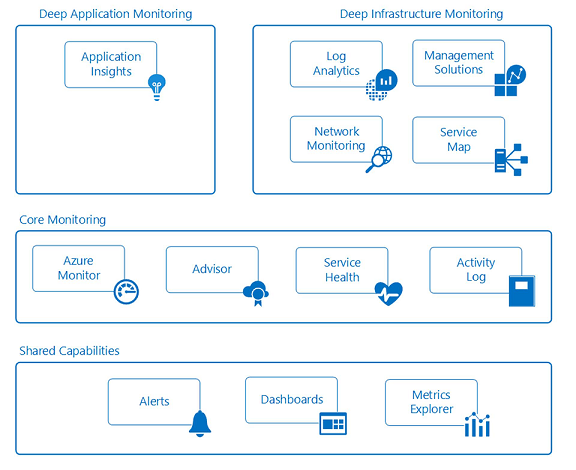

Azure监视器。 Azure包括多个服务,这些服务分别在监视空间中执行特定角色或任务。这些服务共同提供了一个全面的解决方案,用于从您的应用程序和支持它们的Azure资源中收集,分析和处理遥测。他们还可以监视关键的本地资源,以提供混合监视环境。了解可用的工具和数据是为应用程序开发完整监视策略的第一步。

Azure中有两种主要类型的日志:

Azure活动日志(以前称为“操作日志”)提供对Azure订阅中的资源执行的操作的深入了解。这些日志报告订阅的控制平面事件。每个Azure资源都会生成审核日志。

Azure Monitor诊断日志是由资源生成的日志,该资源提供有关该资源操作的丰富,频繁的数据。这些日志的内容因资源类型而异。

跟踪网络安全组的日志非常重要,尤其是以下信息:

事件日志提供有关基于MAC地址应用于VM和实例角色的网络安全组规则的信息。

计数器日志跟踪每个网络安全组规则运行的次数,以拒绝或允许流量。

所有日志都可以存储在Azure存储帐户中,以进行审计,静态分析或备份。将日志存储在Azure存储帐户中时,客户可以使用不同类型的框架来检索,准备,分析和可视化此数据,以报告云资源的状态和运行状况。

大型企业应该已经获得了监控内部系统的标准框架。他们可以扩展该框架以集成由云部署生成的日志。通过使用Azure Log Analytics,组织可以将所有日志记录保留在云中。 Log Analytics作为基于云的服务实施。因此,只需最少的基础设施服务投资,即可快速完成并快速运行。 Log Analytics还与System Center Operations Manager等System Center组件集成,以将您现有的管理投资扩展到云中。

Log Analytics是Azure中的一项服务,可帮助收集,关联,搜索和操作由操作系统,应用程序和基础架构云组件生成的日志和性能数据。它使用集成的搜索和自定义仪表板为客户提供实时操作洞察,以分析VDC实施中所有工作负载的所有记录。

Azure网络观察程序提供了用于监视,诊断和查看指标以及启用或禁用Azure虚拟网络中资源日志的工具。这是一个多方面的服务,允许以下功能和更多:

- 监视虚拟机和端点之间的通信。

- 查看虚拟网络中的资源及其关系。

- 诊断进出VM的网络流量过滤问题。

- 诊断VM的网络路由问题。

- 诊断来自VM的出站连接。

- 从VM捕获数据包。

- 诊断Azure虚拟网络网关和连接的问题。

- 确定Azure区域和Internet服务提供商之间的相对延迟。

- 查看网络接口的安全规则。

- 查看网络指标。

- 分析进出网络安全组的流量。

- 查看网络资源的诊断日志。

Operations Management Suite内部的网络性能监视器解决方案可以提供端到端的详细网络信息。此信息包括Azure网络和本地网络的单个视图。该解决方案具有ExpressRoute和公共服务的特定监视器。

组件类型:工作负载

工作负载组件是实际应用程序和服务所在的位置。它也是您的应用程序开发团队花费大部分时间的地方。

工作量的可能性是无止境的以下是一些可能的工作负载类型:

内部LOB应用程序:业务线应用程序是对企业持续运营至关重要的计算机应用程序。 LOB应用程序有一些共同特征:

互动性。输入数据,并返回结果或报告。

数据驱动 - 数据密集型,频繁访问数据库或其他存储。

与组织内外的其他系统集成提供集成。

面向客户的网站(互联网或内部):与互联网交互的大多数应用程序都是网站。 Azure提供在IaaS VM或Azure Web Apps站点(PaaS)上运行网站的功能。 Azure Web Apps支持与VNets集成,允许在分支网络区域中部署Web应用程序。面向内部的网站不需要公开公共互联网端点,因为资源可以通过私有VNet的私有非互联网可路由地址访问。

大数据/分析:当数据需要扩展到大容量时,数据库可能无法正确扩展。 Hadoop技术提供了一个在大量节点上并行运行分布式查询的系统。客户可以选择在IaaS VM或PaaS(HDInsight)中运行数据工作负载。 HDInsight支持部署到基于位置的VNet,可以部署到VDC轮辐中的集群。

事件和消息传递:Azure事件中心是一种超大规模的遥测提取服务,可收集,转换和存储数百万个事件。作为分布式流媒体平台,它提供低延迟和可配置的时间保留,使您能够将大量遥测数据摄入Azure并从多个应用程序中读取该数据。使用事件中心,单个流可以支持实时和基于批处理的管道。

您可以通过Azure Service Bus在应用程序和服务之间实现高度可靠的云消息传递服务。它提供客户端和服务器之间的异步代理消息传递,结构化先进先出(FIFO)消息传递以及发布和订阅功能。

使VDC高度可用:多个VDC

到目前为止,本文主要关注单个VDC的设计,描述了有助于弹性的基本组件和体系结构。 Azure负载均衡器,NVA,可用性集,规模集等Azure功能以及其他机制有助于您在生产服务中构建可靠的SLA级别的系统。

但是,由于单个VDC通常在单个区域内实施,因此可能容易受到影响整个区域的任何重大中断的影响。需要高SLA的客户必须通过在位于不同区域的两个(或更多)VDC实施中部署相同项目来保护服务。

除了SLA问题之外,还有几种常见的场景,其中部署多个VDC实现是有意义的:

- 区域或全球存在。

- 灾难恢复。

- 一种在数据中心之间转移流量的机制。

区域/全球存在

Azure数据中心遍布全球众多地区。选择多个Azure数据中心时,客户需要考虑两个相关因素:地理距离和延迟。要提供最佳用户体验,请评估每个VDC实施之间的地理距离以及每个VDC实施与最终用户之间的距离。

托管VDC实施的区域必须符合贵组织运营的任何法律管辖区制定的监管要求。

灾难恢复

灾难恢复计划的设计取决于工作负载的类型以及在不同VDC实现之间同步这些工作负载状态的能力。理想情况下,大多数客户需要快速故障转移机制,这可能需要在运行多个VDC实施的部署之间进行应用程序数据同步。但是,在设计灾难恢复计划时,重要的是要考虑大多数应用程序对此数据同步可能导致的延迟敏感。

不同VDC实现中的应用程序的同步和心跳监视要求它们通过网络进行通信。可以通过以下方式连接不同区域的两个VDC实现:

- VNet对等 - VNet对等可以跨区域连接集线器。

- 当每个VDC实现中的集线器连接到同一ExpressRoute电路时,ExpressRoute私有对等。

- 多个ExpressRoute电路通过您的公司骨干网和连接到ExpressRoute电路的多个VDC实现连接。

- 每个Azure区域中VDC实施的集线器区域之间的站点到站点VPN连接。

通常,VNet对等或ExpressRoute连接是首选的网络连接类型,因为在通过Microsoft骨干网传输时具有更高的带宽和一致的延迟级别。

我们建议客户运行网络资格测试以验证这些连接的延迟和带宽,并根据结果确定同步或异步数据复制是否合适。鉴于最佳恢复时间目标(RTO),权衡这些结果也很重要。

灾难恢复:将流量从一个地区转移到另一个地区

Azure流量管理器定期检查不同VDC实施中公共端点的服务运行状况,如果这些端点发生故障,它将使用域名系统(DNS)自动路由到辅助VDC。

由于它使用DNS,因此Traffic Manager仅用于Azure公共端点。该服务通常用于在VDC实施的健康实例中控制或转移到Azure VM和Web Apps的流量。即使在整个Azure区域出现故障的情况下,流量管理器也具有弹性,并且可以根据多个条件控制不同VDC中服务端点的用户流量分布。例如,特定VDC实施中的服务失败,或选择具有最低网络延迟的VDC实施。

摘要

虚拟数据中心是一种数据中心迁移方法,可在Azure中创建可扩展的体系结构,从而最大限度地利用云资源,降低成本并简化系统治理。 VDC基于中心和分支网络拓扑,在集线器中提供通用共享服务,并允许辐条中的特定应用程序和工作负载。 VDC还匹配公司角色的结构,其中不同的部门(如中央IT,DevOps,运营和维护)在执行其特定角色时协同工作。 VDC满足“提升和转移”迁移的要求,但也为本机云部署提供了许多优势。

参考

本文档讨论了以下功能。点击链接了解更多信息。

| Network Features | Load Balancing | Connectivity |

|---|---|---|

| Azure Virtual Networks Network Security Groups Network Security Group Logs User-Defined Routes Network Virtual Appliances Public IP Addresses Azure DDoS Azure Firewall Azure DNS |

Azure Front Door Azure Load Balancer (L3) Application Gateway (L7) [Web Application Firewall][WAF] Azure Traffic Manager |

VNet Peering Virtual Private Network Virtual WAN ExpressRoute ExpressRoute Direct |

| Other Azure Services |

|---|

| Azure Web Apps HDInsights (Hadoop) Event Hubs Service Bus |

原文:https://docs.microsoft.com/en-us/azure/architecture/vdc/networking-virtual-datacenter

本文:https://jiagoushi.pro/azure-virtual-datacenter-network-perspective

讨论:请加入知识星球【首席架构师圈】

- 61 次浏览

【云架构】用于保护和监控云应用的安全性

了解安全云开发,部署和操作所需的安全组件。

保护云中的应用程序和环境

云计算通过提供随时可用的基础架构,平台和软件服务,提供简化的应用程序开发和交付。但是,对安全性的担忧是企业的主要抑制因素。当您计划采用云时,共享责任模型,风险管理和合规性可能是核心决定因素。将工作负载移至云时,安全要求和风险承受能力不会发生变化。

任何迁移到云都需要一个由企业首席信息安全官(CISO)驱动的有效控制框架。控制框架必须评估和管理业务目标的风险。您必须将这些控制实施并扩展到云环境,同时将成本保持在IT预算范围内。通过使用量化指标持续监控威胁,事件和控制性能对于企业安全迁移到云是至关重要的。

随着您的业务经历数字化转型,您将通过使用微服务架构构建云原生应用程序,并构建它们以全面接受DevOps。因此,您必须重新考虑安全体系结构和方法,以实现云原生应用程序的持续安全性。这些体系结构和方法与您过去用于单片企业应用程序的体系结构和方法不同。在将应用程序迁移到云并实现现代化时,请确保云提供可信赖的平台,以便与企业数据中心安全地集成。

云从根本上提供了一个从根本上重新思考和转变互联网安全实践的机会。传统的基于边界的安全控制和基础架构操作实践正在转变为以数据和工作负载为中心的云安全策略,技术和实践。安全性是客户与云提供商之间的共同责任。云是一个确保安全的机会!------ Nataraj Nagaratnam博士,杰出工程师,IBM云安全首席技术官

安全云解决方案的关键组件

在设计,构建,部署和管理云应用程序时,请考虑安全性以保护您的业务,基础架构,应用程序和数据。

- 如何在云原生应用程序中设计和提供持续安全性?

- 如何保护敏感数据并对数据拥有权限?

- 您如何在云原生和企业工作负载的安全平台上构建?

内置和附加安全性

组织中的云开发人员需要一种更简单,更有效的方法来保护他们的云原生应用程序。 云中的安全服务提供内置功能即服务,本地从云端提供。 这些服务可以与您的DevOps流程无缝集成。 开发人员可以通过在云中使用安全性来创建灵活,灵活且可扩展的解决方案。

同时,组织中的安全专家可以使用您的安全投资,或者将额外的安全功能或工具作为云的附件,以进行完整的安全管理。

要创建安全的云解决方案,请考虑以下安全性的关键组件:

- 管理身份和访问

- 保护基础架构,应用程序和数据

- 获得跨环境的可见性

管理身份和访问

管理身份并管理用户对云资源的访问。当您从云中使用基础架构时,管理与特权活动相关联的身份非常重要,例如由云管理员执行的任务。您还必须跟踪参与开发和运营的人员的活动。访问控制的另一个重要方面是管理用户和客户对云应用程序的访问。

保护基础架构,应用程序和数据

与传统数据中心一样,您必须在云上提供特定于租户的网络保护和隔离,以保护云基础架构。对于应用程序保护,请设计安全的开发和操作过程(Sec-Dev-Ops或Dev-Sec-Ops)。此过程包括识别和管理虚拟机(VM),容器和应用程序代码中的漏洞的步骤。对于数据保护,您的解决方案必须涵盖加密静态数据的技术,例如文件,对象和存储以及运动中的数据。您的解决方案还必须包括如何监控数据活动和流程以验证和审核外包到云的数据的步骤。

获得跨环境的可见性

持续监控云中的每个活动和事件,以实现内部部署和基于云的环境的完全可见性。通过跨云中的各种组件和服务实时收集和分析日志,您可以构建改进的虚拟基础架构安全性和可见性。

保护IBM Cloud上的工作负载

根据业务需求,公司采用不同类型的云,例如公共云,私有云和混合云。在选择适当的云部署模型时,请考虑应用程序类型,数据敏感性,业务流程重要性和目标用户群。

借助IBM Cloud,您可以在公共,私有或混合部署的任何组合中获得单一的开发和管理体验。如图所示,IBM Cloud平台包含许多内置安全功能(云中的安全性)。您可以根据所选的工作负载和部署模型(云上的安全性)添加额外的安全性。

在创建安全云解决方案时,您必须了解安全选项以及如何应用它们。 这些文章解释了安全云部署,开发和运营所需的安全组件。 它们描述了IBM Cloud的内置安全功能,并向您展示如何扩展和集成其他安全服务,以创建最安全的云解决方案。

Identity and access management

Security monitoring and intelligence

Security policy, governance, risk, and compliance

下一步是什么

既然您已了解安全性的概念和价值,请了解有关如何在安全性参考体系结构中构建安全应用程序的更多信息。

了解有关可用IBM Cloud产品和服务的更多信息。

原文:https://www.ibm.com/cloud/garage/architectures/securityArchitecture

本文:

讨论:请加入知识星球或者小红圈【首席架构师圈】

- 17 次浏览

【云架构】通过新的优化视角查看云架构

仅仅让云部署工作不再是目标。关注构建和部署最佳解决方案的新指标和方法。

随着云计算架构的成熟,我们定义成功的方式也应该成熟。在2021,我指出,优化云计算更多的是二进制过程,而不是模拟过程。

我当时所说的仍然是正确的:“这关系到很多问题。未充分优化且成本高昂的架构(云架构)也许确实有效,但它们可能会导致企业每周损失数百万美元,而大多数人对此一无所知。30种技术被用于12种可能更好的技术,而不为改变而设计意味着业务敏捷性受到影响。”

为什么大多数云架构都没有得到很好的优化?在规划和设计阶段,大多数云架构师都会按照云架构课程中教给他们的内容来做,或者他们会将所读内容应用到大量的“如何云”参考资料中,或者他们甚至会采纳从以前的云架构项目和导师那里学到的技巧。所有这些都将引导架构师使用一系列通用参考模型、流程和技术堆栈,这些模型、流程和技术堆栈应该进行修改,以满足企业独特的业务需求。这种方法始终导致未充分优化的架构,这会给企业带来更多(或更多)的成本。发生什么事了?

要回答这个问题,让我们后退一步。优化的云架构实际上意味着什么?我在2020年10月定义了云架构优化的过程,并包括了一个要利用的高级模型。我甚至扩展了我的云架构课程,加入了这个概念,这个概念很快将在这里发布。

其次,我们需要认识到,过去的主要重点是让所有东西协同工作,而很少考虑它的工作效果如何或解决方案变得多么复杂。衡量成功的标准是“它有效吗?”不是“它工作得怎么样?”

在开发过程中,团队专注于云架构、迁移和网络新开发的方法,包括广域(元云架构)和窄域(微云架构)。现在,更多的是关于如何设计和部署云迁移和新的云本地开发,或者如何利用容器、无服务器或其他小型或大型云计算解决方案。相反,关键在于如何定义解决方案的目标。

IT和企业管理层普遍认识到,一个“有效”或“似乎具有创新性”的解决方案并不能真正告诉您为什么运营成本比预测成本高很多。今天,我们需要审核和评估云解决方案的最终状态,以明确衡量其成功与否。云部署的规划和开发阶段是规划和构建审计和评估程序的好地方,这些程序将在开发后进行,以衡量项目的总体ROI。

这种从端到端的观点将对构建和部署云及云相关解决方案的人造成一些干扰。大多数人相信他们的设计和构建都是最前沿的,并且采用了当时最好的解决方案。他们相信他们的设计是尽可能优化的。在大多数情况下,他们是错的。

过去10年中实施的大多数云解决方案都严重优化不足。如此之多,以至于如果公司对部署的内容和应该部署的内容进行诚实的审计,一个真正优化的云解决方案的完全不同的图景就会形成。也许容器的使用太多或不够。或者没有强制云原生重构,或者没有考虑这些优势。或者我所看到的新趋势,使多云变得比它需要的更复杂,并且未能定义常见的跨云服务,如安全和操作。在某些情况下,解决方案使用了太多的公共服务,但这些情况并不常见。

概括地说,云架构师应用了他们从书籍、视频、文章甚至我和其他专家报告技术应该如何利用的方法中学到的知识。架构师定义业务需求,然后将这些需求与最优化的解决方案相匹配。这是个好办法。

但是,假设供应商A拥有适用于您的财务运营的最佳原生应用程序,供应商B拥有适用于您的CRM需求的最佳原生应用程序,供应商C拥有适用于您的库存需求的最佳本机应用程序。为了满足这三个需求以及数十种其他选择(安全性、存储、网络等),使用多云来获得最佳产品可能不符合企业的总体最佳利益。这些选择中的每一个都增加了另一层复杂性和成本,很快就会超过额外的好处。

这并不意味着廉价使用用于构建云解决方案的技术。只是要知道,获得最优化的架构仍然是艺术多于科学。有时你需要投资更多的技术,有时需要投资更少的技术。重要的是定义尽可能接近优化的内容。

今天,云优化意味着我们必须审核和重新评估我们当前的云解决方案,然后再考虑进一步增加指标。这并不容易,但考虑到潜在的价值返回到业务。在某些情况下,云优化甚至可以挽救业务。

当有云解决方案可用时,“足够好”团队中的许多员工倾向于成为三只聪明的猴子中的一只或全部:他们不想听到、看到或谈论他们帮助部署或当前运行的云解决方案的任何坏话。相反,团队中似乎总是有人“等等,这要花多少钱?”谁意识到云解决方案将继续消耗企业资源,其消耗量将远远超过应有的水平。他们将是第一个建议或坚持进行审计的人。

原文:https://www.infoworld.com/article/3646989/view-cloud-architecture-throu…

- 21 次浏览

【云计算】什么是IT弹性(弹力)以及对备份用户意味着什么?

备份和恢复科学不断发展。二十年前,磁带系统是主要的备份技术;它足以保存您的数据。今天,备份已经发展到不仅包括数据的快速恢复,还包括用于执行业务操作的应用程序。认识到整个数据中心可以在一个事件中被摧毁,灾难恢复即服务(DRaaS)现在正成为组织业务连续性计划的主要组成部分。

但是,让所有这些恢复技术依赖于人类识别问题,诊断有效的解决方案,及时采取行动,并确保恢复成功使整个企业恢复过程处于危险之中。我们需要的是能够实时地根据预先编排的操作处理挑战,在应用程序和IT基础架构中构建智能,自导向功能的解决方案。

这是IT的韧性。

IT Resilience(ITR)保护您的数据

IT Resilience能够保护数据和应用程序免受任何类型的问题。它是通过采用一组工具和应用程序构建的,这些工具和应用程序将自动采取措施保护数据和应用程序免受任何类型的问题的影响。以ITR如何处理勒索软件为例。支持ITR的供应商提供的软件可以持续检查所有备份上的恶意软件感染,并可以轻松地将生产数据恢复到攻击前的状态。支持ITR的软件产品已经发展到支持生产数据中心和云之间的应用程序弹性和工作负载转移。

为什么你应该关心ITR

Gartner可能最着名的是他们的Magic Quadrants,这是一种报告格式,可以评估来自60多个IT市场的技术供应商到4个“象限”。目前,Unitrends被定位为2017年6月数据中心备份和恢复软件魔力象限的参与者,并作为灾难恢复即服务魔力象限的有远见者,也于2017年6月发布。还提及Unitrends作为代表2017年12月IT Resilience Orchestration Automation市场指南中的供应商。

虽然IT防灾市场目前很小,但它的规模和重要性都在不断提高。我们刚刚开始这项新技术。 ITR的早期阶段对客户提出了挑战。用户似乎被迫集成多个供应商和解决方案以实现IT弹性。

但为什么?

备份,DRaaS和ITR是彼此的自然扩展。 您可以使用专用备份设备保护内部部署和云应用程序以及物理和虚拟环境。 您还可以确保使用这些备份设备的DRaaS服务的正常运行时间。 如果供应商可以做到这一切,为什么他们不能自动化整个过程(故障转移,测试,合规报告等)以在出现威胁时自动响应?

有些供应商可以做到这一切。 供应商做到这一切的一个迹象是他们愿意提供DRaaS SLA。 他们非常肯定他们的恢复过程将按要求执行,他们愿意在财务上支持结果。 ITR可以提供可衡量,值得信赖和可重复的RPO和RTO指标,因为该技术可以自动化,每次都可以使用。

您的数据备份和业务连续性供应商能做到吗? 如果没有,也许你需要看一个能够更好地保护你公司和你的新服务提供商。

- 50 次浏览

【云计算】什么是不可变的基础设施?

介绍

在传统的可变服务器基础架构中,服务器会不断更新和修改。使用此类基础架构的工程师和管理员可以通过SSH连接到他们的服务器,手动升级或降级软件包,逐个服务器地调整配置文件,以及将新代码直接部署到现有服务器上。换句话说,这些服务器是可变的;它们可以在创建后进行更改。由可变服务器组成的基础设施本身可称为可变,传统或(贬低)手工艺。

不可变基础架构是另一种基础架构范例,其中服务器在部署后永远不会被修改。如果需要以任何方式更新,修复或修改某些内容,则会根据具有相应更改的公共映像构建新服务器以替换旧服务器。经过验证后,它们就会投入使用,而旧的则会退役。

不可变基础架构的好处包括基础架构中更高的一致性和可靠性,以及更简单,更可预测的部署过程。它可以缓解或完全防止可变基础架构中常见的问题,例如配置漂移和雪花服务器。但是,有效地使用它通常包括全面的部署自动化,云计算环境中的快速服务器配置,以及处理状态或短暂数据(如日志)的解决方案。

本文的其余部分将:

- 解释可变和不可变基础架构之间的概念和实际差异

- 描述使用不可变基础架构的优势并将复杂性置于语境中

- 概述不可变基础架构的实现细节和必要组件

可变和不可变基础设施之间的差异

可变基础和不可变基础设施之间最根本的区别在于它们的核心政策:前者的组件旨在在部署后进行更改;后者的组成部分旨在保持不变并最终被替换。本教程将这些组件作为服务器,但是还有其他方法可以实现不可变的基础结构,例如容器,它们应用相同的高级概念。

为了更深入,基于服务器的可变基础架构和不可变基础架构之间存在实际和概念上的差异。

从概念上讲,这两种基础设施在处理服务器的方法(例如创建,维护,更新,销毁)方面差异很大。这通常用“宠物与牛”类比来说明。

实际上,可变基础架构是一种更老的基础架构范例,它早于核心技术,如虚拟化和云计算,使不可变的基础架构成为可能和实用的。了解这段历史有助于将两者之间的概念差异以及在现代基础设施中使用其中一个或另一个的含义进行背景化。

接下来的两节将更详细地讨论这些差异。

实际差异:拥抱云

在虚拟化和云计算成为可能并且广泛可用之前,服务器基础架构以物理服务器为中心。这些物理服务器创建起来既昂贵又耗时;初始设置可能需要数天或数周,因为订购新硬件,配置机器,然后将其安装在colo或类似位置需要多长时间。

可变基础设施起源于此。由于更换服务器的成本非常高,因此尽可能在尽可能短的停机时间内尽可能长时间地使用您运行的服务器是最实际的。这意味着对于常规部署和更新有很多适当的更改,但对于出现问题时的临时修复,调整和补丁也是如此。频繁手动更改的结果是服务器变得难以复制,使每个服务器成为整个基础架构中独特且易碎的组件。

虚拟化和按需/云计算的出现代表了服务器架构的转折点。虚拟服务器虽然规模较小,但成本较低,可以在几分钟而不是几天或几周内创建和销毁。这使得新部署工作流和服务器管理技术首次成为可能,例如使用配置管理或云API快速,编程和自动配置新服务器。创建新虚拟服务器的速度和低成本使得不变性原则变得切实可行。

传统的可变基础设施最初是在使用物理服务器决定其管理可行性时开发的,并且随着技术的不断改进而不断发展。在部署之后修改服务器的范例在现代基础设施中仍然很常见。相比之下,不可变基础架构从一开始就设计为依赖基于虚拟化的技术来快速配置架构组件,如云计算的虚拟服务器。

概念差异:宠物与牛,雪花与凤凰

云计算先进的基本概念变化是服务器可以被认为是一次性的。考虑丢弃和更换物理服务器是非常不切实际的,但使用虚拟服务器,这样做不仅可行而且简单有效。

传统可变基础架构中的服务器是不可替代的,独特的系统必须始终保持运行。通过这种方式,它们就像宠物一样:独一无二,无法模仿,并且倾向于手工制作。失去一个可能是毁灭性的。另一方面,不可变基础架构中的服务器是一次性的,易于复制或使用自动化工具进行扩展。通过这种方式,他们就像牛一样:牛群中的众多群体中没有一个人是独一无二或不可或缺的。

引用Randy Bias,他首先将宠物与牛类比应用于云计算:

在旧的做事方式中,我们将服务器视为宠物,例如Bob邮件服务器。如果鲍勃摔倒,那就全都动手了。首席执行官无法收到他的电子邮件,这是世界末日。以新的方式,服务器被编号,就像牛群中的牛一样。例如,www001到www100。当一台服务器发生故障时,它会被取回,射击并在线路上更换。

另一种类似的方式来说明服务器处理方式之间差异的含义是雪花服务器和凤凰服务器的概念。

雪花服务器类似于宠物。它们是手工管理的服务器,经常更新和调整到位,从而形成独特的环境。 Phoenix服务器与牛类似。它们是始终从头开始构建的服务器,并且易于通过自动化过程重新创建(或“从灰烬中升起”)。

不可变的基础设施几乎完全由牛或凤凰服务器制成,而可变基础设施允许一些(或许多)宠物或雪花服务器。下一节将讨论两者的含义。

不可变基础设施的优势

要了解不可变基础架构的优势,有必要将可变基础架构的缺点置于语境中。

可变基础架构中的服务器可能会受到配置偏差的影响,这种情况在未记录的情况下,即兴更改会导致服务器的配置变得越来越不同,并且与审核,批准和最初部署的配置之间的配置越来越不同。这些越来越像雪花的服务器难以重现和替换,使得缩放和恢复问题变得困难。即使复制问题来调试它们也会变得具有挑战性,因为创建与生产环境匹配的临时环境很困难。

在许多手动修改之后,服务器的不同配置的重要性或必要性变得不清楚,因此更新或更改任何配置可能会产生意想不到的副作用。即使在最好的情况下,也不能保证对现有系统进行更改,这意味着依赖于这样做的部署可能会导致失败或将服务器置于未知状态。

考虑到这一点,使用不可变基础架构的主要好处是部署简单性,可靠性和一致性,所有这些最终可以最大限度地减少或消除许多常见的痛点和故障点。

已知良好的服务器状态和较少的部署失败

不可变基础架构中的所有部署都是通过基于经过验证和版本控制的映像配置新服务器来执行的。因此,这些部署不依赖于服务器的先前状态,因此不会失败 - 或者只是部分完成 - 因为它。

配置新服务器时,可以在投入使用之前对其进行测试,将实际部署过程减少到单个更新,以使新服务器可用,例如更新负载均衡器。换句话说,部署变为原子:要么成功完成,要么没有任何变化。

这使得部署更加可靠,并且还确保始终知道基础结构中每个服务器的状态。此外,此过程可以轻松实现蓝绿色部署或滚动版本,这意味着无需停机。

没有配置漂移或雪花服务器

通过使用文档检查更新的映像到版本控制并使用自动,统一的部署过程来部署具有该映像的替换服务器来实现不可变基础结构中的所有配置更改。 Shell访问服务器有时完全受限制。

通过消除雪花服务器和配置漂移的风险,这可以防止复杂或难以重现的设置。这还可以防止有人需要修改一个知之甚少的生产服务器,这种生产服务器存在高错误风险并导致停机或意外行为。

一致的登台环境和轻松的水平扩展

由于所有服务器都使用相同的创建过程,因此没有部署边缘情况。通过简化复制生产环境,可以防止混乱或不一致的登台环境,并通过无缝地允许您向基础架构添加更多相同的服务器来简化水平扩展。

简单的回滚和恢复过程

使用版本控制来保留图像历史记录也有助于处理生产问题。用于部署新映像的相同过程也可用于回滚到旧版本,在处理停机时添加额外的弹性并缩短恢复时间。

不可变基础设施实施细节

不可变的基础架构在其实现细节方面有一些要求和细微差别,特别是与传统的可变基础架构相比。

通过简单地遵循不变性的关键原则,技术上可以实现独立于任何自动化,工具或软件设计原则的不可变基础设施。但是,强烈建议使用以下组件(大致按优先顺序)以实现大规模实用性:

- 云计算环境中的服务器,或其他虚拟化环境(如容器,但会改变下面的一些其他要求)。这里的关键是通过自定义映像快速配置隔离实例,以及通过API或类似工具创建和销毁的自动化管理。

- 整个部署管道的完全自动化,理想情况下包括创建后的图像验证。设置此自动化会显着增加实施此基础架构的前期成本,但这是一次性成本,可以快速摊销。

- 面向服务的体系结构,将您的基础架构分离为通过网络进行通信的模块化逻辑离散单元。这使您可以充分利用云计算的产品,这些产品同样面向服务(例如IaaS,PaaS)。

- 无状态,易变的应用程序层,包括您的不可变服务器。这里的任何东西都可以在任何时候(易变)快速销毁和重建,而不会丢失任何数据(无状态)。

- 持久数据层,包括:

- 集中式日志记录,包含有关服务器部署的其他详细信息,例如通过版本或Git提交SHA进行映像识别。由于服务器在此基础结构中是一次性的(并且经常处理),因此即使在限制shell访问或服务器被销毁之后,外部存储日志和指标也允许调试。

- 数据库和任何其他有状态或短暂数据的外部数据存储,如DBaaS /云数据库和对象或块存储(云提供或自我管理)。当服务器易变时,您不能依赖本地存储,因此您需要将该数据存储在其他位置。