1框架风险

人工智能风险管理提供了一条途径,可以最大限度地减少人工智能系统的潜在负面影响,如对公民自由和权利的威胁,同时也提供了最大限度地扩大积极影响的机会。有效地解决、记录和管理人工智能风险和潜在的负面影响可以带来更值得信赖的人工智能系统。

1.1了解和应对风险、影响和危害

在AI RMF的背景下,风险是指事件发生概率和相应事件后果的大小或程度的综合衡量标准。人工智能系统的影响或后果可能是积极的、消极的,也可能是两者兼而有之,并可能导致机会或威胁(改编自:iso 31000:2018)。当考虑潜在事件的负面影响时,风险是1)如果情况或事件发生,将产生的负面影响或伤害程度和2)发生的可能性的函数(改编自:omb通告a-130:2016)。个人、团体、社区、组织、社会、环境和地球都可能受到负面影响或伤害。

“风险管理是指在风险方面指导和控制组织的协调活动”(来源:iso 31000:2018)。

虽然风险管理流程通常解决负面影响,但该框架提供了将人工智能系统的预期负面影响降至最低的方法,并确定了最大限度地发挥积极影响的机会。有效管理潜在危害的风险可以带来更值得信赖的人工智能系统,并为人们(个人、社区和社会)、组织和系统/生态系统带来潜在利益。风险管理可以使人工智能开发人员和用户了解其模型和系统的影响,并解释其固有的局限性和不确定性,这反过来可以提高系统的整体性能和可信度,以及人工智能技术以有益的方式使用的可能性。

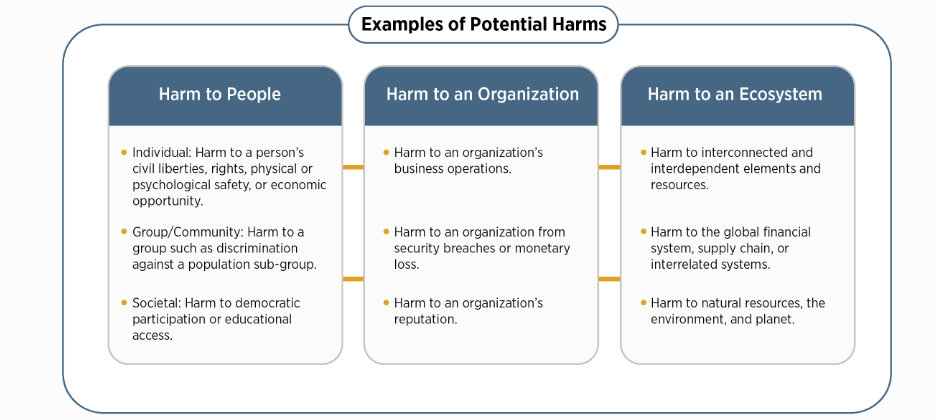

AI RMF旨在应对出现的新风险。在影响不易预见且应用程序不断发展的情况下,这种灵活性尤为重要。虽然人工智能的一些风险和好处是众所周知的,但评估负面影响和危害程度可能很有挑战性。图1提供了与人工智能系统相关的潜在危害示例。

人工智能风险管理工作应考虑到,人类可能会认为人工智能系统在所有环境中都能正常工作。例如,无论是否正确,人工智能系统通常被认为比人类更客观,或者比通用软件提供更大的功能。

图1:与人工智能系统相关的潜在危害示例。值得信赖的人工智能系统及其负责任的使用可以减轻负面风险,为人们、组织和生态系统带来好处。

1.2人工智能风险管理面临的挑战

以下介绍了几个挑战。在管理风险以追求人工智能可信度时,应将其考虑在内。

1.1.1风险度量

人工智能的风险或失败没有明确定义或充分理解,很难定量或定性地衡量。无法适当衡量人工智能风险并不意味着人工智能系统必然会带来高风险或低风险。一些风险衡量挑战包括:

- 与第三方软件、硬件和数据相关的风险:第三方数据或系统可以加速研发并促进技术转型。它们也可能使风险衡量复杂化。风险既可能来自第三方数据、软件或硬件本身,也可能来自其使用方式。开发人工智能系统的组织所使用的风险度量或方法可能与部署或运行该系统的组织使用的风险指标或方法不一致。此外,开发人工智能系统的组织可能对其使用的风险指标或方法不透明。客户如何使用或将第三方数据或系统集成到人工智能产品或服务中,尤其是在没有足够的内部治理结构和技术保障的情况下,风险测量和管理可能会变得复杂。无论如何,各方和人工智能参与者都应该管理他们开发、部署或用作独立或集成组件的人工智能系统中的风险。

- 跟踪突发风险:将通过识别和跟踪突发风险并考虑测量技术来加强组织的风险管理工作。人工智能系统影响评估方法可以帮助人工智能参与者了解特定背景下的潜在影响或危害。

- 可靠指标的可用性:目前对风险和可信度的稳健和可验证的测量方法以及对不同人工智能用例的适用性缺乏共识,这是人工智能风险测量的挑战。在寻求衡量负面风险或危害时,潜在的陷阱包括这样一个现实,即指标的制定通常是一项机构努力,可能会无意中反映出与潜在影响无关的因素。此外,测量方法可能过于简单化、游戏化、缺乏关键的细微差别、以意想不到的方式被依赖,或者无法解释受影响群体和环境的差异。

如果认识到环境很重要,伤害可能会对不同的群体或子群体产生不同的影响,并且可能受到伤害的社区或其他子群体并不总是系统的直接用户,那么衡量对人群影响的方法效果最好。

- 人工智能生命周期不同阶段的风险:在人工智能生命生命周期的早期阶段测量风险可能会产生与在后期测量风险不同的结果;一些风险可能在给定的时间点是潜在的,并且可能随着人工智能系统的适应和发展而增加。此外,人工智能生命周期中不同的人工智能参与者可能有不同的风险视角。例如,提供人工智能软件(如预训练模型)的人工智能开发人员可能与负责在特定用例中部署预训练模型的人工智能参与者有不同的风险视角。这些部署人员可能没有意识到,他们的特定用途可能会带来与最初开发人员所感知的风险不同的风险。所有相关的人工智能参与者都有责任设计、开发和部署一个符合目的的值得信赖的人工智能系统。

- 现实世界环境中的风险:虽然在实验室或受控环境中测量人工智能风险可能会在部署前产生重要见解,但这些测量可能与实际操作环境中出现的风险不同。

- 不可破解性:不可破解的人工智能系统会使风险衡量复杂化。不可破解性可能是由于人工智能系统的不透明性(可解释性或可解释性有限)、人工智能系统开发或部署缺乏透明度或文档,或人工智能系统固有的不确定性。

- 人类基线:旨在增强或取代人类活动的人工智能系统的风险管理,例如决策,需要某种形式的基线指标进行比较。这很难系统化,因为人工智能系统执行的任务与人类不同,执行的任务也不同

1.1.2风险承受能力

虽然AI RMF可用于优先考虑风险,但它并未规定风险承受能力。风险承受能力是指组织或人工智能参与者(见附录A)为实现其目标而承担风险的意愿。风险承受能力可能受到法律或监管要求的影响(改编自:iso指南73)。风险承受能力和组织或社会可接受的风险水平是高度相关的,并且是特定于应用程序和用例的。风险承受能力可能受到人工智能系统所有者、组织、行业、社区或政策制定者制定的政策和规范的影响。随着人工智能系统、政策和规范的发展,风险承受能力可能会随着时间的推移而变化。不同的组织由于其特定的组织优先级和资源考虑因素,可能具有不同的风险承受能力。

企业、政府、学术界和民间社会将继续发展和讨论新出现的知识和方法,以更好地了解危害/成本效益权衡。在指定人工智能风险承受能力的挑战仍未解决的情况下,可能存在风险管理框架尚不适用于减轻人工智能负面风险的情况。

该框架旨在具有灵活性,并加强现有的风险实践,这些实践应符合适用的法律、法规和规范。组织应遵循组织、领域、学科、部门或专业要求制定的风险标准、容忍度和应对措施的现有法规和指南。一些部门或行业可能已经确定了危害的定义,或制定了文件、报告和披露要求。在部门内,风险管理可能取决于特定应用程序和用例设置的现有指南。在没有既定指导方针的情况下,组织应定义合理的风险承受能力。一旦定义了容差,该AI RMF就可以用于管理风险和记录风险管理流程。

1.1.3风险优先级

试图完全消除负面风险在实践中可能会适得其反,因为并非所有的事件和失败都能消除。对风险的不切实际的期望可能导致组织以一种使风险分类低效或不切实际或浪费稀缺资源的方式分配资源。风险管理文化可以帮助组织认识到,并非所有的人工智能风险都是相同的,资源可以有目的地分配。可采取行动的风险管理工作为评估组织开发或部署的每个人工智能系统的可信度制定了明确的指导方针。应根据评估的风险水平和人工智能系统的潜在影响,优先考虑政策和资源。人工智能系统可以在多大程度上根据人工智能部署者使用的特定环境进行定制或定制,这可能是一个促成因素。

在应用人工智能RMF时,组织确定在给定使用环境下人工智能系统的风险最高,需要最紧急的优先级排序和最彻底的风险管理流程。如果人工智能系统呈现出不可接受的负面风险水平,例如重大负面影响迫在眉睫、严重危害实际发生或存在灾难性风险,则应以安全的方式停止开发和部署,直到风险得到充分管理。如果人工智能系统的开发、部署和用例在特定情况下被发现是低风险的,这可能意味着优先级可能会降低。

与非人工智能系统相比,设计或部署用于与人类直接交互的人工智能系统之间的风险优先级可能有所不同。在人工智能系统在由敏感或受保护数据(如个人身份信息)组成的大型数据集上进行训练的环境中,或者人工智能系统的输出对人类有直接或间接影响的环境中可能需要更高的初始优先级。人工智能系统设计为仅与计算系统交互,并在非敏感数据集(例如,从物理环境中收集的数据)上进行训练,可能需要较低的初始优先级。尽管如此,基于上下文定期评估和优先考虑风险仍然很重要,因为面向非人类的人工智能系统可能会产生下游安全或社会影响。

剩余风险——定义为风险处理后的剩余风险(来源:iso指南73)——直接影响最终用户或受影响的个人和社区。记录剩余风险将要求系统提供商充分考虑部署人工智能产品的风险,并告知最终用户与系统交互的潜在负面影响。

1.1.4组织整合与风险管理

人工智能风险不应单独考虑。不同的人工智能参与者有不同的责任和意识,这取决于他们在生命周期中的角色。例如,开发人工智能系统的组织通常没有关于如何使用该系统的信息。人工智能风险管理应整合并纳入更广泛的企业风险管理战略和流程。将人工智能风险与其他关键风险(如网络安全和隐私)一起处理,将产生更综合的结果和组织效率。

人工智能RMF可与相关指南和框架一起用于管理人工智能系统风险或更广泛的企业风险。与人工智能系统相关的一些风险在其他类型的软件开发和部署中很常见。重叠风险的例子包括:与使用基础数据训练人工智能系统有关的隐私问题;与资源密集型计算需求相关的能源和环境影响;与系统及其培训和输出数据的机密性、完整性和可用性相关的安全问题;以及人工智能系统底层软件和硬件的一般安全性。

各组织需要建立和维护适当的问责机制、作用和责任、文化和激励结构,以使风险管理有效。单独使用AI RMF不会导致这些变化或提供适当的激励措施。有效的风险管理是通过高层的组织承诺实现的,可能需要组织或行业内的文化变革。此外,管理人工智能风险或实施人工智能RMF的中小型组织可能面临与大型组织不同的挑战,这取决于它们的能力和资源。